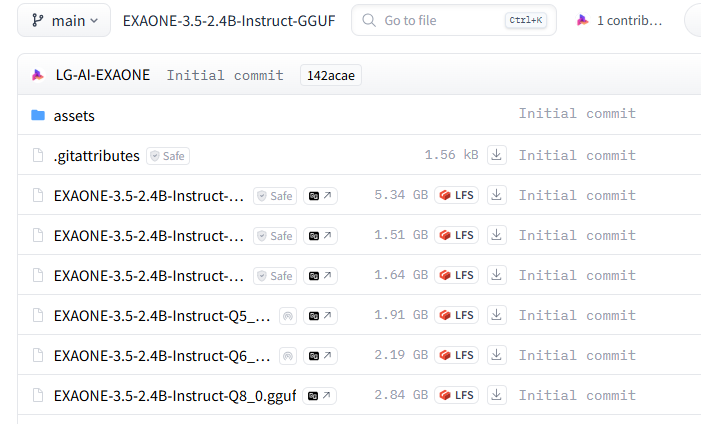

1. 허깅페이스에서 gguf 다운받는다.

난 그냥 Q8_0 으로 받을 것이다.

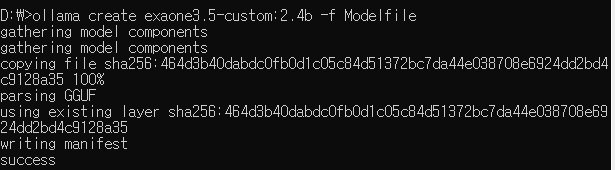

2. Modelfile 작성

FROM exaone-3.5-2.4b.gguf3. Modelfile 실행

exaone3.5-custom:2.4b 으로 만들 것이다.

% ollama create exaone3.5-custom:2.4b -f Modelfile생성완료

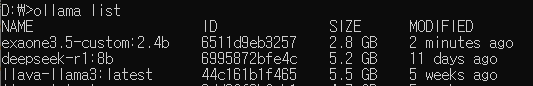

4. 생성 확인

% ollama list

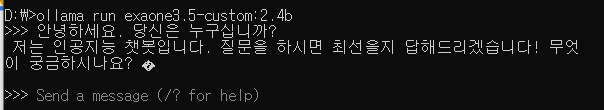

5. 테스트

% ollama run exaone3.5-custom:2.4b

Finally

다른 모델도 양자화 해서 테스트 해봐야겠다.