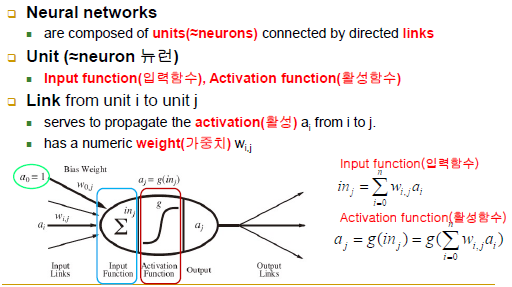

■ Artificial Neural Networks (인공 신경망)

■ Neural Network Structures(신경망 구조)

-NN: 뉴런들과 뉴런들을 연결하는 링크 구조

-Unit: 입력 함수(각각의 입력 * 가중치) -> 활성 함수(입력 함수) -> output

-

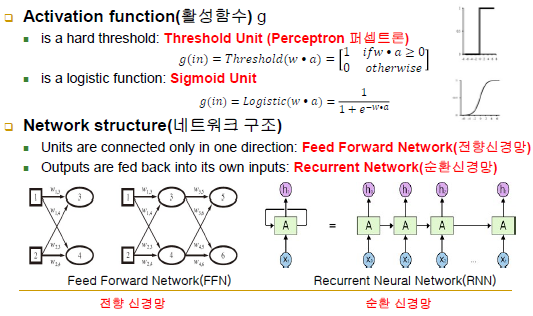

Activation function g

-hard threshold: Trehshold Unit(Perceptron)

-logistic function: Sigmoid Unit

-뉴런 하나는 곧 하나의 직선함수, 여러 개를 연결하면 신경망이 됨 -

Network structure

-Feed Forward Network: 입력에서 출력까지 앞으로 전달되는 방식 / 완전 연결(하나의 입력이 다음 계층의 모든 뉴런에 연결되어 있음, fully connected)

-Recurrent Network: 순환 구조, 출력이 앞으로만 전달되는 것이 아니라 앞으로 갈 수 있는 경우, 이전에 있던 정보를 기반하는 성질을 가짐

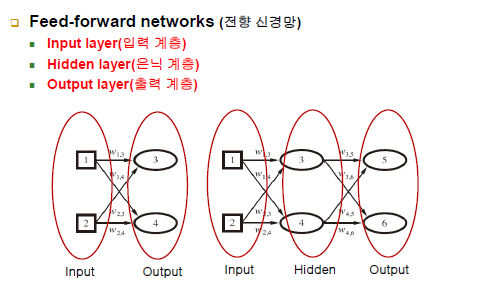

- Feed-forward network(전향 신경망)

-입력 계층: 단지 입력이 들어오는 단자 역할

-은닉 계층: 실제 데이터가 처리되는 부분

-출력 계층: 결과

-단층인 경우에는 실제로 뉴런은 출력층뿐임

-밖에서 봤을 때 중간은 노출되지 않음(은닉 계층)

■ Single-Layer Feed-Forward NNs

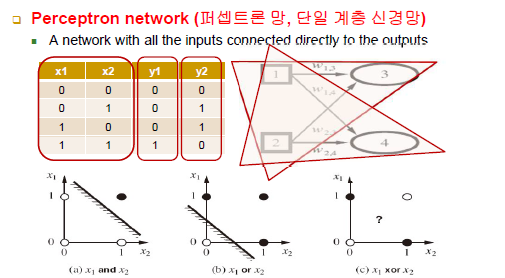

- Perceptron network (퍼셉트론 망, 단일 계층 신경망)

-링크마다 가중치 존재, 가중치 값을 학습을 통해서 알아내려고 함

-단층인 경우에 각 출력에 있어 다른 output들이 독립적임, 서로 영향을 주지 못함

-사실상 3,4는 선형 모델과 같음 / hard threshold냐 sigmoid냐에 따라서만 학습 규칙이 다름

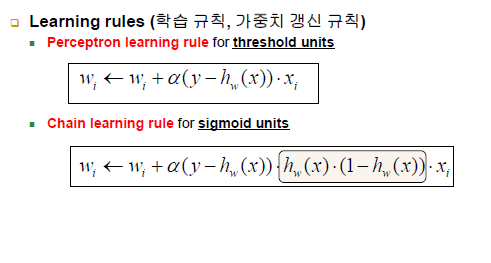

- Learning rules(학습 규칙, 가중치 갱신 규칙)

-Perceptron learning rule for threshold units: 미분 불가능한 불연속

-Chain learning rule for sigmoid units: 미분하기 좋은 연속

-둘 중 무엇을 사용하느냐에 따라 activation function이 달라짐

-직선 하나를 찾는 경우는 뉴런 하나로 모두 가능

■ Multilayer Feed-Forward NNs

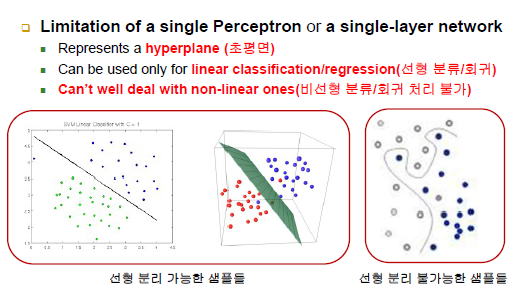

- Limitation of a single Perceptron or a single-layer network

-직선(선형), 초평면 등만 가능

-비선형은 불가능

-

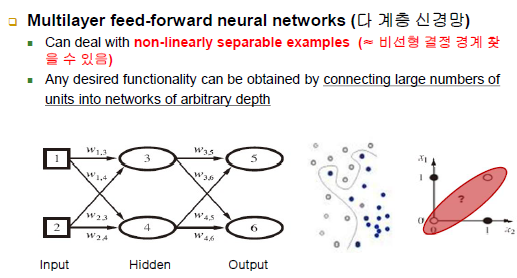

Multilayer feed-forward neural networks (다 계층 신경망)

-비선형 결정 경계를 찾을 수 있음

-layer가 깊어질수록 데이터는 더 비선형적으로 복잡하게 만들어짐 -

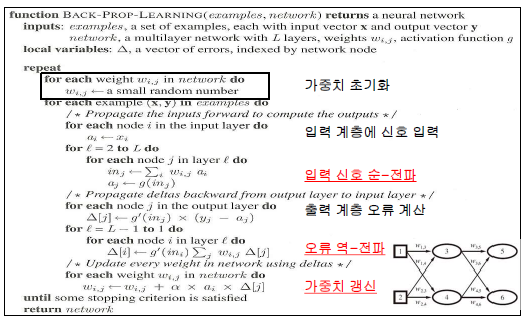

Backpropagation Algorithm(역-전파 알고리즘)

-간단하게 말해 입력 순-전파와 오류 역-전파의 반복

-난수로 가중치 초기화

-입력 계층에 신호 입력 -> 입력 신호 순-전파 -> 출력 계층(출력 예측치)에서 오류 계산

-오류 역-전파: 5,6에서 나온 오류를 통해 3,4의 오류가 얼마인지를 계산하는 방법 / 5에서 발생하는 오차는 3,4에게도 책임이 있음 -> 5에서 오류를 나누어줄때도 가중치를 나눠서 줌(3: w3,5 , 4: w4,5)

-각각의 오차만 있으면 공식에서 각 뉴런들은 독자적으로 weight를 고치는 공식을 적용할 수 있음 -> 가중치 갱신