■ Intelligent Agent

■ 에이전트(Agent)

-

개념

-An autonomous entity(자율 존재) that perceives the environment with its sensors and upon the environment with its effectors

-주어진 환경에서 작업을 수행하며, 일련의 센서를 사용하여 환경에서 데이터를 수집하고, 이 데이터를 분석하여 적절한 행동을 결정하고 실행human agent

-sensors: eyes, ears,,

-effectors: hands, legs,,

robotic agent

-sensors: cameras and IR range finders

-effectors: various motors for actuators

ex) Bimetal thermal switch

-전기적인 신호를 통해 온도 변화를 감지하고, 온도가 일정 값 이상으로 상승하면 전기 신호를 발생시켜 회로를 차단하는 장치(난방기, 에어컨 등등) -

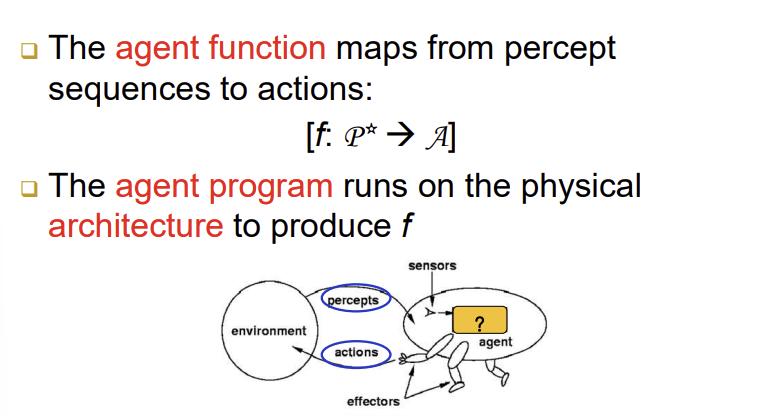

Agent Function & Program

-에이전트 기능은 percept sequences에서 actions로 매핑

-에이전트 프로그램은 physical architecture에서 실행되어 produce f 생성 -

청소 로봇(Vacuum-Cleaner)

-Percepts(!=raw sensory data): location and status( ex) [A,Dirty])

-Actions(!=direct motor control): Left, Right, Suck, Noop

■ 합리성(Rationality)

- 합리적인 에이전트(Rational Agent)

-A rational agent chooses whichever action maxinizes the expected value of the performance measure given the percept sequence to date

-현재까지 인식된 정보를 바탕으로, 성능을 최대화할 수 있을 것으로(결과가 가장 좋을 것으로) 예측되는 행동들을 선택할 줄 아는 에이전트

■ PEAS

-

작업 환경 명세

-To design a rational agent, we must specify task environment with PEAS(Performance Measure, Environment, Actuators, Sensors) -

ex) 자율 주행 자동차

-Sensor: cameras, speedometer, GPS,,,

-Actuators: steering, accelerator, brake,,,

-Environment: road, other traffic,,,

-Performance Measure: safety, legal, comfortable trip,,,

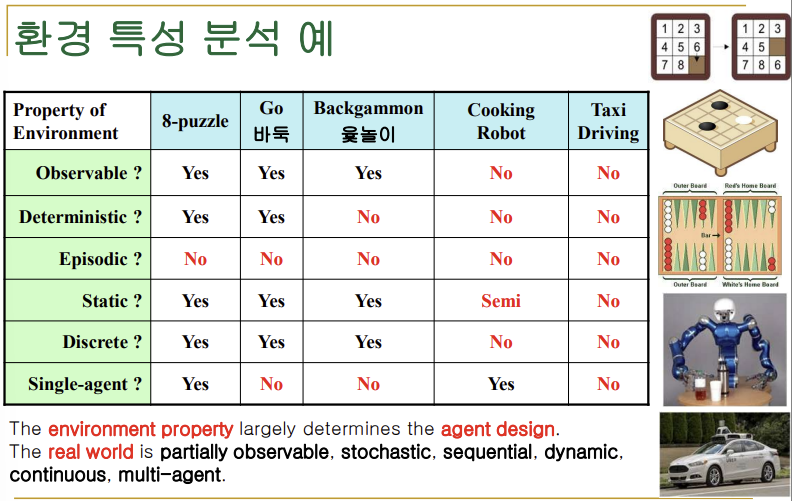

■ 환경 특성(Environment Properties)

- Fully observable vs Partially observerble

-완전 관측 가능 / 부분 관측 가능 - Deterministic vs Stochastic

-결정적 / 비 결정적(바둑 두기 vs 로봇 손을 이용한 머그컵 들기) - Static vs Dynamic

-정적 / 동적(바둑 두기 vs 도로위의 자율 주행) - Discrete vs Continuous

-이산적 / 연속적(격자 세계 이동 vs 드론 공중 비행/로봇 팔 제어) - Episodic vs Sequential

-단편적 / 순차적(과녁 맞추기 vs rubik cube 퍼즐 풀기) - Single Agent vs (Competitive/Cooperative) Multiagent

-단일 에이전트 / 멀티 에이전트(8퍼즐 풀기 vs 온라인 축구게임)

■ 에이전트 유형(Agent Types)

-

4가지 기본 유형들

-단순 반응형 에이전트(Simple Reflex Agent)

-모델-기반 반응형 에이전트(Model-Based Reflex Agent)

-목표-기반 에이전트(Goal-Based Agent)

-유틸리티-기반 에이전트(Utility-Based Agent)

-서로 다른 행동 결정 방식을 채택

-하지만, 학습 능력은 공통적으로 부여 가능 -

설계 고려사항들:

-유연성, 효율성 등

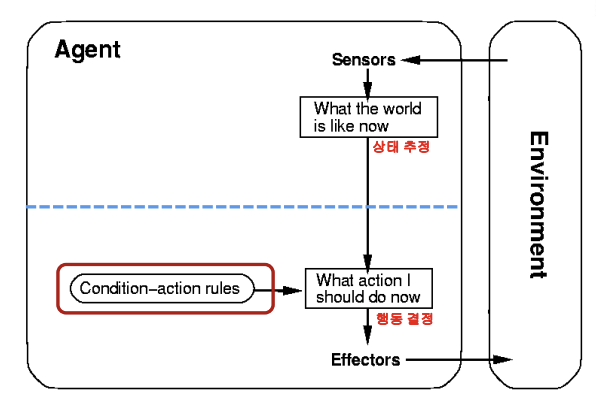

○ 단순 반응형 에이전트

→ 특징

-do not know what they want to achieve(no goal)

-do not know what they are doing(no plan)

-조건-행동 규칙(condition-action rule)들에 의해 행동 결정(if condition then action)

→ 장점

-빠른 행동 선택, 빠른 반응

→ 제한점

-올바른 행동 규칙들을 미리 제공해야 함

-과거 경험과 미래 예측에 대한 고려가 부족함

-실행 중 상황 변화에 대처할 유연성이 떨어짐

ex) 로봇 청소기

○ 모델-기반 반응형 에이전트

→ 특징

-센서들의 한계: 감지 범위, 노이즈, 다양한 불확실성 존재

-센서들이 외부 환경에 대한 완전한 상태 정보를 제공하지 못함

-별도의 내부 상태 정보를 유지, 관리

-조건-행동 규칙들을 적용, 행동 결정

→ 내부 상태의 관리 및 갱신

-2가지 종류의 지식(모델)이 필요

-월드 모델: How world evolves

-행동 모델: How agent's action affect the world

ex) 대화 시스템, 챗봇, 가상 비서

→ 단순 반응형 에이전트와의 차이점

-단순 반응형 에이전트는 미리 정해진 규칙에 부합하지 않으면 적절한 응답을 제공하지 못함

-모델-기반 반응형 에이전트는 대규모 데이터를 이용한 학습을 통해 새로운 상황에서도 최적의 응답을 생성할 수 있음

-즉 모델-기반 반응형 에이전트는 단순 반응형 에이전트보다 더욱 정확하고 유연한 응답 제공 가능

○ 목표-기반 에이전트

→ 특징

-현재 상태, 목표, 실행 가능한 행동과 효과에 대한 지식을 이용

-목표(goal) 달성을 위한 행동(action)을 결정

-적용 기술들: 탐색(serach)과 자동계획(planning)

→ 장점

-목표 지향적인 행위

-높은 자율성과 유연성

→ 단점

-복잡한 행동 결정 과정

-느린 반응, 낮은 효율성

ex) 인공지능 게임, 로봇제어

→ 모델-기반 반응형 에이전트와의 차이점

-모델-기반 반응형 에이전트는 사용자와의 상호작용을 처리하여 적절한 응답을 생성하는 반면, 복표-기반 에이전트는 주어진 목표를 달성하기 위해 행동을 선택

○ 유틸리티-기반 에이전트

→ 유틸리티 함수

-유틸리티: 행복/쓸모/이득

-각 상태의 유틸리티 값을 평가

→ 유틸리티 기반의 에이전트의 특징

-높은 유틸리티 값을 얻을 수 있는 행동을 선택

-합리적인 의사결정을 요구

-양질의 행위를 생성

ex) 자율 주행 자동차, 로봇

→ 목표-기반 에이전트와의 차이점

-목표-기반 에이전트는 목표 달성을 위해 행동을 선택하는 반면, 유틸리티 기반 에이전트는 보상이나 효용성 최대화를 위한 행동을 선택