[논문] Camera Distance-aware Top-down Approach for 3D Multi-person Pose Estimation from a Single RGB Image[ICCV 2019]

0

Pose Estimation 논문 리뷰

목록 보기

1/12

Gyeongsik Moon, Ju Yong Chang, Kyoung Mu Lee, ECE & ASRI, Seoul National University, Korea, ECE, Kwangwoon University, Korea

Abstract

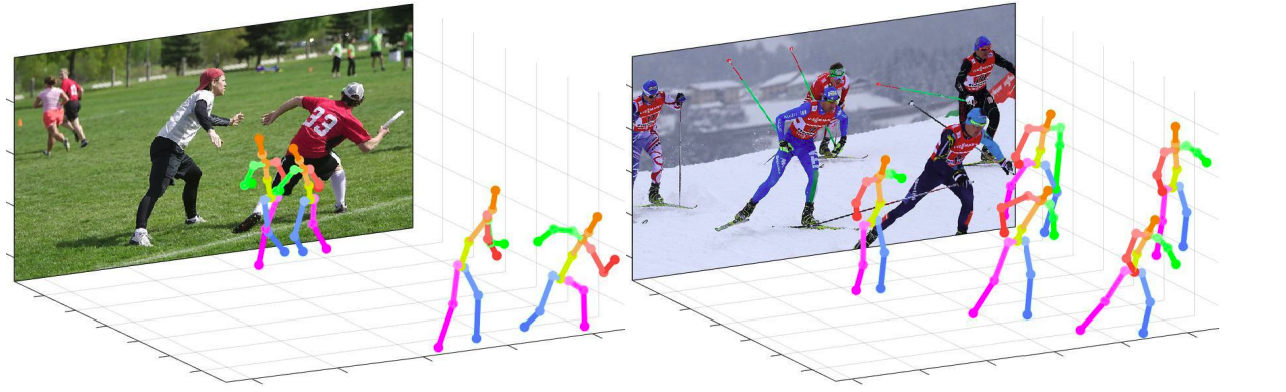

- 카메라 거리를 아는 상태에서의 top-down방식을 통한 3D single RGB 이미지로 부터 3D "multi" person pose estimation

- pipeline modules

- human detection

- absolute 3D human root localization

- root relative 3D single-person pose estimation

Introduction

- 본 연구는 세 개의 모듈을 사용한다.

- Input 이미지로부터 bbox를 찾는 DetectNet

- 카메라 중점의 사람의 중심(root) 좌표를 찾아 내는 RootNet

- 각각의 detect된 사람의 Root-relative 3D pose를 찾는 PoseNet

Related works

- 2D Multi-person Pose Estimation

- Top-down: 추론된 offset vector와 heatmap을 통해서 joint의 위치를 찾아내는 방식.

- Bottom-up:각각의 joint를 찾고, 그후 각각의 사람단위로 집합을 만드는 방식.

- 3D Single-person Pose Estimation

- single-stage approach: Input 이미지로부터 바로 3d pose를 찾아내는 방식

- two-stage approach: 2D좌표를 먼저 찾고 3D로 변환하는 방식

- 3D Multi-person Pose Estimation

- LCRNet(top-down): 사람 찾고, 사람의 anchor pose(2D pose와 root-relative pose쌍) 찾고, anchor pose를 걸러내는 방식

- bottom-up방식: 잘린부분, 보이지 않는 부분에 좋은 방식

- 3D Human Root Localization in 3D Multi-person Pose Estimation

Overview of the Proposed Model

- DetectNet: Input이미지로부터 사람의 bounding box를 찾고

- RootNet: cropped된 이미지로부터 사람의 중심 을 찾고(은 pixel coordinates, 은 depth value)

- PoseNet: cropped된 이미지로부터 root-relative 3D pose 을 찾아,

- 을 더함으로써 을 로 변환하고, 와 를 원래 이미지공간으로 변환시킨 후, simple back-projection을 통해 마지막 3D pose 를 얻는다

DetectNet

- MaskRCNN

- ResNet: feature map 추출

- Region Proposal Network: bbox 후보 추출

- HeadNet: bbox 정제

RootNet

- human depth를 구하기 위한

- : focal lengths divided by the per-pixel distance factors (pixel) of x- and y-axes

- :실제 공간()에서의 사람 면적

- : image 공간()

- Camera Normalization

- correction factor 를 출력 -> 를 학습에 사용

- 모델 구조

- ResNet을 통한 feature 추출

- BN과 ReLU을 포함한 Deconv 연속 3회를 통한 2D이미지 coordinate 추출

- 1-by-1 conv를 통한 중심(root)의 heatmap추출

- soft-argmax로 2D heatmap에서 추출

- feature을 pooling과 1-by-1 conv를 통한 추출

- k와 를 통한 계산

- loss: L1

PoseNet

- ResNet을 이용한 cropped 이미지의 global feature map 추출

- feature map을 BN과 ReLU를 포함한 연속적인 3번의 deconv를 통해 upsample하고 1-by-1 conv해서 3D heatmap추출

- loss: L1