본 포스트는 LG Aimers 활동에 참여하며 온라인 AI 교육을 정리한 내용입니다!

프로그램에 관심이 있으시다면 https://www.lgaimers.ai/ 를 참고해주세요!!

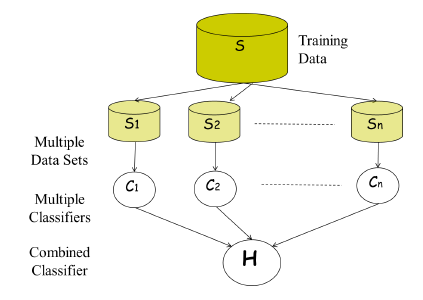

Ensemble

- 머신러닝에서 알고리즘의 종류에 상관 없이 서로 다르거나 같은 매커니즘으로 동작하는 다양한 머신러닝 모델을 묶어 함께 사용하는 방식

- 다양한 model의 각 장점을 살려서 예측 성능을 향상할 수 있다.

- 학습 data를 n개의 집합으로 나누어 학습을 진행한다.

- 최종 결정은 다수결로 예측을 진행하게 된다.

- 장점

- 예측 성능을 안정적으로 향상

- 다양한 model의 결정으로 최종 예측을 하기 때문에 noise 등으로부터 안정적이다.

- 쉽게 구현이 가능하다.

- model parameter의 tuning이 많이 필요 없다.

- 단점

- 모델 자체로는 compact한 표현이 되지 않는다.

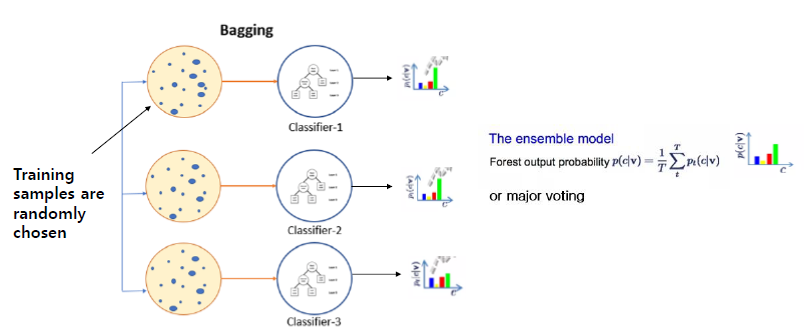

Bagging

- Bootstrapping + aggregating

- 학습 과정에서 training sample을 랜덤하게 나누어 선택해 학습

- 모델을 병렬적으로 학습할 수 있다.

- lower variance의 안정적인 성능을 제공하는데 유용하다.

Bootstraping

- 다수의 sample data set을 생성해서 학습하는 방식

- 서로 다른 모델 m개에 대해 같은 data를 m번 반복 or 다른 data m개를 반복 → noise에 robust하다.

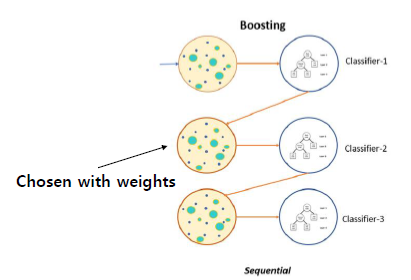

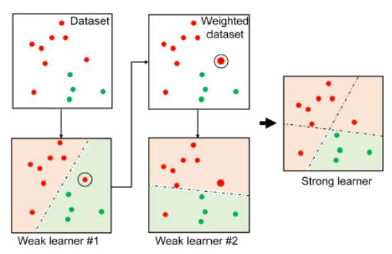

Boosting

- Sequential하게 동작한다.

- 다음 예측에 이전 결과를 이용하는 방식

- 결정을 하는 것에 weight를 주어 다음 분류에 적용을 할 수 있다.

Weak Classifier Cascading

- Weak classifier

- Bias가 높은 classifier

- model이 단순하여 성능이 낮아 혼자서 무엇을 하기 어려운 모델

- 이러한 weak classifier를 cascading을 하면 연쇄적으로 적용이 되어 classifier의 성능이 높아지게 된다.

Adaboost

- base classifier에 의해 오분류된 sample에 대해 보다 높은 가중치를 두어 다음 학습에 사용할 수 있게 한다.

- 장점

- 간단하게 구현이 가능한다.

- 특정한 학습 알고리즘에 구애받지 않는다.

Performance evaluation

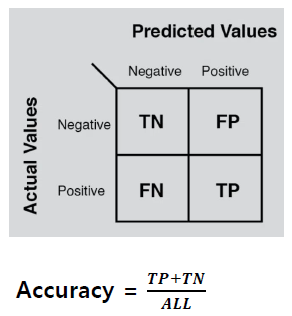

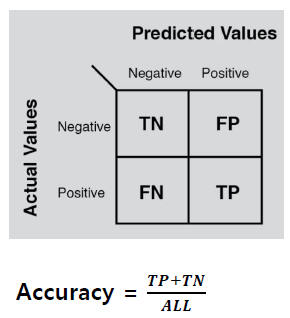

Accuracy

- Accuracy예측과 결과가 같은 비율을 확인한다.

- Confusion matrix : 각 경우에 대해 오차가 얼마 있었는지 표현하는 방법

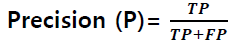

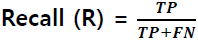

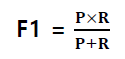

Precision & Recall & F1 Score

- Precision : 모델이 True라고 분류한 것 중에서 실제 True인 것의 비율

- Recall : 실제 True인 것 중에서 모델이 True라고 예측한 것의 비율

- F1 score : Precision과 Recall의 조화평균

- Unbalanced data의 경우 accuracy 이외에도 precision, recall 값을 동시에 봐야 성능을 제대로 측정할 수 있다.

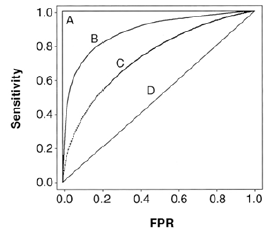

ROC Curve

- 서로 다른 classifier의 성능을 측정하는데 사용하는 Curve

- 왼쪽 상단으로 갈수록 좋은 성능을 의미한다.

Error measure

- 실제 중요하게 되는 것에 따라 accuracy, precision, recall 등 중요도를 두고 판단해야한다.

- ex) 암환자 판정의 경우 recall이 중요 / 재난지원금 분배 여부의 경우 precision이 중요...