본 글은 LLM from Scratch의 저자 세바스찬 라쉬카(Sebastian Rashka)의 아티클을 공부 목적으로 번역하여 정리한 것이다.

The Big LLM Architecture Comparison [원문]

From DeepSeek-V3 to gpt-oss: A Look At Modern LLM Architecture Design

최초의 GPT 아키텍처가 개발된 지 7년이 경과했다. GPT-2 (2019)를 돌아보고 DeepSeek-V3와 Llama 4 (2024-2025)를 전망해 볼 때, 이 모델들이 여전히 구조적으로 매우 유사하다는 점은 놀라울 수 있다.

물론, positional embedding은 절대(absolute) 방식에서 rotational (RoPE)으로 발전했으며, Multi-Head Attention은 대체로 Grouped-Query Attention으로 전환되었고, GELU와 같은 활성화 함수는 더 효율적인 SwiGLU로 대체되었다.

그러나 이러한 미미한 개선 사항을 넘어, 진정한 의미의 획기적 변화가 있었는지, 혹은 단순히 기존 아키텍처의 기반을 개선하는 것에 불과한 것인지는 의문이다.

LLM의 성능에 기여하는 핵심 요소를 판별하기 위해 여러 모델을 비교하는 것은 매우 어려운 과제이다. 이는 데이터셋, 훈련 기법, 하이퍼파라미터가 매우 다양하고, 관련 문서가 충실히 기록되지 않은 경우가 많기 때문이다.

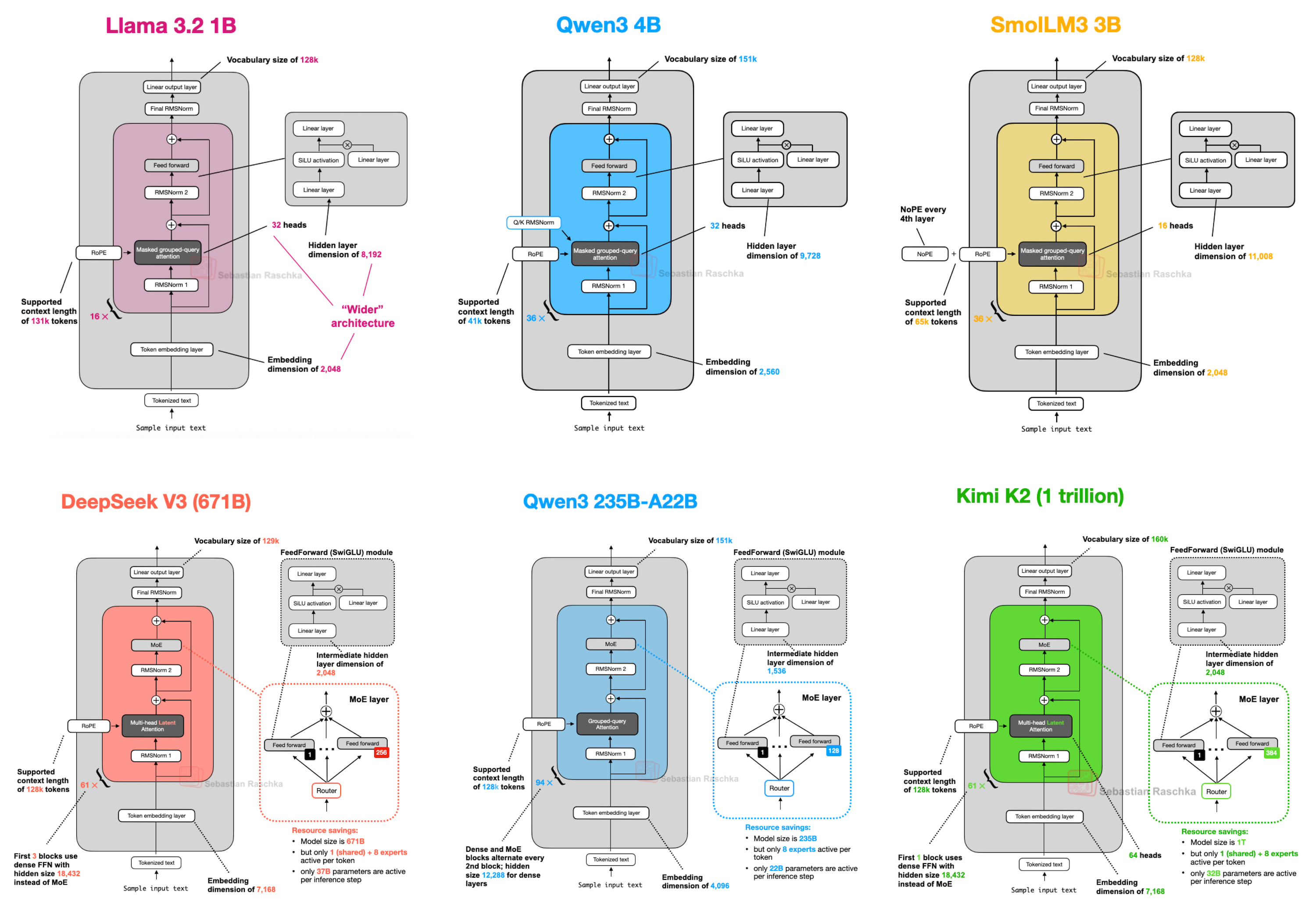

그럼에도 불구하고, 2025년 LLM 개발자들의 동향을 파악하기 위해 아키텍처 자체의 구조적 변화를 검토하는 것은 상당한 가치를 지닌다고 판단된다. (이 중 일부 사례가 아래 [그림 1]에 제시되어 있다.)

[Figure 1. A subset of the architectures covered in this article.]

따라서 본 고에서는 벤치마크 성능이나 훈련 알고리즘을 다루기보다, 오늘날의 대표적인 공개 모델들을 정의하는 아키텍처 발전에 초점을 맞추고자 한다.

1. DeepSeek V3/R1

이미 여러 차례 알려진 바와 같이, 2025년 1월에 출시된 DeepSeek R1은 상당한 파급력을 보여주었다.

DeepSeek R1은 2024년 12월에 소개된 DeepSeek V3 아키텍처를 기반으로 구축된 추론(reasoning) 모델이다.

본고에서는 2025년에 출시된 아키텍처에 중점을 두지만, DeepSeek V3는 2025년 DeepSeek R1 출시 이후에야 광범위한 주목과 채택을 받았다는 점에서 함께 다루는 것이 타당하다고 판단된다.

본 섹션에서는 DeepSeek V3에 도입되어 연산 효율성을 개선하고 다른 LLM과 차별화되는 다음의 두 가지 핵심 아키텍처 기법에 초점을 맞춘다:

- Multi-Head Latent Attention (MLA)

- Mixture-of-Experts (MoE)

1.1 Multi-Head Latent Attention (MLA)

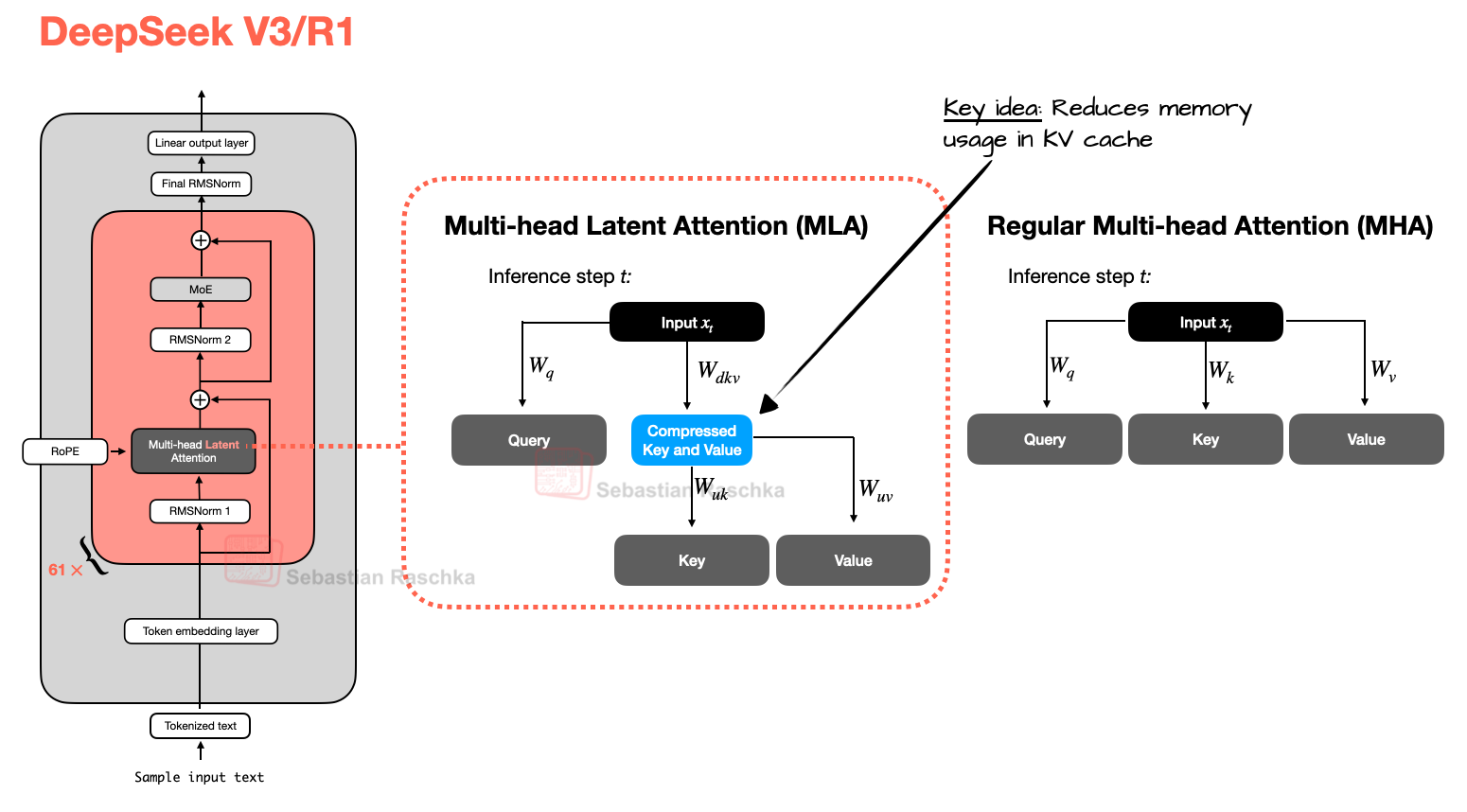

Multi-Head Latent Attention (MLA)를 논의하기에 앞서, 이 기법이 사용되는 동기를 이해하기 위한 배경 지식을 간략히 살펴볼 필요가 있다.

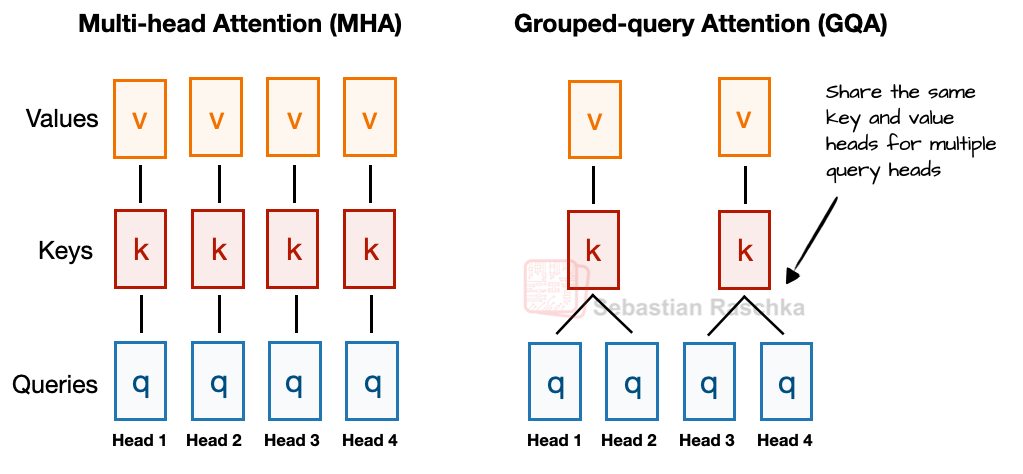

이를 위해, 최근 몇 년간 Multi-Head Attention (MHA)를 대체하는 더 효율적인 연산 및 파라미터 대안으로 새로운 표준이 된 Grouped-Query Attention (GQA)부터 시작한다.

GQA를 간략히 요약하면 다음과 같다. 각 헤드(head)가 자체적인 키(key)와 값(value)을 갖는 MHA와 달리, GQA는 메모리 사용량을 줄이기 위해 여러 헤드를 그룹화하여 동일한 키와 값 프로젝션(projection)을 공유한다.

예를 들어, 아래 [그림 2]에서 더 자세히 설명하듯이, 2개의 키-값 그룹과 4개의 어텐션 헤드가 있는 경우, 헤드 1과 2가 하나의 키-값 세트를 공유하고, 헤드 3과 4가 다른 세트를 공유할 수 있다.

이는 키와 값 연산의 총 수를 줄여 메모리 사용량을 낮추고 효율성을 향상시킨다 (ablation study에 따르면, 모델링 성능에 눈에 띄는 영향은 주지 않는다).

[Figure 2: A comparison between MHA and GQA. Here, the group size is 2, where a key and value pair is shared among 2 queries.]

즉, GQA의 핵심 아이디어는 여러 쿼리(query) 헤드에 걸쳐 키(key)와 값(value) 헤드를 공유함으로써 그 수를 줄이는 것이다. 이는 (1) 모델의 파라미터 수를 감소시키고, (2) 추론(inference) 시 KV cache에 저장하고 검색해야 할 키와 값의 수가 줄어들기 때문에 키와 값 텐서(tensor)에 대한 메모리 대역폭(bandwidth) 사용량을 줄인다.

GQA는 주로 MHA의 연산 효율성을 높이기 위한 해결책이지만, ablation study(기존 GQA 논문 및 Llama 2 논문 등)에 따르면 LLM 모델링 성능 측면에서는 표준 MHA와 유사한 성능을 보인다.

한편, Multi-Head Latent Attention (MLA)는 KV 캐싱과 특히 잘 결합되는 다른 방식의 메모리 절약 전략을 제공한다. GQA처럼 키와 값 헤드를 공유하는 대신, MLA는 K,V 텐서를 KV cache에 저장하기 전에 더 낮은 차원의 공간으로 압축한다.

추론 시에는 아래 [그림 3]과 같이, 이 압축된 텐서들이 사용되기 전에 원래 크기로 다시 프로젝션(projection)된다. 이 과정은 추가적인 행렬 곱셈을 필요로 하지만 메모리 사용량을 감소시킨다.

Figure 3: Comparison between MLA (used in DeepSeek V3 and R1) and regular MHA.

참고로, 쿼리(query)도 압축되지만 이는 추론(inference)이 아닌 훈련(training) 과정에서만 이루어진다.

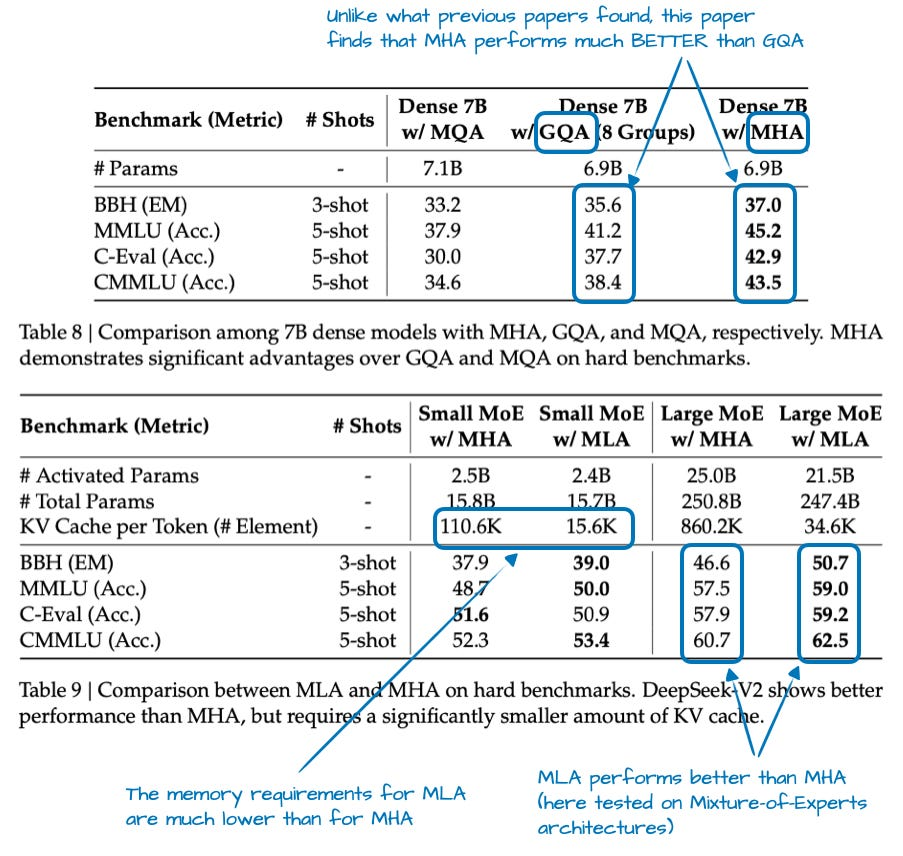

MLA는 DeepSeek V3에서 처음 도입된 기술은 아니며, 이전 버전인 DeepSeek-V2에서 이미 사용 및 소개된 바 있다. 또한 V2 논문에는 DeepSeek 팀이 GQA 대신 MLA를 선택한 이유를 설명할 수 있는 몇 가지 흥미로운 ablation study 결과가 포함되어 있다 (아래 [그림 4] 참조).

[Figure 4: Annotated tables from the DeepSeek-V2 paper]

위 [그림 4]에서 볼 수 있듯이, GQA는 MHA보다 성능이 저하되는 것으로 나타나는 반면, MLA는 MHA보다 더 나은 모델링 성능을 제공한다. 이는 DeepSeek 팀이 GQA 대신 MLA를 선택한 주된 이유로 추정된다. (MLA와 GQA 간의 '토큰당 KV Cache' 절감 효과를 비교한 자료가 있었다면 더 흥미로웠을 것이다.)

다음 아키텍처 구성 요소로 넘어가기 전에 본 섹션을 요약하면, MLA는 모델링 성능 측면에서 MHA를 소폭 능가하면서도 KV cache 메모리 사용량을 줄이는 효과적인 기법이라고 할 수 있다.

1.2 Mixture-of-Experts (MoE)

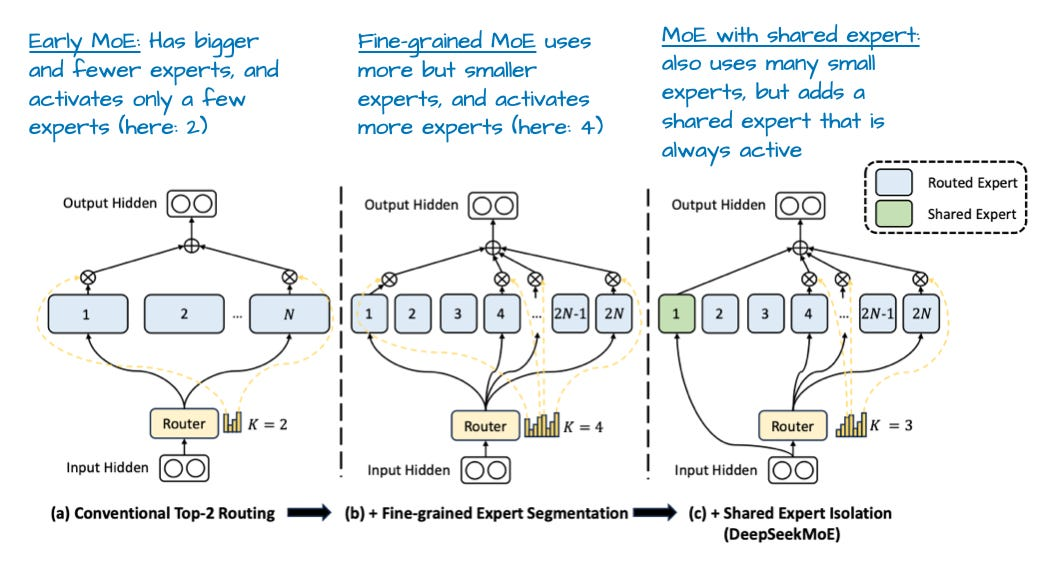

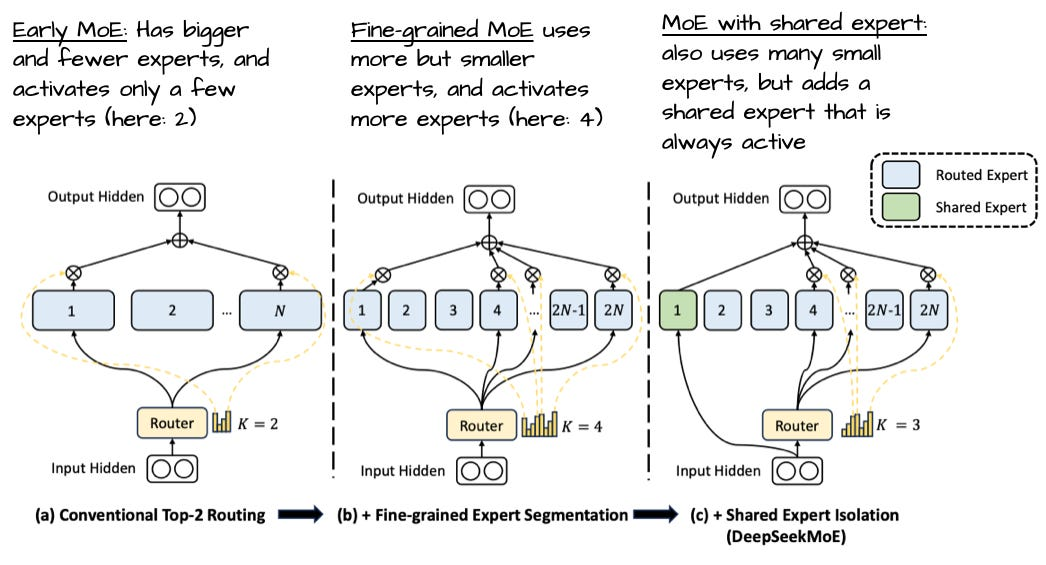

DeepSeek에서 주목할 만한 또 다른 주요 아키텍처 구성 요소는 Mixture-of-Experts (MoE) 레이어를 사용했다는 점이다. DeepSeek이 MoE를 처음 개발한 것은 아니지만, 이 기술은 올해 다시 부상했으며 이후에 다룰 많은 아키텍처에서도 이를 채택하고 있다.

MoE의 개념을 간략히 되짚어 본다.

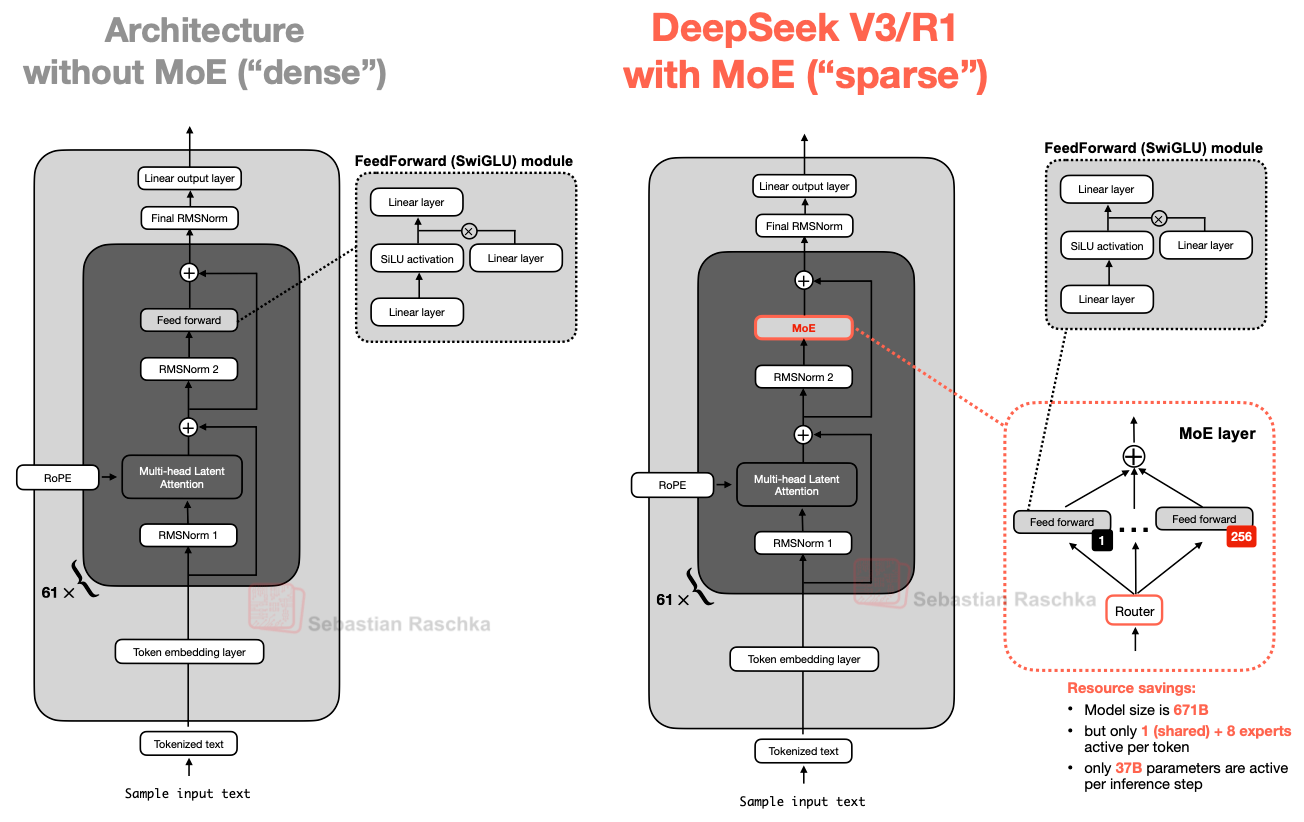

MoE의 핵심 아이디어는 transformer 블록의 각 FeedForward 모듈을 여러 '전문가(expert)' 레이어로 대체하는 것이며, 여기서 각 전문가 레이어 역시 FeedForward 모듈이다. 즉, 아래 [그림 5]에서 볼 수 있듯이 단일 FeedForward 블록이 여러 FeedForward 블록으로 교체되는 것을 의미한다.

[Figure 5: An illustration of the Mixture-of-Experts (MoE) module in DeepSeek V3/R1 (right) compared to an LLM with a standard FeedForward block (left).]

Transformer 블록 내부의 FeedForward 블록(위 그림의 어두운 회색 블록)은 일반적으로 모델 전체 파라미터의 상당 부분을 차지한다. (참고로, transformer 블록, 그리고 그에 따른 FeedForward 블록은 LLM 내에서 여러 번 반복되며, DeepSeek-V3의 경우 61회 반복된다.)

따라서 단일 FeedForward 블록을 여러 FeedForward 블록으로 대체하면(MoE 구조에서처럼) 모델의 총 파라미터 수가 크게 증가한다.

그러나 핵심적인 기법은 모든 토큰에 대해 모든 전문가(expert)를 사용('활성화')하지 않는다는 점이다. 대신, '라우터(router)'가 토큰당 전문가의 일부 서브셋(subset)만을 선택한다.

[본문에 없는 추가 설명]

MoE architecture의 Router

: 각 토큰에게 가장 적합한 전문가(Expert)가 누구인지 결정하고, 작업을 효율적으로 분배하는 중간 관리자의 역할Router의 작동 원리

토큰 정보 입력: Transformer 블록의 이전 레이어에서 처리된 결과, 즉 특정 토큰에 대한 정보가 담긴 벡터(hidden state)가 라우터에 입력전문가별 '적합도' 점수 계산: 라우터는 그 자체로 하나의 작은 신경망(보통 간단한 Feedforward layer)임. 입력된 토큰 벡터를 받아서, 가지고 있는 모든 전문가의 수만큼의 '점수(logit)'를 계산.

예를 들어 전문가가 128명이라면, 라우터는 128개의 점수를 출력하고, 각 점수는 "이 토큰을 처리하는 데 이 전문가가 얼마나 적합할까?"를 나타냄.Top-K(상위 K개) 전문가 선택: 계산된 점수가 가장 높은 전문가 K개를 선택. 이 K값은 모델을 설계할 때 미리 정해주는 하이퍼파라미터이며, 보통 2 ~ 8처럼 아주 작은 수가 됨- 가중치(Gating Value) 계산 및 분배 : 전문가를 선택한 후, 각 전문가에게 '얼마나 중요하게' 일을 맡길지 가중치를 부여. 2단계에서 계산한 점수에 Softmax 함수를 적용하여 확률화

- 최종 결과 취합 : 선택된 전문가들이 각자 계산을 수행한 후, 라우터는 4단계에서 계산한 가중치를 적용하여 그 결과들을 하나로 합함. 합쳐진 결과는 MoE Layer의 최종 출력이 되어 다음 TF 블록으로 전달됨

한 번에 소수의 전문가만 활성화되므로, MoE 모듈은 전체 파라미터 세트를 항상 사용하는 '밀집(dense)' 모듈과 대조적으로 '희소(sparse)' 모듈이라고 불린다. 그러나 MoE를 통한 많은 총 파라미터 수는 LLM의 '용량(capacity)'을 증가시키는데, 이는 훈련 중에 더 많은 지식을 습득할 수 있음을 의미한다.

한편, 모든 파라미터를 동시에 사용하지 않기 때문에 희소성(sparsity)은 추론의 효율성을 유지시킨다.

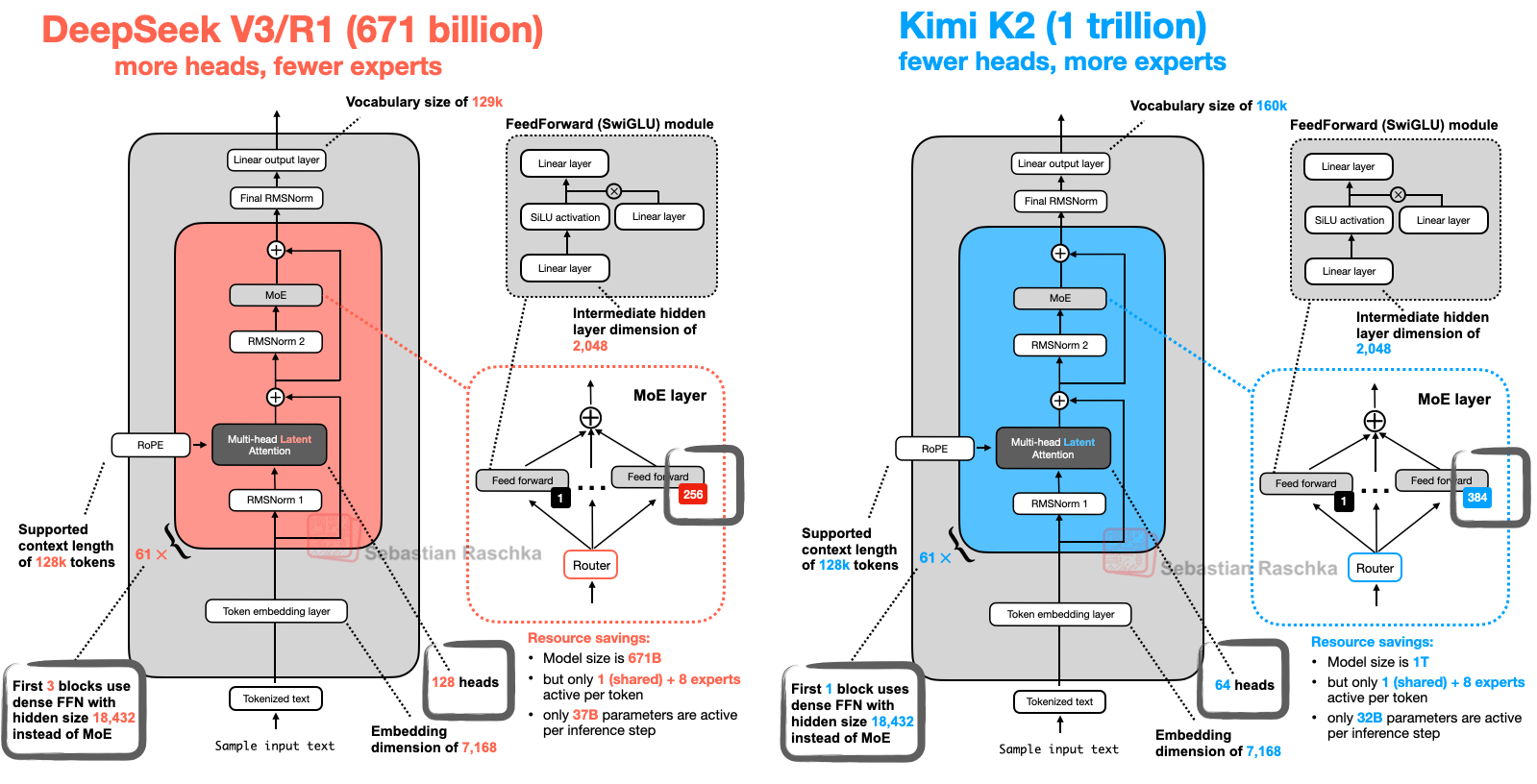

예를 들어, DeepSeek-V3는 MoE 모듈당 256개의 전문가를 가지며, 총 6,710억 개의 파라미터를 보유한다. 그러나 추론 시에는 한 번에 9개의 전문가(공유 전문가 1개 + 라우터가 선택한 8개)만이 활성화된다. 이는 추론 단계마다 전체 6,710억 개가 아닌 370억 개의 파라미터만 사용됨을 의미한다.

DeepSeek-V3의 MoE 설계에서 주목할 만한 특징 중 하나는 '공유 전문가(shared expert)'를 사용한다는 점이다. 이는 모든 토큰에 대해 항상 활성화되는 전문가이다. 이 아이디어는 새로운 것이 아니며, DeepSeek 2024 MoE 논문과 2022년 DeepSpeedMoE 논문에서 이미 소개된 바 있다.

[Figure 6: An annotated figure from "DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models"]

공유 전문가를 두는 것의 이점은 DeepSpeedMoE 논문에서 처음 언급되었으며, 해당 논문에서는 공유 전문가가 없는 경우에 비해 전반적인 모델링 성능을 향상시킨다는 점을 발견했다. 이는 공통적이거나 반복적인 패턴을 여러 개별 전문가가 학습할 필요가 없게 되어, 각 전문가가 더 특화된 패턴을 학습할 수 있는 여지를 더 많이 확보하게 되기 때문으로 추정된다.

1.3 DeepSeek 요약

요약하면, DeepSeek-V3는 6,710억 개의 파라미터를 가진 대규모 모델로, 출시 당시 4,050억 개의 파라미터를 가진 Llama 3를 포함한 다른 공개 가중치(open-weight) 모델들을 능가하는 성능을 보였다.

모델 규모는 더 크지만, 토큰당 일부 파라미터(단 370억 개)만을 활성화하는 Mixture-of-Experts (MoE) 아키텍처 덕분에 추론 시 효율성은 훨씬 더 높다.

또 다른 핵심적인 차별점은 DeepSeek-V3가 Grouped-Query Attention (GQA) 대신 Multi-Head Latent Attention (MLA)를 사용한다는 것이다.

MLA와 GQA는 모두 표준 Multi-Head Attention (MHA)에 대한 추론 효율적인 대안이며, 특히 KV 캐싱을 사용할 때 그 효과가 두드러진다. MLA는 구현이 더 복잡하지만, DeepSeek-V2 논문의 한 연구에서는 GQA보다 더 나은 모델링 성능을 제공하는 것으로 나타났다.

2. OLMo 2

비영리 단체인 Allen Institute for AI의 OLMo 모델 시리즈는 훈련 데이터와 코드의 투명성, 그리고 비교적 상세한 기술 보고서 덕분에 주목할 만하다.

OLMo 모델이 벤치마크나 리더보드 최상위권에 있는 경우는 드물지만, 모델이 상당히 정제되어 있고, 더 중요하게는 그 투명성 덕분에 LLM 개발을 위한 훌륭한 청사진을 제공한다.

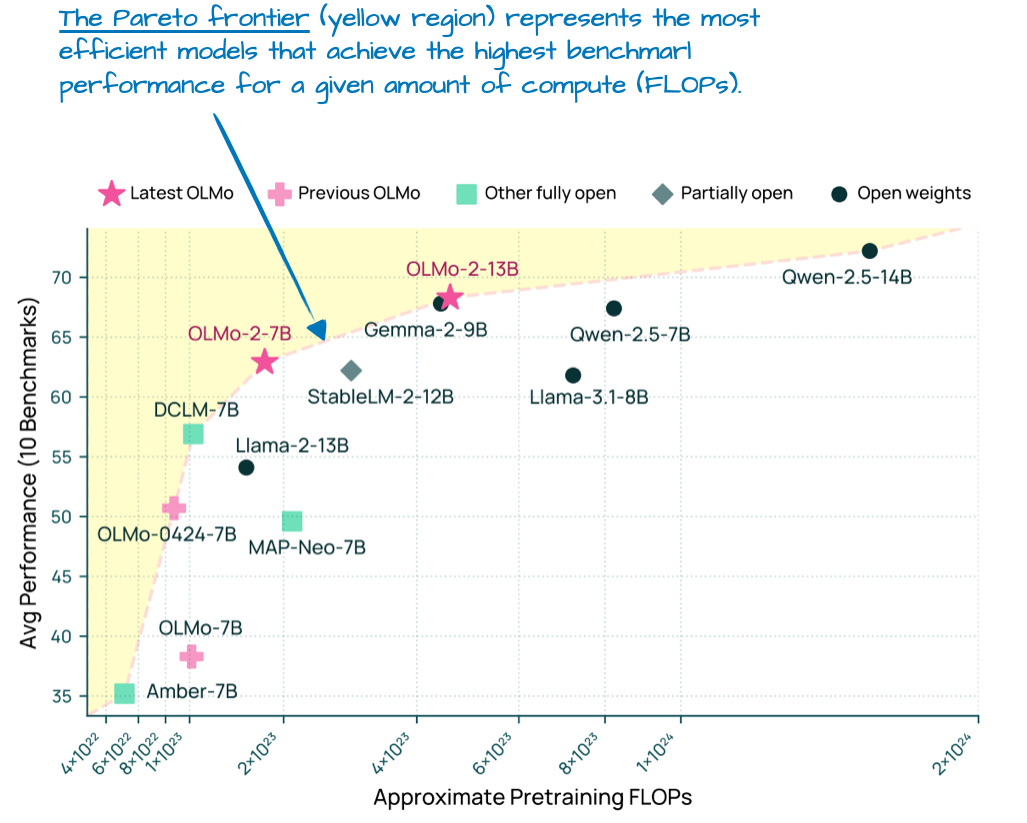

OLMo 모델은 투명성으로 널리 알려져 있지만, 성능 또한 준수한 편이다. 실제로 1월 출시 시점(Llama 4, Gemma 3, Qwen 3 이전)에는 아래 [그림 7]에서 볼 수 있듯이, OLMo 2 모델이 연산 대비 성능의 파레토 프론티어(Pareto frontier)에 위치해 있었다.

[Figure 7: Modeling benchmark performance (higher is better) vs pre-training cost (FLOPs; lower is better) for different LLMs. This is an annotated figure from the OLMo 2 paper]

본 아티클의 서두에서 언급했듯이, 관리 가능한 분량을 위해 LLM 아키텍처 세부 사항(훈련이나 데이터 제외)에만 초점을 맞춘다.

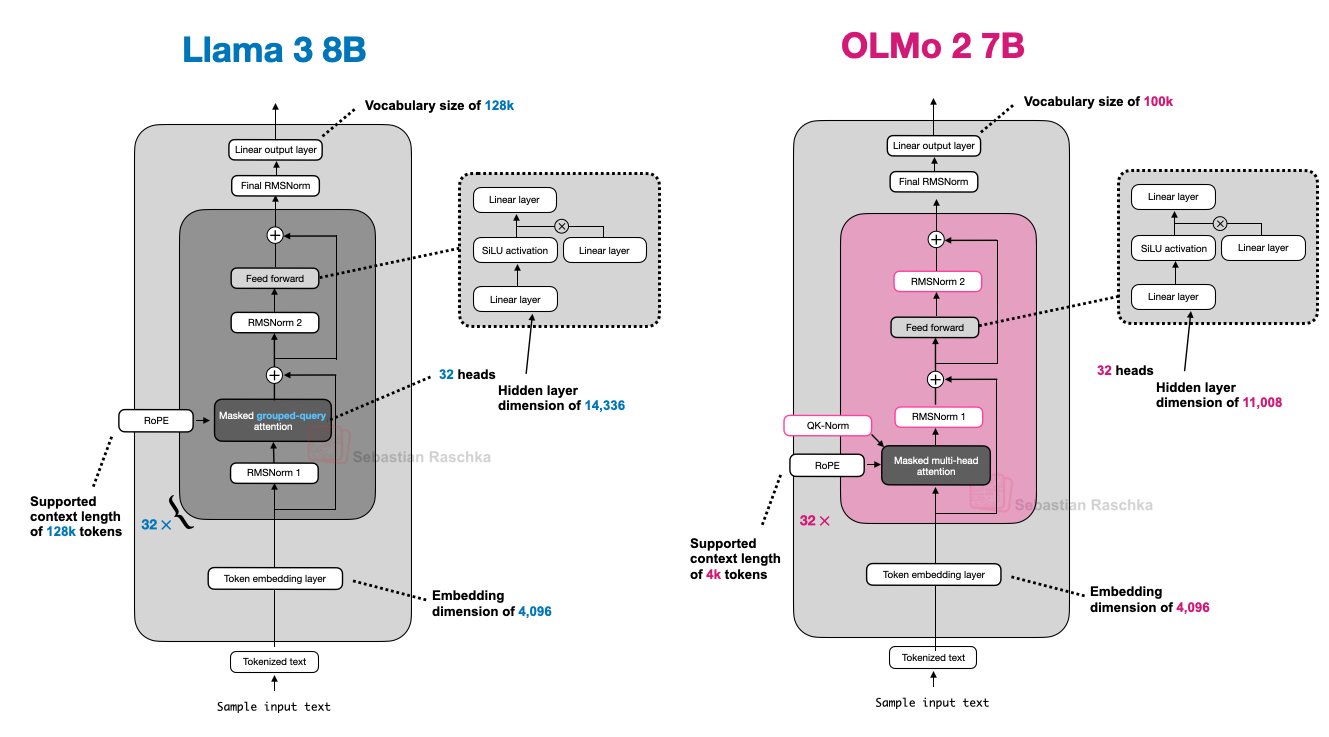

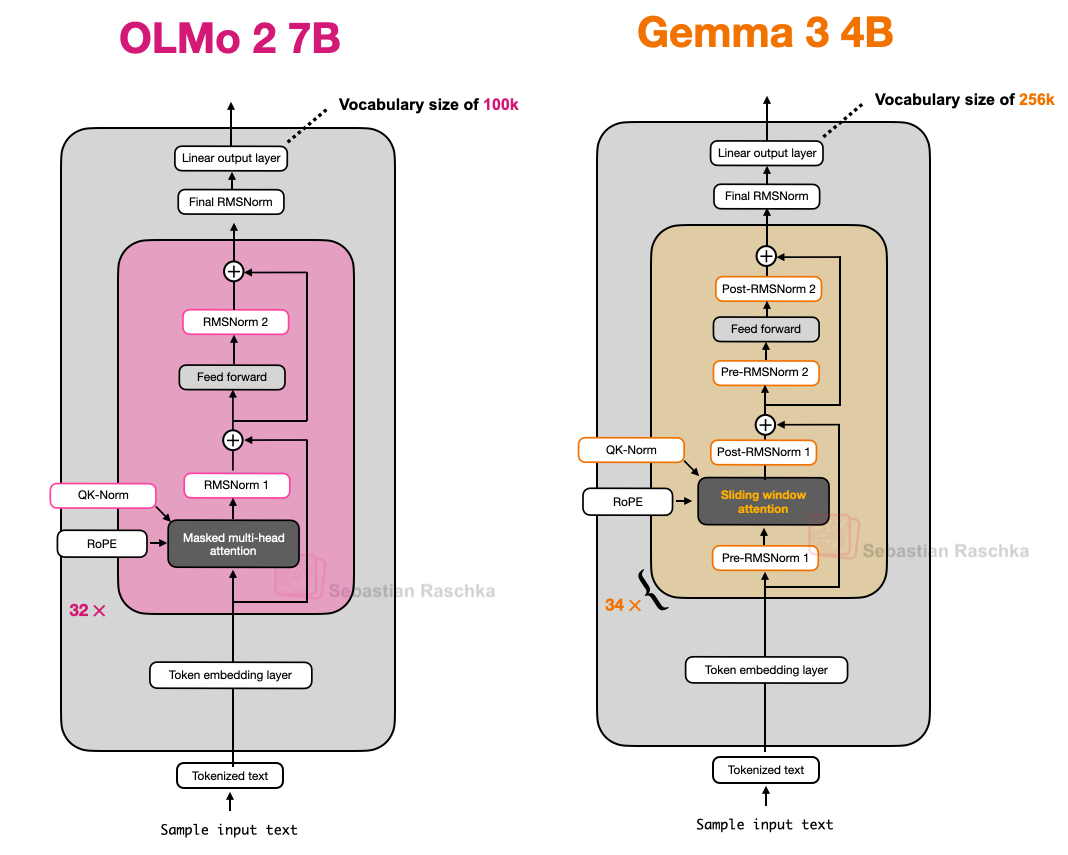

OLMo2의 흥미로운 아키텍처 설계 선택은 주로 정규화(normalization)에 관한 것으로 요약된다. 이는 RMSNorm 레이어의 배치와 QK-norm의 추가이며, 아래에서 논의할 예정이다.

언급할 만한 또 다른 사항은 OLMo 2가 MLA나 GQA 대신 여전히 전통적인 Multi-Head Attention (MHA)을 사용한다는 점이다.

2.1 Normalization Layer Placement

전반적으로 OLMo 2는 다른 최신 LLM과 유사하게 기존 GPT 모델의 아키텍처를 대체로 따르지만, 몇 가지 주목할 만한 차이점이 존재한다. 정규화 레이어부터 살펴본다.

Llama, Gemma 및 대부분의 다른 LLM과 마찬가지로, OLMo 2는 LayerNorm에서 RMSNorm으로 전환했다.

그러나 RMSNorm은 이미 널리 알려진 기술이므로(기본적으로 LayerNorm에서 학습 가능한 파라미터 수를 줄인 단순화된 버전), RMSNorm과 LayerNorm의 비교 논의는 생략한다. (RMSNorm 코드 구현은 'GPT-2 to Llama 변환 가이드'에서 찾아볼 수 있다.)

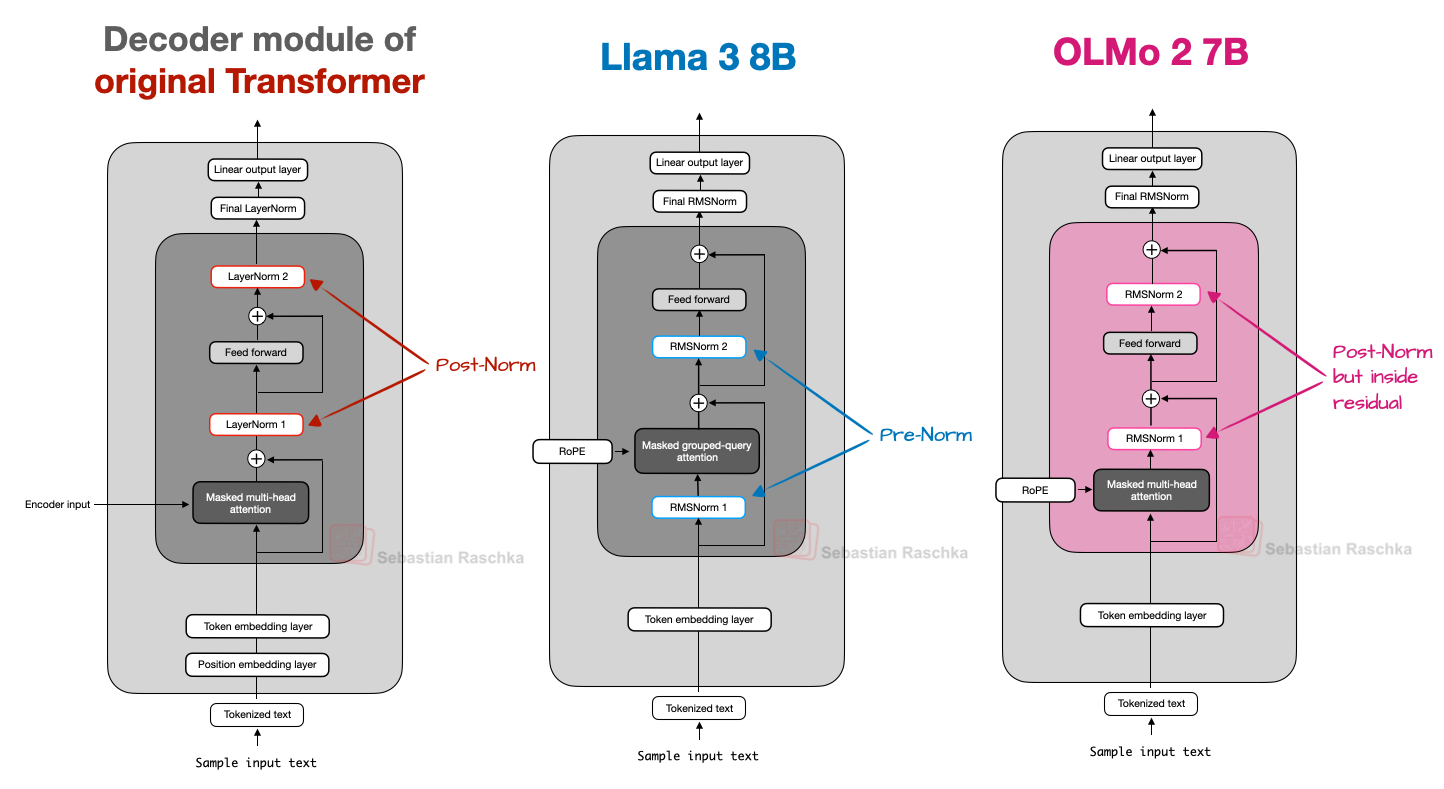

하지만 RMSNorm 레이어의 배치에 대해서는 논의할 가치가 있다. 기존 transformer("Attention is all you need" 논문)는 transformer 블록 내 두 개의 정규화 레이어를 각각 어텐션 모듈과 FeedForward 모듈 뒤에 배치했다. 이는 Post-LN 또는 Post-Norm으로도 알려져 있다.

이후에 등장한 GPT와 대부분의 LLM은 정규화 레이어를 어텐션 및 FeedForward 모듈 앞에 배치했으며, 이는 Pre-LN 또는 Pre-Norm으로 알려져 있다. Post-Norm과 Pre-Norm의 비교는 아래 그림에 나타나 있다.

[Figure 8: A comparison of Post-Norm, Pre-Norm, and OLMo 2's flavor of Post-Norm.]

2020년 Xiong et al. 연구에서는 Pre-LN이 초기화(initialization) 시 더 안정적인 그래디언트(gradient)를 보인다는 점을 입증했다. 더 나아가, 연구진들은 Pre-LN이 세심한 learning rate warm-up 없이도 잘 작동한다고 언급했는데, 이는 Post-LN에서는 필수적인 기법이다.

이러한 배경을 언급하는 이유는 OLMo 2가 Post-LN의 한 형태를 채택했기 때문이다. (다만 LayerNorm 대신 RMSNorm을 사용하므로, 여기서는 이를 Post-Norm이라 칭한다.)

OLMo 2에서는 정규화 레이어를 어텐션 및 FeedForward 레이어 앞에 배치하는 대신, 위 그림과 같이 그 뒤에 배치한다. 그러나 기존 transformer 아키텍처와는 대조적으로 정규화 레이어가 여전히 잔차 레이어(residual layer, skip connection) 내부에 위치한다는 점에 주목할 필요가 있다.

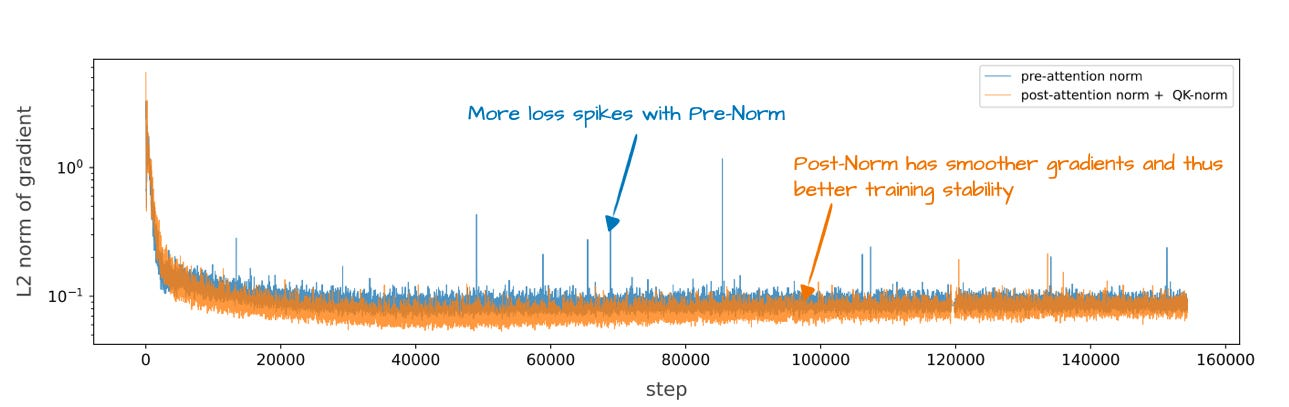

이처럼 정규화 레이어의 위치를 변경한 이유는 아래 그림에서 볼 수 있듯이 훈련 안정성(training stability)에 도움이 되었기 때문이다.

[Figure 9: A plot showing the training stability for Pre-Norm (like in GPT-2, Llama 3, and many others) versus OLMo 2's flavor of Post-Norm. This is an annotated figure from the OLMo 2 paper]

아쉽게도 해당 그림은 재배치의 결과를 별개의 개념인 QK-Norm과 함께 보여주고 있어, 정규화 레이어 재배치 단독의 기여도를 파악하기는 어렵다.

2.2 QK-Norm

이전 섹션에서 QK-norm이 이미 언급되었고, 이후에 다룰 Gemma 2 및 Gemma 3와 같은 다른 LLM에서도 QK-norm을 사용하므로, 이것이 무엇인지 간략히 논의한다.

QK-Norm은 본질적으로 또 하나의 RMSNorm 레이어라고 할 수 있다. 이는 Multi-Head Attention (MHA) 모듈 내부에 위치하며, RoPE를 적용하기 전에 쿼리(q)와 키(k)에 적용된다.

앞서 언급했듯이, QK-Norm은 Post-Norm과 함께 훈련을 안정화하는 역할을 한다. 참고로, QK-Norm은 OLMo 2에서 처음 개발된 것이 아니라 2023년의 'Scaling Vision Transformers' 논문에 그 기원을 두고 있다.

2.3 OLMo 2 Summary

요컨대, OLMo 2 아키텍처의 주목할 만한 설계 결정은 주로 RMSNorm의 배치에 관한 것이다. 즉, 어텐션 및 FeedForward 모듈 이전 대신 이후에 RMSNorm을 배치하는 것(Post-Norm의 일종)과, 어텐션 메커니즘 내의 쿼리와 키에 RMSNorm을 추가하는 것(QK-Norm)이며, 이 두 가지는 함께 훈련 손실(training loss)을 안정화하는 데 기여한다.

아래 그림은 OLMo 2와 Llama 3를 나란히 비교한 것이다. 그림에서 볼 수 있듯이, OLMo 2가 GQA 대신 전통적인 MHA를 여전히 사용한다는 점을 제외하면 두 아키텍처는 비교적 유사하다. (다만, OLMo 2 팀은 3개월 후 GQA를 사용하는 32B(320억) 파라미터 변형 모델을 출시했다.)

[Figure 10: An architecture comparison between Llama 3 and OLMo 2.]

Gemma 3

구글의 Gemma 모델은 Llama 시리즈와 같은 다른 유명 모델에 비해 상대적으로 저평가된 경향이 있으나, 꾸준히 우수한 성능을 보여왔다.

Gemma의 특징 중 하나는 (다국어 지원을 강화하기 위한) 비교적 큰 어휘(vocabulary) 크기와, (8B 또는 70B 대비) 27B 크기에 더 중점을 둔다는 점이다. 참고로 Gemma 2는 1B, 4B, 12B와 같은 더 작은 크기로도 제공된다.

27B 크기는 8B 모델보다 훨씬 성능이 뛰어나면서도 70B 모델만큼 자원 집약적이지 않아, 성능과 효율성 사이의 이상적인 지점(sweet spot)에 해당한다. 또한 로컬 환경에서도 원활하게 실행 가능하다.

Gemma 3의 또 다른 흥미로운 특징은 다음과 같다.

앞서 논의했듯이, Deepseek-V3/R1과 같은 다른 모델들은 주어진 모델 크기에서 추론 시 메모리 요구량을 줄이기 위해 Mixture-of-Experts (MoE) 아키텍처를 사용한다. (MoE 접근 방식은 이후에 다룰 여러 다른 모델에서도 사용된다.)

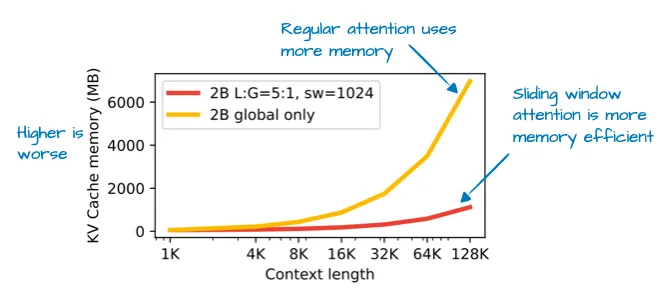

Gemma 3는 연산 비용을 줄이기 위해 다른 기법, 즉 슬라이딩 윈도우 어텐션(sliding window attention)을 사용한다.

3.1 Sliding Window Attention

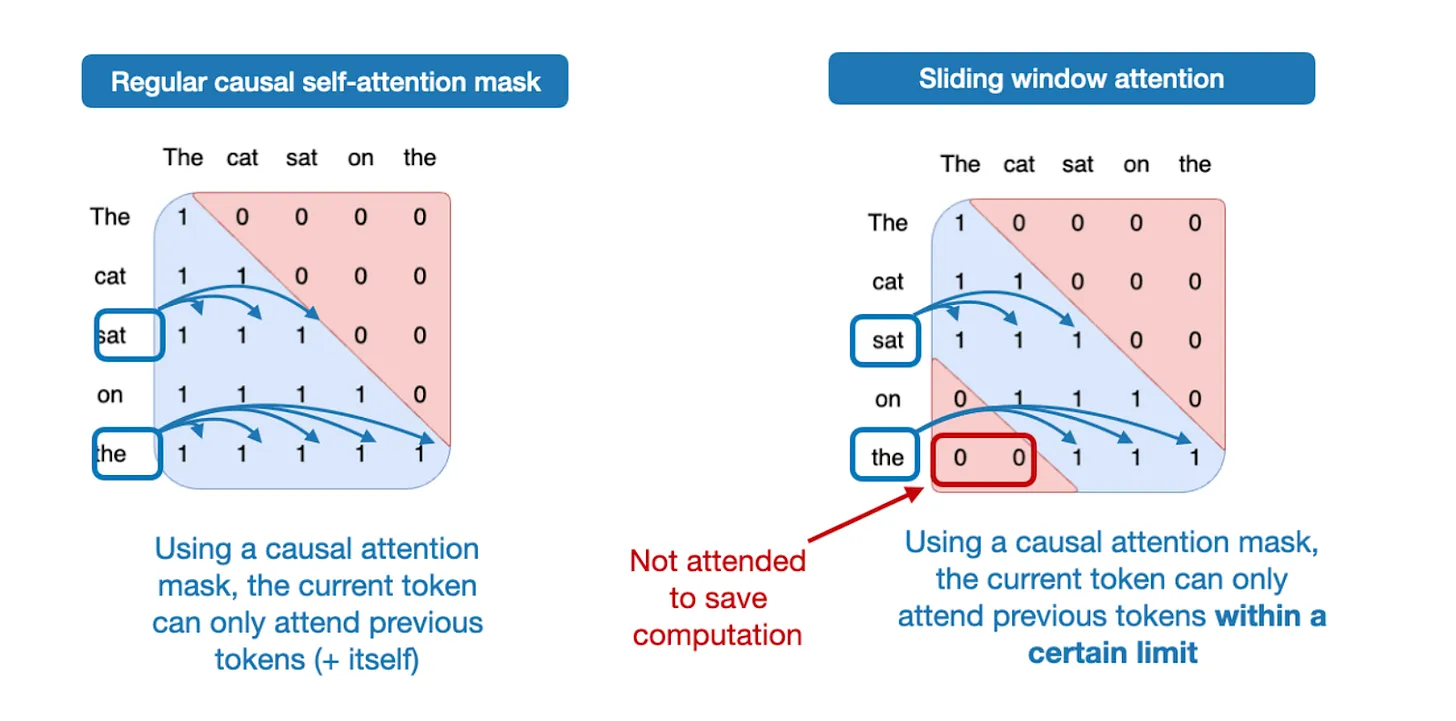

Sliding window attention(2020년 LongFormer 논문에서 처음 소개되었으며 Gemma 2에서도 이미 사용됨)을 통해, Gemma 3는 아래 그림에서 볼 수 있듯이 KV cache의 메모리 요구량을 상당량 줄일 수 있었다.

[Figure 11: An annotated figure from Gemma 3 paper showing the KV cache memory savings via sliding window attention.]

그렇다면 sliding window attention이란 무엇인가? 일반적인 self-attention은 각 시퀀스 요소가 다른 모든 시퀀스 요소에 접근할 수 있으므로 '전역(global)' 어텐션 메커니즘으로 간주할 수 있다. 이와 대조적으로, sliding window attention은 현재 쿼리 위치 주변의 컨텍스트 크기를 제한하므로 '지역(local)' 어텐션으로 볼 수 있다. 이는 아래 그림에 설명되어 있다.

[Figure 12: A comparison between regular attention (left) and sliding window attention (right).]

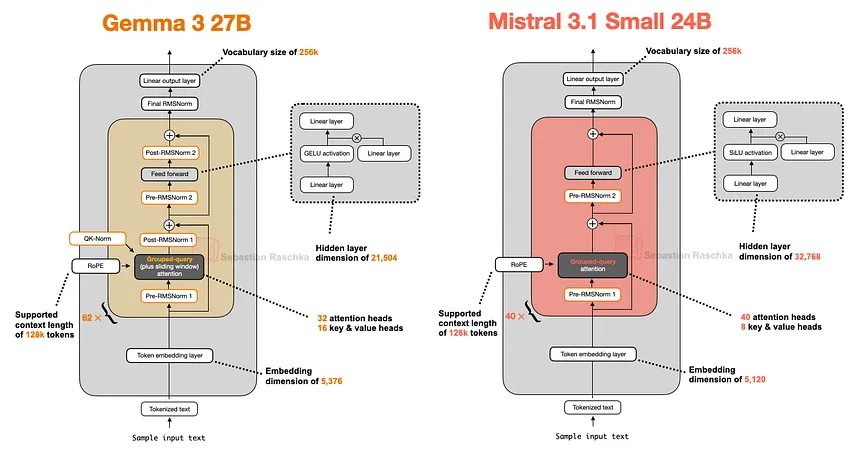

Sliding window attention은 Multi-Head Attention과 Grouped-Query Attention 모두에 사용될 수 있으며, Gemma 3는 Grouped-Query Attention을 사용한다는 점에 유의해야 한다.

앞서 언급했듯이, sliding window attention은 지역(local) 윈도우가 현재 쿼리 위치를 둘러싸고 함께 이동하기 때문에 '지역(local)' 어텐션이라고도 불린다. 반면, 일반적인 어텐션은 각 토큰이 다른 모든 토큰에 접근할 수 있으므로 '전역(global)' 어텐션이다.

이전 버전인 Gemma 2 아키텍처에서도 sliding window attention이 사용된 바 있다. Gemma 3의 차이점은 전역(일반) 어텐션과 지역(슬라이딩) 어텐션 간의 비율을 조정했다는 점이다.

예를 들어, Gemma 2는 sliding window 지역 어텐션과 전역 어텐션을 1:1 비율로 결합한 하이브리드 어텐션 메커니즘을 사용한다. 각 토큰은 인접한 컨텍스트의 4k 토큰 윈도우에 어텐션을 적용할 수 있다.

Gemma 2가 격층으로 sliding window attention을 사용한 반면, Gemma 3는 이제 5:1 비율을 적용한다. 이는 5개의 sliding window (지역) 어텐션 레이어마다 단 1개의 전체 어텐션 레이어만 존재함을 의미한다. 더 나아가, 슬라이딩 윈도우 크기는 4096(Gemma 2)에서 1024(Gemma 3)로 축소되었다. 이는 모델의 초점을 더 효율적인 지역화된 연산으로 이동시키는 변화이다.

Gemma 3의 ablation study에 따르면, 아래 그림에서 볼 수 있듯이 sliding window attention의 사용은 모델링 성능에 미미한 영향을 미치는 것으로 나타났다.

3.2 Normalization Layer Placement in Gemma 3

사소하지만 흥미로운 점은 Gemma 3가 Grouped-Query Attention 모듈을 중심으로 Pre-Norm과 Post-Norm 설정 모두에서 RMSNorm을 사용한다는 것이다.

이는 Gemma 2와 유사하지만, (1) 기존 transformer(“Attention is all you need”)에서 사용된 Post-Norm, (2) GPT-2에 의해 대중화되어 이후 많은 아키텍처에서 사용된 Pre-Norm, (3) 앞서 살펴본 OLMo 2의 Post-Norm 방식과 모두 다르다는 점에서 주목할 가치가 있다.

[Figure 14: An architecture comparison between OLMo2 and Gemma 3; note the additional normalization layers in Gemma 3.]

이러한 정규화 레이어 배치는 Pre-Norm과 Post-Norm의 장점을 모두 취할 수 있어 비교적 직관적인 접근법으로 평가된다. 추가적인 정규화는 최악의 경우 중복으로 인한 약간의 비효율성을 야기할 수 있으나, 전체적인 관점에서 RMSNorm의 연산 비용은 상대적으로 낮으므로 실제로는 눈에 띄는 영향을 미치지 않을 것으로 보인다.

3.3 Gemma 3 요약

Gemma 3는 우수한 성능을 보이는 공개 가중치(open-weight) LLM으로, 오픈소스 커뮤니티에서 상대적으로 저평가된 경향이 있다. 가장 흥미로운 부분은 효율성 향상을 위한 sliding window attention의 사용이며, 향후 MoE와 결합하는 방식도 기대된다.

또한, Gemma 3는 어텐션 및 FeedForward 모듈의 앞과 뒤 모두에 RMSNorm 레이어를 배치하는 독특한 정규화 레이어 배치 구조를 가진다.

3.4 추가: Gemma 3n

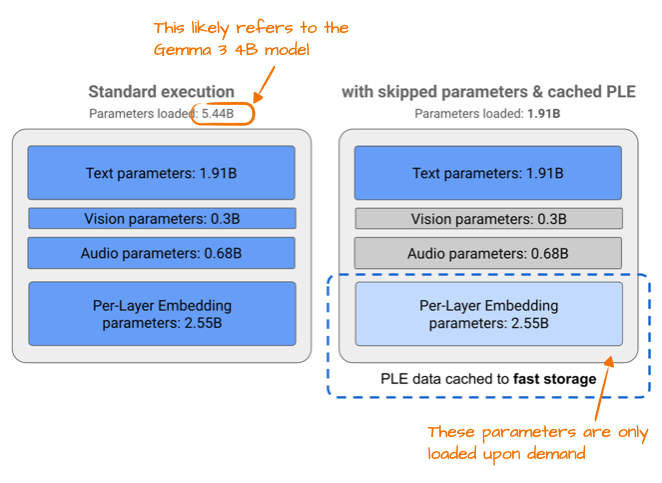

Gemma 3 출시 몇 달 후, 구글은 스마트폰에서 실행하는 것을 목표로 소형 기기 효율성에 최적화된 Gemma 3 모델인 Gemma 3n을 공개했다.

Gemma 3n에서 더 나은 효율성을 달성하기 위한 변경 사항 중 하나는 소위 Per-Layer Embedding (PLE) 파라미터 레이어이다. 여기서 핵심 아이디어는 모델 파라미터의 일부 서브셋(subset)만을 GPU 메모리에 유지하는 것이다. 이후 텍스트, 오디오, 비전 양식(modality)과 같은 토큰-레이어별 임베딩은 필요에 따라 CPU나 SSD에서 스트리밍된다.

아래 그림은 PLE의 메모리 절감 효과를 보여주며, 표준 Gemma 3 모델에 대해 54.4억 개의 파라미터를 나열하고 있다. 이는 Gemma 3 4B(40억) 변형 모델을 지칭하는 것으로 보인다.

[Figure 15: An annotated figure from Google's Gemma 3n blog illustrating the PLE memory savings.]

파라미터 수 간의 불일치(54.4억 개 vs 40억 개?)는 구글이 LLM의 파라미터 수를 보고하는 독특한 방식 때문이다.

구글은 종종 모델을 더 작게 보이게 하기 위해 임베딩 파라미터를 제외하지만, 이 경우처럼 모델을 더 크게 보이게 하는 것이 유리할 때는 이를 포함하기도 한다. 이러한 접근 방식은 구글에만 국한된 것이 아니며, 업계 전반에 걸쳐 일반적인 관행이 되었다.

또 다른 흥미로운 기법은 MatFormer 개념(Matryoshka Transformer의 줄임말)이다. 예를 들어, Gemma 3n은 더 작고 독립적으로 사용 가능한 모델로 분할될 수 있는 단일 공유 LLM(transformer) 아키텍처를 사용한다. 각 조각(slice)은 자체적으로 기능하도록 훈련되므로, 추론 시에는 대형 모델 전체 대신 필요한 부분만 실행할 수 있다.

4. Mistral Small 3.1

Gemma 3 직후인 3월에 출시된 Mistral Small 3.1 24B는 더 빠르면서도 여러 벤치마크(수학 제외)에서 Gemma 3 27B를 능가하는 성능을 보였다는 점에서 주목할 만하다.

Mistral Small 3.1이 Gemma 3보다 낮은 추론 지연 시간(inference latency)을 보이는 이유는 자체 토크나이저(tokenizer) 사용과 더불어 KV cache 및 레이어 수를 줄였기 때문으로 추정된다. 그 외에는 아래 그림에서 볼 수 있듯이 표준적인 아키텍처를 따른다.

[Figure 16: An architecture comparison between Gemma 3 27B and Mistral 3.1 Small 24B.]

흥미로운 점은, 이전 Mistral 모델들은 sliding window attention을 활용했지만 Mistral Small 3.1에서는 이를 사용하지 않은 것으로 보인다는 점이다.

따라서 Mistral이 Gemma 3처럼 슬라이딩 윈도우를 사용하는 Grouped-Query Attention 대신 일반적인 Grouped-Query Attention을 사용하기 때문에, 더 최적화된 코드(예: FlashAttention)를 사용할 수 있어 추가적인 추론 연산 절감 효과가 있을 수 있다.

예를 들어, sliding window attention이 메모리 사용량을 줄이는 반면, 추론 지연 시간(inference latency)을 반드시 줄이는 것은 아니며, Mistral Small 3.1은 후자에 더 중점을 둔 것으로 추측된다.

5. Llama 4

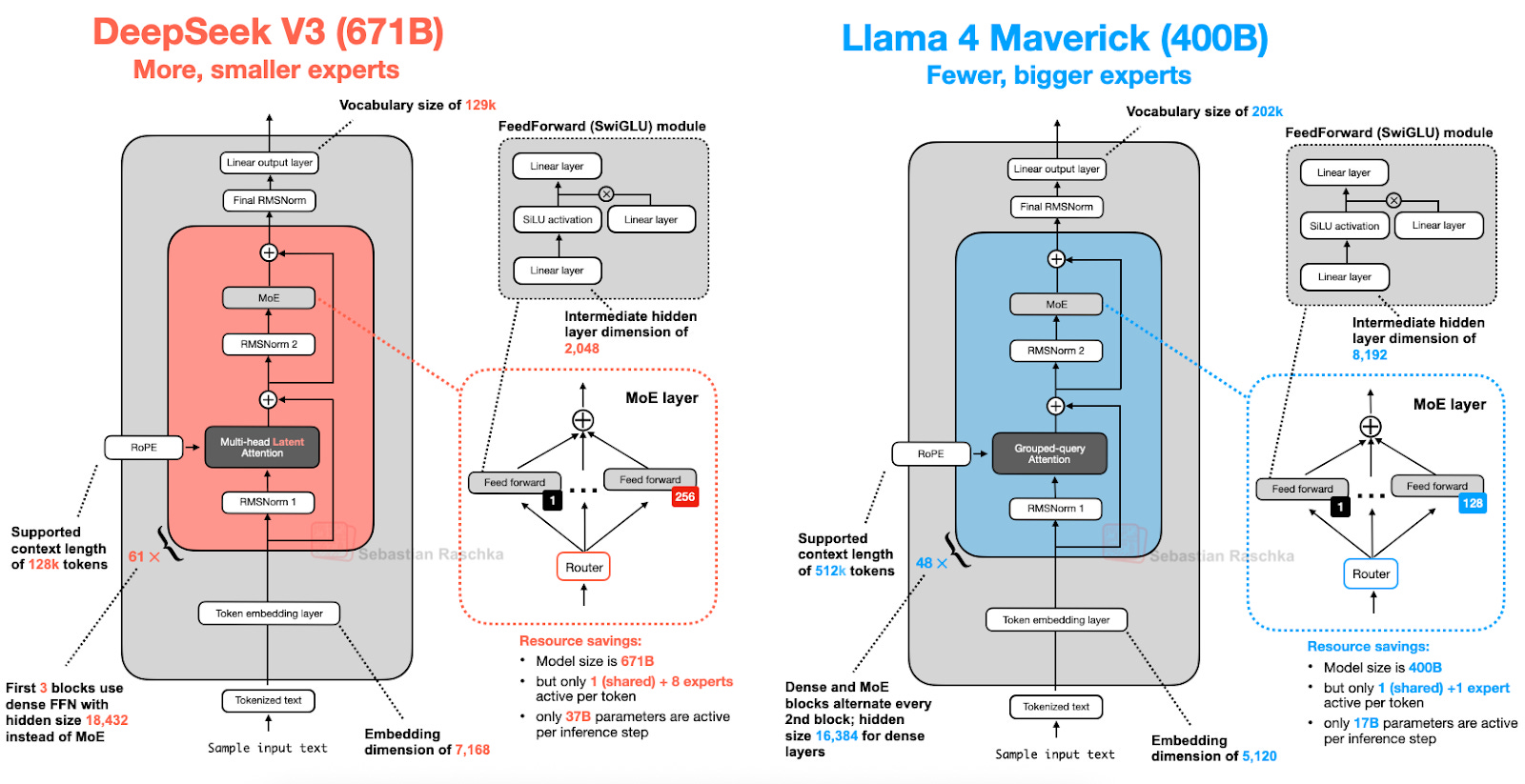

본 아티클의 앞부분에서 광범위하게 다룬 Mixture-of-Experts (MoE)에 대한 논의는 Llama 4를 이해하는 데에도 유용하다. Llama 4 역시 MoE 접근 방식을 채택했으며, 그 외에는 아래 그림에서 볼 수 있듯이 DeepSeek-V3와 매우 유사한 비교적 표준적인 아키텍처를 따른다. (Llama 4는 Gemma 및 Mistral과 같은 모델과 유사하게 네이티브 멀티모달(multimodal)을 지원한다. 그러나 본 아티클은 언어 모델링에 초점을 맞추므로, 텍스트 모델에만 집중하여 다룬다.)

Llama 4 Maverick 아키텍처가 전반적으로 DeepSeek-V3와 매우 유사해 보이지만, 주목할 만한 몇 가지 흥미로운 차이점이 있다.

첫째, Llama 4는 이전 모델들과 유사하게 Grouped-Query Attention을 사용하는 반면, DeepSeek-V3는 본 논문 서두에서 논의했던 Multi-Head Latent Attention을 사용한다.

DeepSeek-V3와 Llama 4 Maverick은 모두 매우 큰 아키텍처이며, DeepSeek-V3의 총 파라미터 수는 약 68% 더 많다.

하지만, DeepSeek-V3는 370억 개의 활성 파라미터를 가져 Llama 4 Maverick(170억 개)보다 두 배 이상 많은 활성 파라미터를 가진다.

[Figure 17: An architecture comparison between DeepSeek V3 (671-billion parameters) and Llama 4 Maverick (400-billion parameters).]

Llama 4 Maverick은 DeepSeek-V3(각각 2,048의 hidden size를 가진 9개의 활성 expert)에 비해 더 적지만 더 큰 expert(각각 8,192의 hidden size를 가진 2개의 활성 expert)를 사용하는 더 고전적인 MoE 설정을 채택한다.

또한, DeepSeek은 첫 3개를 제외한 각 transformer 블록에 MoE 레이어를 사용하는 반면, Llama 4는 한 블록 건너 MoE와 dense 모듈을 번갈아 가며 사용한다.

아키텍처 간의 많은 사소한 차이점을 고려할 때, 최종 모델 성능에 미치는 정확한 영향을 파악하기는 어렵다. 그러나 핵심은 2025년에 MoE 아키텍처의 인기가 크게 증가했다는 점이다.

6. Qwen3

Qwen 팀은 꾸준히 고품질의 공개 가중치(open-weight) LLM을 출시해왔다. 실제로 NeurIPS 2023에서 열린 LLM 효율성 챌린지(efficiency challenge)의 최상위 수상 솔루션들은 모두 Qwen2 기반이었다.

Qwen3 역시 각 크기 등급에서 리더보드 최상위에 오르며 성공적인 모델 시리즈로 자리매김했다. 7개의 밀집(dense) 모델(0.6B, 1.7B, 4B, 8B, 14B, 32B)과 2개의 MoE 모델(30B-A3B, 235B-A22B)이 있다.

(참고로, "Qwen3"의 공백 부재는 오타가 아니며, Qwen 개발팀이 선택한 원 표기를 따른 것이다.)

6.1 Qwen3 (Dense)

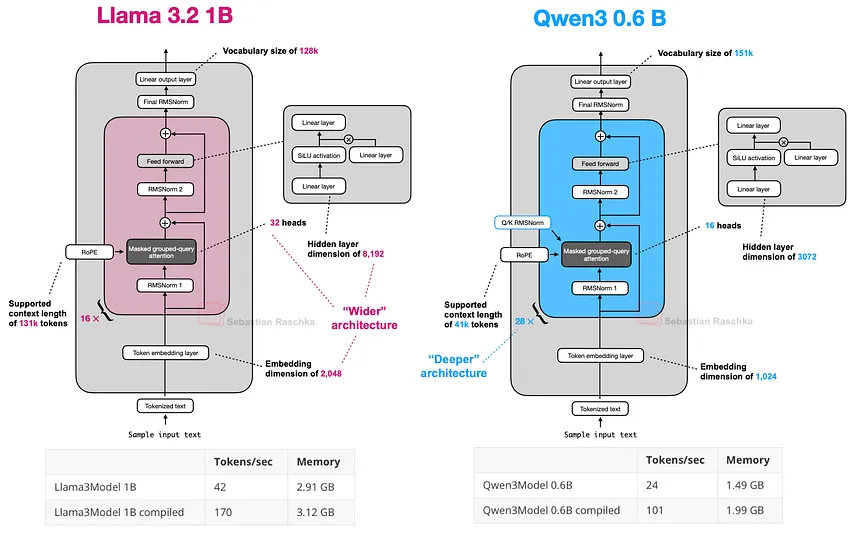

먼저 밀집(dense) 모델 아키텍처를 논의한다. 이 글을 작성하는 시점에서 0.6B 모델은 현 세대 공개 가중치 모델 중 가장 작은 모델일 가능성이 높다.

작은 크기에도 불구하고 매우 우수한 성능을 보이며, 로컬 환경에서 실행 시 높은 token/sec 처리량과 낮은 메모리 사용량을 특징으로 한다. 더 나아가, 작은 크기 덕분에 (교육 목적으로) 로컬 환경에서 훈련하기도 용이하다.

이러한 장점들로 인해, Qwen3 0.6B는 여러 활용 사례에서 Llama 3 1B를 대체할 수 있는 강력한 대안으로 부상했다. 두 아키텍처 간의 비교는 아래와 같다.

[Figure 18: An architecture comparison between Qwen3 0.6B and Llama 3 1B; notice that Qwen3 is a deeper architecture with more layers, whereas Llama 3 is a wider architecture with more attention heads.]

위 그림의 연산 성능 수치는 A100 GPU에서 실행된 PyTorch 직접 구현 코드를 기반으로 한다. 그림에서 볼 수 있듯이, Qwen3는 전반적으로 더 작은 아키텍처이므로 메모리 사용량이 더 적으며, 더 작은 은닉층(hidden layer)과 더 적은 어텐션 헤드를 사용한다. 그러나 Llama 3보다 더 많은 transformer 블록을 사용하기 때문에 실행 시간은 더 느리다(더 낮은 tokens/sec 생성 속도).

6.2 Qwen3 (MoE)

앞서 언급했듯이, Qwen3는 30B-A3B와 235B-A22B 두 가지 MoE 버전으로도 제공된다. Qwen3와 같은 일부 아키텍처가 일반(밀집, dense) 버전과 MoE(희소, sparse) 버전으로 모두 제공되는 이유는 무엇인가?

본 아티클 서두에서 언급했듯이, MoE 버전은 대규모 기본 모델의 추론 비용을 줄이는 데 도움이 된다. 밀집(dense) 버전과 MoE 버전을 모두 제공함으로써 사용 목적과 제약 조건에 따라 유연하게 선택할 수 있는 폭을 넓혀준다.

밀집(dense) 모델은 일반적으로 다양한 하드웨어에서 미세조정(fine-tune), 배포 및 최적화하기가 더 용이하다.

반면, MoE 모델은 추론 확장성(scaling inference)에 최적화되어 있다. 예를 들어, 고정된 추론 예산 하에서 추론 비용을 비례적으로 증가시키지 않으면서도 더 높은 전체 모델 용량(즉, 더 큰 크기로 인한 훈련 중 지식 습득량)을 달성할 수 있다.

두 가지 유형을 모두 출시함으로써, Qwen3 시리즈는 더 넓은 범위의 사용 사례를 지원할 수 있다. 즉, 견고성, 단순성 및 미세조정을 위해서는 밀집 모델을, 대규모 환경에서의 효율적인 서빙을 위해서는 MoE 모델을 사용할 수 있다.

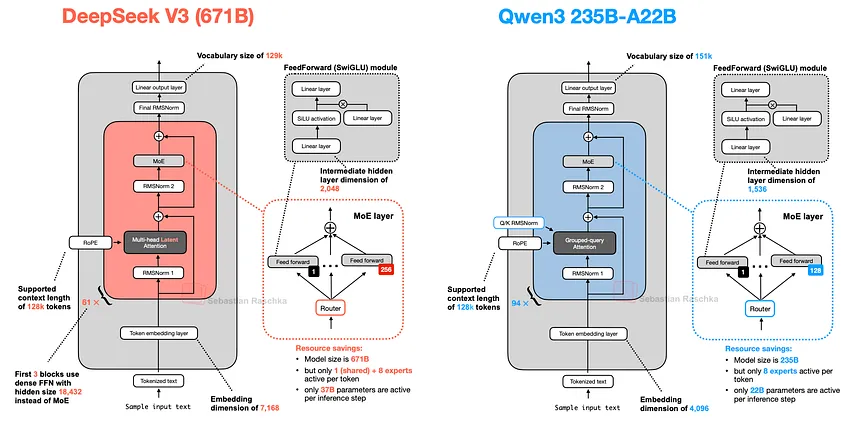

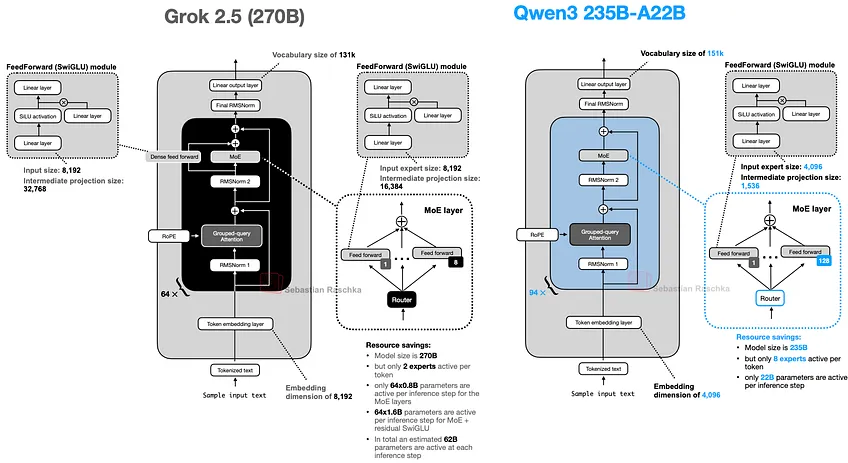

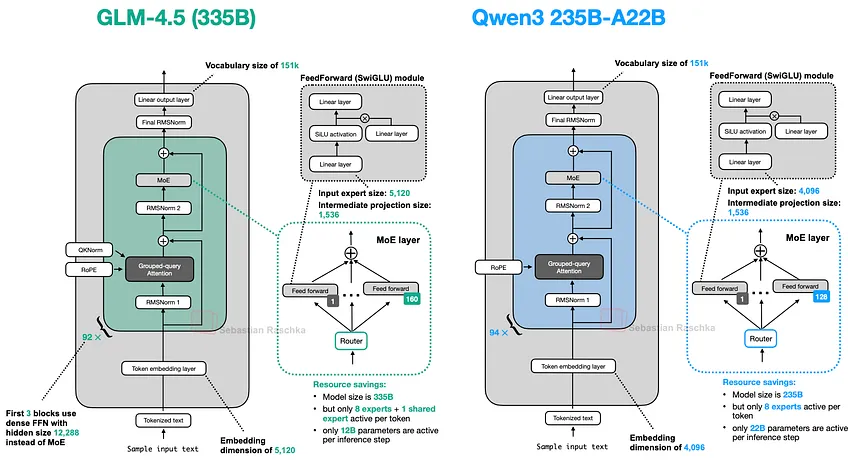

본 섹션을 마무리하며, Qwen3 235B-A22B(A22B는 '22B 활성 파라미터'를 의미)를 거의 두 배 많은 활성 파라미터(37B)를 가진 DeepSeek-V3와 비교해 본다.

[Figure 19: An architecture comparison between DeepSeek-V3 and Qwen3 235B-A22B.]

위 그림에서 볼 수 있듯이, DeepSeek-V3와 Qwen3 235B-A22B 아키텍처는 매우 유사하다. 그러나 주목할 만한 점은 Qwen3 모델이 공유 전문가(shared expert)를 사용하지 않는 방향으로 변경되었다는 것이다 (Qwen2.5-MoE와 같은 이전 Qwen 모델은 공유 전문가를 사용했다).

아쉽게도 Qwen3 팀은 공유 전문가를 사용하지 않게 된 이유를 공개하지 않았다. 추측건대, Qwen2.5-MoE의 전문가 2개에서 Qwen3의 8개로 늘리면서 해당 설정에서는 훈련 안정성을 위해 공유 전문가가 더 이상 필요하지 않았을 수 있다.

이를 통해 8+1개가 아닌 8개의 전문가만 사용함으로써 추가적인 연산/메모리 비용을 절감할 수 있었을 것이다. (다만, 이것이 DeepSeek-V3가 여전히 공유 전문가를 유지하는 이유를 설명해주지는 않는다.)

업데이트. Qwen3 개발자 중 한 명인 Junyang Lin은 다음과 같이 답변했다:

그 당시 Qwen 팀은 공유 전문가에서 충분히 유의미한 개선점을 찾지 못했으며, 공유 전문가로 인해 발생하는 추론 최적화에 대해 우려했다. 솔직히 이 질문에 대한 명확한 답은 없다.

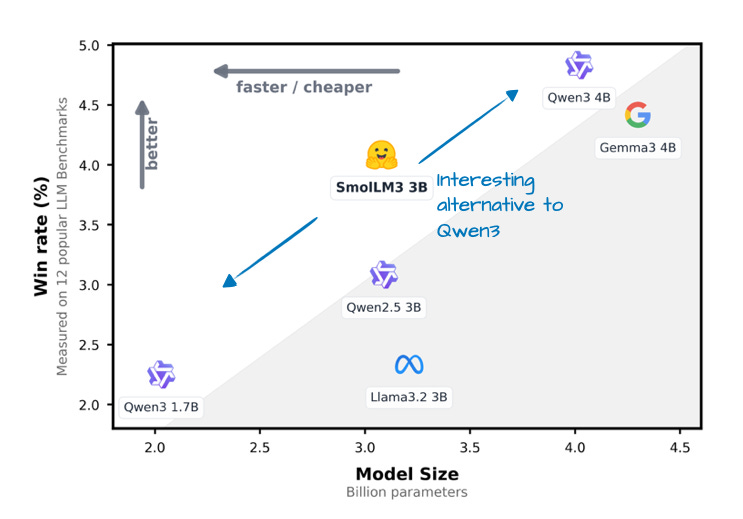

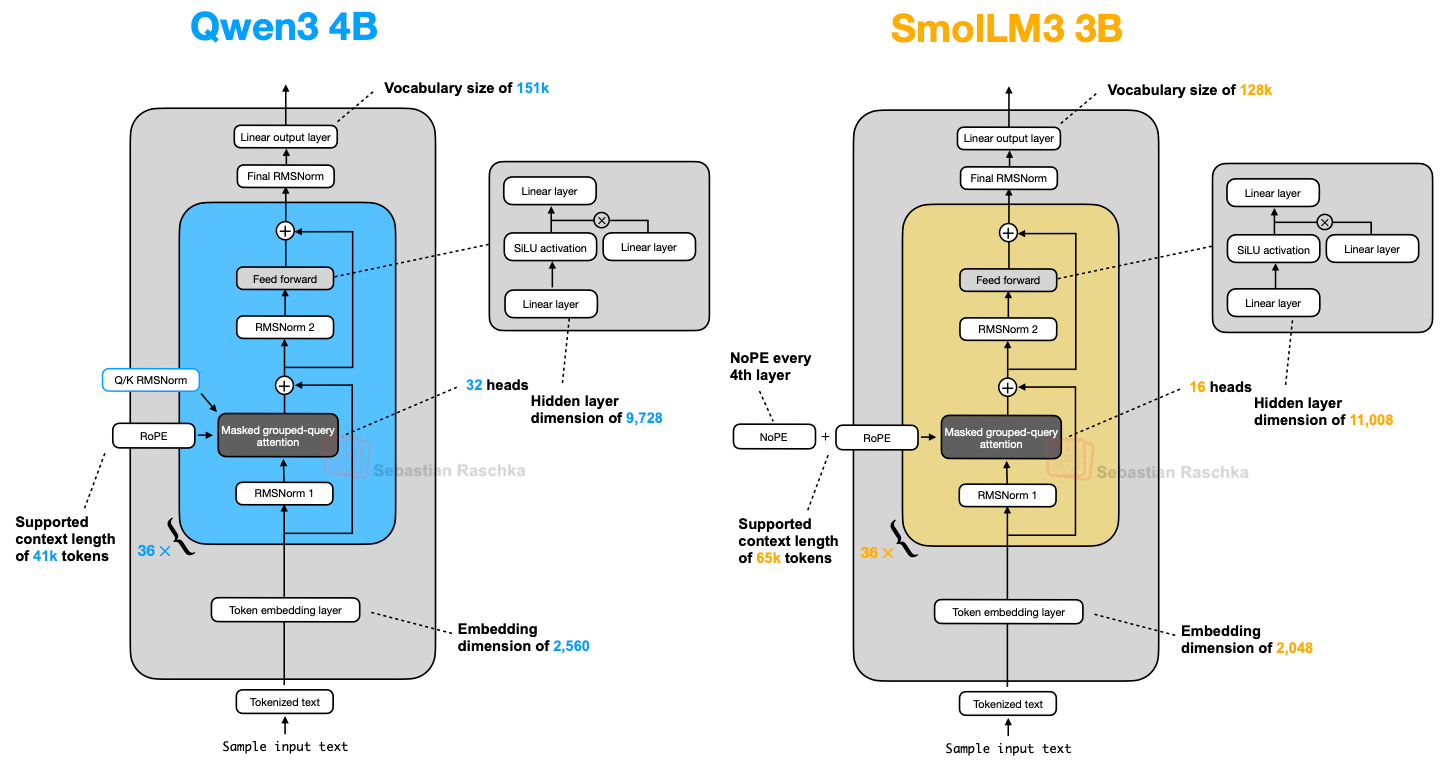

7. SmolLM3

SmolLM3는 본 아티클에서 다룬 다른 LLM만큼 널리 알려져 있지는 않지만, 아래 그림에서 볼 수 있듯이 1.7B와 4B Qwen3 모델 사이의 비교적 작고 사용하기 편리한 30억 파라미터 크기에서 매우 우수한 모델링 성능을 제공하므로 함께 포함할 만한 흥미로운 모델로 판단된다.

더욱이, OLMo와 유사하게 많은 훈련 세부 정보를 공유했다는 점 또한 주목할 만하며, 이는 업계에서 드문 사례로 긍정적으로 평가된다.

[Figure 20: An annotated figure from the SmolLM3 announcement post,comparing the SmolLM3 win rate to Qwen3 1.7B and 4B as well as Llama 3 3B and Gemma 3 4B.]

아래 아키텍처 비교 그림에서 볼 수 있듯이, SmolLM3 아키텍처는 상당히 표준적으로 보인다. 다만, 가장 흥미로운 측면은 NoPE (No Positional Embeddings)를 사용했다는 점이다.

[Figure 21: A side-by-side architecture comparison between Qwen3 4B and SmolLM3 3B.]

7.1 No Positional Embeddings (NoPE)

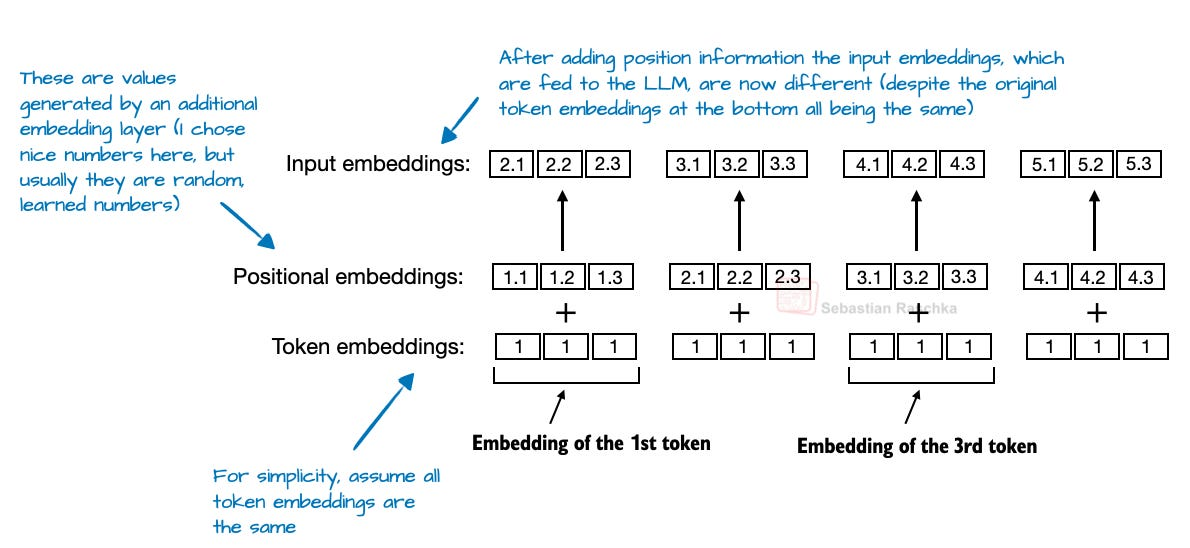

LLM 맥락에서 NoPE는 2023년 논문("The Impact of Positional Encoding on Length Generalization in Transformers")에 그 기원을 둔 비교적 오래된 아이디어로, 명시적인 위치 정보 주입(초기 GPT 아키텍처의 고전적인 절대 위치 임베딩 레이어나 오늘날의 RoPE와 같은)을 제거하는 것을 목표로 한다.

Transformer 기반 LLM에서 self-attention은 토큰의 순서와 관계없이 독립적으로 처리하기 때문에 일반적으로 위치 인코딩(positional encoding)이 필수적이다.

절대 위치 임베딩(Absolute position embedding)은 토큰 임베딩에 정보를 추가하는 별도의 임베딩 레이어를 더함으로써 이 문제를 해결한다.

Figure 22: A modified figure from Build A Large Language Model (From Scratch) book illustrating absolute positional embeddings.

반면, RoPE는 토큰 위치에 따라 쿼리 및 키 벡터를 회전시킴으로써 이 문제를 해결한다. 그러나 NoPE 레이어에서는 고정된 것이든, 학습된 것이든, 상대적인 것이든 어떤 종류의 위치 신호도 전혀 추가되지 않는다.

위치 임베딩이 없음에도 불구하고, 모델은 인과적 어텐션 마스크(causal attention mask) 덕분에 어떤 토큰이 먼저 오는지 여전히 알 수 있다.

이 마스크는 각 토큰이 미래의 토큰에 어텐션을 적용하는 것을 방지한다. 결과적으로, 위치 에 있는 토큰은 위치 에 있는 토큰들만 볼 수 있으므로, 자기회귀(autoregressive) 순서가 보존된다.

따라서 명시적으로 추가되는 위치 정보는 없지만, 모델 구조 자체에 암묵적인 방향성이 내재되어 있다. 그리고 LLM은 일반적인 경사 하강법 기반 훈련(gradient-descent-based training)에서 최적화 목표에 유익하다고 판단되면 이를 활용하는 법을 학습할 수 있다. (더 자세한 정보는 NoPE 논문의 정리를 참고할 수 있다.)

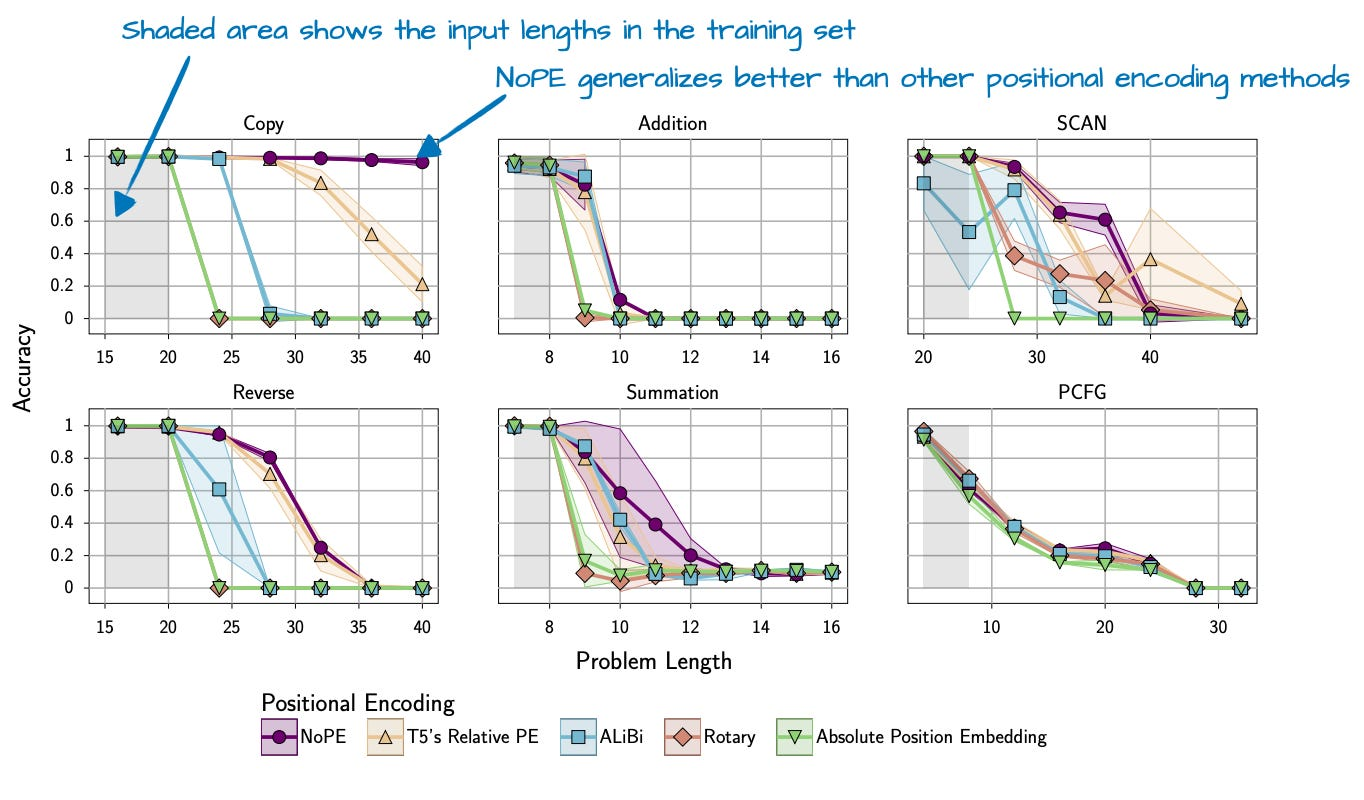

결론적으로 NoPE 논문은 위치 정보 주입이 필요하지 않다는 것을 발견했을 뿐만 아니라, NoPE가 더 나은 길이 일반화(length generalization) 성능을 보인다는 점도 발견했다.

이는 아래 그림에서 볼 수 있듯이, 시퀀스 길이가 증가함에 따라 LLM의 답변 성능 저하가 더 적다는 것을 의미한다.

위에서 보여준 실험은 약 1억 개의 파라미터를 가진 비교적 작은 GPT 스타일 모델과 작은 컨텍스트 크기로 수행되었다는 점에 유의해야 한다. 이러한 결과가 더 크고 현대적인 LLM에 얼마나 잘 일반화되는지는 불분명하다.

이러한 이유로, SmolLM3 팀은 4번째 레이어마다 NoPE를 적용(혹은 RoPE를 생략)한 것으로 보인다.

[Figure 23: An annotated figure from the NoPE paper showing better length generalization with NoPE.]

8. Kimi 2

Kimi 2는 최근 AI 커뮤니티에서 매우 우수한 성능을 가진 공개 가중치(open-weight) 모델로 큰 반향을 일으켰다. 벤치마크에 따르면, 이 모델은 구글의 Gemini, Anthropic의 Claude, OpenAI의 ChatGPT 모델과 같은 최고의 독점(proprietary) 모델들과 대등한 성능을 보인다.

주목할 만한 측면은 AdamW 대신 비교적 새로운 Muon 옵티마이저의 변형을 사용했다는 점이다. 알려진 바로는, 이 규모의 상용(production) 모델에 AdamW 대신 Muon이 사용된 것은 이번이 처음이다 (이전에는 16B 규모까지만 확장성이 입증되었다).

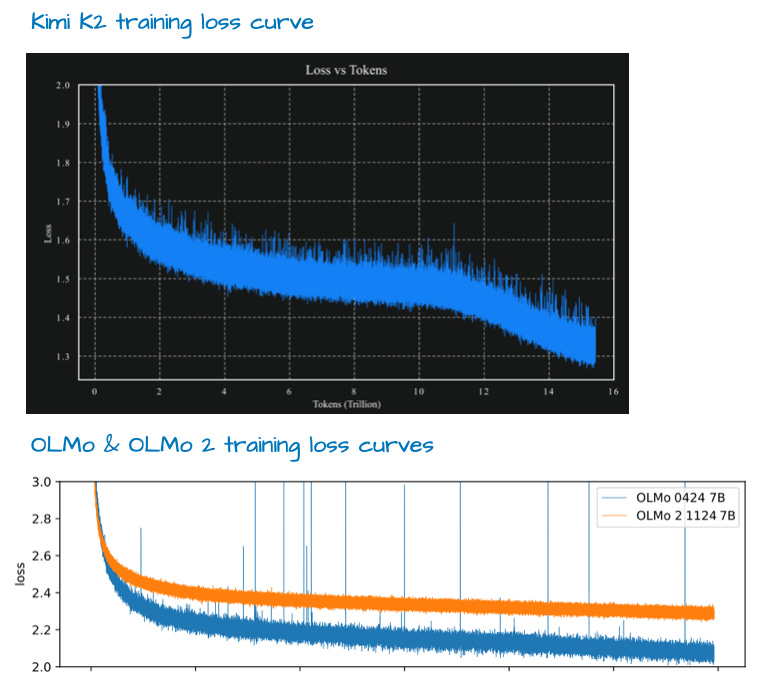

그 결과 매우 양호한 훈련 손실 곡선(training loss curve)을 보였으며, 이는 앞서 언급한 벤치마크에서 이 모델이 최상위권에 오르는 데 기여했을 가능성이 높다.

손실(loss) 곡선이 스파이크(spike)가 없어 이례적으로 매끄럽다는 평가가 있지만, OLMo 2의 손실 곡선(아래 그림 참조)과 비교하면 특별히 더 매끄럽다고 보기는 어렵다 (또한, 훈련 안정성을 추적하기에는 그래디언트의 L2 norm이 더 나은 지표일 수 있다).

그러나 손실 곡선이 감소하는 양상은 주목할 만하다. 그러나 본 아티클의 서두에서 언급했듯이, 훈련 방법론은 다른 기회에 다룰 주제이다.

모델 자체는 1조 개의 파라미터 규모로, 이는 매우 인상적인 수치이다.

이 글을 작성하는 시점에서, 이 모델은 현 세대 LLM 중 가장 큰 모델일 수 있다 (Llama 4 Behemoth가 아직 출시되지 않았고, 독점 LLM은 제외하며, 구글의 1.6조 파라미터 Switch Transformer는 다른 세대의 인코더-디코더 아키텍처라는 제약 조건을 고려할 때).

또한 Kimi 2는 본 아티클의 서두에서 다룬 DeepSeek-V3 아키텍처를 사용한다는 점에서 논의가 다시 원점으로 돌아온다. 다만, 아래 그림에서 볼 수 있듯이 그 규모를 더 크게 확장했다는 차이점이 있다.

[Figure 25: An architecture comparison between DeepSeek V3 and Kimi K2.

As shown in the figure above, Kimi 2.5 is basically the sam]

위 그림에서 볼 수 있듯이, Kimi 2.5는 MoE 모듈에서 더 많은 전문가(expert)를 사용하고 Multi-head Latent Attention (MLA) 모듈에서 더 적은 헤드(head)를 사용한다는 점을 제외하면 기본적으로 DeepSeek V3와 동일하다.

Kimi 2는 갑자기 등장한 것이 아니다. 'Kimi k1.5: Scaling Reinforcement Learning with LLMs' 논문에서 논의된 이전 Kimi 1.5 모델 또한 인상적인 성능을 보였다.

하지만 불운하게도 DeepSeek R1 모델 논문이 1월 22일 바로 같은 날에 발표되었다. 더욱이, 알려진 바로는 Kimi 1.5의 가중치는 공개된 적이 없다.

따라서 Kimi K2 팀은 이러한 경험을 교훈 삼아 DeepSeek R2가 출시되기 전에 Kimi K2를 공개 가중치 모델로 공유한 것으로 보인다. 이 글을 작성하는 시점에서 Kimi K2는 가장 인상적인 성능을 보이는 공개 가중치 모델이다.

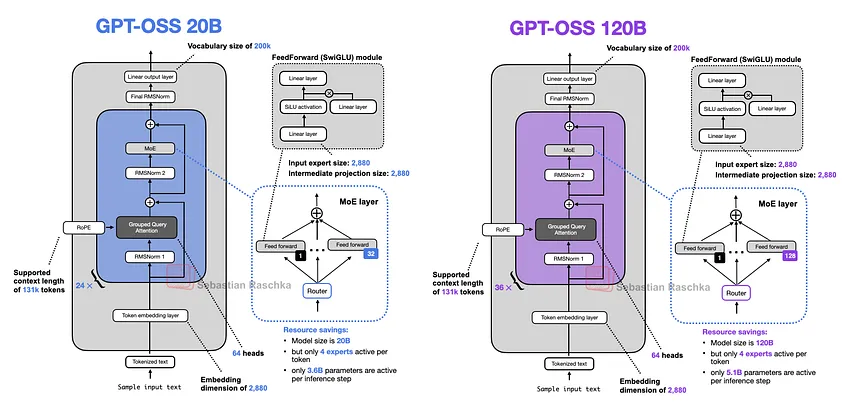

9. GPT-OSS

OpenAI는 2019년 GPT-2 이후 첫 공개 가중치(open-weight) 모델인 gpt-oss-120b와 gpt-oss-20b를 출시했다.

OpenAI의 공개 가중치 모델에 대한 기대가 매우 높았기 때문에, 본 아티클을 업데이트하여 해당 내용을 포함했다. 본 섹션은 간결하게 유지하되, gpt-oss 모델에 대해 훨씬 더 자세히 다룬 별도의 아티클은 여기에서 확인할 수 있다:

[Figure 26: Architecture overview of the two gpt-oss models.]

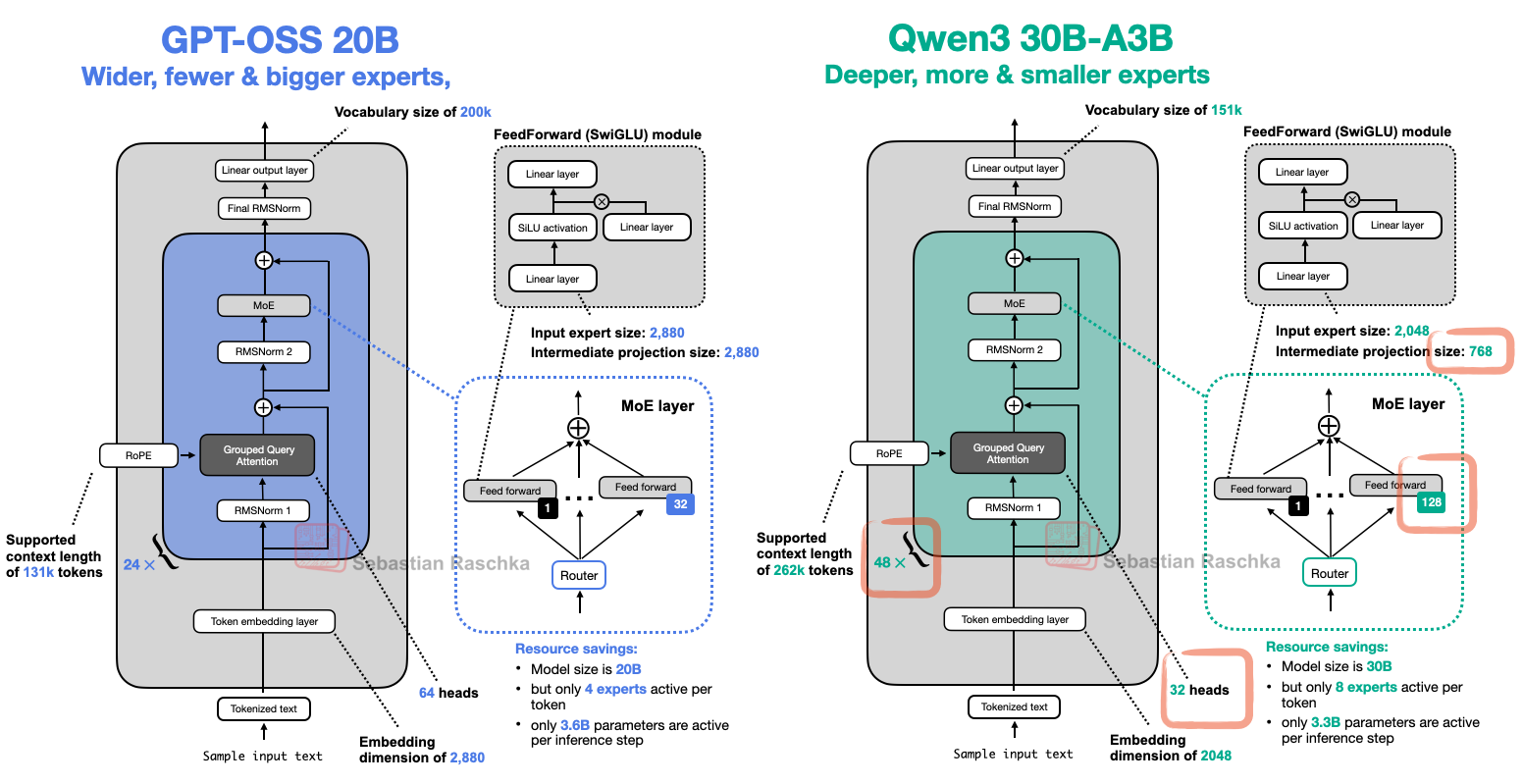

[그림 26]을 보면, 해당 아키텍처는 이전에 논의된 다른 아키텍처들에서 보았던 익숙한 구성 요소들을 모두 포함하고 있다. 예를 들어, [그림 27]은 더 작은 gpt-oss 아키텍처를 Qwen3 30B-A3B와 나란히 비교하는데, Qwen3 30B-A3B 역시 유사한 수의 활성 파라미터를 가진 MoE 모델이다 (gpt-oss는 3.6B, Qwen3 30B-A3B는 3.3B의 활성 파라미터를 가진다).

[Figure 27: Architecture comparison between gpt-oss and Qwen3]

[그림 27]에 나타나지 않은 한 가지 측면은 gpt-oss가 sliding window attention을 사용한다는 점이다 (Gemma 3와 유사하지만, 5:1 비율 대신 격층으로 사용한다).

9.1 Width vs Depth

[그림 27]은 gpt-oss와 Qwen3가 유사한 구성 요소를 사용함을 보여준다. 그러나 두 모델을 자세히 살펴보면, Qwen3가 24개가 아닌 48개의 transformer 블록을 사용하여 훨씬 더 깊은(deeper) 아키텍처임을 알 수 있다.

반면, gpt-oss는 훨씬 더 넓은(wider) 아키텍처이다:

- 임베딩 차원이 2048 대신 2880이다.

- 중간 전문가(feed forward) 프로젝션 차원 또한 768 대신 2880이다.

gpt-oss가 두 배 더 많은 어텐션 헤드를 사용한다는 점도 주목할 만하지만, 이것이 모델의 너비를 직접적으로 증가시키지는 않는다. 너비는 임베딩 차원에 의해 결정된다.

고정된 파라미터 수에서 한 접근 방식이 다른 방식보다 이점을 제공하는가? 일반적으로, 더 깊은 모델은 유연성이 더 높지만 그래디언트 폭주 및 소실(exploding and vanishing gradients)로 인한 불안정성 문제로 훈련이 더 어려울 수 있다 (RMSNorm과 shortcut connection은 이를 완화하는 것을 목표로 한다).

더 넓은 아키텍처는 더 높은 메모리 비용을 대가로 더 나은 병렬화가 가능하기 때문에 추론 시 더 빠르다는(더 높은 tokens/second 처리량) 장점이 있다.

모델링 성능에 관해서는, (파라미터 크기와 데이터셋이 일정하게 유지되는) 직접적인 비교 사례는 알려진 바가 드물다. 예외적으로 Gemma 2 논문(표 9)의 ablation study가 있는데, 9B 파라미터 아키텍처의 경우 더 넓은 설정이 더 깊은 설정보다 약간 더 낫다는 것을 발견했다. 4개의 벤치마크에 걸쳐, 더 넓은 모델은 평균 52.0점을, 더 깊은 모델은 평균 50.8점을 기록했다.

9.2 Few Large vs Many Small Expert

위 [그림 27]에서 볼 수 있듯이, gpt-oss가 예상외로 적은 수의 전문가(128개 대신 32개)를 가지며, 토큰당 8개 대신 4개의 활성 전문가만 사용한다는 점 또한 주목할 만하다. 그러나 각 전문가는 Qwen3의 전문가보다 훨씬 크다.

최근의 경향과 발전이 더 많고 더 작은 모델이 유리하다는 방향을 가리키고 있기 때문에 이는 흥미로운 지점이다. 고정된 총 파라미터 크기에서 이러한 변화는 아래 DeepSeekMoE 논문의 [그림 28]에 잘 나타나 있다.

[Figure 28: An annotated figure from "DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models"]

주목할 점은, DeepSeek의 모델과 달리 gpt-oss와 Qwen3는 모두 공유 전문가를 사용하지 않는다는 것이다.

9.3 Attention Bias와 Attention Sink

gpt-oss와 Qwen3는 모두 Grouped-Query Attention을 사용한다. 주요 차이점은 앞서 언급했듯이 gpt-oss가 격층으로 sliding window attention을 통해 컨텍스트 크기를 제한한다는 점이다.

그러나 한 가지 흥미로운 세부 사항이 있다. 아래 [그림 29]에서 볼 수 있듯이, gpt-oss는 어텐션 가중치(attention weight)에 편향(bias) 유닛을 사용하는 것으로 보인다.

[Figure 29: gpt-oss models use bias units in the attention layers. See code example here.]

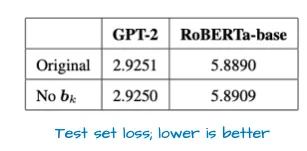

이러한 편향 유닛은 GPT-2 시절 이후로는 거의 사용되지 않았으며, 일반적으로 불필요한 것으로 간주된다. 실제로, 최근 한 논문은 이것이 적어도 키 변환(k_proj)에 대해서는 수학적으로 사실임을 보여준다.

더 나아가, 경험적 결과에 따르면 편향 유닛의 유무에 따른 차이는 거의 없는 것으로 나타났다 (아래 [그림 30] 참조).

[Figure 30: Table from ROLE OF BIAS TERMS IN DOT-PRODUCT ATTENTION showing the average test loss when the models were trained from scratch with and without bias units.]

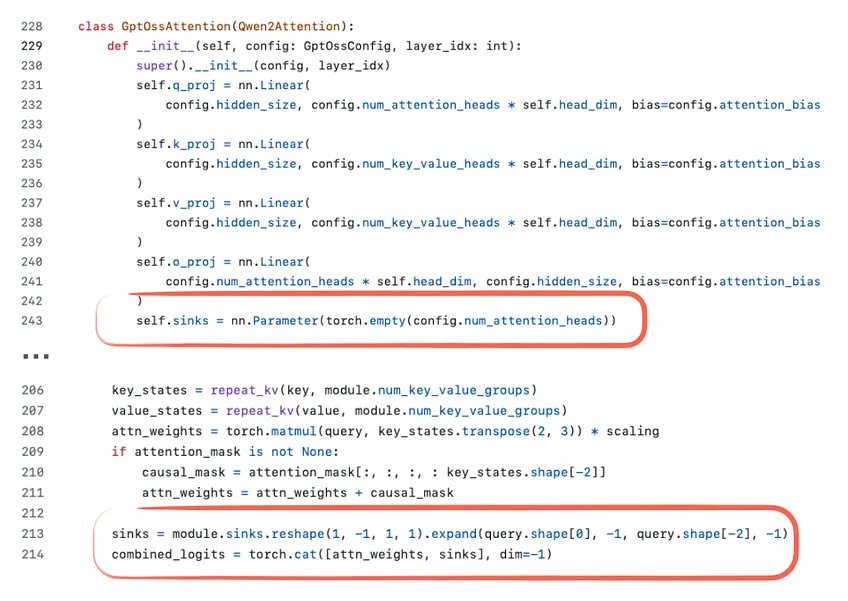

또 다른 세부 사항으로 [그림 30]의 코드 스크린샷에 정의된 sink가 있다. 일반적인 모델에서 attention sink는 어텐션을 안정화하기 위해 시퀀스 시작 부분에 배치되는 특별한 '항상 주목받는(always-attended)' 토큰으로, 특히 긴 컨텍스트(long-context) 시나리오에서 유용하다.

즉, 컨텍스트가 매우 길어지더라도 시작 부분의 이 특별한 토큰은 여전히 주목을 받으며, 전체 시퀀스에 대한 전반적으로 유용한 정보를 저장하도록 학습할 수 있다. (이 개념은 'Efficient Streaming Language Models with Attention Sinks' 논문에서 처음 제안된 것으로 보인다.)

gpt-oss 구현에서 attention sink는 입력 시퀀스의 실제 토큰이 아니다. 대신, 어텐션 점수(attention score)에 추가되는 학습 가능한 헤드별(per-head) 편향 로짓(bias logit)이다 ([그림 31]).

목표는 토큰화된 입력을 수정하지 않으면서 위에서 언급한 attention sink와 동일한 효과를 얻는 것이다.

[Figure 31: The use of attention sinks in gpt-oss; based on the Hugging Face code here.]

gpt-oss에 대한 더 자세한 정보 및 GPT-2와의 비교는 다른 gpt-oss 아티클에서 확인할 수 있다.

10. Grok 2.5

본 아티클이 처음 공개된 지 몇 주 후, xAI는 2,700억 파라미터의 Grok 2.5 모델 가중치를 공개했다.

Grok 2.5가 작년 xAI의 주력 상용(production) 모델이었다는 점에서 여기에 포함할 가치가 있다고 판단된다. 지금까지 논의된 모든 모델은 처음부터 공개 가중치 모델로 출시되었다.

예를 들어, gpt-oss는 GPT-4의 공개 가중치 복제본이라기보다는 오픈소스 커뮤니티를 위해 특별히 훈련된 맞춤형 모델일 가능성이 높다.

Grok 2.5를 통해, 비록 작년의 것이기는 하지만 실제 상용 시스템을 들여다볼 수 있는 드문 기회를 얻게 된다.

아키텍처 측면에서, Grok 2.5는 전반적으로 상당히 표준적으로 보이지만([그림 32]), 몇 가지 주목할 만한 세부 사항이 있다.

[Figure 32: Grok 2.5 next to a Qwen3 model of comparable size]

예를 들어, Grok 2.5는 소수의 대형 전문가(8개)를 사용하는데, 이는 과거의 경향을 반영한다. 앞서 논의했듯이, DeepSeekMoE 논문이나 Qwen3와 같은 최신 설계는 다수의 소형 전문가를 선호한다.

또 다른 흥미로운 선택은 사실상 공유 전문가에 해당하는 것을 사용했다는 점이다. [그림 32]의 왼쪽에 표시된 추가 SwiGLU 모듈은 항상 활성화되는(always-on) 공유 전문가 역할을 한다.

중간 차원이 두 배라는 점에서 고전적인 공유 전문가 설계와 동일하지는 않지만, 아이디어는 같다. (Qwen3가 공유 전문가를 생략했다는 점은 여전히 흥미로운 지점이며, 이러한 선택이 Qwen4 및 후속 모델에서 변경될지 여부는 앞으로 지켜볼 부분이다.)

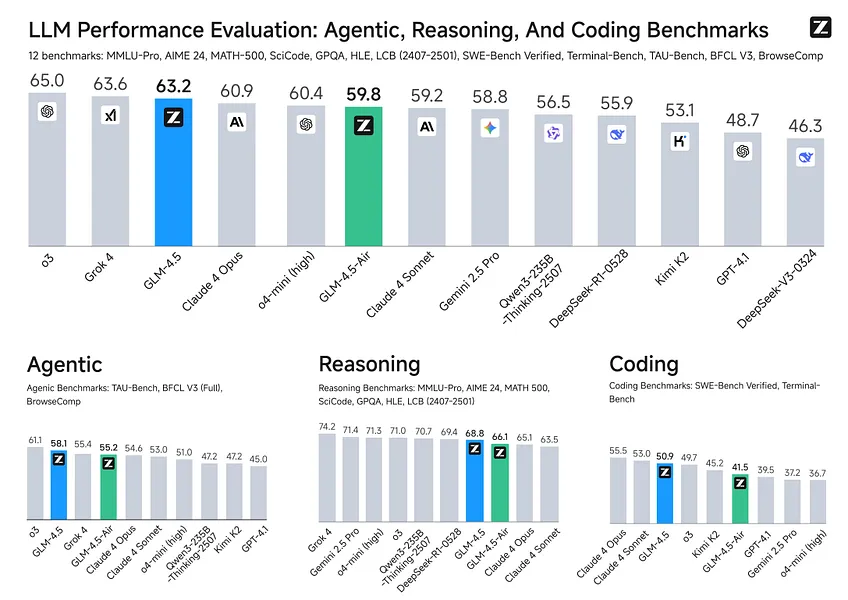

11. GLM-4.5

GLM-4.5는 올해의 또 다른 주요 출시 모델이다. 이는 Qwen3와 유사한 지시/추론 하이브리드 모델이지만, 함수 호출(function calling)과 에이전트 스타일의 맥락에 더욱 최적화되어 있다.

[Figure 33: GLM-4.5 benchmark from the official GitHub repository]

[그림 34]에서 볼 수 있듯이, GLM-4.5는 두 가지 버전으로 제공된다. 주력 모델인 3,550억 파라미터 모델은 12개 벤치마크 평균에서 Claude 4 Opus를 능가하며, OpenAI의 o3와 xAI의 Grok 4에 근소한 차이로 뒤처진다. 또한 3,550억 모델보다 성능이 약간 낮은 더 압축된 1,060억 파라미터 버전인 GLM-4.5-Air도 있다.

[Figure 34: GLM-4.5 next to a similarly-sized Qwen3 model.]

두 설계는 대체로 유사하지만, GLM-4.5는 DeepSeek V3에서 처음 도입된 구조적 선택을 채택했다. 즉, Mixture-of-Experts (MoE) 블록 앞에 3개의 밀집(dense) 레이어를 배치하는 것이다.

여러 개의 밀집 레이어로 시작하는 것은 대규모 MoE 시스템에서 수렴 안정성과 전반적인 성능을 향상시킨다. MoE 라우팅이 즉시 도입되면, 희소 전문가 선택의 불안정성이 초기 구문 및 의미 특징 추출을 방해할 수 있다.

따라서 초기 레이어를 밀집 형태로 유지함으로써, 라우팅 결정이 더 높은 수준의 처리를 형성하기 전에 모델이 안정적인 저수준 표현(low-level representation)을 형성하도록 보장한다고 할 수 있다.

또한, GLM-4.5는 DeepSeek-V3와 유사하게(그리고 Qwen3와는 다르게) 공유 전문가를 사용한다.

(흥미롭게도, GLM-4.5는 GPT-2와 gpt-oss에서 사용된 attention bias 메커니즘 또한 유지하고 있다.)

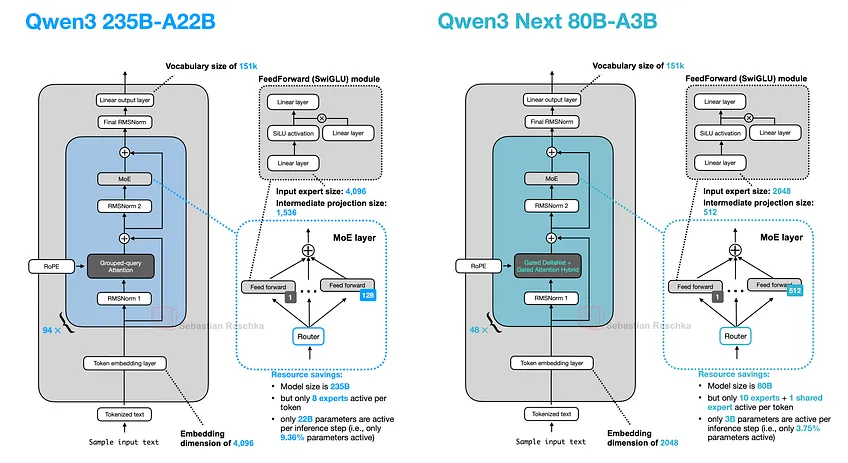

12. Qwen3-Next

2025년 9월 11일, Qwen3 팀은 Instruct와 Thinking 두 가지 변형으로 제공되는 Qwen3 Next 80B-A3B를 출시했다 ([그림 35]). 이 모델의 설계는 이전에 논의된 Qwen3 아키텍처를 기반으로 하지만, 그림 번호의 일관성을 유지하고 일부 설계 변경 사항에 주목하기 위해 여기서는 별도의 항목으로 다룬다.

12.1 Expert Size and Number

[Figure 35: The original Qwen3 model released in May (left) next to the Qwen3 Next model released in September (right).]

새로운 Qwen3 Next 아키텍처는 이전 235B-A22B 모델([그림 35])보다 3배 작음에도 불구하고, 4배 더 많은 전문가를 도입하고 공유 전문가까지 추가했다는 점에서 두드러진다.

다수의 전문가를 사용하는 것과 공유 전문가를 포함하는 이 두 가지 설계 선택은 이 모델이 출시되기 전부터 향후 발전 방향으로 주목받아 온 바 있다.

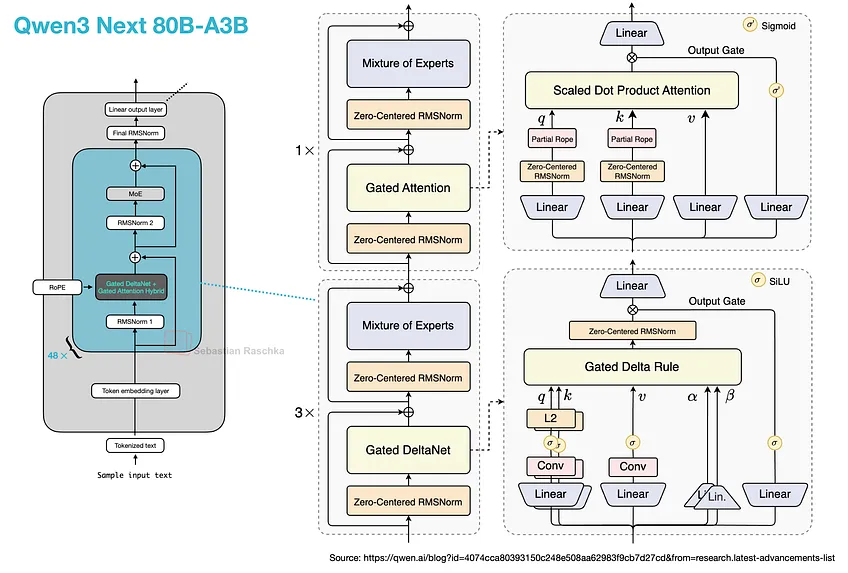

12.2 Gated DeltaNet + Gated Attention Hybrid

또 다른 주목할 만한 점은 일반적인 어텐션 메커니즘을 Gated DeltaNet + Gated Attention hybrid로 대체하여, 메모리 사용량 측면에서 262k 토큰의 네이티브 컨텍스트 길이를 가능하게 했다는 것이다 (이전 235B-A22B 모델은 네이티브 32k를 지원했으며, YaRN 스케일링을 통해 131k를 지원했다).

이 새로운 어텐션 하이브리드의 작동 방식은 다음과 같다. Grouped-Query Attention (GQA)은 표준적인 scaled dot-product attention으로서, (앞서 논의했듯이 쿼리 헤드 그룹 간 K/V를 공유하여 KV-cache 크기와 메모리 대역폭을 줄이지만) 디코딩 비용과 캐시는 여전히 시퀀스 길이에 따라 증가하는 한계가 있다.

이와 비교하여, Qwen3-Next의 하이브리드 메커니즘은 [그림 36]에서 볼 수 있듯이 Gated DeltaNet 블록과 Gated Attention 블록을 3:1 비율로 혼합한다.

[Figure 36: The Gated DeltaNet + Gated Attention hybrid mechanism. Note that these are arranges in a 3:1 ratio, meaning that 3 transformer blocks with Gated DeltaNet are followed by 1 transformer block with Gated Attention. The right subfigure is from the official Qwen3 blog]

Gated attention 블록은 GQA에서 사용될 수 있는 표준적인 scaled-dot-product attention으로 간주할 수 있지만, 몇 가지 수정 사항이 추가되어 있다. Gated attention과 일반 GQA 블록의 주요 차이점은 다음과 같다:

- 잔차(residual)에 더해지기 전에 어텐션 결과의 크기를 조정하는 출력 게이트(일반적으로 채널별로 sigmoid로 제어됨)

- 표준 RMSNorm 대신 QKNorm에 사용되는 zero-centered RMSNorm

- 부분적인 RoPE(차원의 서브셋에 적용)

이러한 변경 사항들은 본질적으로 GQA의 안정성을 높이기 위한 것임에 유의해야 한다.

Gated DeltaNet은 더 중요한 변경 사항이다. DeltaNet 블록에서는 와 두 개의 게이트()가 정규화가 포함된 선형 및 경량 컨볼루션 레이어(lightweight convolutional layer)에 의해 생성되며, 이 레이어는 어텐션을 fast‑weight delta rule 업데이트로 대체한다.

그러나 절충점(tradeoff)은 DeltaNet이 전체 어텐션보다 덜 정밀한 내용 기반 검색(content-based retrieval)을 제공한다는 것이며, 이것이 하나의 gated attention 레이어가 남아있는 이유이다.

어텐션이 이차적으로(quadratically) 증가한다는 점을 고려할 때, DeltaNet 구성 요소는 메모리 효율성을 돕기 위해 추가되었다. "선형 시간, 캐시 프리(linear-time, cache-free)" 계열에서 DeltaNet 블록은 본질적으로 Mamba의 대안이다.

Mamba는 학습된 상태 공간 필터(state-space filter, 본질적으로 시간에 따른 동적 컨볼루션)를 사용하여 상태를 유지한다. 반면 DeltaNet은 와 로 업데이트되는 작은 fast-weight 메모리를 유지하고 이를 q로 읽어들이며, 작은 컨볼루션은 를 형성하는 데에만 사용된다.

12.3 Multi-Token Prediction

위의 두 하위 섹션에서는 효율성을 목표로 한 두 가지 설계 결정을 설명했다. 이에 더해, Qwen3는 또 다른 기법인 Multi-Token Prediction (MTP)을 추가했다.

Multi-token prediction은 각 단계에서 LLM이 단일 토큰 대신 여러 개의 미래 토큰을 예측하도록 훈련시킨다. 여기서 각 위치 에서 작은 추가 헤드(선형 레이어)가 에 대한 로짓(logit)을 출력하며, 이 오프셋들에 대한 cross-entropy 손실을 합산한다 (MTP 논문에서는 를 권장했다).

이 추가적인 신호는 훈련 속도를 높이며, 추론은 한 번에 하나의 토큰만 처리하는 방식으로 유지될 수 있다. 그러나 추가 헤드는 추측적 다중 토큰 디코딩(speculative multi-token decoding)에 사용될 수 있으며, Qwen3-Next가 이 방식을 사용하는 것으로 보이나, 세부 사항은 아직 부족하다:

Qwen3-Next는 네이티브 Multi-Token Prediction (MTP) 메커니즘을 도입하여, Speculative Decoding에서 높은 수용률(acceptance rate)을 보이는 MTP 모듈을 생성할 뿐만 아니라 전반적인 성능도 향상시킨다.

또한, Qwen3-Next는 MTP의 다중 단계 추론 성능을 특별히 최적화하고, 훈련과 추론 간의 일관성을 유지하는 다중 단계 훈련을 통해 실제 시나리오에서 Speculative Decoding의 수용률을 더욱 향상시킨다. (출처: Qwen3-Next 블로그)

수년이 지난 지금도 LLM 출시는 여전히 많은 기대를 모으고 있으며, 앞으로 어떤 발전이 있을지 귀추가 주목된다.