계산 그래프를 신경망에 적용하기

Relu 계층

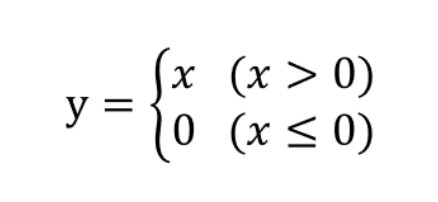

Relu 함수 수식

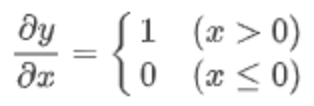

Relu 함수 미분

x가 0보다 크면 역전파는 상류의 값을 그대로 하류로 흘림

x가 0 이하면 역전파는 하류로 신호를 보내지 않음 (0을 보냄)

Relu 계층의 계산 그래프

Sigmoid 계층

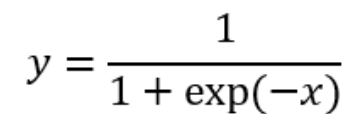

시그모이드 함수

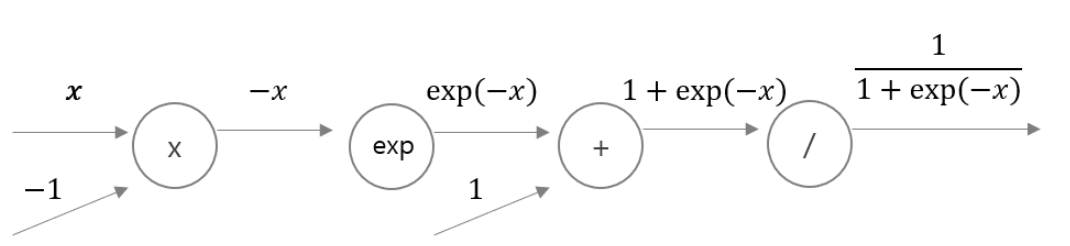

시그모이드 계층의 계산 그래프(순전파)

- exp 노드는 y=exp(x) 계산을 수행하고 /(나누기) 노드는 y=1/x 계산을 수행

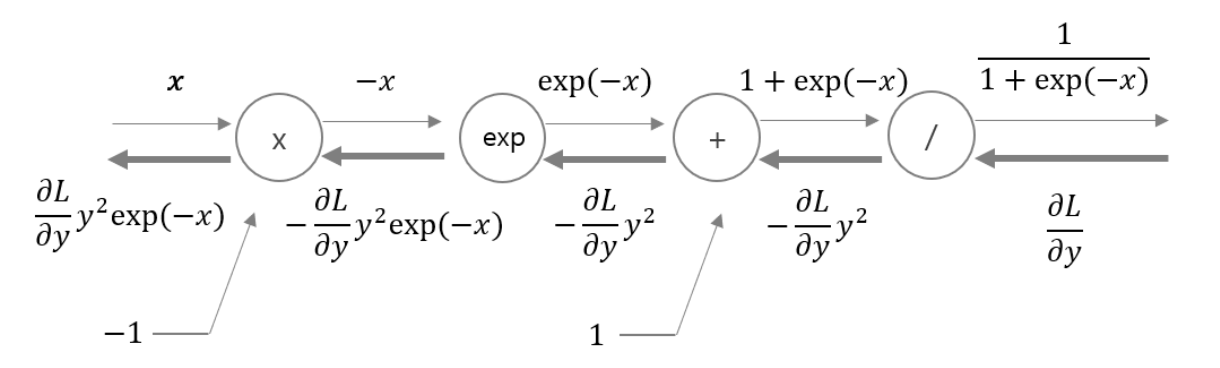

시그모이드 층의 계산 그래프(역전파)

-

1단계 : / 노드를 미분하면 아래와 같은 식이 됨

-

2단계 : + 노드는 값을 하류로 그대로 보냄

-

3단계 : exp노드는 y=exp(x)의 연산을 수행하며 미분은 아래와 같음

-

4단계 : X(곱하기) 노드는 값을 바꿔 곱함

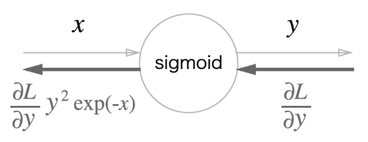

위 과정을 아래와 같이 간소화 할 수 있음

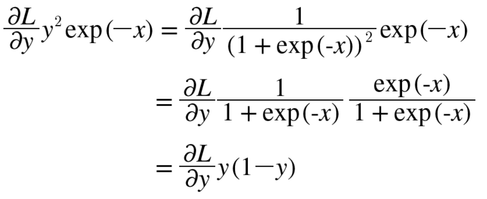

위 식은 아래와 같이 정리할 수 있다