본 포스팅은 K-MOOC의 공승현 교수의 강좌 <자율주행 인공지능 시스템>을 수강하고 작성되었습니다. 강좌 바로가기(K-MOOC)

자율주행 시스템의 구성요소

1. 자율주행 시스템의 분류

- Standalone Autonomous Vehicle(AV): 개개의 자동차가 모든 자율 주행 기술을 가지고 주변과의 교류 없이 스스로 모든 걸 판단하고 주행하는 기술

- Connected AV

- 자율 주행 자동차가 통신의 기능을 가지고, V2X(Vehicle-to-Everything)를 이용해 주변의 자동차 또는 인프라와 정보를 교류해서 자율 주행을 하는 것

- 센싱 영역에 다른 장애물이 위치할 경우, 알아야 하는 정보를 얻지 못하거나 판단이 불가능할 수 있음. 이 경우 도로 인프라로부터 정보를 획득할 수 있음

- 전방의 먼 곳의 교통 상황에 대해서 미리 정보를 받을 수 있음

2. 자율주행 시스템을 구현하는 인공지능 방식

- Modular AI Architecture

- Perception, localization, Path planning, Control, HMI 등 전 과정의 모든 기능을 개개의 AI 모듈(심층 신경망)로 구현한 뒤, 이를 인간의 사고 논리 구조로 연결한 자율주행시스템

- 현재 상용화된 자율주행자동차 시스템이 이 방식임

- 장점

- 논리적 체계를 바탕으로 한 구조이므로, 개별 기능을 부분적으로 구현하거나 추가, 개선하기 편리함

- 성능의 오류 확인 및 검증이 편리함

- 실제 환경에서 검증된 구현 방식임

- 단점

- 인간이 가진 논리구조를 벗어나지 못하며, 인간의 운전 능력을 뛰어넘을 수 없음

- 센서의 오차가 제어까지 전달되는 취약한 구조임(모듈 하나의 오류가 전체 과정에 영향을 미침)

- 시스템 복잡도가 높음

- End-to-End AI Architecture

- 인지, 계획, 제어까지 전 과정을 단일 AI 모듈(심층 신경망)에서 수행하는 시스템 -> Level5로 기술 향상하는 데 주목하는 방식

- 장점

- 인간이 생각하지 못한 접근법을 구현할 수도 있어, 현 자율주행 시스템의 문제들을 해결할 가능성이 있는 시스템임 데이터 수집이 충분할 시, 기존 Modular 방식보다 더 좋은 성능을 기대할 수 있음

- 센서의 오차에 다양한 대안을 찾아 대응할 수 있음

- 다양한 교통 상황에 대해 적절히 대응할 수 있음

- 단일 신경망이므로 계산량과 복잡도가 낮음

- 운전의 다양성(ex. 운전자의 운전 습관)을 구현할 수 있음

- 단점

- Low Interpretability: 주행 방식을 설명하기가 어려움

- Low Controllability: 주행 기능을 제어하기가 어려움

- 아직 연구중임

- 주어진 상황에서 운전 능력을 예측하기 어려움

3. 탑재 센서의 개요

- Exteroceptive Sensors: 외향 센서

- Proprioceptive Sensors: 내향 센서

4. Exteroceptive Sensor

- Camera

- RGB의 3가지 색으로 보이는 장면을 인지해 출력

- Analog-to-Digital-Converter(ADC)를 이용해 각 이미지의 픽셀 값을 RGB 각각 256개의 레벨(=1byte)로 표현함

- 이전까진 CCD 센서(?)를 이용한 카메라를 주로 사용 -> 최근 CMOS 이미지 센서로 카메라를 구현하고 있음. 특히 자동차에서

- CMOS 이미지 센서: CCD 센서에 비해 높은 집적도, 낮은 전력 소모, 잡음에 대한 강인함, 높은 데이터 출력 속도 등의 장점을 가짐

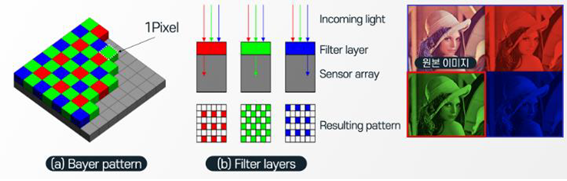

- 인간은 초록색을 더 잘 구분하고 정보를 잘 받아들임. 따라서 카메라 센서도 초록색을 받아들이는 센서가 빨간색과 파란색보다 2배 많음

- 이미지 센서는 화소수 만큼 배열된 monochrome 셀 위에 RGB 중 하나의 색상 필터들이 배치된 것. 하나의 mono 셀에 하나의 종류의 필터만이 결합

- Bayer Pattern: 초록색 센서가 절반, 빨강과 파랑색 센서가 각각 25%씩 차지하도록 교차되어 배치되는 패턴

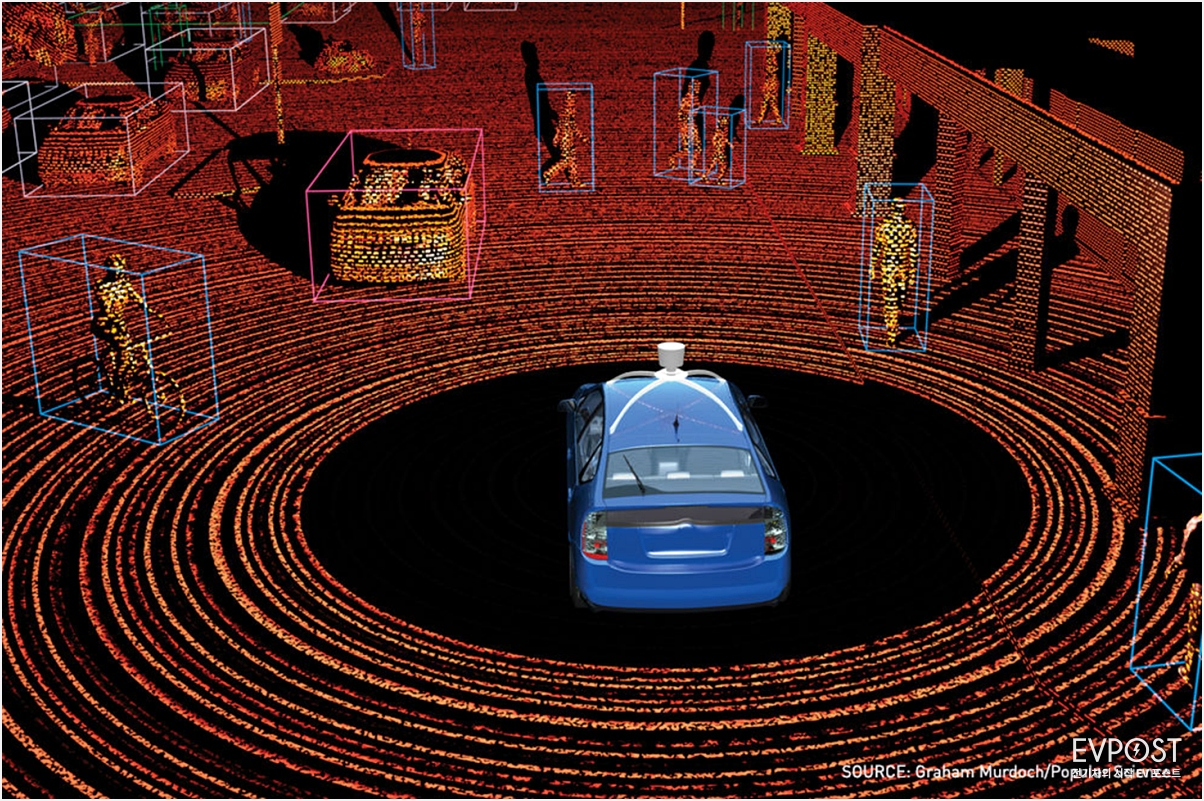

- LiDAR(Light Detection and Ranging, 라이다)

- 1, 8, 16, 32, 64, 128 등의 다수 개의 레이저 채널을 가지고 있어, 각 레이저 채널이 하나의 포인트를 측정함

- 레이저 채널들은 수평선을 기준으로 -25° ~ 15° 범위의 수직 방향 FOV(Field of View) 갖는 적외선 레이저를 조사함

- 조사한 레이저 신호가 반사되어 돌아오는 시간(Time of Flight)을 이용해 거리를 계산함

- 전체 채널이 수평 방향으로 초당 6~20회 회전하며 1°~0.4°를 회전할 때마다 측정치를 계산함

- 따라서 한 개의 채널에서 회전 당 최대 3600개의 point 측정치를 30byte/point의 크기로 출력하며, 전체적으로는 초당 약 100Mbyte의 point cloud data를 생성함

- 마치 구름처럼 보인다 하여 point cloud 라 부름

- 한 채널 내에서 측정하는 과정

- 라이다 채널에서 전기 신호를 내보내 레이저 다이오드가 발광해 적외선 레이저 조사됨

- 레이저 신호가 전방의 물체에 부딪혀 돌아오면, 수신 다이오드가 이를 받아 전기 신호를 발생시킴

- 전기 신호를 걸어주고 다시 발생되는 시간 간격(ΔT, time interval measurement)를 이용해 물체까지의 거리(ΔR)를 계산함: ΔR = C x ΔT / 2 (C: 빛의 속도)

- Digital Signal Processing Unit에서 정밀한 계산을 수행해 보정

-

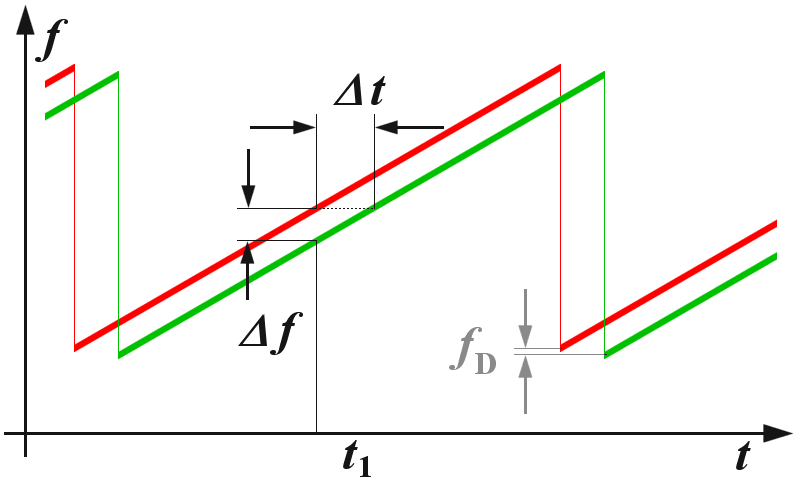

Radar (Radio Detection and Ranging)

- 다양한 방식의 신호 중 Chirp 신호를 발신하여 물체에 반사되어 돌아오는 신호의 수신 시간 및 방향을 측정함

- 자동차의 경우 소형화가 이루어져 76~81GHz까지 광대역 주파수를 사용 가능

- 측정 정밀도 개선 방법

- Chirp 신호의 대역폭: 수신 시각 정밀도 개선, 신호 대역폭(bandwidth, fmin~fmax의 크기)이 높아져 거리 측정 정확도 향상

- Antenna Array: 수신 각도(송신한 신호가 대상 물체에 반사되었다가 들어오는 수신 각도) 측정 정밀도 개선

- Chirp 신호: 시간에 따라 주파수가 높아졌다 낮아졌다 다시 높아지길 반복하며 진행하는 방식의 신호

- FMCW(Frequency-Modulated Continuous Wave) 변조(Modulation) 방식 사용

-

Sensor의 한계와 외향 센서의 다중 사용(Redundancy)

- Sensor의 한계: 이를 극복하기 위해 다중 사용

- 측정 거리와 정밀도, 정확도, 신뢰도

- 잡음으로 인한 성능 하락

- 장애물로 인한 음영 지역 발생

- 날씨, 환경, 조도의 변화에 따른 성능 하락

- 신호 간섭: 전자기파를 이용하는 레이더의 경우 같은 주파수의 다른 전자기파로 인해 레이더 신호와 교란 & 간섭

- 사이버 공격 노출: 사용자가 사용하는 센서와 똑같은 신호를 악의를 가지고 방사하면, 수신된 신호를 그대로 받아들이고 측정하여 진위여부 구별하기 힘듦

- 한 종류의 센서를 여러 개를 사용하기도 함. 카메라의 FOV 제한을 극복하기 위해 다양한 방향으로 카메라를 장착하는 등

- Sensor Fusion: 측정 결과를 각각을 이용하기보단 결과치를 혼합해 정확한 정보를 추출함

- Sensor의 한계: 이를 극복하기 위해 다중 사용

-

GPS (Global Positioning System)

- 30여 개의 중궤도를 돌고 있는 전 지구적 위성망에서 같은 시간대에 모든 위성이 지상으로 방사하는 신호를 수신기로 수신하고, 각 순간의 위성의 위치 계산하여, 이 신호들을 삼각 측량해 수신기의 위치를 파악함

- 각 위성의 위치에서부터의 거리를 이용해 4차원 위치의 X, Y, Z, 시간으로부터 4D Variable을 풀어 위치와 시간을 계산함

- 수신기에 따라 다양한 측위 방법이 존재함

- 정확도의 저하가 발생함

- 도심환경에서는 전파장애가 있어 세기가 감쇄되기도 하고, 난반사로 인한 다중 경로 신호로 인해 1m ~ 1km의 정확도 저하가 발생함

- 특히 터널과 고가도로 밑, 고층 건물 주변에서 측위 오차가 불규칙하게 증가함

- GNSS

- 유럽의 Galieo(갈릴레오), 중국의 Beidou(베이두), 러시아의 Glonass(글로나스), 일본의 QZSS, 인도의 IRNSS 등 GPS를 포함한 120여개의 GNSS 위성망이 가용되고 있음

- 신호를 방사하는 중궤도 위성은 지상으로부터 약 20,000km 떨어져 있어 신호의 세기가 약해짐 -> 건물 혹은 유리를 만났을 때 반사파가 발생하거나, 건물에 가려지면 투과가 불가해 건너편에선 신호를 잡을 수 없음 -> 도심에서의 오차 큼

5. Proprioceptive Sensors

-

IMU(Inertial Measurement Unite, 관성 항법 장치)

- IMU에 작용하는 3축 회전 각속도를 측정하는 2개의 Gyro와 3축 가속도를 측정하는 3개의 Accelerometer로 구성됨

- 여섯 가지 측정치를 누적(적분)해 3차원 공간에서의 위치, 속도, 자세각(Roll, Pitch, Yaw)를 계산함 (관성(힘)을 계산하려 가속도를 측정함 -> 이를 누적하면 속도가 됨 -> 다시 누적하면 거리가 됨)

- 자동차가 움직일 때 이에 저항하는 관성이 생기므로, 이를 측정 -> 자동차의 움직임과 방향 측정 가능

- 누적의 단계에서 측정치에 노이즈가 쌓임. 누적된 잡음으로 인해 IMU의 측정 정확도가 저하됨 -> 보통 GPS를 이용해 오차를 교정하곤 함

- GPS를 이용한 보정에는 칼만 필터(Kalman Filter)를 이용한 센서 퓨전 기술 중 하나를 곧잘 사용함

-

그 외 내향 센서

- Wheel Encoder: Passive Sensor로, 바퀴의 회전수를 측정해 진행 거리를 계산함

- Tachometer(타코미터): Passive Sensor로, 자동차의 속도를 측정함. 계기판에서 볼 수 있음

- Steering Angle Sensor: 운전대의 회전 각도를 측정

6. 센서 사용 시의 고려 사항

- 센서의 데이터 size가 과하게 크다면 컴퓨팅 능력에 제한이 걸림

- 데이터 측정의 속도가 센서마다 차이가 있음

- 라이다: 레이저 신호를 사용하기에 바로 탐지 가능

- 카메라: fps가 달라짐

- IMU 등 관성 센서: 반복 누적과 이 결과에 대한 시간이 필요함

- 데이터 처리의 계산량

- 센서의 부피가 커 장착이 힘들거나 장착 비용이 발생하기도 함(예: 외부에 장착해야 하는 라이다와 GPS)