활성화 함수란?

: 입력신호의 총합을 출력 신호로 변환하는 함수

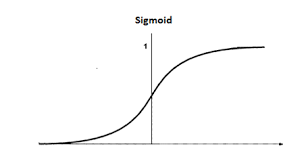

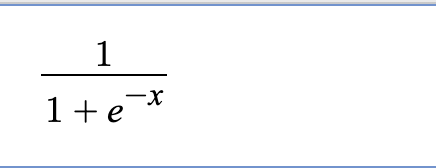

Sigmoid

특징

- 입력값이 커질 수록 1에 수렴, 작아질 수록 0에 수렴

- 시그모이드 함수를 미분하면 양쪽으로 향할 수록 변화값이 거의 없음

- 오류역전파를 할 때 Vanishing Gradient 현상 발생 할 수 있음

- 0 또는 1을 반환하기 때문에 이진 분류 모델의 마지막 활성화 함수(출력층)로 사용됨

이진 분류(Binary Classification)는 입력값에 따라 모델이 분류한 카테고리가 두 가지인 분류 알고리즘입니다.

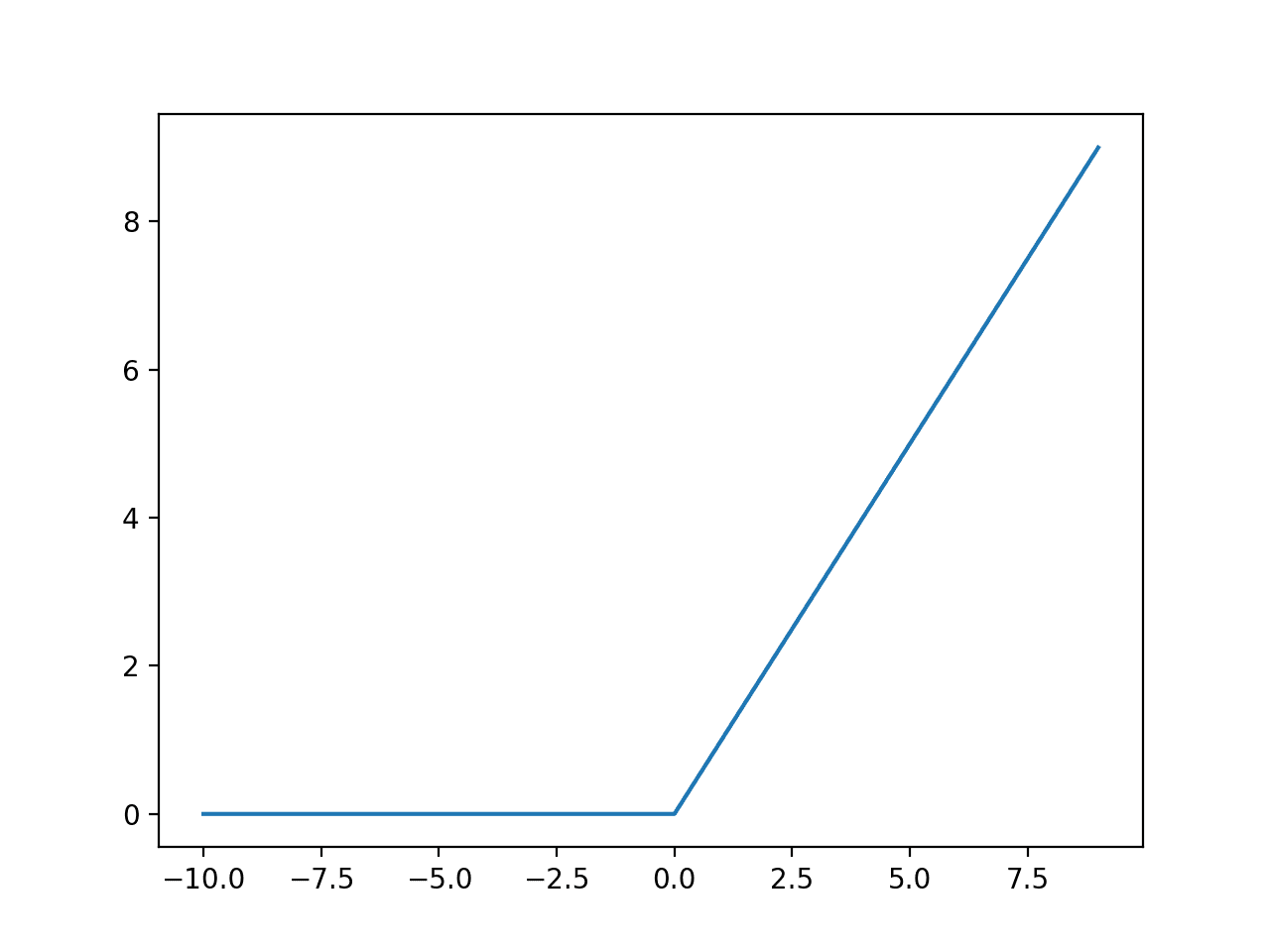

Relu

: 은닉층 활성화 함수, 입력값이 0보다 작거나 같을 때는 항상 0을 출력하고 0보다 크면 입력값과 동일한 출력값을 출력함

입력값이 0보다 작으면 기울기(gradient)는 0이고, 입력값이 0보다 크면 기울기(gradient)는 1입니다.

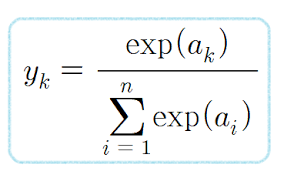

SoftMax

: sigmoid함수와 비슷하게 0~1 사이로 변환하여 출력하지만 출력값들의 합이 1이 되도록 하는 함수. -> 다중 분류의 최종 활성화 함수로 사용

다중 레이블 분류(multi-label classification) : 하나의 입력값이 여러 개의 클래스에 대응되는 경우

- 소프트맥스 함수는 시그모이드 함수를 일반화 (generalization) 하여 얻을 수 있습니다.