[ 실습 01 : File 생성, 주입 ]

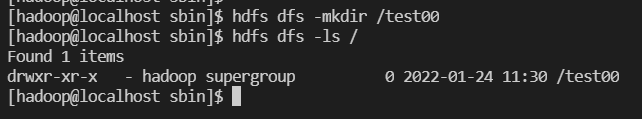

디렉토리 생성 /test00

- touchz

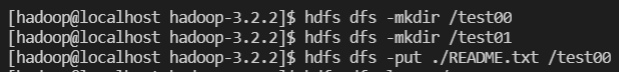

- put README.txt- 디렉토리 생성 /test00

- touchz (0 bite 파일 생성)

hdfs dfs -touchz /test01/test11.txt

- put README.txt

hdfs dfs -put ./README.txt

[hadoop@localhost hadoop-3.2.2]$ hdfs dfs -mkdir /test00

[hadoop@localhost hadoop-3.2.2]$ hdfs dfs -mkdir /test01

[hadoop@localhost hadoop-3.2.2]$ hdfs dfs -put ./README.txt /test00

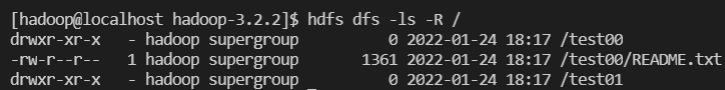

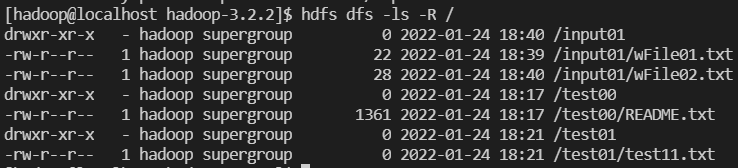

[hadoop@localhost hadoop-3.2.2]$ hdfs dfs -ls -R / [ 실습 02 : java wordcount 1 ]

- 목적 : 하둡 맵리듀스의 이해

#. hadoop jar hadoop-mapreduce-examples-3.2.2.jar wordcount /대상폴더 /출력폴더

hdfs /input01

/wFile01.txt : [Hello World Bye World]

/wFile02.txt : [Hello Hadoop Goodbye Hadoop]

hadoop fs -put ./wFile01.txt /input01

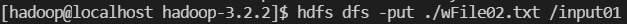

hadoop fs -put ./wFile02.txt /input01

hadoop fs -ls -R /-

input01 폴더에 현재 경로에 있는 wFile01, wFile02 파일 복사

hdfs dfs -put ./wFile01.txt /input01

-

확인

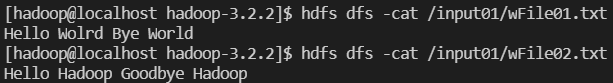

hadoop fs -cat /input01/wFile01.txt

hadoop fs -cat /input01/wFile02.txt

-

hadoop jar 명령으로 wordcount

hadoop jar /~~~~/hadoop-mapreduce-examples-3.2.2.jar wordcount /input01/output01 -

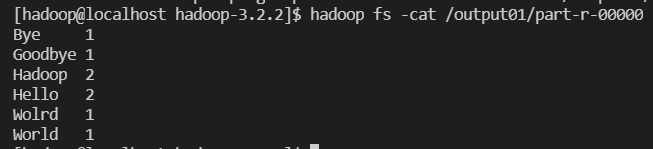

생성파일 조회 및 내용 확인

hadoop fs -ls /

hadoop fs -ls /output01

output01 폴더 안에 part-r-00000 파일은 txt 파일이므로 cat으로 읽을 수 있음

hadoop fs -cat /output01/part-r-00000

[hadoop@localhost hadoop-3.2.2]$ hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.2.2.jar wordcount /input01 / output01