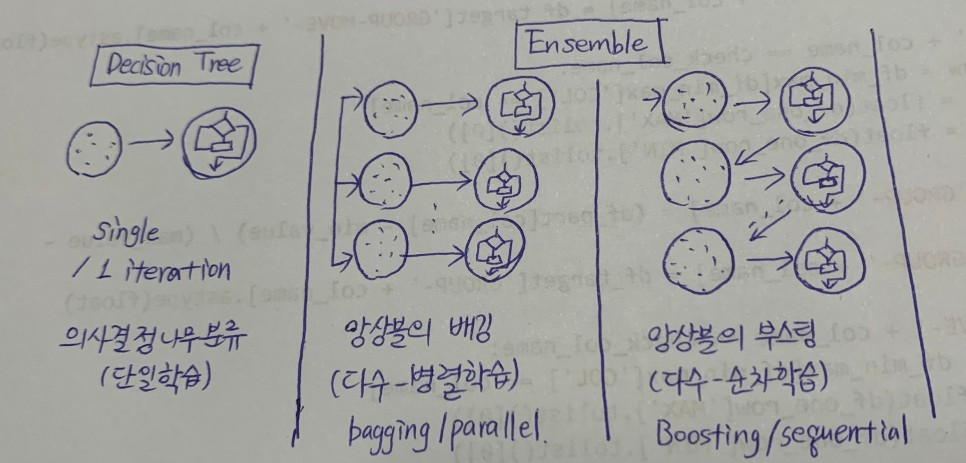

[1] 앙상블 Ensemble :

- 여러가지 우수한 학습 모델을 조합해 예측력을 향상시키는 모델

- 장점 : 단일 모델에 비해서 분류 성능이 우수

- 단점 : 모델 결과의 해석이 어렵고, 예측 시간이 많이 소요됨

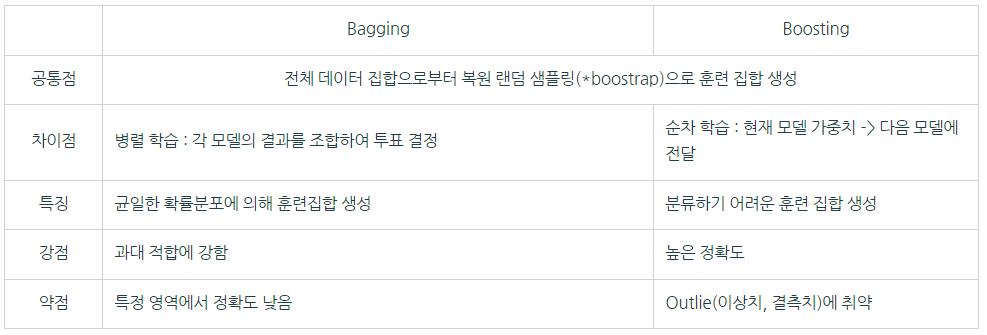

- 앙상블 알고리즘 : Bagging(배깅), Boosting(부스팅)(맞추기 어려운 문제를 맞추는 데 초점을 둠)

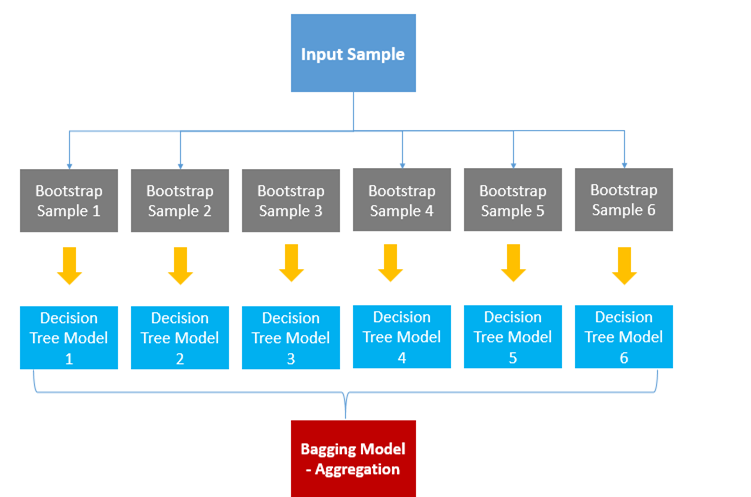

[2] Boosting Algorithm : - Random Forest - Bootstrap Aggregating의 줄임말 - > Bagging

- 부트스트랩을 통해서 조금씩 서로 다른 훈련 데이터를 생성하여 모델(훈련된 트리)을 생성하고, 결과를 결합(aggregating) 시키는 방법

- 각 샘플의 결과변수(예측치)를 결합하는 방법은 결과 변수가 연속형이면 평균, 범주형이면 다중 투표 사용

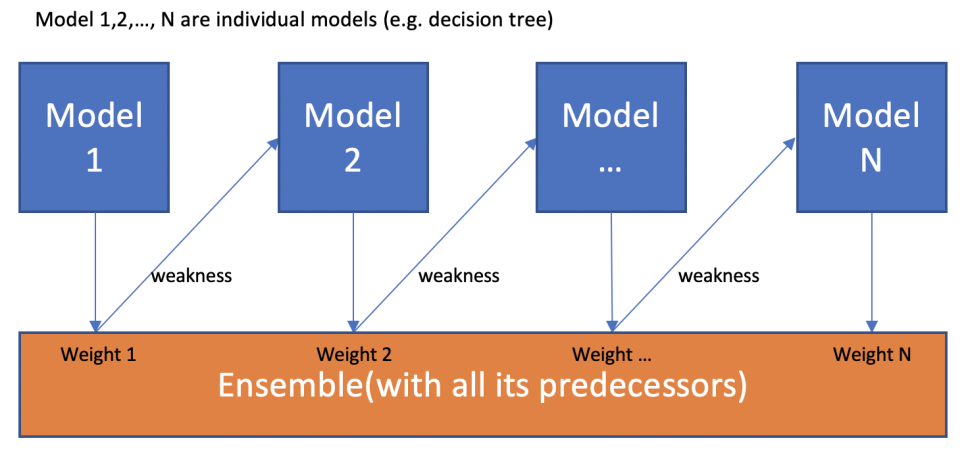

[3] Boosting Algorithm : - XGBoost - 잘못 분류된 객체들에 집중하여 새로운 분류 규칙을 생성하는 단계를 반복하는 알고리즘(순차적 학습)

- 약한 예측 모형들을 결합하여 강한 예측 모형 도출

- 오분류된 개체는 높은 가중치, 정분류된 개체는 낮은 가중치 적용 -> 예측 모형의 정확도 향상

[4] Bagging vs Boosting :

- bootstrap : 원래의 데이터셋으로부터 관측치를 반복적으로 추출(복원 반복 추출)하여 데이터셋을 얻는 방법. 데이터양을 임의적으로 늘리고, 데이터셋의 분포가 고르지 않을 때 고르게 만드는 효과가 있음.

- Reference :

1) https://joyfuls.tistory.com/61