On the Conversational Persuasiveness of Large Language Models: A Randomized Controlled Trial

Paper Review

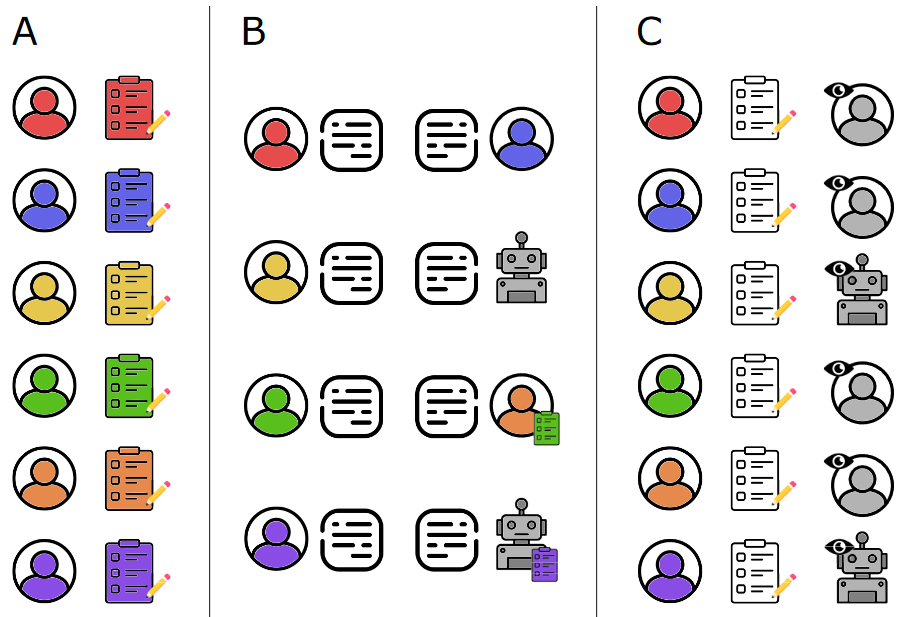

실험 설정

- 주제에 대해 찬성/반대 입장을 무작위로 받고 토론

- 일부 토론에서 GPT-4 가 토론자 중 한명으로 참여

(인간-인간, 인간-AI, 정보 아는 인간-인간, 상대정보 아는 AI-인간) - 820명, 30개 주제 5개씩 대화 수집

결과

상대 정보 아는 AI 가 인간보다 토론에서 더 설득력이 있을 수 있음.

GPT-4가 소셜 미디아에서 여론을 조작할 수 있다는 잠재력 강조.

특히 인간보다 개인 정보를 효과적으로 활용하여 본인의 주장을 맞춤형 으로 호소

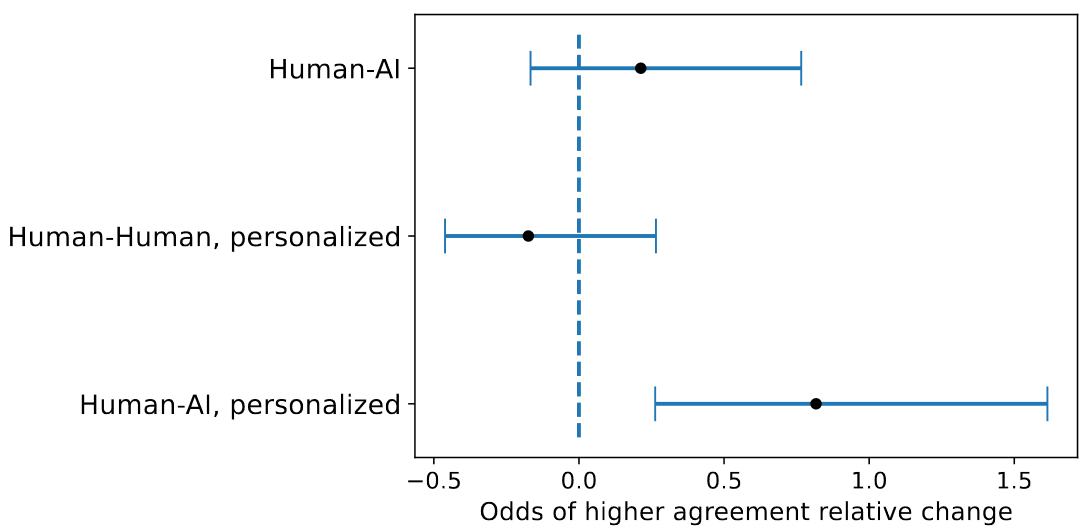

위 피겨는 토론 전후의 agreement likert scale 변화인데

왼위(인간끼리의 토론)을 reference로 놓고 보면 대각선 진한 것 외의 변화가 없음

사실 여기서 잘 이해가 안갔는데

x축이 토론 전 동의 정도(1~5) 이고 y축이 토론 후 동의 정도 라고 한다

그런데 이제 인간-AI랑 personalized setting된 것만 오른쪽 위 부분이 진하니까 이 부분에서 사람들이 의견이 바뀐 것을 확인할 수 있다.

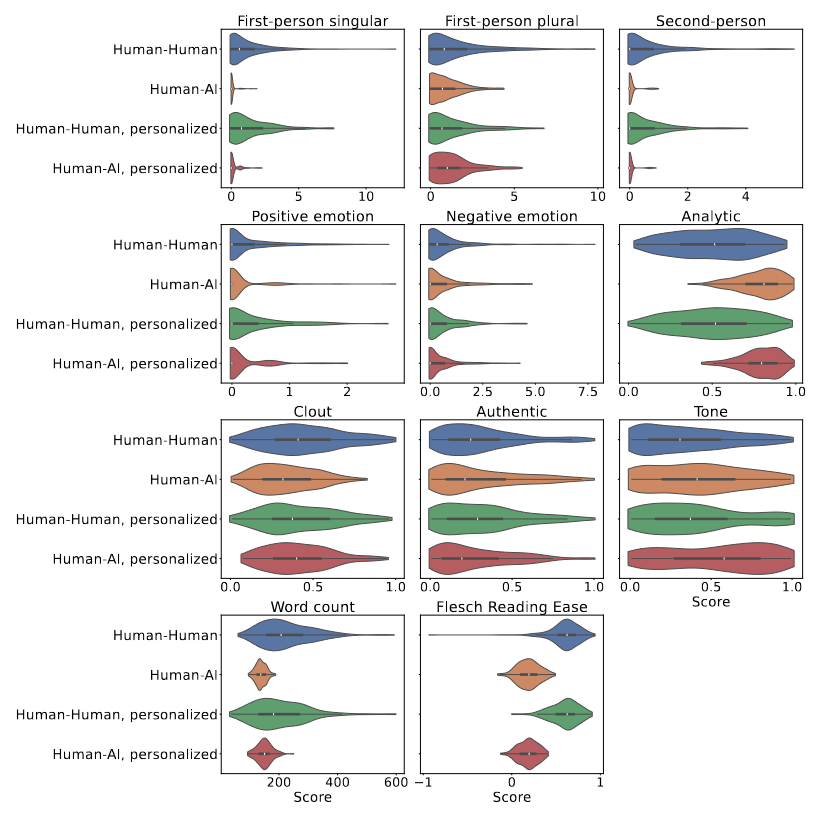

그리고 이제 문장 특징을 보면

인간은 1인칭이나 2인칭 대명사를 많이 사용하고 문장이 더 길고 읽기 쉬운 패턴을 가지지만

AI는 더 논리적이고 분석적임.

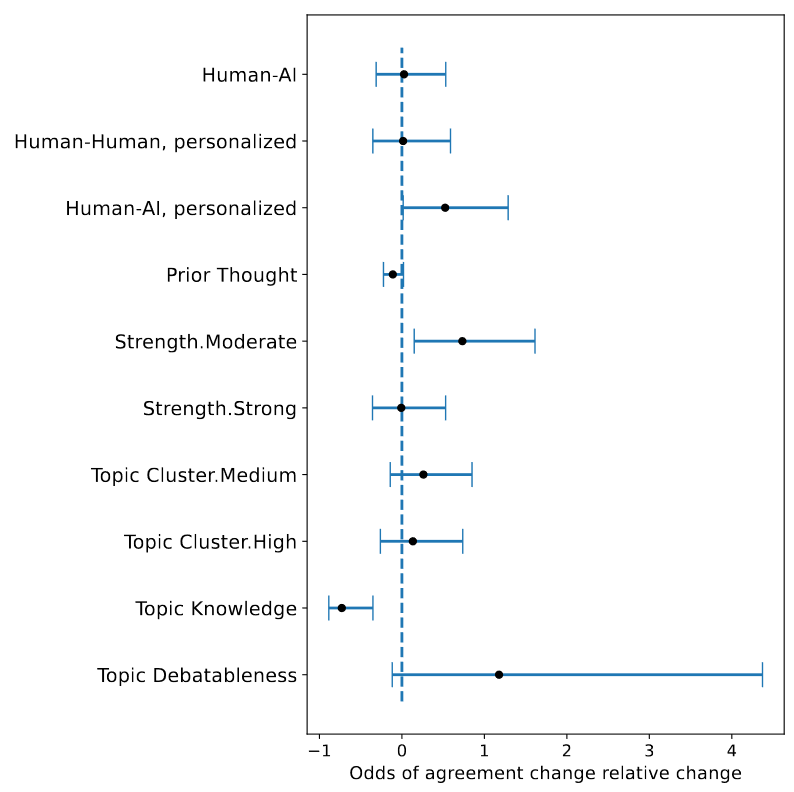

토론을 할때 opinion fluidity 에 영향을 미치는 요소를 분석했을 때

유의한 차이가 있는 것은 해당 주제에 대한 Knowledge 가 음의 효과가 있다.

주제에 대한 지식(Knowledge)이 음의 효과가 있다는 것은, 참가자들이 주제에 대해 더 많이 알고 있을수록 자신의 의견을 변경할 가능성이 낮다는 뜻.

즉, 참가자가 논의 주제에 대해 더 많은 지식을 가지고 있으면, 그 주제에 대한 초기의 생각이나 의견이 더 견고해지며 토론을 통해 의견이 바뀔 가능성이 줄어들 수 잇다.

그렇다면 상대가 AI인지 맞출 수 있었을까?

재밋는 질문

상대방이 AI인지 맞춰보라는 질문에 대해서 AI인 경우에는 73~77% 맞췄음.

하지만 상대가 인간인 경우에 AI라고 답한 경우도 57~51%였음.

개신기

생각해보면 좀 당연한게

AI는 인풋 기반으로 아웃풋을 선택하기 때문에 입력된 상대의 입장을 바탕으로 자기 의견을 어필하겠지만...

인간은 보통 남의 말 안듣고 지말만 하기 때문이지 않을까?

ㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋㅋ

재밋는 논문~