아침 9시에 시작하는 학회...

9시부터 바로 세션 시작

다 교수님들이 나오셔서 설명하는데

연구는 석,박사들이 하셔서 '~이렇다는데... ~ 이렇게 나왔다고 하더라구요~' ㅋㅋㅋㅋㅋ 뭔가 발표가 아니라 수업을 듣는 기분이었다. (지식+1)

점심...

그리고 쉬는시간+포스터 세션 시간에 다녀온 네이버 사내 스타벅스

주원언니랑 회사 안에서 잔뜩 헤매고

우와... 회사 좋다... 간지난다... 하다가 돌아와서 포스터 구경

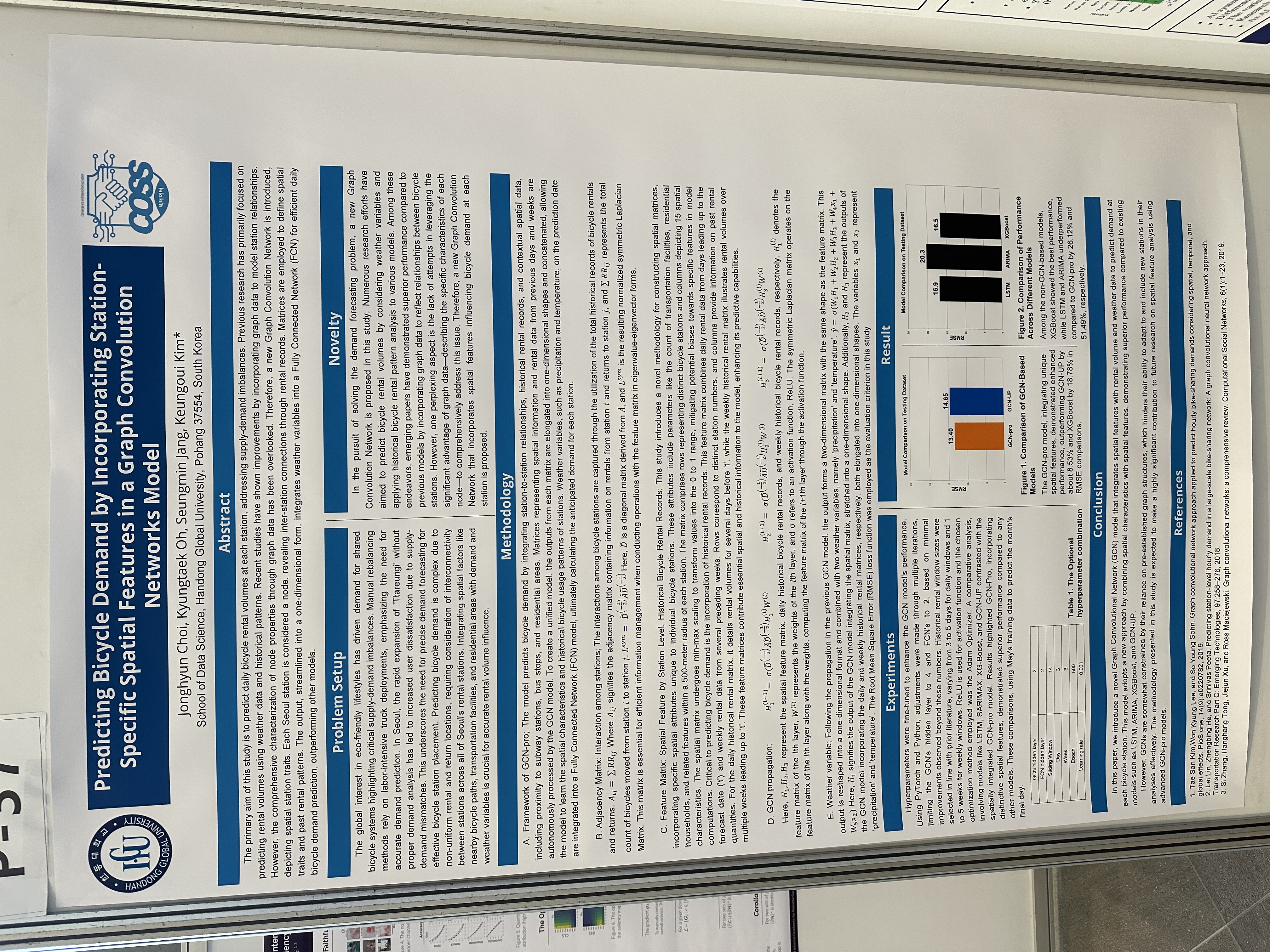

내가 하려는 연구랑 비슷한 연구가 있어서 사진찍어왔다.

모델은 비슷한데 이분은 노드 하나를 station으로 정했음. 흠.. 좀 다르네

그리고 이어지는 강연... 강연..... 강연 ..........

끝나고 저녁먹으러 왔다.

맛있었다...최고...

그리고 나도 멋진거 맹들어서 사람들 앞에서 떠들고싶다...

더 열심히 해야지... 동기부여 잔뜩 되고 왔다....

아래는 학회 들으면서 끄적거린 필기.... 정리가 하나도 안되어있는 것 같지만 내 노트에는 정리했으니(?) 됐어

Optimal Transport in Large-Scale Machine Learning Applications

Optimal Transport: 물류를 운송할 때 최적의 비용을 찾는 분야.

기존 방법들 : Transfer Learning , 3D object's Representation . Clustering . 3D Brain Surface Reconstruction . #TimeSeries

![[IMG_8158.heic]]

Its Application to generative modeling task.

- GANs

- Optimal Transport 를 GANs에 적용한 OT-GANs

- issue: curse of dimensionality

- approach to overcome : sliced Wasserstein distance (proper metric, does not suffer from curse of dimensionality, also fast)

- Random Transform (Helgason)

Universal -

understanding content behind the pixels

이런 픽셀 단위의 레이블을 계산하는걸 Dense prediction Task인데

픽셀이 레이블로 변환된다. output의 종류에 따라 사이즈나 시멘틱이 변화.

문제는 픽셀 단위에 이해가 필요할때마다 레이블링을 해줘야하는 번거로움이 있음.

-> Few shot learner for DP 해보자.

support(image, label)로 학습. (소수의 demonstration)

기존: 어떤 특정 Task위에서 각각 설계가 된다.(Segmentation, ...) 적은수로 데이터를 학습하기 때문에 오버피팅되기 쉽기 때문. 그래서 태스크에 맞춘 퓨샷 러닝은 많지만 일반화를 할 수 있는 모델은 없음

만든 모델: 트레이닝때는 키포인트, 엣지 , Surface Normal을 넣고 출력은 정하지 않았다.

조건이 생기는데, 1. 표현할 수 있는 함수의 공간이 task-agnostic function을 가져야함

어떤 형태의 레이블이 들어올지 몰라서 태스크에 맞는 inductive bias를 사용할 수 없음. 그래서 learner info에 넣지 못함

2. Flexible & data-efficient adaptation 적은 형태를 가지고 아웃풋에 형태에 맞춰야하고 오버피팅 되면 안되고 효율적인 방법을 찾아야함

3. Analogy - Making 을 잘 설계하면 되지 않을까?

4. ![[IMG_8159.heic]]

설계하기 위해서 : Visual Token Matching (VTM)

쿼리 이미지에서 패치마다 token을 뽑는다. 이거랑 support label token으로 매칭을 수행한다. similarity score계산하고 각 대응하는 레이블을 매칭한다. 그러면 인코딩하고 디코딩하면 계산할 수 있게 된다.

task specific parameter를 설계하면 가능하다.

task specific bias tuning

오민환 UCB-CCA

유저의 피드백을 받는 모형화

cascade (인스타에서 하나씩 추천 ) vs 넷플릿스처럼 한번에 여러개 Assortment

=> 실생활에서는 두가지가 합쳐진 형태로 제공됨

한단계(한줄)씩 피드백을 받으면서 없다면 다음 assortment , 선택된 single assortment=1 이면 그 위치를 알아낸다.

매 시간마다 아이템에 대한 정보를 바탕으로 에이전트들이 아이템의 셋을 assortment의 형태로 유저에게 제공하며 피드백을 받는다.

유저의 클릭이 받으면 세션이 리셋된다 : 세번째 줄에서 클릭을 하면 세번째 ass에서 클릭하고 이 인터액션은 끝나는거. 멈추게 되는 시점을 ot.

-> 유저의 초이스 모델을 구성해야한다.

이 초이스 모델을 바탕으로 expected reward function을 설계.

임성빈

image generation model, video, motion generation

추론된 파라미터들로 샘플링을 할 수 있지만 데이터가 크다면 분포를 알아내기 힘들다.

데이터 분포를 모델 분포에서 샘플링하는것으로 매칭 (data distribution = model distribution)

만약 train 사진이랑 generate이미지가 같으면 안된다. 대신 유사한 분포를 찾아야함. train dataset과 같아서는 안되는 중요한 문제. -> 현재의 단점 , 숙제

따라서 이 둘을 매칭할때는 kullback 이 0으로 낮아지게 해야하한다., but max likelihood

"generative model중에서 Unnormalized Density, approximate density"

기존 - DDPM 처럼 실제 데이터와 매칭이 되는 솔루션이 있는가?

윤철희

sharpness-aware minimization

min max f(x+e) => max부분을 != arg max ** <- 최대한 크게 만드는 입실론은 gradient 를 norm

ppt에 이모티콘 쓰기 신선하다

한보형 On the Training-Free Image Manipulation using Diffusion Probabilistic Models

sorce information에도 target값을 준다?

확률 분포에서 샘플링을 해서

타겟이 소스에서부터 멀어지지 않게 만든다.....

cross-attention mixed up

김현우 Multi-modal Foundation Models for Video Question Answering

비디오를 보고 내용에 대한 질문을 대답해야하는 것.

비디오를 해석해야한다.

요즘 문제는 단어들은 잘 찾는데 주변에 형용사나 물건들의 관계를 이해하기 힘들다.

때로는 프롬프트만 보고도 답을 맞출 수 있게 AI가 완전히 문제를 이해하게끔 해야함

그래서 말만 들어도 문제풀어도 잘 풀수 있게끔 linguistic shortcut

그래서 Lang Model 을 잘 활용해야한다. + linguistic Bias (못맞추는거)

bias를 활용해서 video QA model을 만드는게 목표

사용했던 모델은 FrozenBiLM. => Frozen Graph Attention

Flamingo (lAng을 놔두고 사이사이에 모델을 넣어서 같이 올라가는)

비디오를 안보고 풀 수 없는 문제를 만들어보자! -> 순서를 바꿔서 비디오 -> 답> 문제만들기

문제+답> 비디오 만들기

그래서 나온 문제는 Flipped-VQA: 비전 태스크임에도 불구하고 랭귀지 모델 성능에 따라서 vqa성능이 달라진다. 원래 문제를 푸는게 아니라 다른 문제를 생성/ 비디오를 생성하는 성능까지 비교하니까 ours가 제일 좋다.

pretrained 된 모델을 잘 쓰면 -> 모델의 성능이 올라간다 !! 그러니까 모델을 잘 골라....

시간적 순서랑 인과관계를 잘 못했는데, 랭귀지 모델을 활용했더니 잘 하게됐다.!

open vocab video question answering

새로운 단어가 나오는 경우에는 떨어졌다.

어떻게 하면 새로운 단어들에 대해서 채점을 잘 할 수 있을까?

![[IMG_8164.heic]]

GNN접목시켰음...

랭귀지 의존해서 모델을 만들었는데, 비디오랑 캡션이 있는 데이터를 같이 사용한다거나

로스펑션들을 잘 조합해서,

이미지와 캡션이 다를수도 있다. (시간적으로) 따라서 여러개의 묶음으로 프롬프트를 짜는게 제안이 됐었는데,

자기가 정렬을 하면서 배우는 VT-TWIN이라는 걸 제안했다.

김태욱

서로 다른 언어를 처리할 때 , 두개의 언어에 대해서 각각 어떻게 동작하는지 , 확인한후 잘 activation이 되는 부분을 확인하고 싶었다.

그래서 방법:

추상적인 각각의 언어마다 모델의 활성도를 나타내주는 맵을 만들어야하는데 이걸 계산할 때 앞에서 gradient 기반의 score방식을 활용해서 기존의 랭귀지 모델을 인풋으로 주고 그게 어떻게 동작하는지 계산을 한 걸 기반을 해서 feature information을 구한다.

주어진 오브젝티브에 대해서 그 언어에 대한 importance score를 계산하고 top - p percent를 뽑는다. 언어별로 맵을 만들게 된다. 이 맵에 대해서 오버랩핑(!)을 계산하게 된다.

각각 연속된 값을 -> 바이너리한 값으로 바꿔서 계산햇다.

자카드 시뮬러리티(?)를 통해서 오버랩을 계산한다.

=>멀티 링구얼 모델이 언어별로 핵심적으로 액티베이트 되는 부분이 다를것이다. 그리고 겹쳐있는 부분이 있을것이다.

그래프의 각도를 재본다. KDE upper angle -> max & min의 차이. 균일하게 토큰화가 된다는 의미. 그런 언어를 골라서 학습을 하면 잘 된다. !!!! 라는 연구결과가 있음

두개의 언어의 코사인 similarity 를 구해서 임베딩화 (EMB)