paper review&implementation

1.[Review and Implementation]LSTM-based Encoder-Decoder for Multi-sensor Anomaly Detection

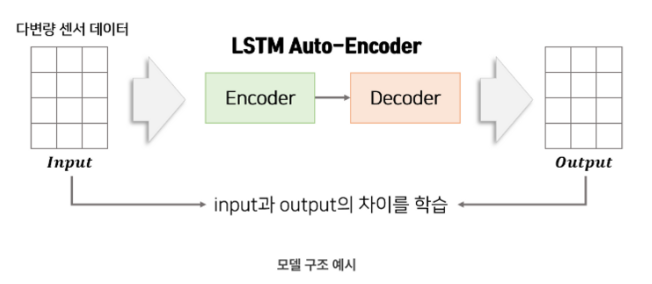

정상 데이터를 input으로 입력하여 encoder에서 차원 축소, decoder에서 다시 복원 하는 과정을 거쳐 output이 나온다.인풋과 아웃풋의 차이를 최소화 하도록 학습한다.(MSE 사용)Teacher Forcing 기법 사용initial 값은 0 벡터를 넣음

2.[PaperRevie]Deep Learning for Anomaly Detection:A Review, An Evalution of Anonamaly Detection and Diagnosis in Multivariate Time Series

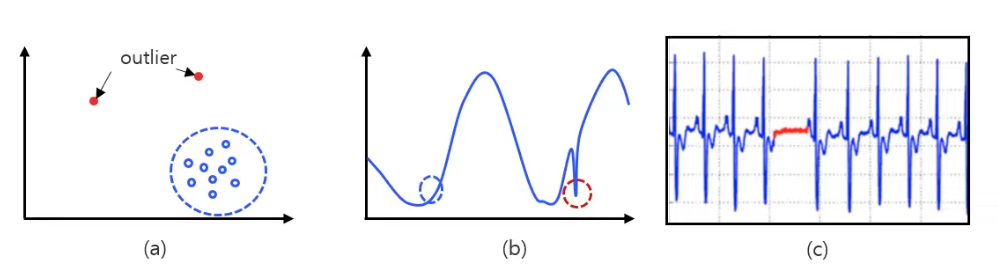

이상탐지 관련 여러가지 deep learning 기반 모델에 대해 파악하고 각 모델들에 대한 실험 결과를 확인할 수 있음최적 모델을 선정하는데 평가 기준 지표에 대한 이해를 바탕으로 추후 진행될 실험과 모델 선정에 도움이 될것으로 생각됨적절한 anomaly scorin

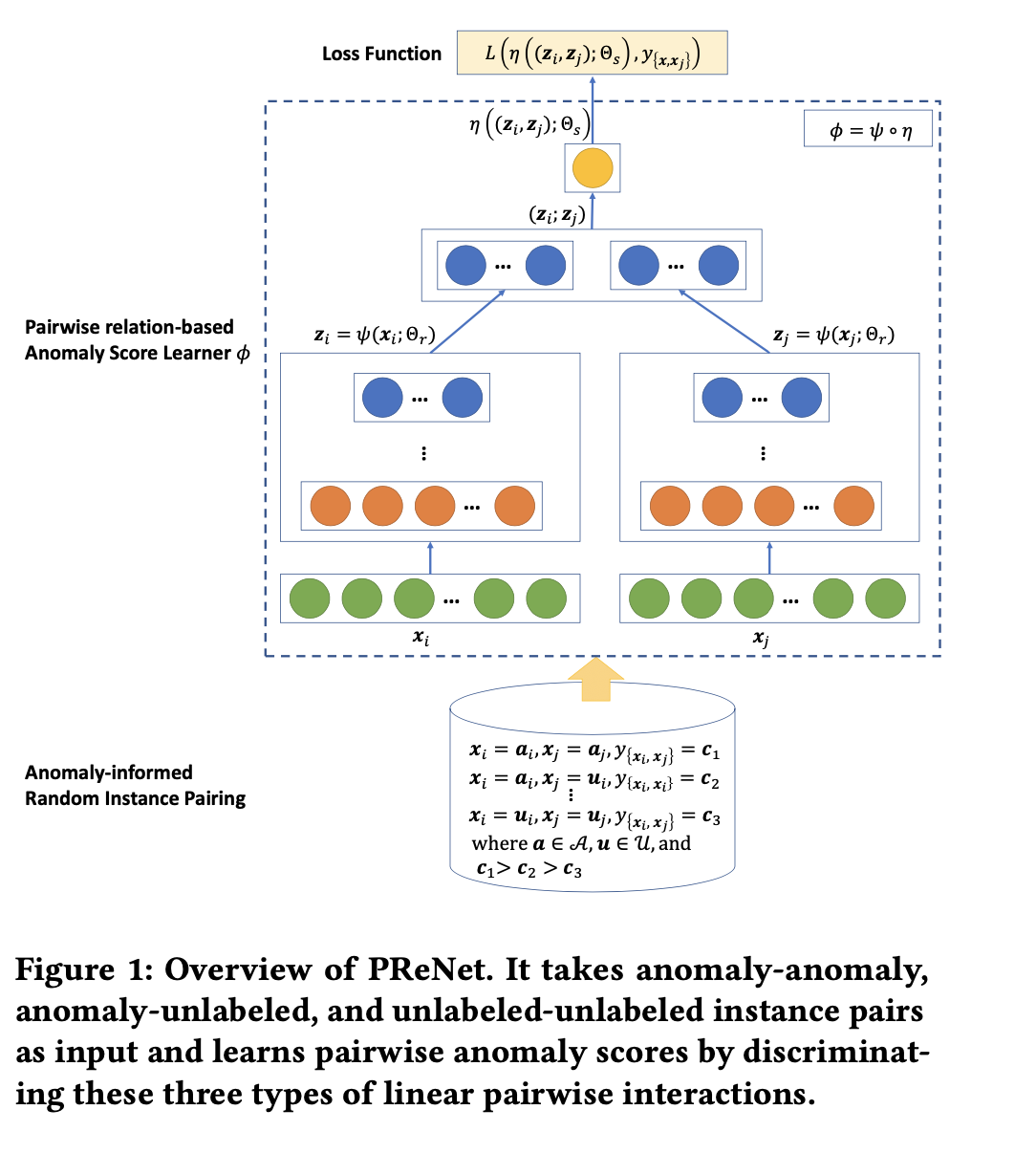

3.[Paper Review]Deep Weakly-supervised Anomaly Detection

weakly supervised learning은 우리가 anomaly label을 불완전하게 가지고 있다고 가정한다. 이러한 가정에서 두 가지 문제를 해결하고자 한다.해당 논문은 1번 문제인 작은 양의 anomaly data문제를 해결하기 위해 pairwise aug

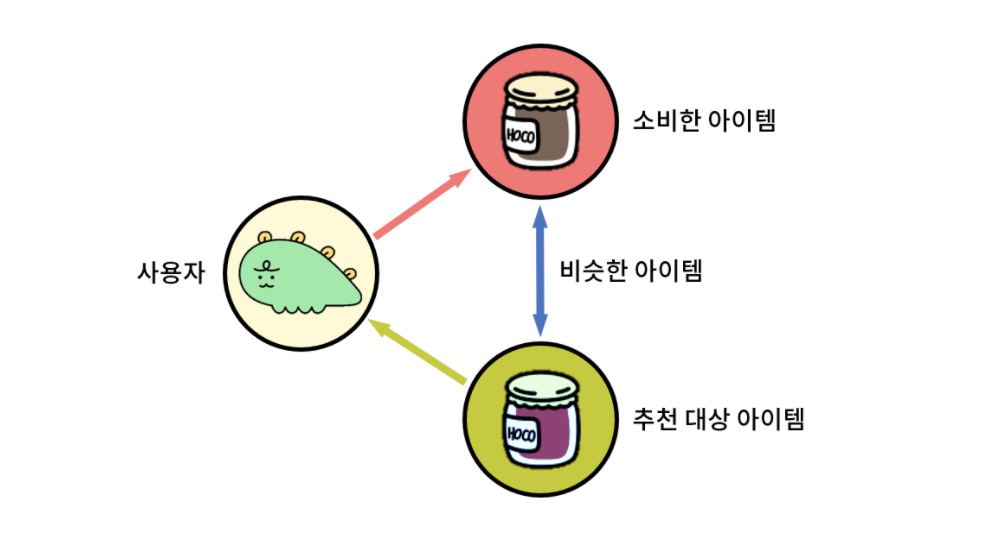

4.전통적인 추천 시스템(CB, CF, MF, NCF, AutoRec)

유저 혹은 아이템에 대한 정보가 없는 상태에서 시작해 추천의 정확도가 떨어지는 문제예를들어 넷플릭스에 처음 가입한 상태가 있다. 아직 시청 기록도 평가 기록도 없으므로 추천을 하기 어렵다.아이템이 너무 많아서 유저가 사용한 경험이 있는 아이템의 수 는 그 중에서 극히

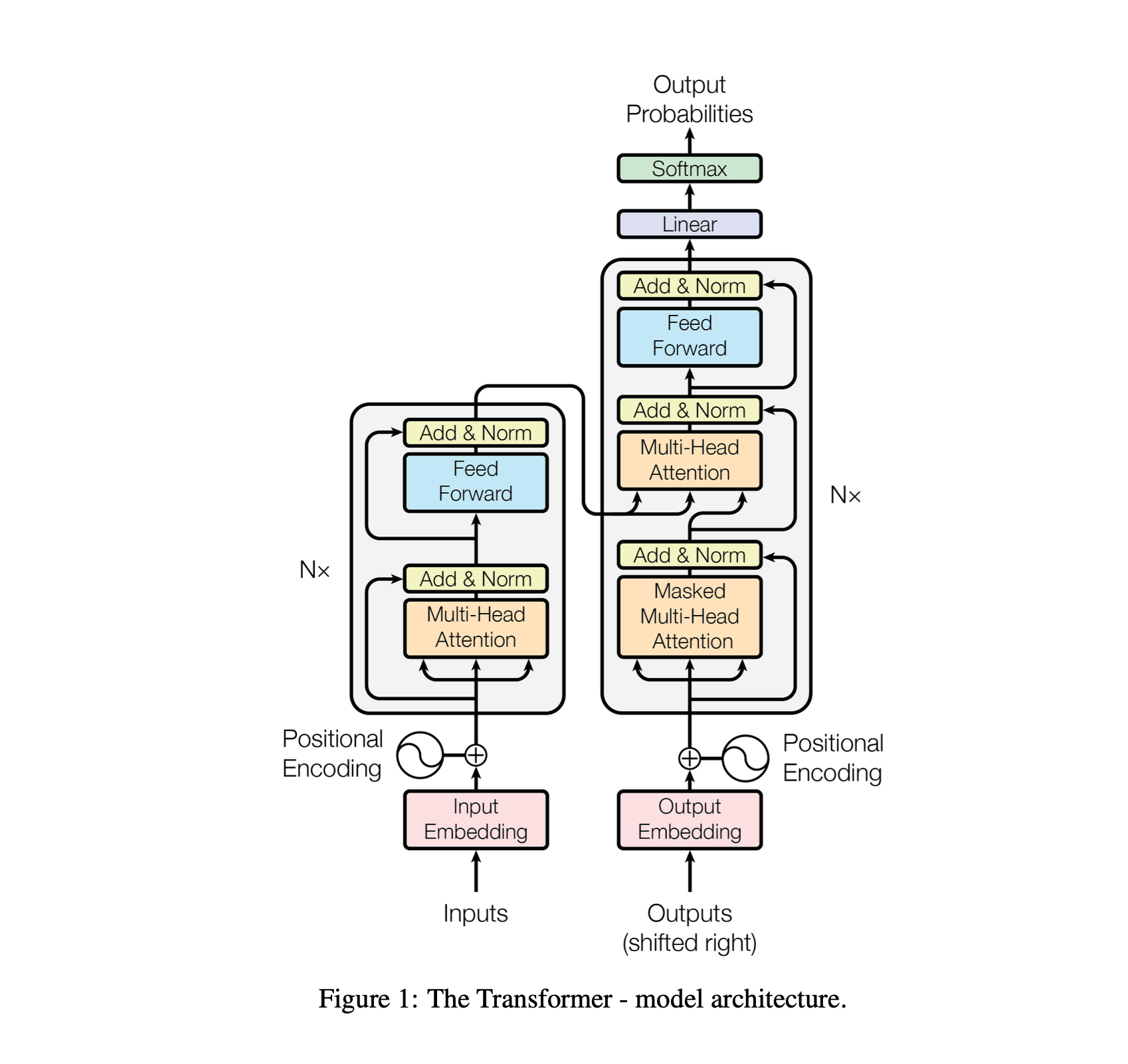

5.Attention is All You Need

드디어 드디어 attention is all you need 논문을 정리해봤다. 그 동안 nlp분야에 관심이 크게 없어서 미루고 미뤘었는데 더 이상 이걸 제대로 정리하지 않으면 이 분야에 있다고 말할 수 없는 지경에 다달았다. 2024년 노벨상을 2개나 인공지능 분야에

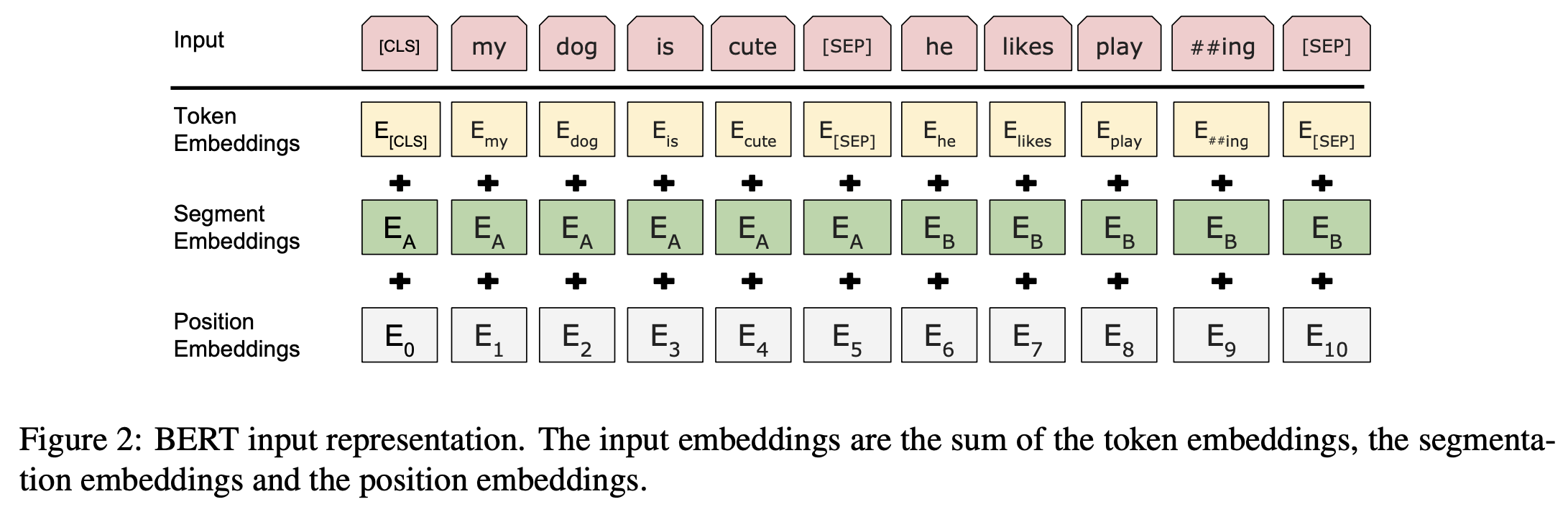

6.BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding

우리는 새로운 언어 표현 모델 BERT,Bidirectional Encoder Representation from Transformers 로 말할 수 있는, 를 소개하겠다. which stands for Bidirectional Encoder Representatio

7.DeepSeek-R1 논문 리뷰

사전학습된 언어모델 DeepSeek-V3-Base를 Supervised Fine-Tuning 없이 강화 학습을 바로 적용한 모델강화학습으로 강력한 추론 능력을 얻었지만 가독성이 떨어지고 언어들이 섞이는 문제가 발생위 문제를 해결하기 위해 Cold-Start 데이터(소량