2-2. GPT 시리즈

GPT-3

저번에는 GPT-3가 더 커짐에 따라 few-shot learners 능력을 가지게 된다는 것까지 내용을 옮겨적었다. GPT-3에 대해 더 적자면, In-context learning능력으로 이전에는 fine-tuning이 필요했기 때문에 태스크 마다 학습해야하는 번거로움이 있었지만, 프롬프트에 예시 몇 개(few-shot)을 넣는 것만으로도 모델 업데이트(fine-tuning) 없이 태스크 수행 가능해졌다는 것이다.

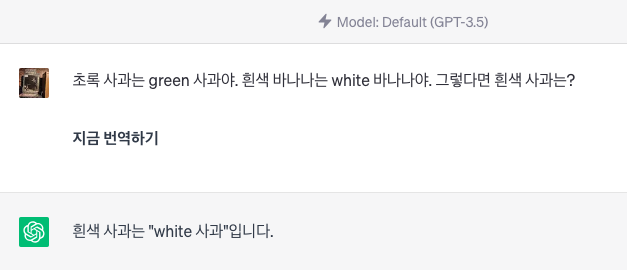

다른 블로그 글의 예시를 가져오자면, 프롬프트로 "초록 사과는 green 사과야. 흰색 바나나는 white 바나나야. 그렇다면 노란 사과는?"와 같이 예시와 함께 입력했을 때, 그 예시를 스스로 학습하고 그에 맞는 답변을 내놓는 것이다.

과연 자연어 분야에서만 이럴 줄 알았는데, 조금 찾아보니 이미지에서도 같은 현상이 있는 것 같았다.

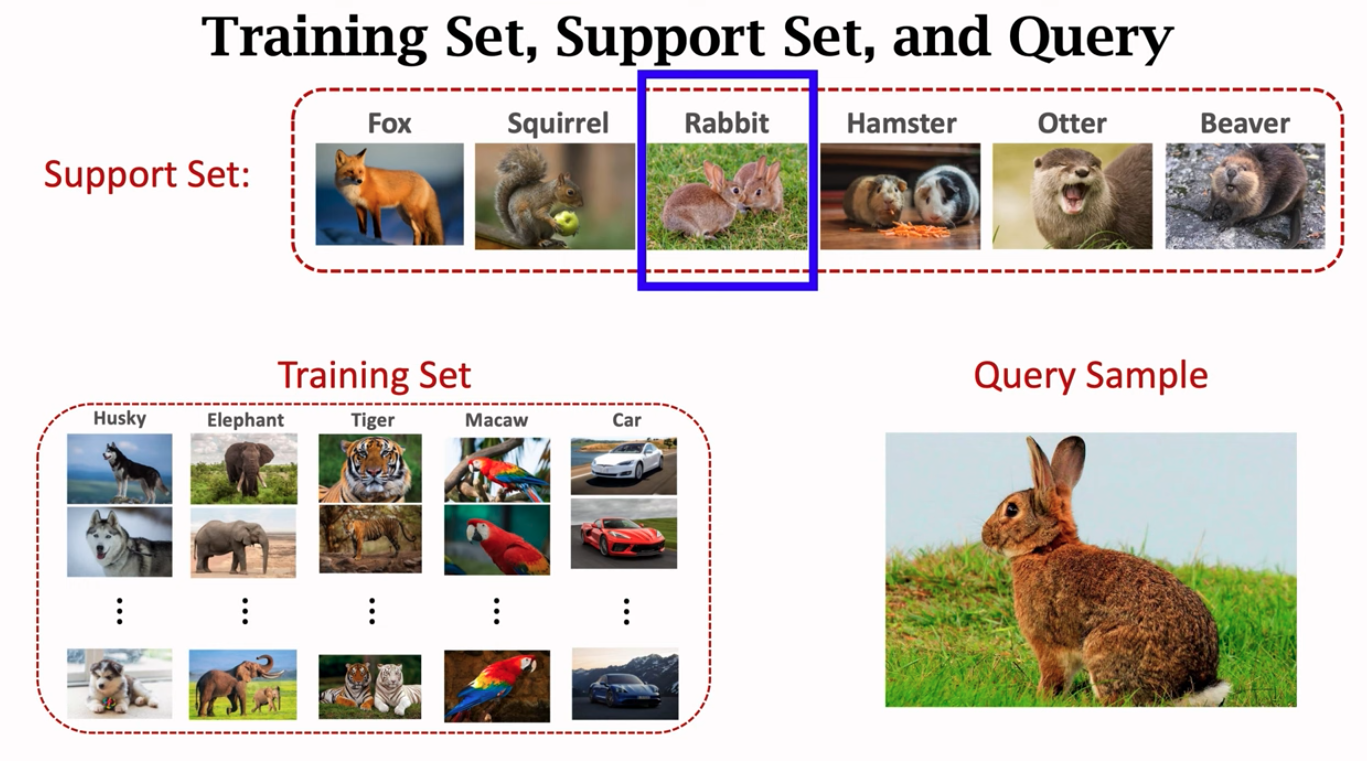

다음은 few-shot learning 유튜브 강의에서 가져온 내용이다. 아래 왼쪽처럼 학습 데이터로 Husky, Elephant, Tiger, Macaw, Car 데이터만 학습시켰기 때문에 토끼 사진만 보여주면 모델은 정확한 예측을 하지 않는다.

하지만, Rabbit에 대한 이미지 정보가 있는 Support Set을 Query와 함께 넣어주면 Rabbit으로 예측 가능해진다는 것이다!

GPT를 서비스로 사용할 때, fine-tuning을 통한 모델 업데이트도 중요하지만, 프롬프트를 잘 사용하는 것이 학습 비용을 아낄 수 있기 때문에 정말 중요해질 것으로 보인다.

GPT-3.5

Codex와 같이 코드 생성을 위한 모델도 나타났으며, GPT가 지문에 맞는 답변 반환이 가능하도록 하기 위해 InstructGPT라는 것도 만들어졌다.

GPT-3.5는 GPT-3와 함께 코드 학습 데이터, 지문 fine-tuning한 모델이다. 이 모델을 이용한 ChatGPT 서비스가 태어났다.

3. ChatGPT와 그 생태계

이번 세션에서는 ChatGPT의 품질, 한계, 이용해야할 장점과 ChatGPT를 이용한 AI 서비스 생태계에 대해서 설명했다.

ChatGPT는 사용해본 사람은 다 알고 있는 대로 정보를 생성해내는 기술이며, 이는 사실과 관계없을 확률이 크다.(Hallucination) 이러한 한계점을 이해하고 '정보 생성', '대화 가능' 장점을 잘 이용한다면 좋은 서비스를 만들 수 있을 것이다.

데이터를 이용한 학습을 통해 ChatGPT 서비스 성능을 향상시키는 방향도 있지만, Prompt Discovering 역량을 키워 목적에 맞는 프롬프트를 잘 넣는 것 또한 중요하다.

4. Next GPT

다음 GPT 서비스는 어떤 형태일까? 일단 프롬프트가 중요해짐에 따라, Prompt Engineering, Discovering, Template 만들기와 같이 그에 맞는 직무 및 작업이 생겨나게 될 것이다.

이 세션에서도 가장 중요하다고 강조하셨던 건 Prompt Manager다. 모델을 학습시키는 비용은 어마어마하다. 그래서 Prompt Manager를 이용해서 기존의 여러 모델을 조합해서 사용하거나, 모델이 할 수 없는 일들을 다른 API와 함께 사용하도록 유도하여 AI 모델의 태스크 역량을 키워나갈 수 있게 되었다.

그 예시로는 AutoGPT, LangChain, babyagi 등이 있다.

Outro

겨우 1회차 이긴 하지만, 정말 유익하고 꽉찬 워크샵이었다! 나름 이쯤이면 ChatGPT에 대해 대부분 알고 있겠지 생각했었는데, 모르고 있었던 정보도 많았고, 논문 정보들을 이 짧은 시간에 모두 얻을 수 있어서 좋았다. GPT 시리즈에 대한 스토리에 대해서는 너무 재밋게 잘 설명해주셔서 흥미롭게 들을 수 있었다.

프롬프트가 왜 중요한지 더 잘 이해할 수 있었고, GPT를 어떻게 활용해야하는지 너무나도 친절하게 이해시켜주었던 워크샵이었다.

현재 3회차까지 모두 들은 상태지만, 1회차 만큼은 꼭 추천해주고 싶은 세션이었다.