논문

1.Attention 논문 리뷰

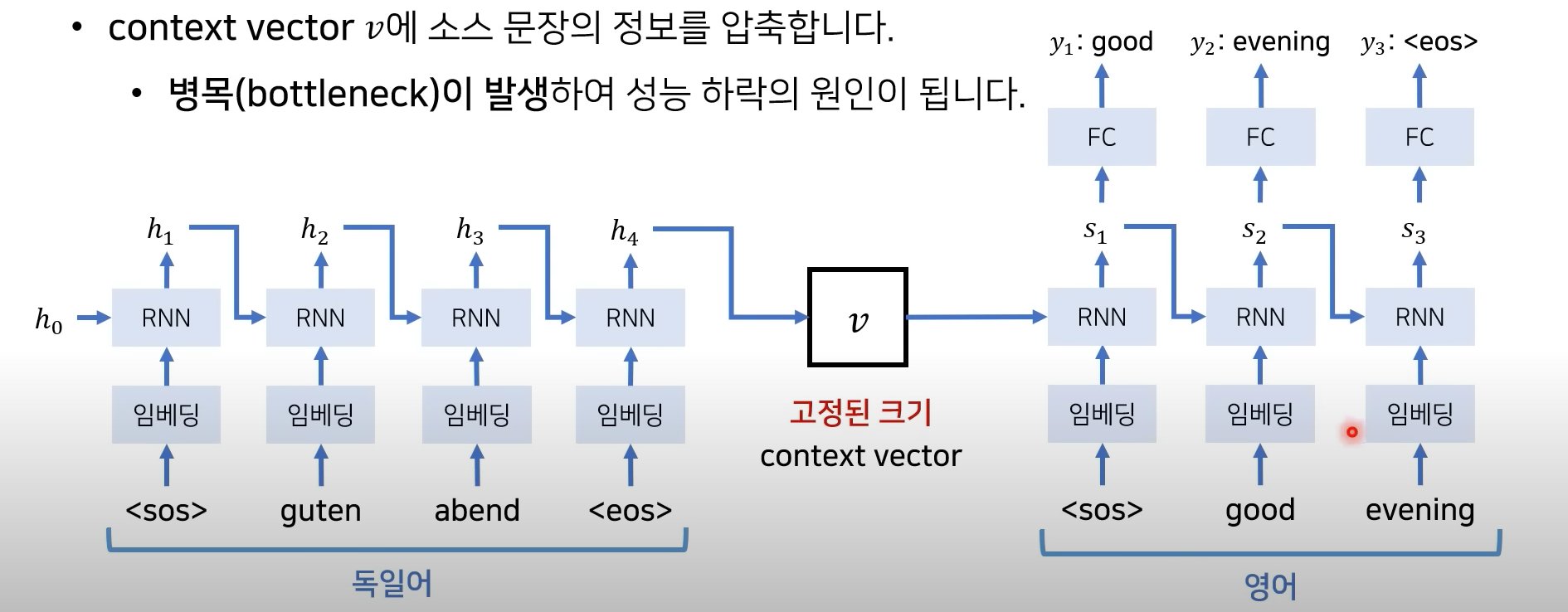

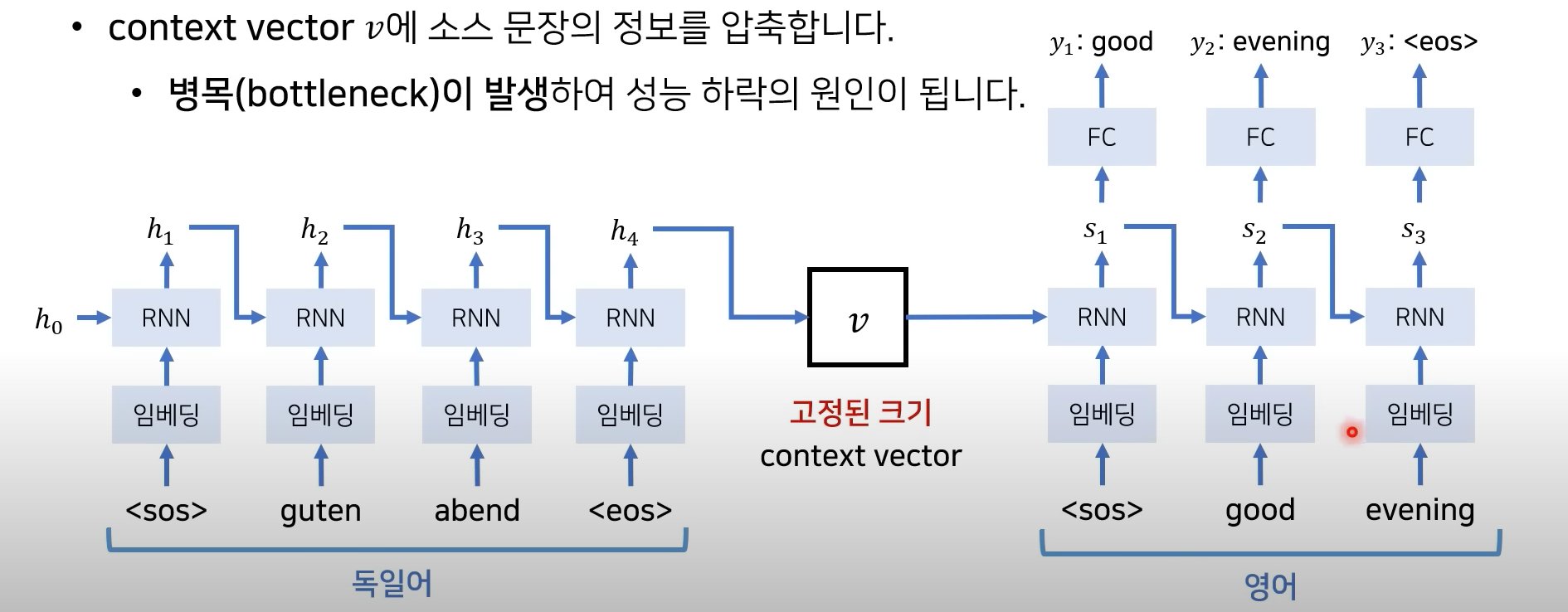

기계번역 RNN -> LSTM -> Seq2Seq(고정된 크기의 vector 사용) -> Attention -> Transformer -> GPT-1 -> BERT Seq2Seq로 딥러닝 기반 시계역 예측 등 기법이 등장 하지만, 성능상의 문제로 Attent

2023년 11월 26일

기계번역 RNN -> LSTM -> Seq2Seq(고정된 크기의 vector 사용) -> Attention -> Transformer -> GPT-1 -> BERT Seq2Seq로 딥러닝 기반 시계역 예측 등 기법이 등장 하지만, 성능상의 문제로 Attent