논문 제목:ReluDiff: Differential Verification of Deep Neural Networks

📕 Summary

Abstract

이 논문에서는 서로 밀접하게 관련된 두 개의 심층 신경망의 차등 검증을 위해 ReluDiff라는 새로운 방법을 도입하여 적대적인 예가 있을 때, 압축된 네트워크의 정확도를 공식적으로 보장합니다.

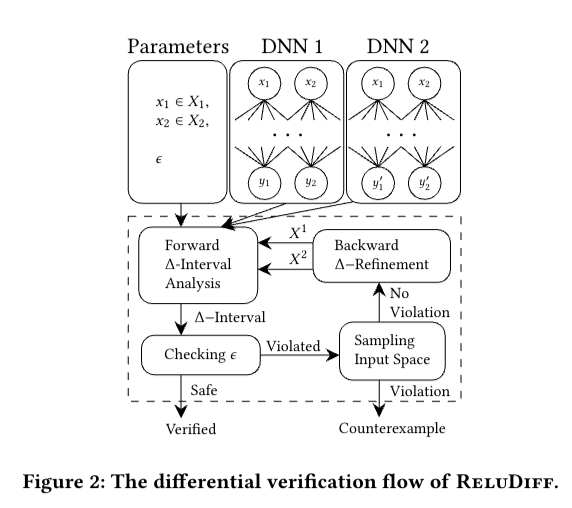

ReluDiff는 원하는 속성이 검증될 때까지 근사치를 반복적으로 개선하는 빨리 감기 간격 분석 패스와 역방향 패스로 구성되며, 기존 검증 도구에 비해 상당한 속도 향상을 달성하고 더 많은 속성을 증명할 수 있습니다.

Introduction

Introduction에서는 특히 안전이 중요한 시스템에서 오류로 인한 잠재적인 치명적인 결과와 악의적인 사례의 존재로 인해 심층 신경망에 대한 공식적인 검증의 필요성이 점점 더 커지고 있음을 강조합니다.

네트워크 크기와 에너지 소비를 줄이기 위한 기존의 압축 기술은 정확성에 대한 공식적인 보장이 부족하며, Reluplex, ReluVal, DeepPoly와 같은 검증 기술은 단일 네트워크 분석을 위해 설계되어 두 네트워크 간의 관계를 처리할 수 없습니다.

이 논문은 양자화 및 에지 가지 치기와 같은 압축 기법을 사용한 후에도 서로 밀접하게 관련된 두 네트워크를 분석하여 동일한 입력에 대해 동일한 출력을 생성한다는 것을 증명하는 차등 검증 문제에 초점을 맞추고 있습니다.

네트워크 간의 구조적 유사성을 활용하지 못하고 두 네트워크에 동일한 입력을 처리하지 못하는 등 기존 검증 도구의 한계에 대해 논의합니다.

이 논문에서는 기존 도구에 비해 더 빠르고 정확한 결과를 얻기 위해 순방향 구간 분석과 역방향 정제를 결합한 새로운 차등 검증 방법인 ReluDiff를 소개합니다.

📕 Solution

What is ReluDiff?

ReluDiff라고 하는 이 방법은 빠르지만 근사치를 구하는 순방향 구간 분석 패스와 원하는 속성이 검증될 때까지 근사치를 반복적으로 다듬는 역방향 패스를 결합한 것입니다.

ReluDiff는 포워드 패스 동안 두 네트워크 간의 구조적 및 행동적 유사성을 활용하여 출력 뉴런 간의 차이를 보다 정확하게 바인딩합니다.

백워드 패스에서 ReluDiff는 기울기 차이를 활용하여 가장 유리한 세분화를 계산합니다.

실험 결과에 따르면 ReluDiff는 최첨단 검증 도구에 비해 몇 배의 속도 향상을 달성하고 더 많은 속성을 입증했습니다.

이 논문은 두 네트워크에 동시에 집중함으로써 각 네트워크를 개별적으로 분석하는 것에 비해 ReluDiff가 더 효율적이고 정확하다는 것을 보여줍니다.

ReluDiff는 복잡한 ReLU 활성화 패턴을 처리하고 기호 간격 산술을 사용하여 두 네트워크의 기울기 차이를 정확하게 계산합니다.

Algorithm

이 논문에서는 심층 신경망의 차등 검증을 위한 새로운 방법인 ReluDiff를 소개합니다.

ReluDiff는 순방향 간격 분석 패스와 정제를 위한 역방향 패스로 구성됩니다.

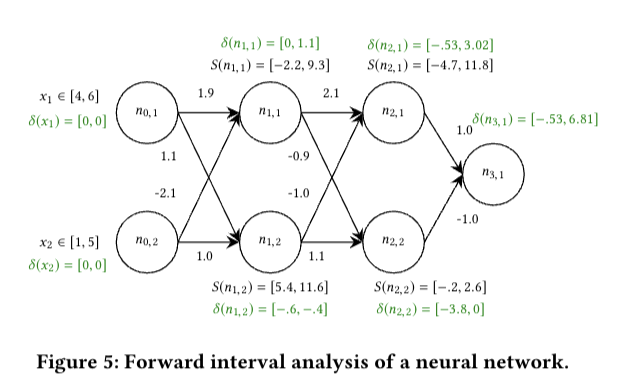

포워드 패스 동안 ReluDiff는 두 네트워크 간의 구조적 및 행동적 유사성을 활용하여 출력 뉴런 간의 차이를 정확하게 바인딩합니다.

역방향 패스에서 ReluDiff는 기울기 차이를 활용하여 가장 유리한 세분화를 계산합니다.

ReluDiff는 기호 간격 산술을 사용하고 복잡한 ReLU 활성화 패턴을 처리하여 두 네트워크 간의 출력 차이를 정확하게 근사화합니다.

ReluDiff의 효율성과 정확성을 비교하기 위해 ReluVal 및 DeepPoly와 같은 기존 검증 도구와 실험적으로 비교합니다.

ReluDiff는 OpenBLAS를 사용하여 C로 구현되었으며 부동 소수점 연산의 건전한 처리를 위해 외내 반올림 및 기호 간격 연산을 통합합니다.

실험적 비교를 통해 신경망의 차등 검증에서 ReluDiff가 훨씬 더 정확하고 효율적이라는 것이 입증되었습니다.

📕 Conclusion

이 논문에서는 밀접하게 관련된 신경망의 차등 검증을 위한 새로운 방법인 ReluDiff를 소개하며, 이를 통해 원래 네트워크와 비교하여 압축된 네트워크의 정확성을 공식적으로 증명할 수 있습니다.

ReluDiff는 기호 간격 분석과 기울기 차이를 활용하여 두 네트워크 간의 뉴런 값의 차이를 정확하게 계산하고 전파하여 최첨단 검증 기법에 비해 상당한 속도를 달성하고 더 많은 증명을 생성합니다.

ReluDiff의 포워드 패스는 구간에 대해 건전하게 정의되고 과대 근사치를 제공하여 분석의 건전성을 보장하는 아핀 및 ReLU 변환을 사용합니다.

포워드 패스 후 분석 결과가 충분히 tight하지 않을 수 있지만, 본 논문에서는 분석 결과를 개선하는 방법에 대해 설명합니다.

이 논문은 악의적인 사례를 탐지하는 기법이 있지만, 위반 사례를 찾기보다는 위반이 없음을 증명하는 데 중점을 두는 형식적 검증과 직교한다는 점을 강조합니다.