모두를 위한 딥러닝 시즌 1 ML lec 6

Multinomial ClassificationSoftmax Classificationcost functionsigmoidsoftmax function모두를 위한 딥러닝모두를 위한 딥러닝 시즌1

0

모두를 위한 딥러닝 시즌 1

목록 보기

2/4

Lecture 6-1 Softmax classification: Multinomial classification

- 저번 강의에서 우리는 binary classification에 대해 공부했었다. binary classification은 한가지 기준으로 그렇다/아니다를 판별하는 것이었다. 그런데 2가지 이상에 대해서 판별하려면 어떻게 해야할까 이것을 알아보디 위해 이번시간에는 multinomial classification에 대해 배웠다.

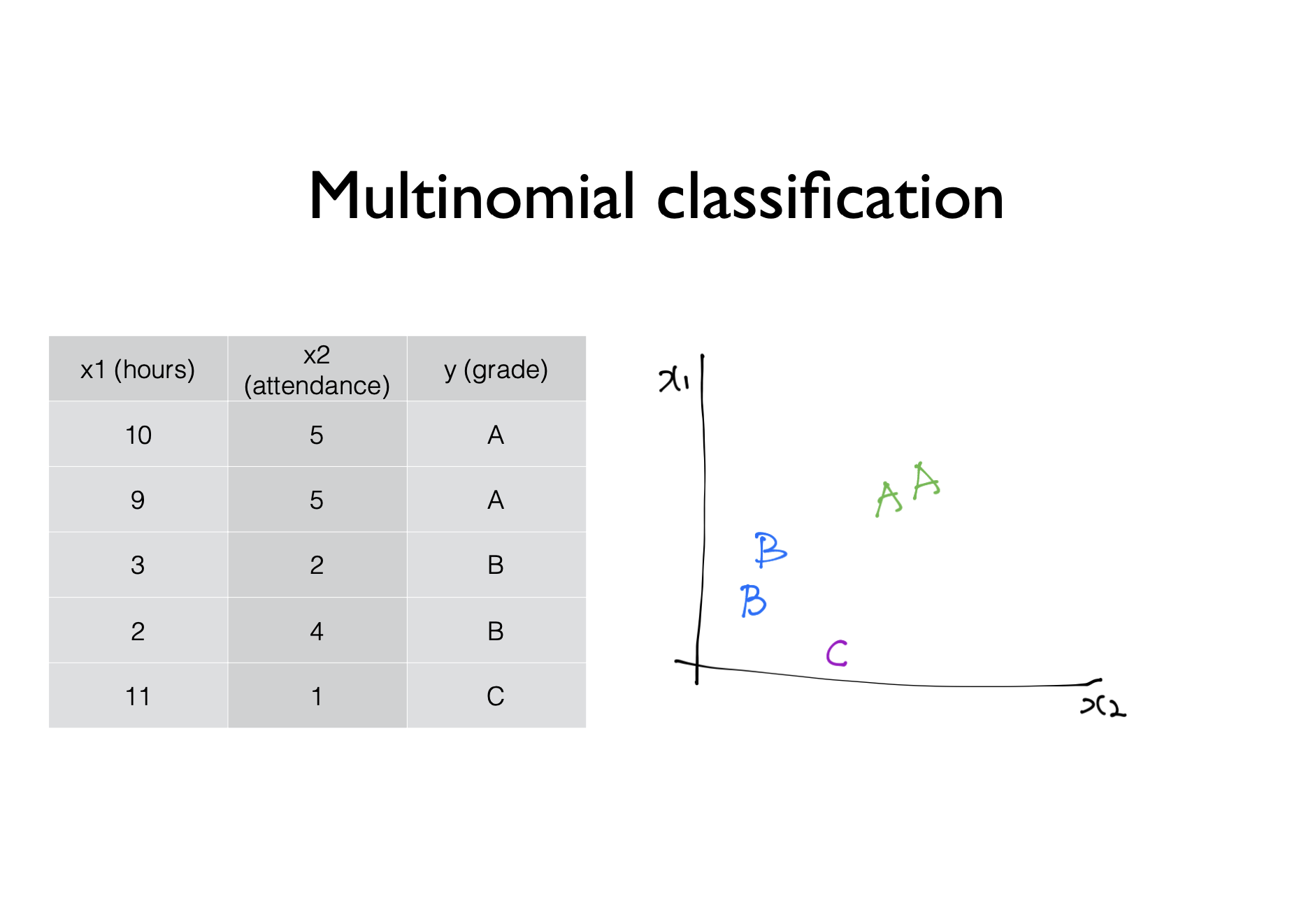

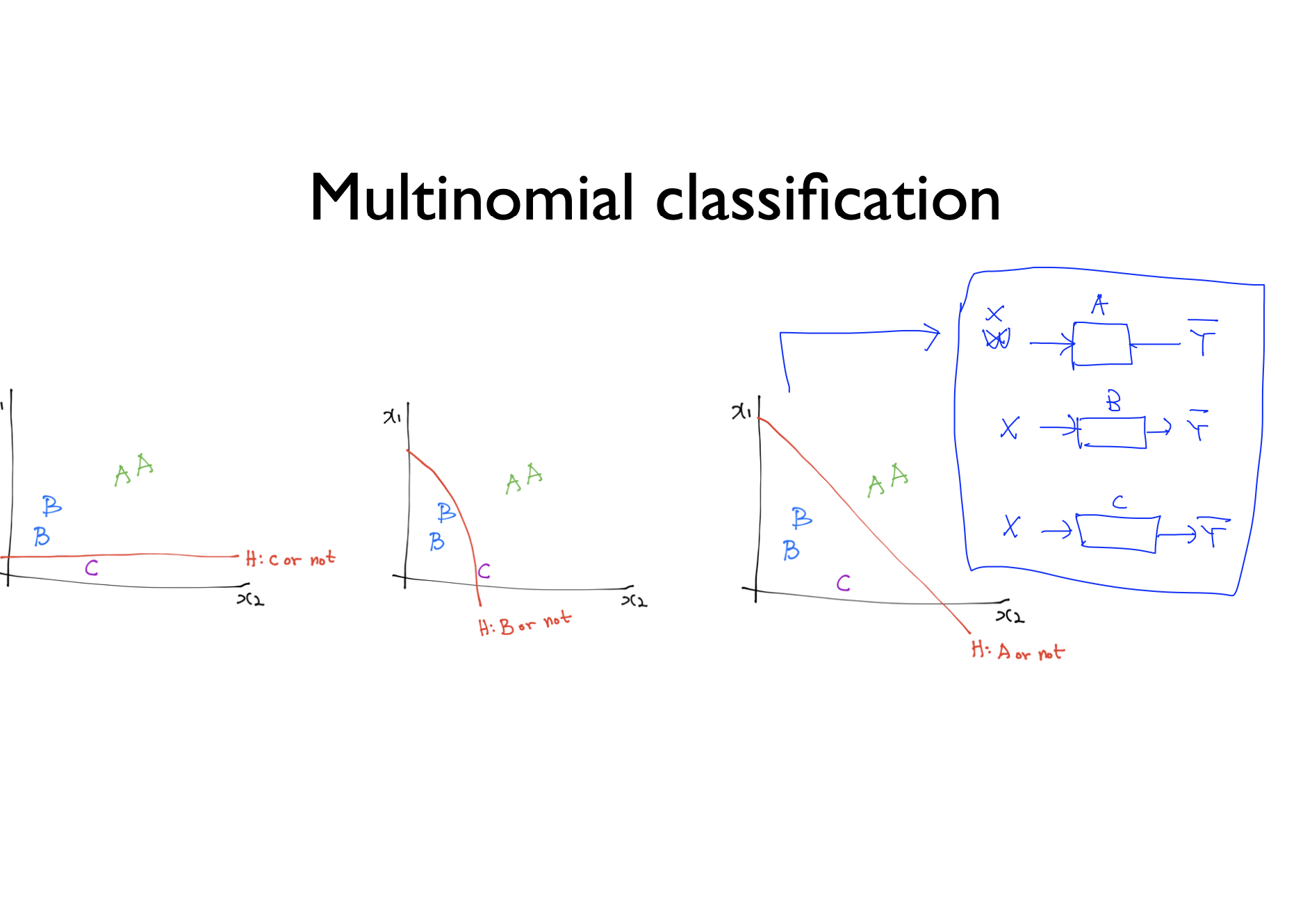

- 이렇게 세가지 경우에 대해 자료가 주어지면 오른쪽 그림과 같이 나타낼 수 있을것이다. 우리는 이것을 3개의 각각 다른 binary classification을 이용해서 구분 지을 수 있다.

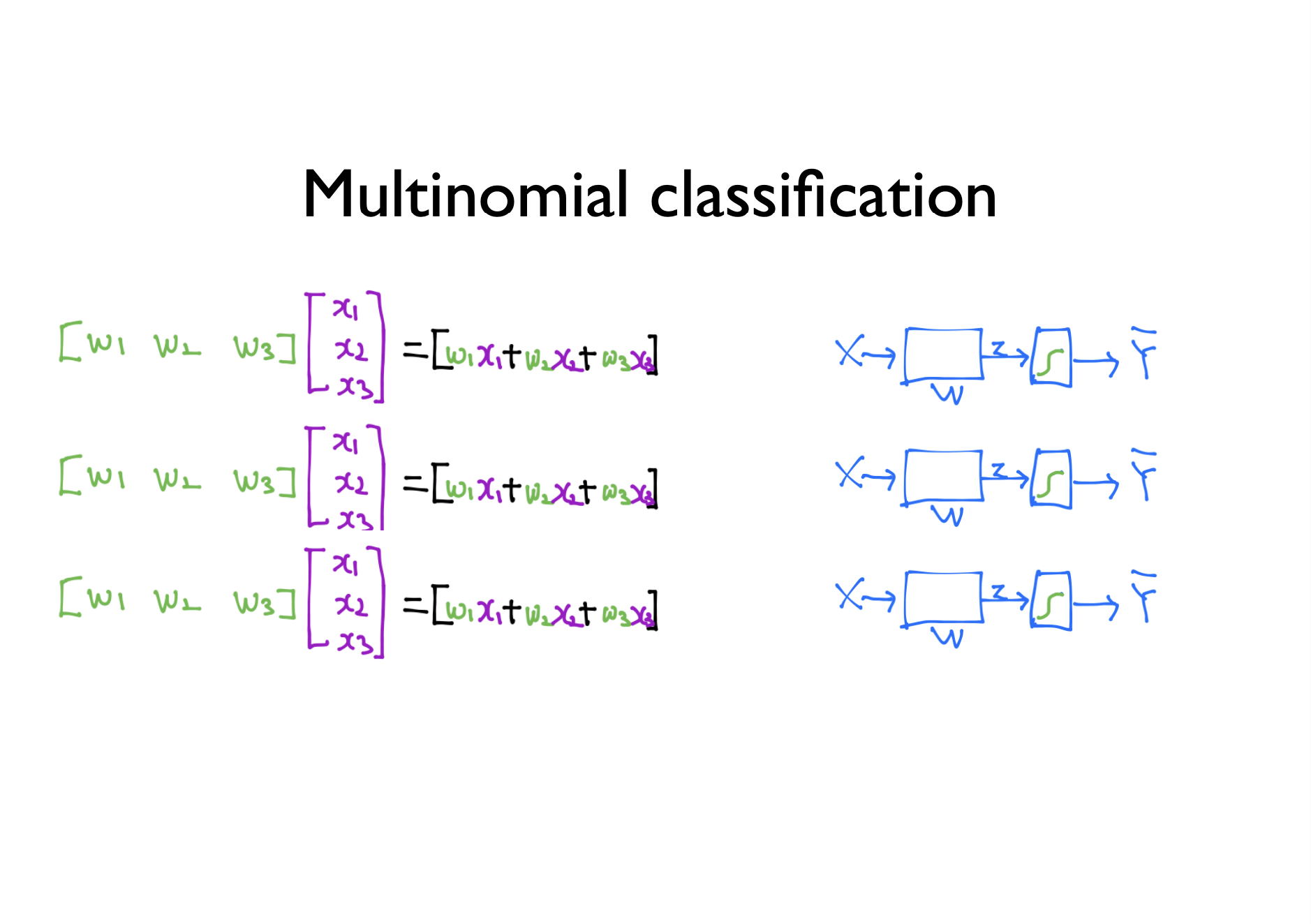

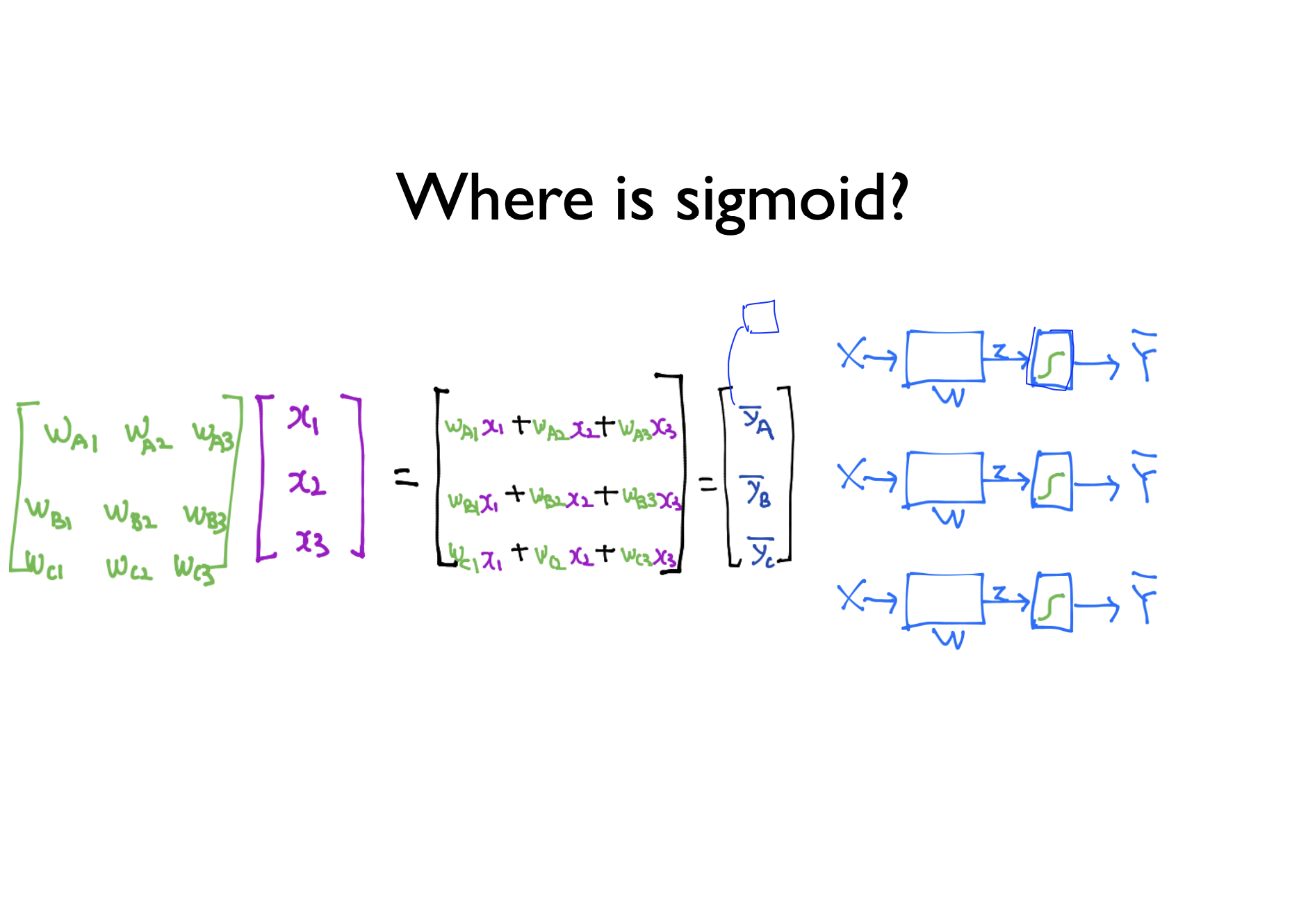

- 여기서 Y는 실제값이고, Y hat은 추정량이다. 이렇게 A인지 아닌지 / B인지 아닌지 / C인지 아닌지를 통해 우리는 multinomial classification을 할 수 있다. 각각의 binary classification은 독립되어있다. 우리는 전 시간에 잠깐 배웠던 것 처럼 이것을 행렬을 이용해서 표현할 수 있다. 행렬을 사용하면 multinomial classification을 좀 더 간단히 구현할 수 있다. 행렬로 식을 구현하면 다음과 같다.

- 행렬로 나타낸 multinomial classification을 정리하여 벡터로 나타내면 두번째 사진과 같이 깔끔하게 정리가 되고 훨씬 알아보기 편하게 변한다.

Lecture 6-2 Softmax classification: softmax and cost function

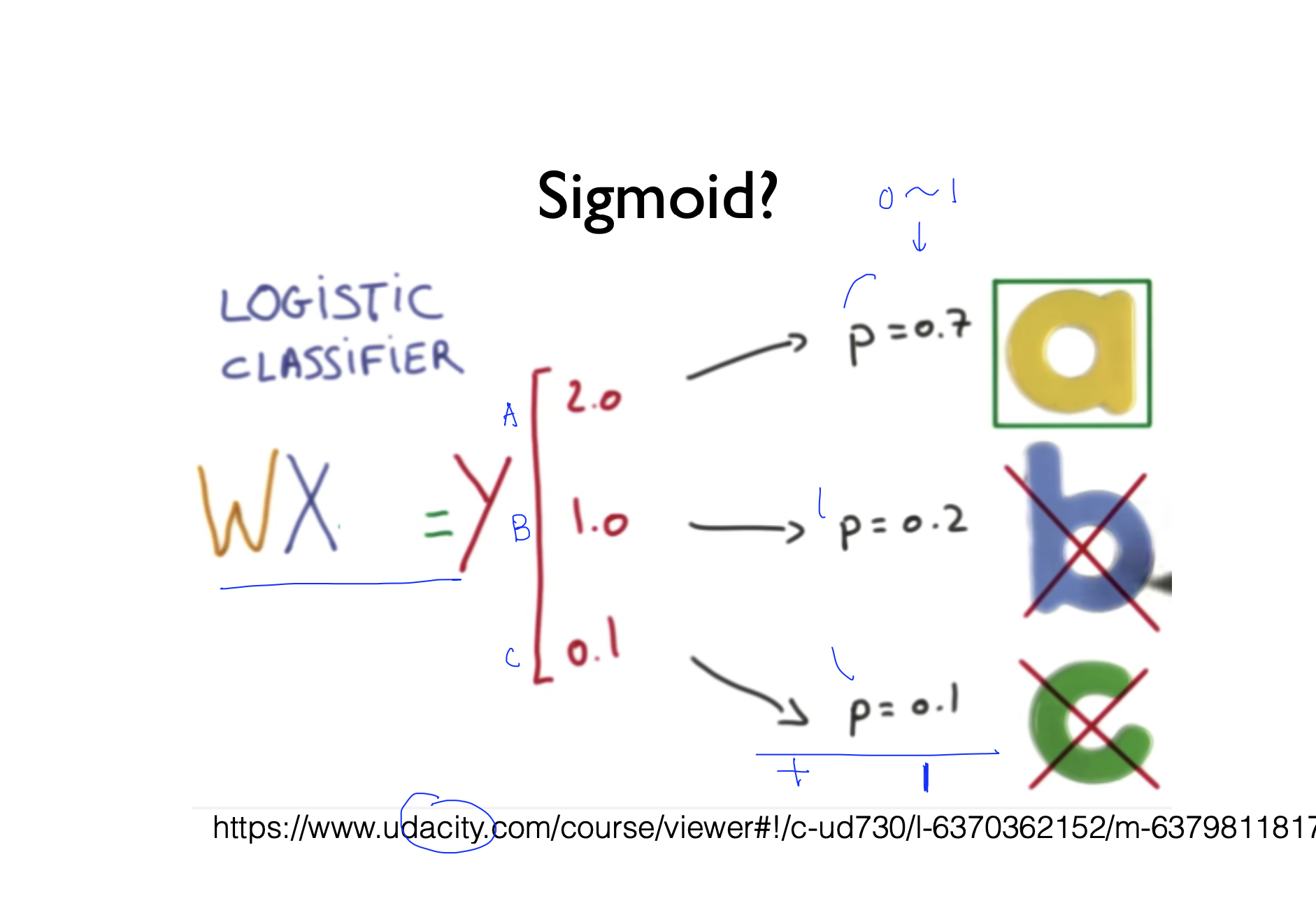

- 6-1 강의에서 배웠던 행렬을 통해 우리는 이제 sigmoid 함수를 찾아야한다.

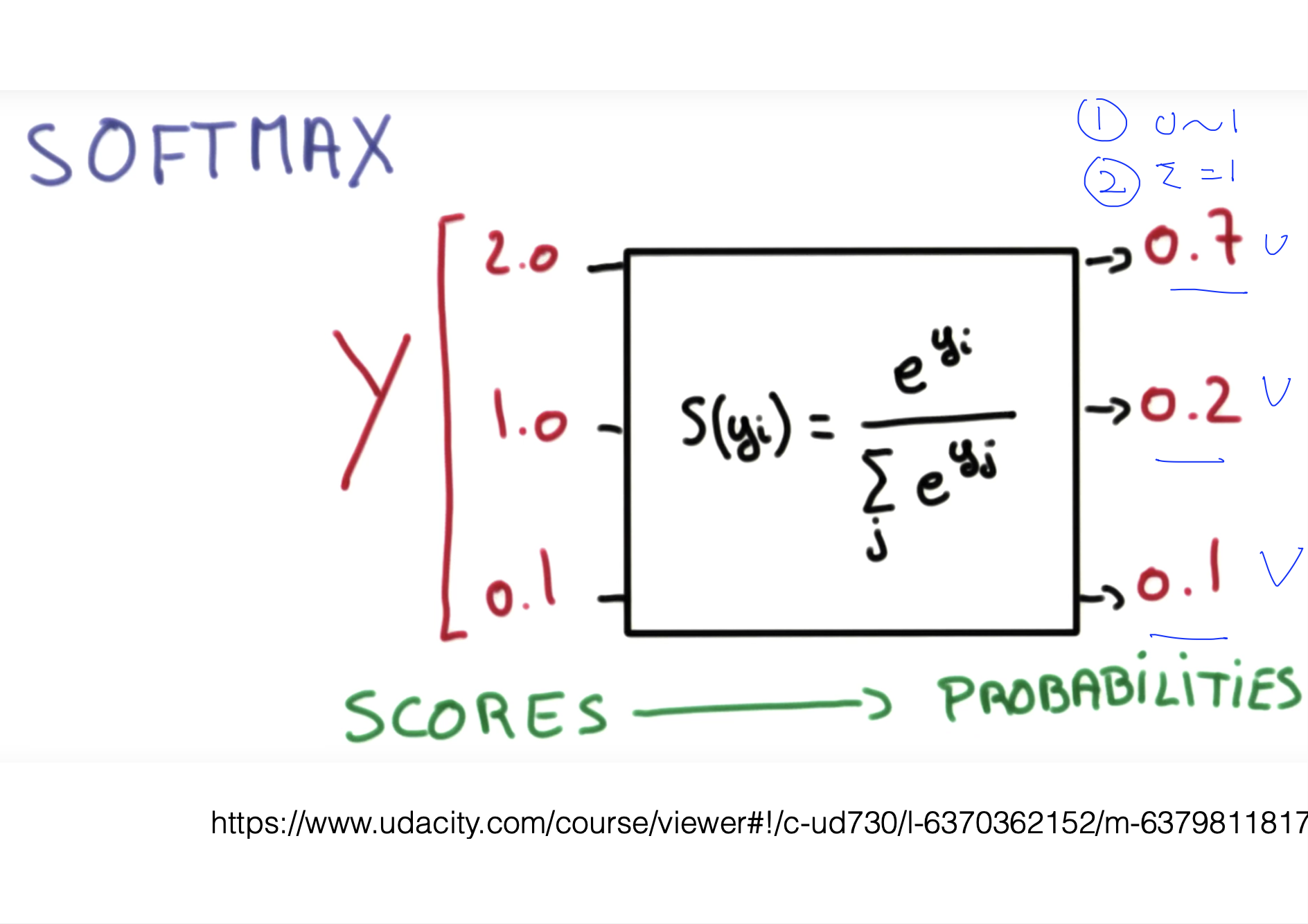

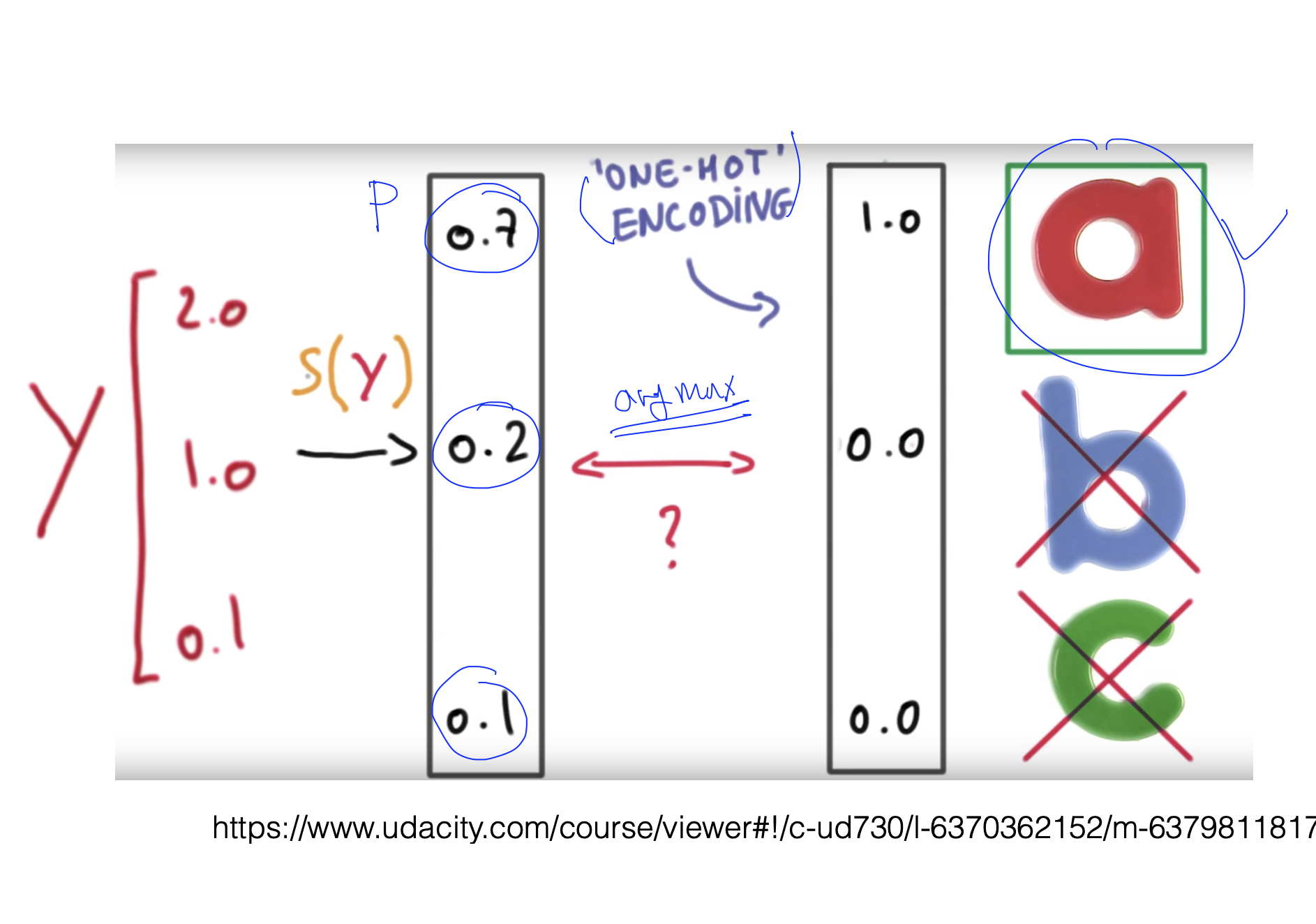

- 우리는 softmax 함수를 사용하면 probabilities를 구할수 있다. 이때 모든 probabilities는 0과 1 사이고, 모든 값들의 probabilities를 더하면 1이 되야 한다. 그리고 우리는 one-hot encoding을 통해 제일 큰 값만 1로 만들어준다.

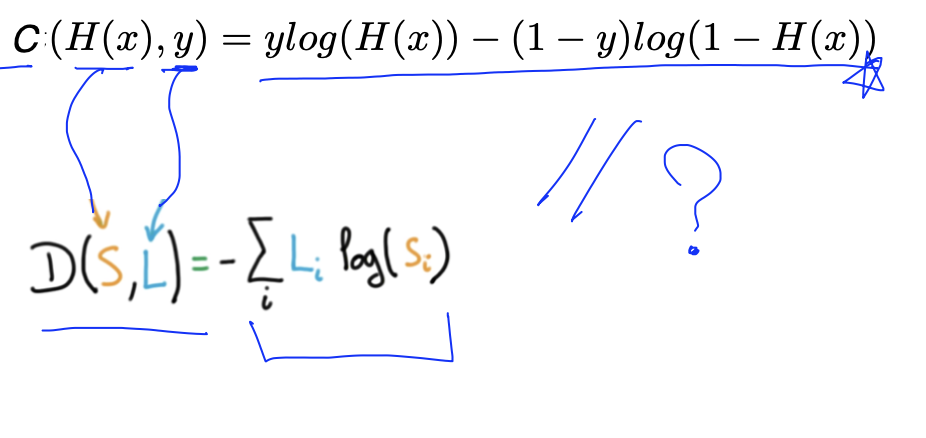

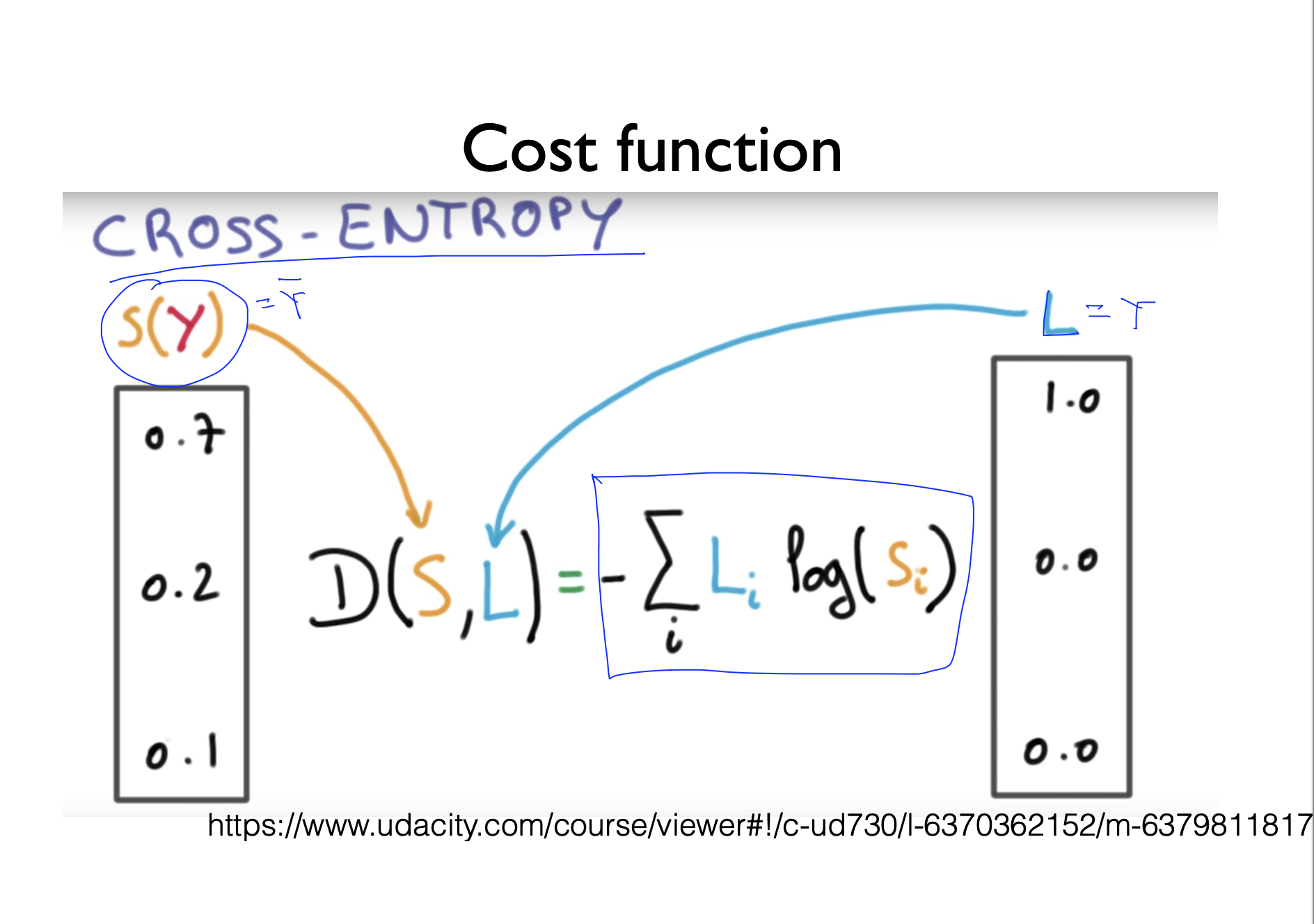

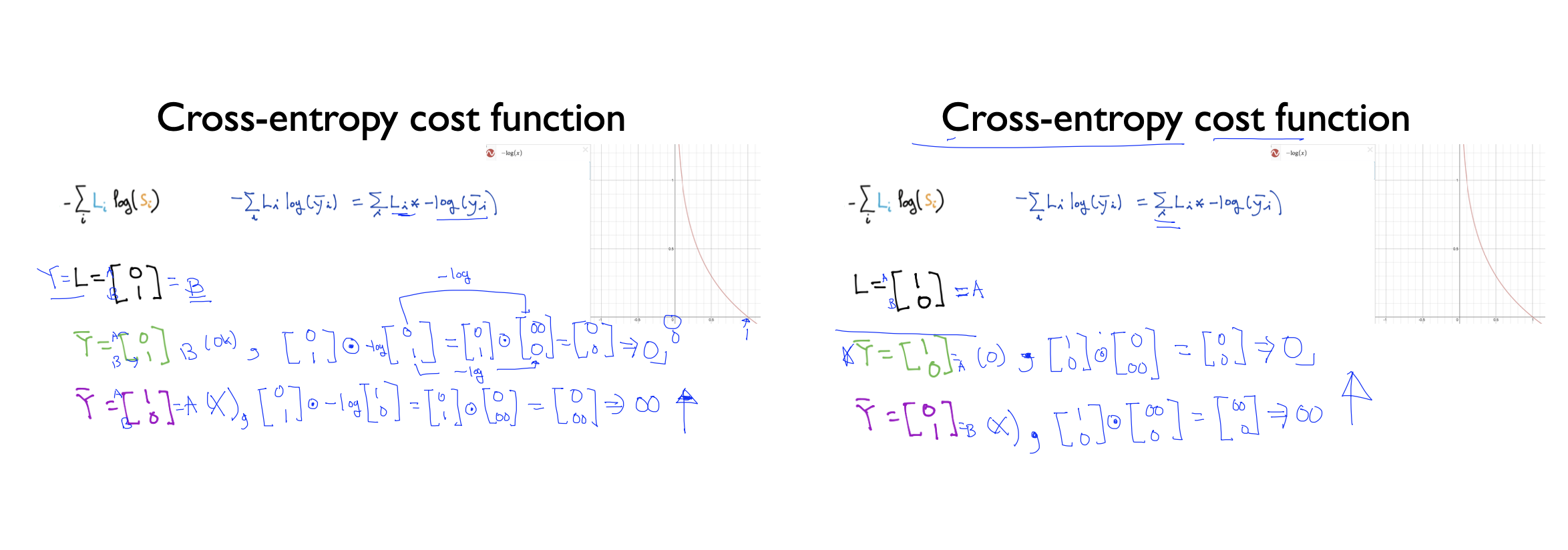

- 그리고 우리는 Cost fuction인 cross-entropy를 찾을 수 있다. 이때 S(y)의 값은 우리가 softmax에 넣어서 예측한 값이고, L은 실제 값이다. 이때 우리는 실제값과 예측이 맞았을 때 예측값이 0이고 예측이 틀리면 무한대가 된다는 것을 확인할 수 있다.

- 또 우리는 Logistic cost와 cross entropy를 비교했을때 결국 둘은 같다는 것을 알수있는데 L은 실제값이기 때문에 항상 0 또는 1의 값을 같는다. 따라서. L2 = 1 - L1이 된다. S는 0과 1사이의 값을 가질 수 있지만 항상 합이 1 이므로 우리는 L1, S1을 이용해서 식을 세우고 정리하면 결국 둘은 같다는 것이 증명된다.