[간단정리]MixCo: Mix-up Contrastive Learning for Visual Representation(Arxiv 2020)

MixCo: Mix-up Contrastive Learning for Visual Representation

- 컴퓨터 비전분야에서 자기지도학습(Self-supervised) 관련 연구는 점점 확대되고 있고, 이 중에선 Contrastive Learning이 가장 대표적으로 쓰이고 있음.

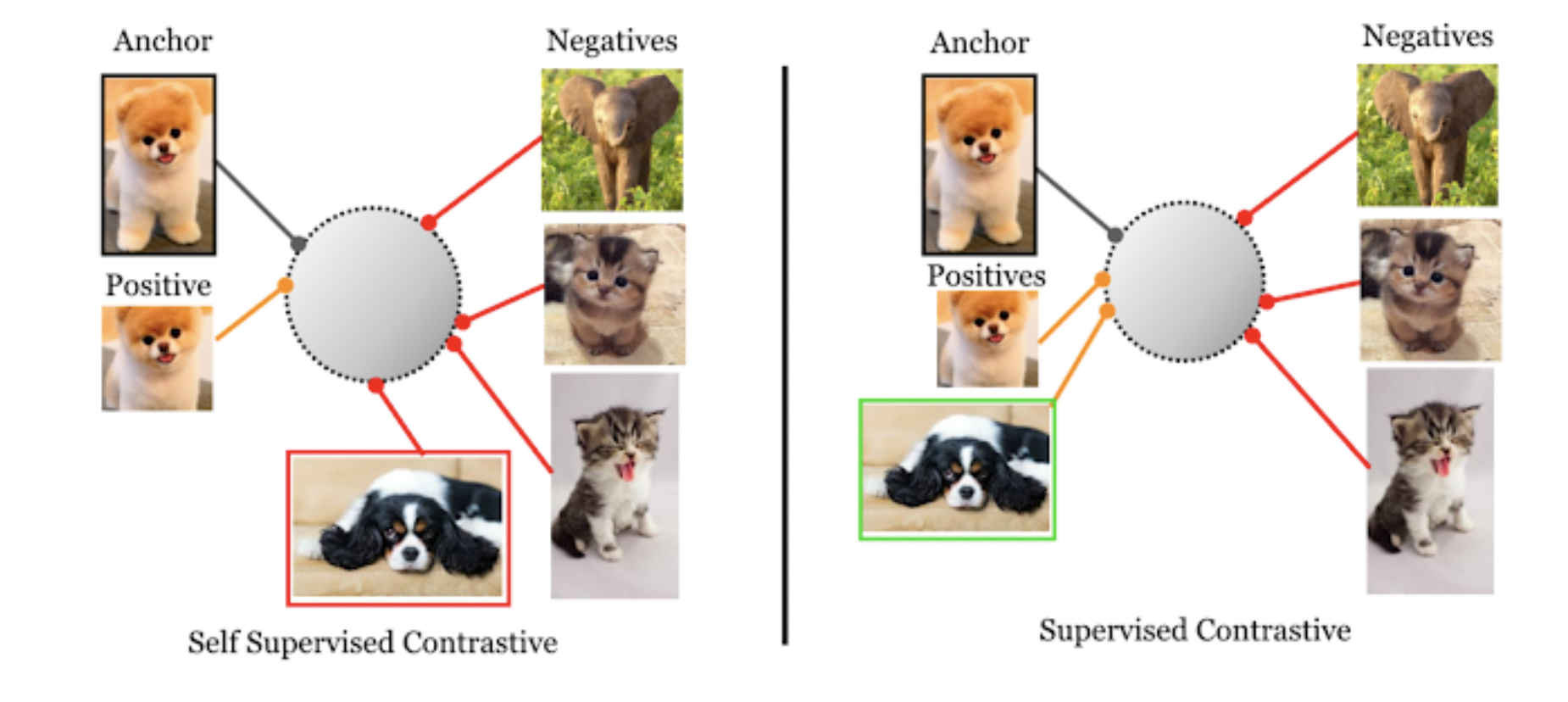

- Contrastive Learning : 같은 샘플은 유사한 representation을 가지게(positive pair), 다른 샘플은 다른 representation을 가지게끔 학습하는 것(negative pair)

- 즉, 클래스 등의 라벨링 없이 instance-level에서 유사도를 기반으로 학습함으로써 양질의 representation을 학습

- 이후에 전이학습 등을 통해 downstream task에서 활용할 수 있다.

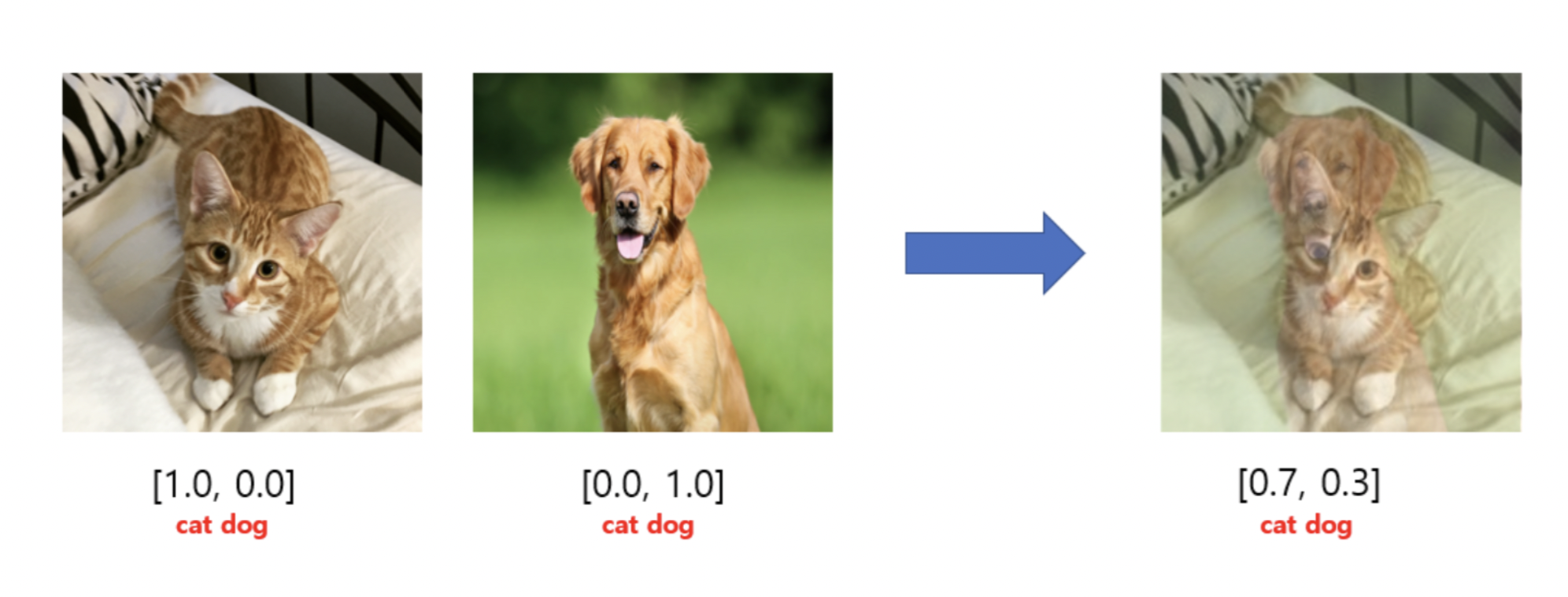

- 이와 동시에, data augmentation(증강)분야에서는 유명한 Mix-up 기법이 존재함

- 이는 두 데이터의 일부를 섞어서 새로 데이터를 만들고, 이를 학습에 사용하는 것

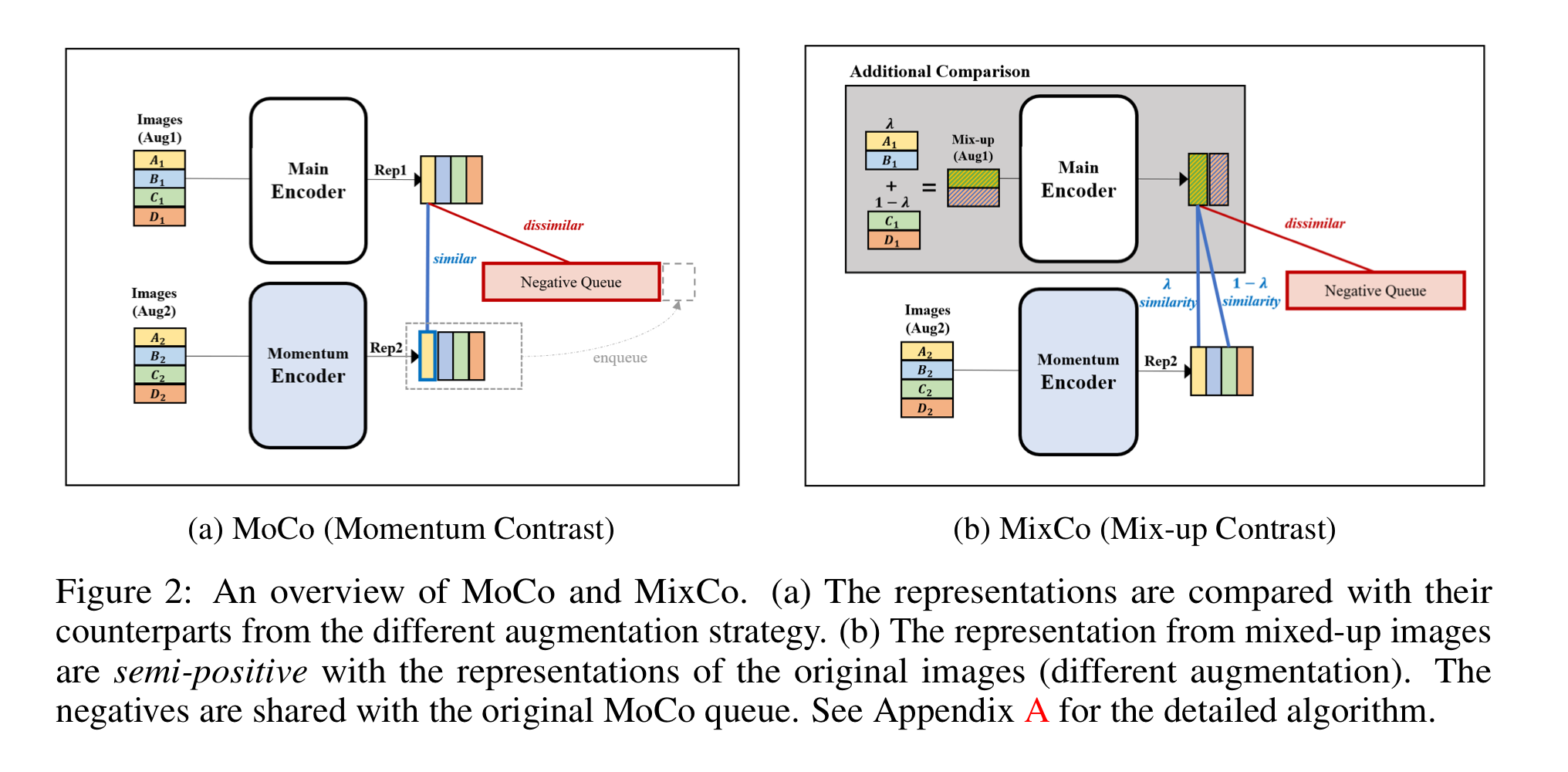

- 본 논문에서는 이 Mix-up을 활용해 semi-positive pair를 만들어 더 섬세하고 풍부한 representation을 학습하는 방법인 Mix-Co 방법을 제안함.

기존의 Contrastive Learning

Mix-up

Mix-co

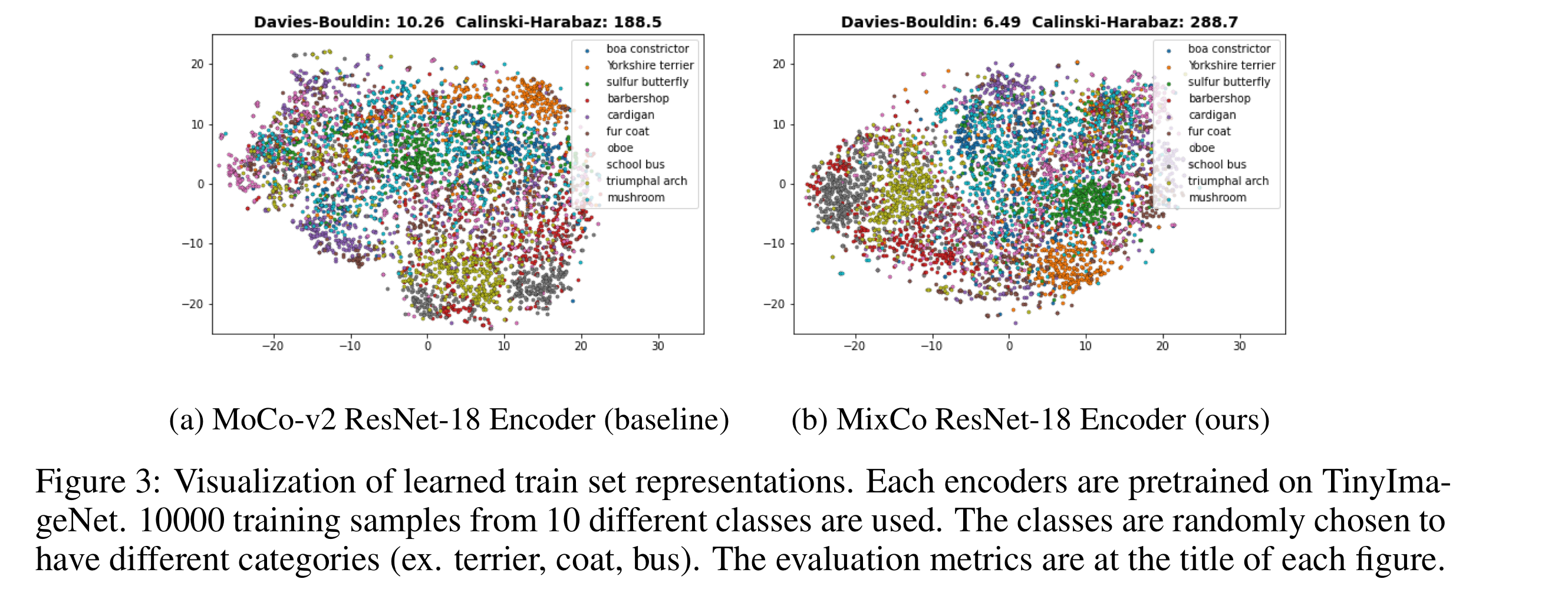

Representation 비교, vs 기존 연구

-

이 방법은 아주 간단히 구현할 수 있고, 다른 방법과 공존 가능하기에 효율적

-

Evaluation은 Linear Classification을 이용해 수행하는데, Self-supervised Learning은 얼마나 좋은 이미지 feature(representation)을 뽑아내느냐에 중점을 두기 때문에, 뒷 부분의 classifier head는 건들지 않고 평가하게됨