[대회 복습] Object Detection - Metric

0

💡 대회 metric vs 내가 사용한 metric

AiStages Object Detection 대회 metric

- 각 category prediction에서 ground truth와 prediction box의 IoU가 0.5 이상인 경우 True

- 각 category의 precision 계산 & 평균 계산

문제점

- Prediction box가 많을수록 score 상승

- Recall 사용 X - Ground truth 중 맞게 prediction한 개수를 알 수 없음

추가적으로 사용한 metric

- 대회에서 사용한 precision과 동일

- Recall 사용

- True Positive 증가 & False Positive 감소가 목표

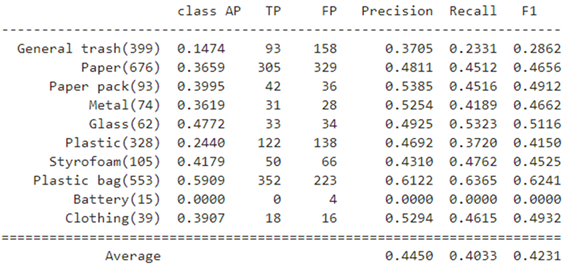

Class AP

- Category 별로 Average Precision 계산

IoU

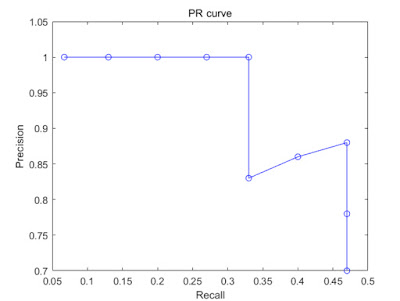

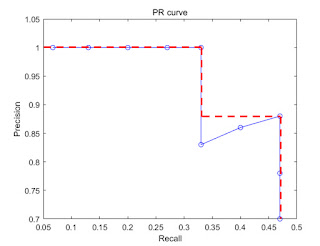

PR Curve

- Confidence score 기준 내림차순

- 누적 TP / 누적 FP 계산

- 각 prediction 순으로 precision, recall 계산

AP - PR Curve 아래 면적

Precision & Recall & F1-score

Precision

Recall

Macro-Average F1-score

Summary

Competition metric

- 각 category의 precision 계산 & 평균 계산

- 문제점: Prediction box가 많을수록 score 상승하는 경향성

Defined metric

- True Positive 증가 & False Positive 감소가 목표

- 무분별한 bounding box 생성 예방

- 해당 class의 Bounding box를 제대로 잡아내는가에 대한 비교에 사용