저번 시간에, NLP 자연어처리 분야에는 크게 NLU와 NLG로 나눠진다는 개념을 살펴보았다. NLG라는 Natural Language Generation에 관심이 많기에 자연어를 생성하고 이를 문법적으로 보좌할 수 있는 NLU의 Linguistic Acceptability(언어적 용인 가능성) Task에 대해 알아보려 한다!

Linguistic Acceptability

문장을 줬을 때 이 문장이 문법적으로 자연스러운 문장인지 아닌지 판별하는 NLU의 한 Task이다. 기계가 사람 언어의 패턴을 학습해서 새롭게 들어오는 문장의 문법적 용인성을 판단한다. 문법 검사, 자동 문법 교정에 사용될 수 있다.

CoLA

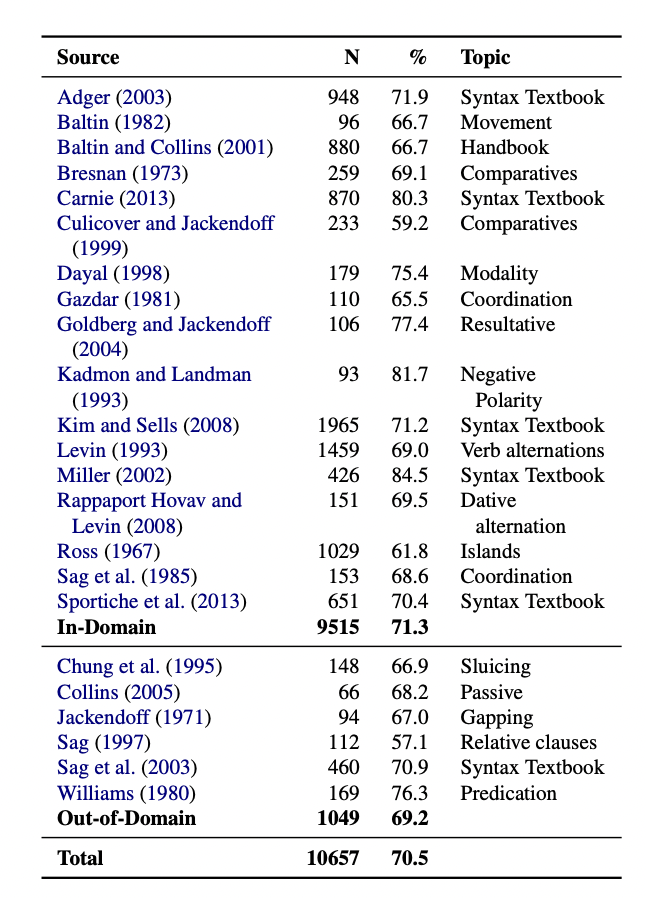

가장 대표적인 Dataset 은 CoLA(Corpus of Linguistic Acceptability)이다. 23개의 언어학 출판물에서 발췌한 10,657개의 문장으로 이루어져 있다. 모든 문장은 저자가 전문적으로 수용 가능한 문법성 주석이 달아져 있다.

N: 자료 문장수

%: 데이터로서 유효하다고 판단한 문장 비율

In-Domain 자료: train, dev, test set에 포함

Out-of-Domain 자료: dev, test set에만 포함

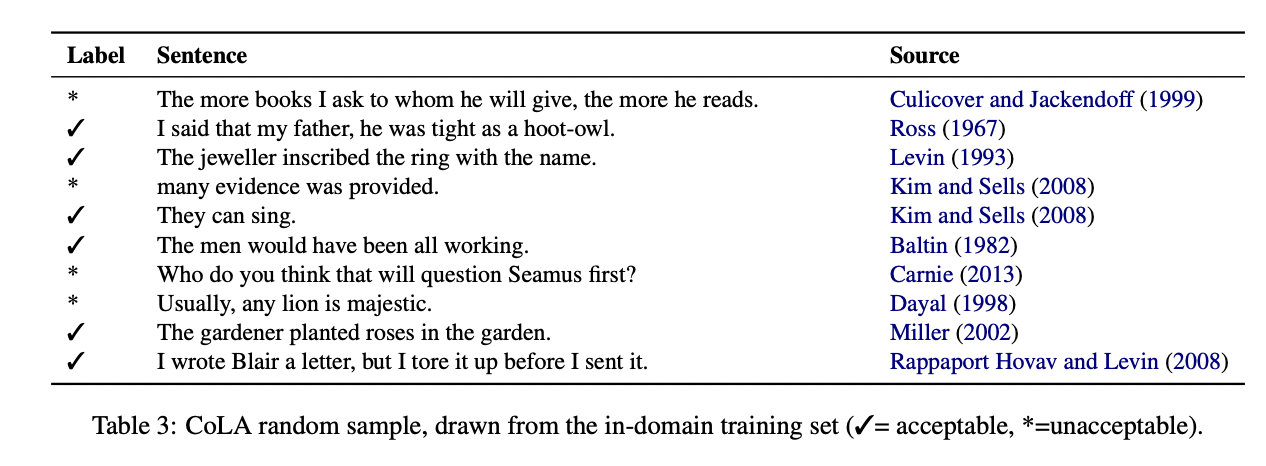

문장과 출처 그리고 라벨로 이루어져 있다. 출처에서 뽑은 문장이 문법적으로 수용 가능한지 불가능한지를 판단해 라벨로 부착되어 있다.

Linguistic Acceptability Task의 SOTA model은 EFL,FNet-Large가 있다.

EFL

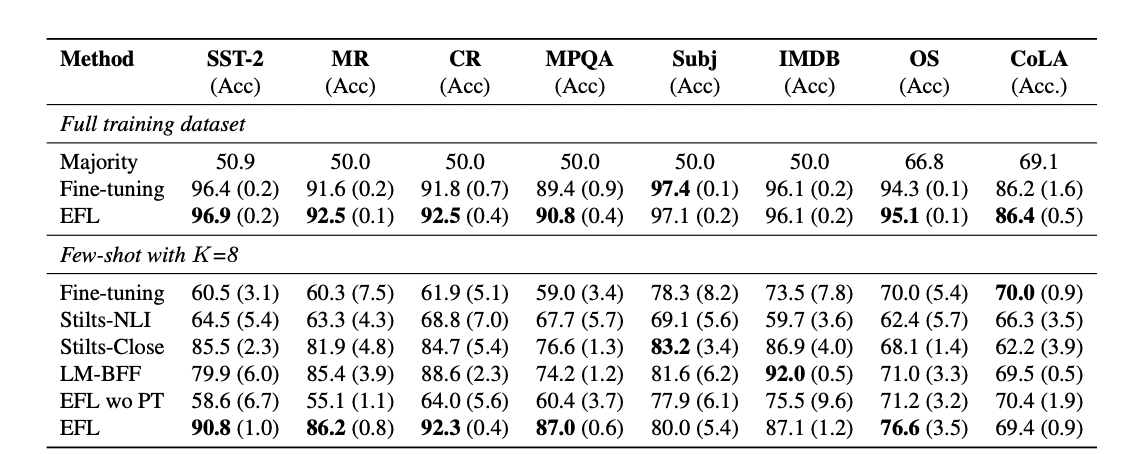

EFL(Entailment as Few-Shot Learner)은 NLP에 Few-Shot Learning을 적용한 모델이다. Pretrained된 모델을 사용하여 새로운 데이터를 잘 학습할 기반 모델을 만들고 8개의 샘플데이터와 같이 작은 데이터에 Fine-Tuning 한다.

EFL을 적용한 모델이 Fine-tuning, Stilts-NLI 등보다 대체로 더 좋은 결과를 보여준다.

FNet-Large

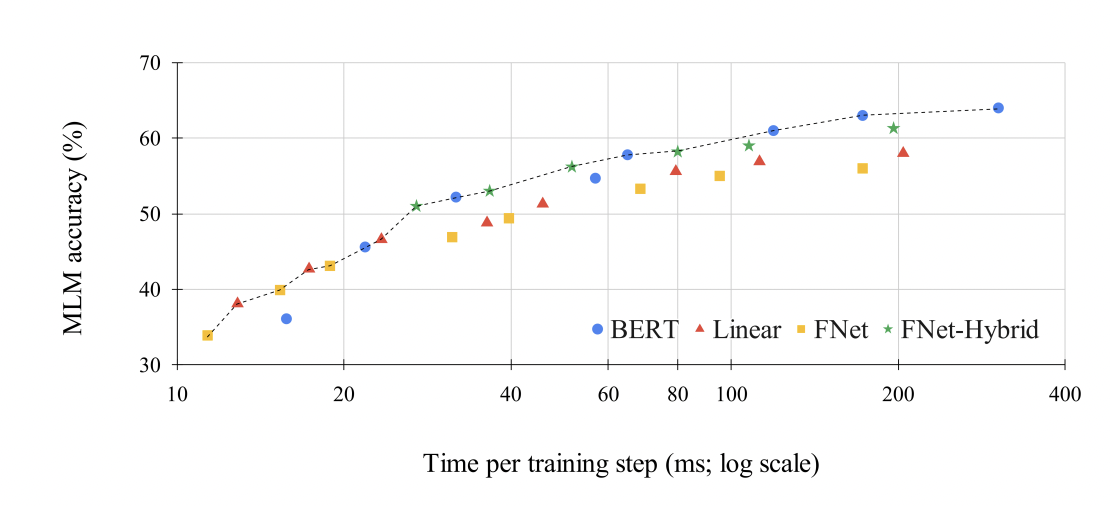

Self-Attention 서브 레이어들의 input 토큰을 '섞어주는' 간단한 선형 변형만으로 Transformer 인코더 아키텍처가 더 빠르게 작동할 수 있다. 이러한 선형 변환으로 여러 텍스트 분류 문제에서 의미론적 관계를 파악하는 데에 더 좋은 성능을 보인다.

비교적 가벼운 모델인 FNet과 Linear은 x축이 10-40 사이일 때 높은 정확도를 보이고, 무거운 모델일수록 40 이상 일 때 더 높은 정확도를 보인다.

NLG를 활용하여 새로운 문장을 자동으로 생성한다면 앞에 위치한 단어 형태소와 뒤에 위치한 형태소가 문법적으로 맞지 않는 현상이 발생할 수 있다. 이러한 Generation 문법적 이슈를 해결하기 위해 NLU의 Linguistic Acceptability Task를 응용해서 보완할 수 있겠다.

참고자료

쉽게 이해할 수 있게 개념 정리 해주셔서 감사합니다. 해당 분야가 실제 업무에서 어떻게 활용될 지 고민해 보는것도 좋을거 같아요!