1️⃣ 개념

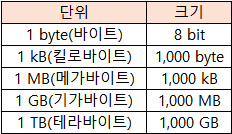

-컴퓨터가 표현하는 정보 단위 : 0 & 1

-n 비트는 2^n 가지 정보 표현

word(워드)

CPU가 한번에 처리할 수 있는 데이터 크기

half word > 절반 , full word > 1배 , double word > 2배

c.f. x64 CPU : word 크기가 64

2️⃣ 2진법, 10진법

1) 2진법 (binary)

-0과 1만으로 변환

2) 10진법 (decimal)

-0~9 로 이루어짐

-표기법

10(10) = 1000(2) = 0b10003) 2의 보수(two's complement)

-음수로 된 숫자 변환

-flag(플래그)를 통해, 양수인지 음수인지 구분

-표기법

2진법 계산 < 0,1 변환 < +1

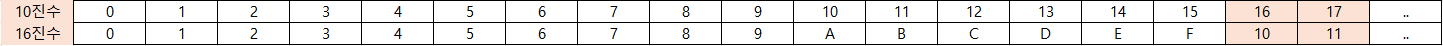

-5 = 1000 < 0111 < 01124) 16진법

-15를 넘어가는 시점에 자리 올림하는 숫자 방식

-코드상 애용

-표기법

15(10) = F(16) = 0xF

17(10) = 11(16) = 0x115) 활용

(1) 16진법 > 2진법

-숫자를 네자리에 맞춰 계산

1A2B(16) = 0001+1010+0010+1011(2)(2) 2진법 > 16진법 : 간단하게 표기하기 위함

-네개씩 끊고, 숫자를 16진수로 변환

11010101(2) = D+5(16)3️⃣ Character set(문자 집합)

-컴퓨터가 인식하고 표현할 수 있는 문자의 모음

4️⃣ Encoding(인코딩)

-컴퓨터가 이해할 수 있는 숫자(0,1)로 변환 과정

5️⃣ Decoding(디코딩)

-0과 1로 이루어진 숫자를 사람이 이해할 수 있도록 하는 문자로 변환 과정

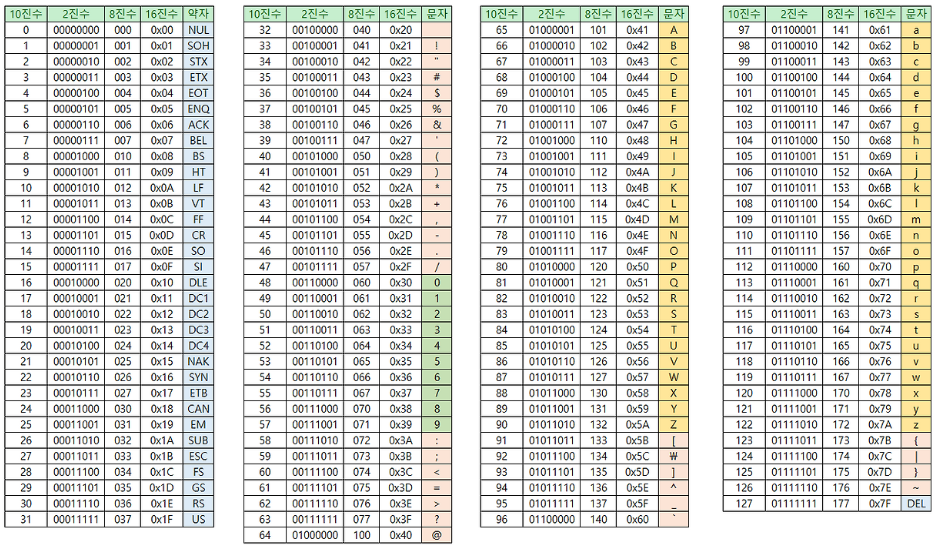

6️⃣ ASCII(아스키) code

-2^7 = 128개

-영어+아라비아숫자+일부 특수문자

-2진수로 표현함으로 아스키 문자를 0,1로 표현할 수 있음

=> ASCII code : 인코딩 가능

code point(코드 포인트)

문자 인코딩에서 '글자에 부여된 고유한 값'

6-1) 확장 아스키 코드

-2^8=256개

-모든 문자를 표현하기에는 턱없이 부족함

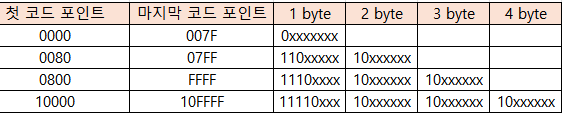

7️⃣ UTF-8 (Unicode Transformation Format)

-유니코드에서 통일된 문자 집합(다양한 나라 언어+이모티콘)

-유니코드 인코딩하는 방식 (1-4byte 형식)