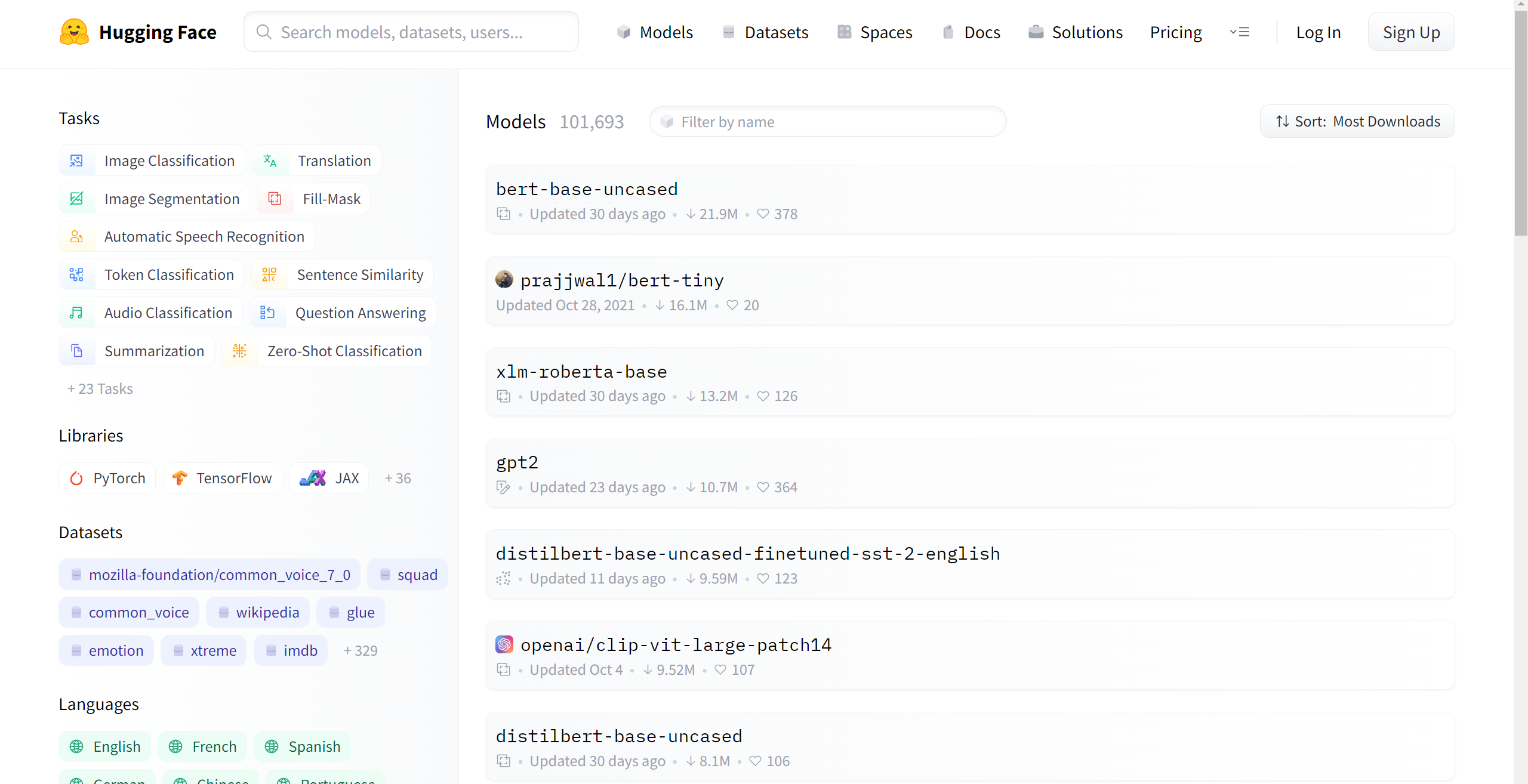

모르는 언어를 학습시킬 때 Huggingface의 모델 허브를 참고해서 데이터셋, 라이브러리, 음성 인식 단위, 가볍게 훈련시켰을 때의 성능 등을 파악해두면 이후 그 언어 관련 최신 논문들을 읽을 때에도 수월하다. 일종의 사전조사.

일본어의 경우, 유저들이 학습 시 사용하는 기본 세팅은 아래와 같다.

- 데이터셋

CommonVoice JP

JSUT

JVS

JSSS

CSS10

TEDxJP - 훈련단위

히라가나 x 2 (파싱 / 원본)

한자어 x 2 (파싱 / 원본) - 파싱, 한자 라이브러리

Mecab

pykakasi

jaconv

romkan

kytea

일본어 ASR 논문에서 사용하는 벤치마크 데이터셋은 CSJ 이지만, 유료 코퍼스라 훈련할 때 대부분 위의 데이터셋을 사용한다. (다행히 나는 있다) 또 CSJ엔 띄어쓰기 정보가 제공되지만, 일본어는 원래도 띄어쓰기가 없는 언어이기 때문에 대부분의 코퍼스에는 없다. 따라서 WER을 구해야 되는 상황이라면 강제로 파싱 라이브러리를 써야 한다.

아래는 CommonVoice JP test set에 대해 모델 카드들을 성능평가/디코딩해본 예시. 한자어, 띄어쓰기 등에 따라 여러가지 디코딩 형태가 보이고, 로마자로 변환하여 학습한 경우도 눈에 띈다. 전처리를 제대로 하지 않아 특수기호가 포함된 경우도 있다. 유저들이 올려놓은 체크포인트를 보면 대충 이 정도의 성능은 찍겠구나 하는 게 보인다. 물론 간단한 공부용으로 올려놓은 모델이 많기 때문에, 실제로 모델을 직접 만들면 이보다는 더 좋은 성능이 나온다.

- vumichien/wav2vec2-large-xlsr-japanese-hiragana (WER: 25.778030%

CER: 11.402665%)

Prd: きむら さん に でんわ お か し て もらい まし た

Ref: きむら さん に でんわ を かし て もらい まし た

Prd: きのう は はき じかん ね まし た

Ref: きのう は はち じかん ね まし た - vumichien/wav2vec2-xls-r-300m-japanese-large-ver2 (WER: 7.062669%

CER: 3.026973%)

Prd: きむら さん に でんわ を かし て もらい まし た

Ref: きむら さん に でんわ を かし て もらい まし た

Prd: きのう は はち じかん ね まし た

Ref: きのう は はち じかん ね まし た - AndrewMcDowell/wav2vec2-xls-r-300m-japanese (WER: 143.512658%

CER: 29.867257%)

Prd: きむらさんにでんわおかひてもらえまにた

Ref: きむらさんにでんわをかしてもらいました

Prd: きのうははきじかんねまにた。 。

Ref: きのうははちじかんねました - vumichien/wav2vec2-large-xlsr-japanese (WER: 30.964900%

CER: 17.881148%)

Prd: 木村 さん に 電話 を か し て もらい まし た

Ref: 木村 さん に 電話 を 貸し て もらい まし た

Prd: きのう は 朝 時間 寝 まし た

Ref: きのう は 八 時間 寝 まし た - NTQAI/wav2vec2-large-japanese (WER: 72.468354%

CER: 18.264322%)

Prd: 木村さんに電話を貸してもらいました

Ref: 木村さんに電話を貸してもらいました

Prd: きのうは八時間寝ました

Ref: きのうは八時間寝ました - pinot/wav2vec2-large-xls-r-300m-japanese-colab (WER: 99.050633%

CER: 15.091503%)

Prd: kimurasan'nidenwaogahitemoraimahitaa

Ref: kimurasan'nidenwaokashitemoraimashita

Prd: kino-wahajijikan'nemahitaa

Ref: kino-wahachijikan'nemashita

이상으로 허깅페이스의 모델 카드를 사용하여 사전조사하는 법을 정리해보았다. 사실 나는 일본어를 할 줄 알지만 아마 몰랐어도 바로 논문으로 시작하기보다는 이렇게 접근했을 것 같다. 그러나 대상이 다국어 음성인식이라 언어도 많고 따라서 시간도 없으면 논문 리뷰하고 쓸 시간도 부족하기 때문에 이마저도 스킵할 수도..

참고사이트:

1. https://huggingface.co/models

2. 그리고 각 모델 카드