Weight Regularization

- 핵심: 딥러닝 모델의 과적합 방지

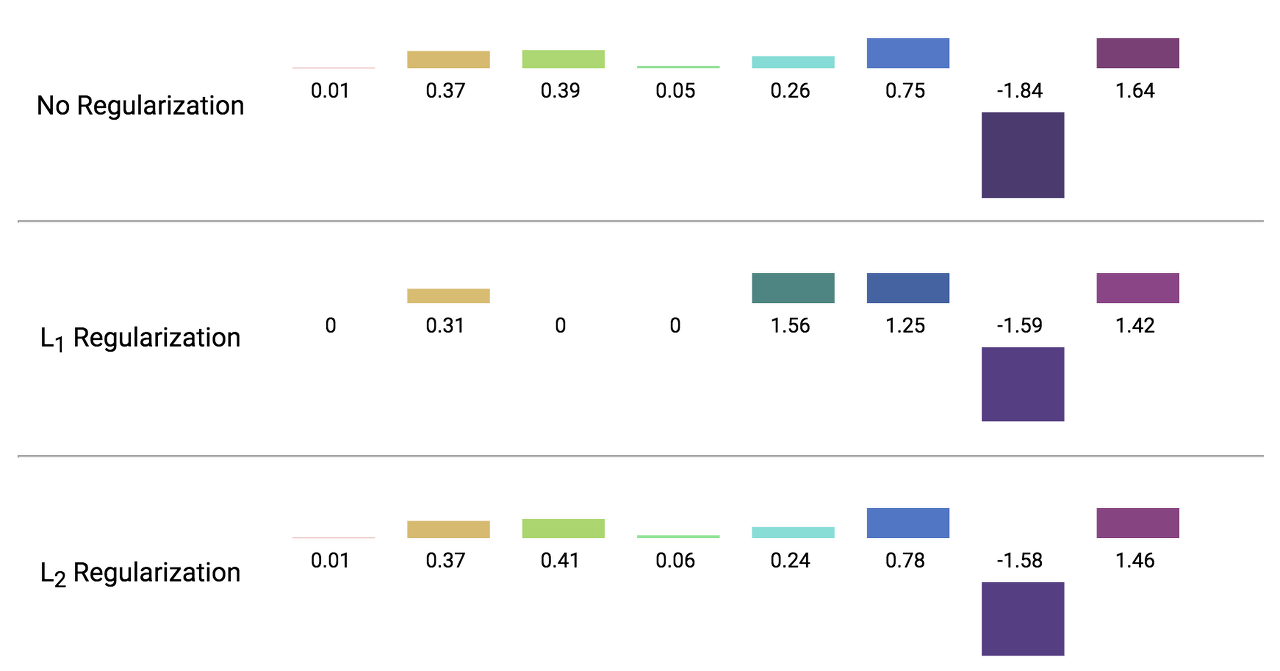

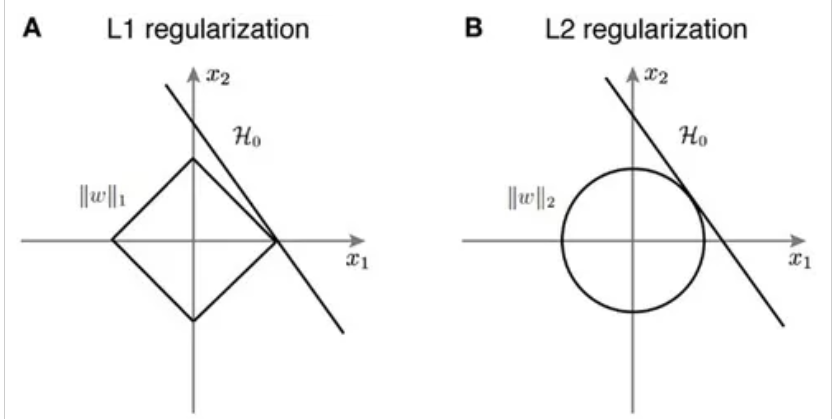

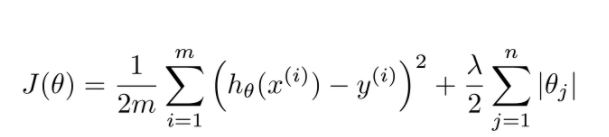

L1 regularization(Lasso)

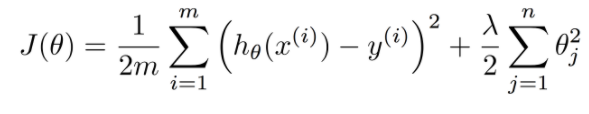

- 수식

- 비용함수

-

cost function + 가중치 크기 => 가중치가 너무 크지 않은 방향으로 학습

-

학습률이 상수가 0에 가까울 수록 정규화 효과가 사라짐

-

가중치 절댓값을 더해줌

-

w: 편미분 시 상수값이 되어버리고 부호에 따라 +-가 결정됨.

-

가중치가 너무 작은 경우는 weight = 0이된다.(일부 항의 계수를 0으로 만든다)

- 효과: 중요 가중치만 남게 됨(= 핵심 feature만 남게 됨)

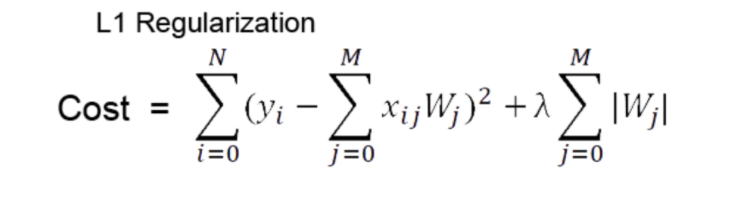

L2 regularization(Ridge)

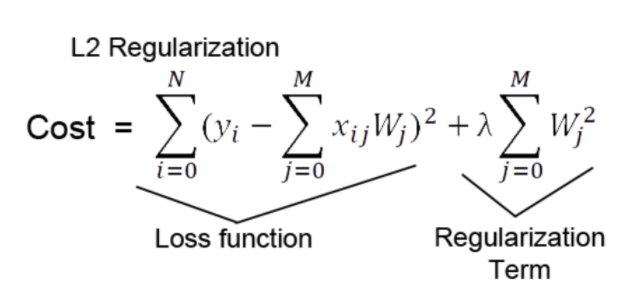

- 수식

- 비용 함수

-

제곱한 가중치를 더한다

-

가중치 줄이기: 편미분 + back propagation(일정 비율로)

-

이상치 방지한다.(이상치에 예민함)

-

Weight decay : 가중치의 제곱을 포함하여 너무 크지 않은 방향으로 학습 시키기

-

일부 항을 0으로 만들지 않고 전체 w의 값을 완만하게한다.

-

효과: 전체적으로 W값이 작아지게 한다.

Regularization 비교