논문 링크 : 링크텍스트

코드 링크: 링크텍스트

배치 정규화(Batch Normalization)

Summary

-

장점

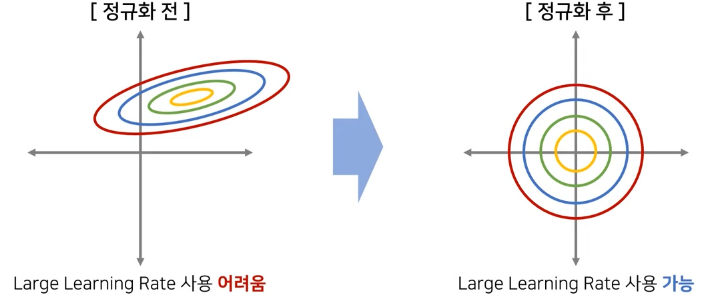

i) 학습속도(training speed)를 빠르게 한다

ii) 가중치 초기화에 대한 민감도 감소

iii) 모델의 일반화 효과 있다.

-

관련 연구

-

입력 정규화(Normalization) : 학습 속도 개선

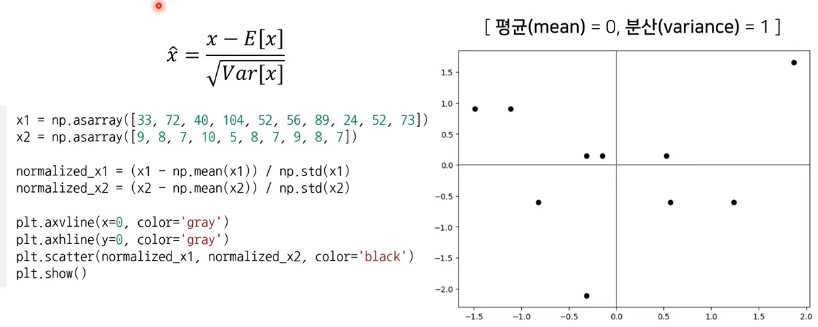

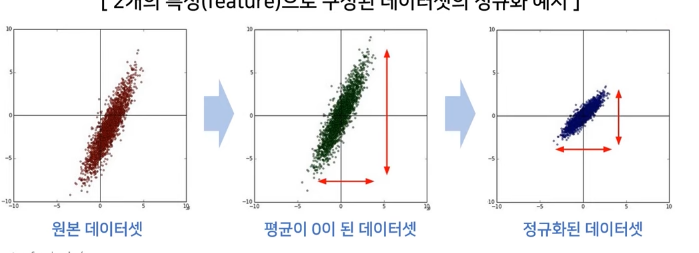

- 입력 표준화(Standardization): 입력 데이터를 N(0,1)분포를 따르는 표준화

-

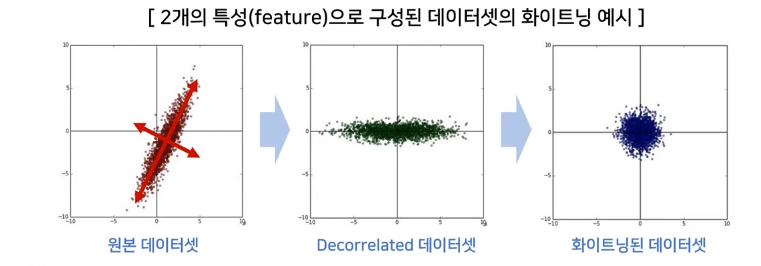

입력 정규화(Normailzation) VS 화이트닝(Whitening)

-

입력 정규화를 통해 각 차원의 데이터가 동일반 범위 내의 값 가지게 함

-

각각 평균만큼 빼고 특정 범위의 값으로 조절

-

화이트닝은 평균이 0, 공분산이 단위 행렬인 정규분포 형태로 변환

- PCA나 화이트닝보다는 정규화가 많이 사용됨.

-

-

-

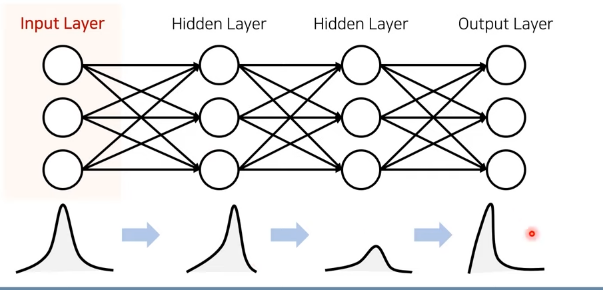

각 레이어에 대한 입력 분포

-

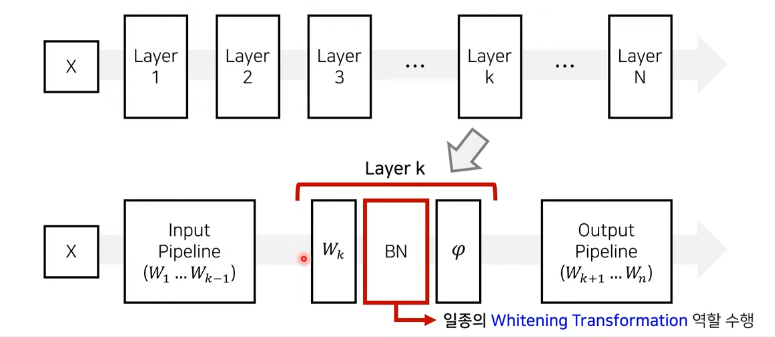

배치 정규화

-

입력(input)

-

A mini-batch: Batch={x1,x2,...,xm}

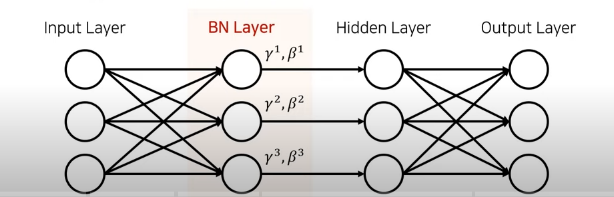

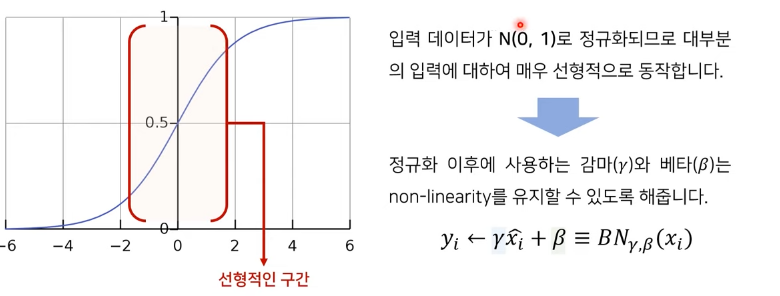

- Parameters to be learned:r,B(감마,베타),실질적 연산을 함

-

-

출력(Output)

- yi=BNr,B(xi)

-

특징: 레이어의 입력차원이 k일 때, 학습할 두 개의 파라미터도 k차원 가짐

-

1. 입력 레이어 정규화

2. How to Hidden layer- 배치 정규화 적용(도식화)

-

레어이 입력을 정규화할 때 유의사항

- 특징: 레이어를 단순히 N(0,1)로 정규화시 비선형 활성함수의 영향력 감소시킴

-

배치 정규화의 성능향상

- 성능효과는 너무 좋음(학습을 위한 파라미터 설정이 편하고 , 학습이 빠르게 수행)

-

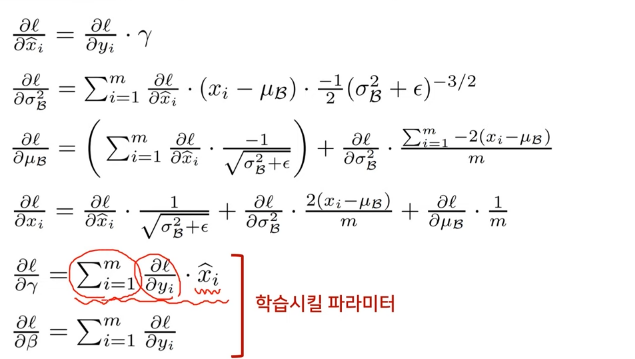

배치 정규화 파라미터 미분 후 계산기 계산

-

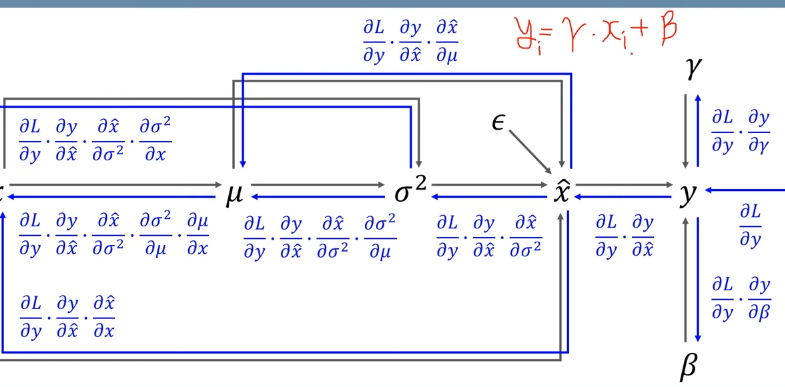

데이터 플로우 그래프

-

기울기 계산

-

- 배치 정규화의 학습 및 추론