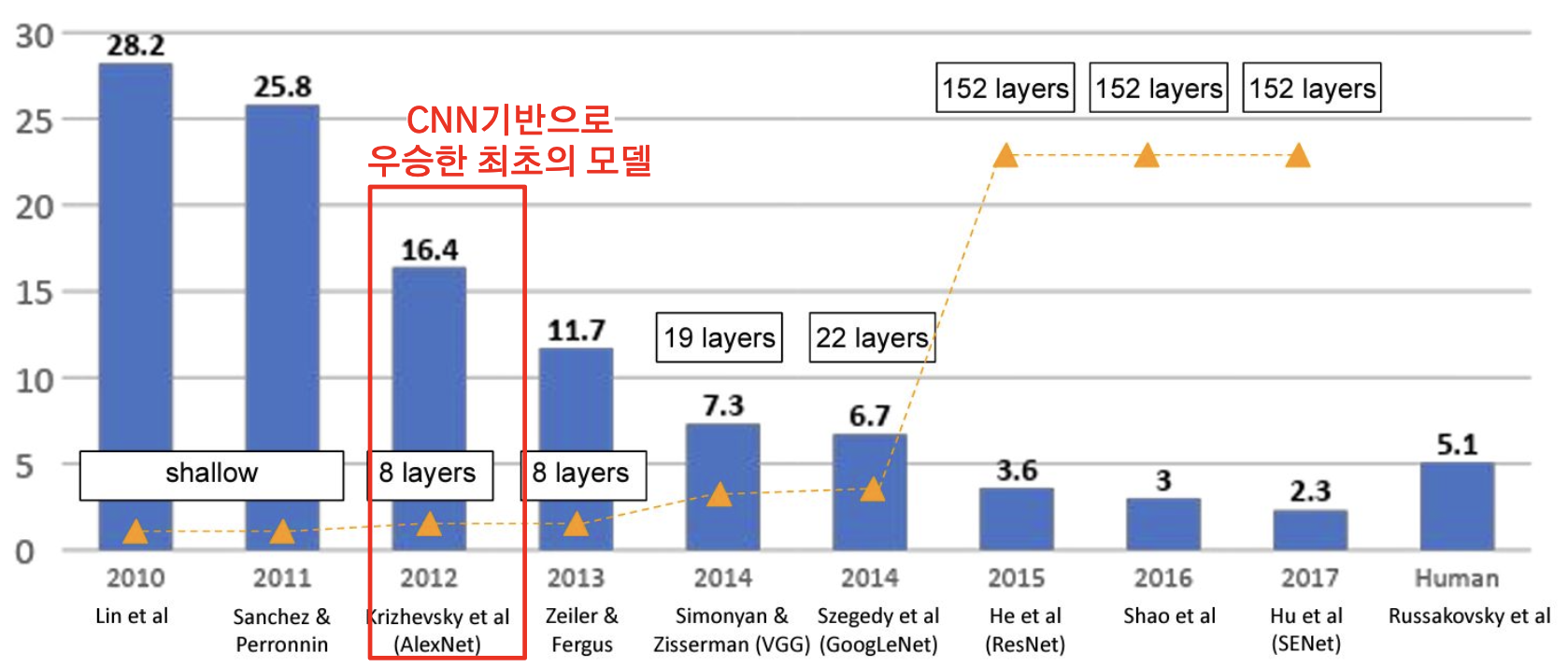

딥러닝 모델의 등장

ImageNet Large Scale Visual Recognition Challenge winners

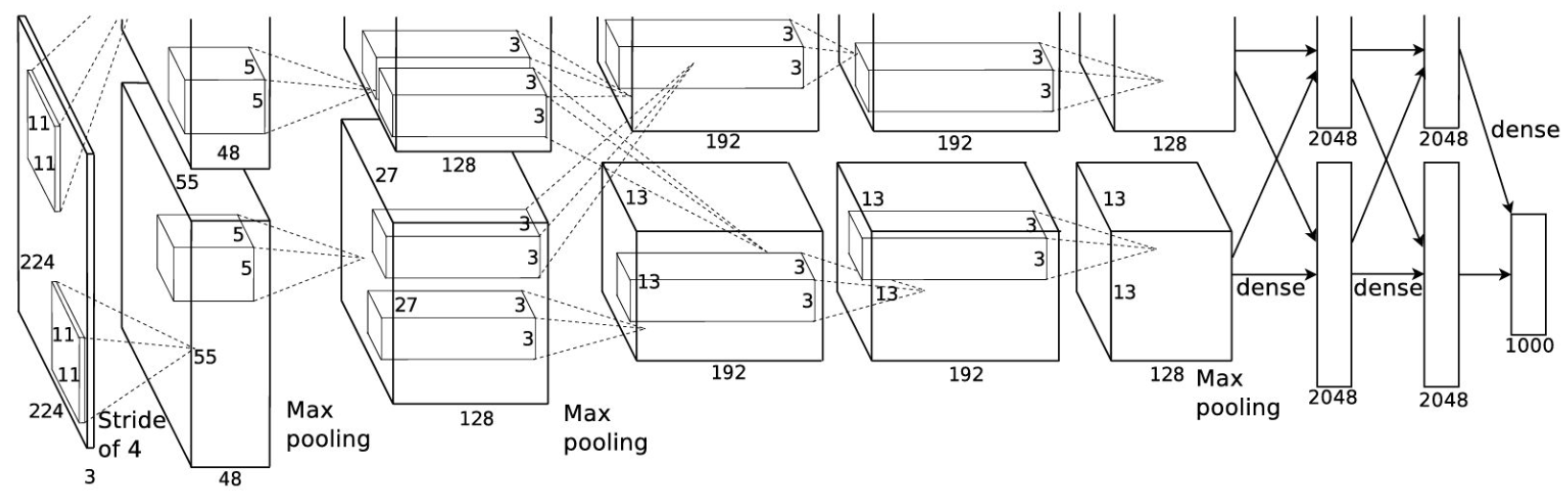

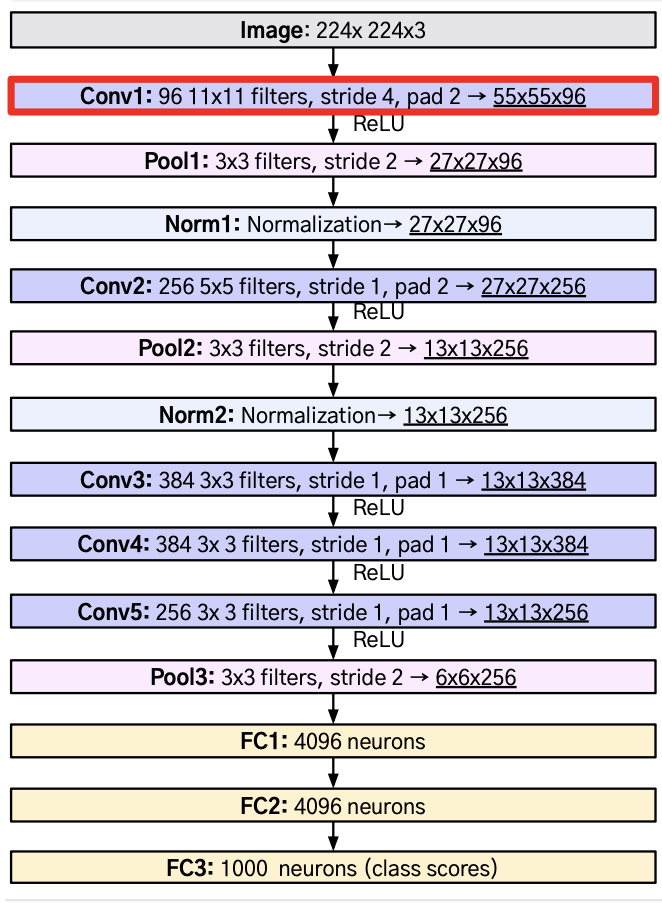

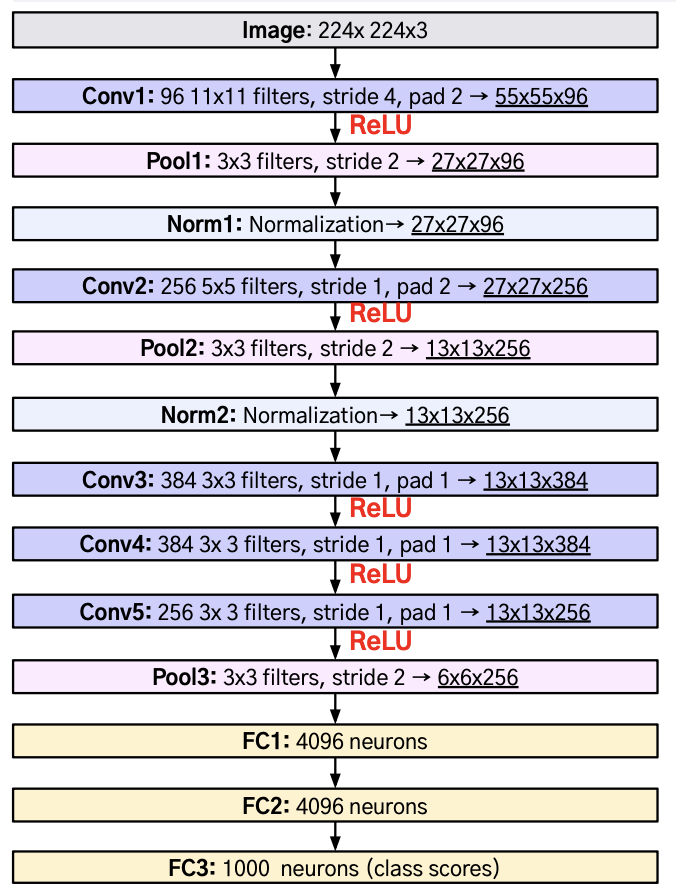

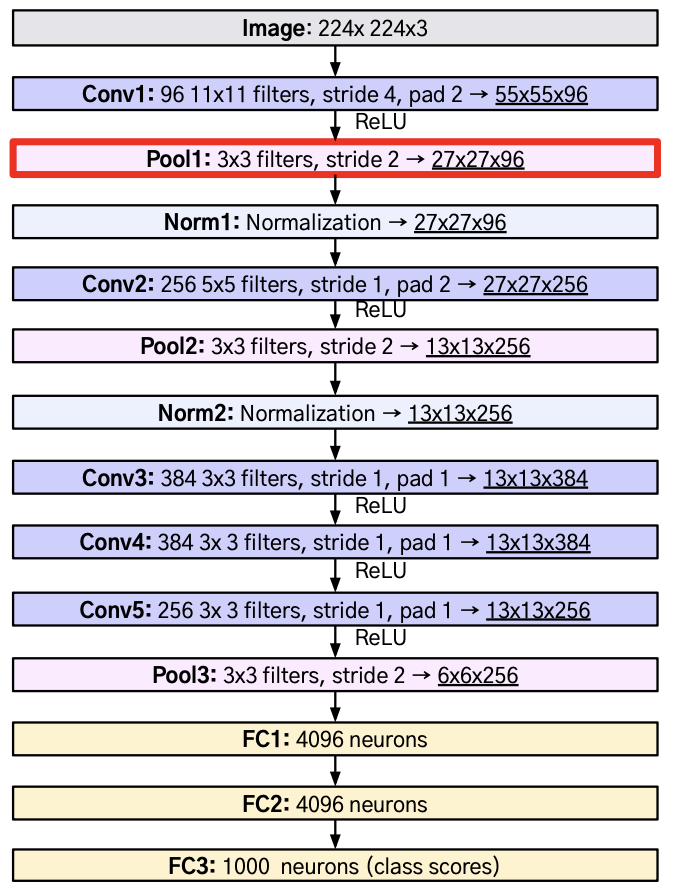

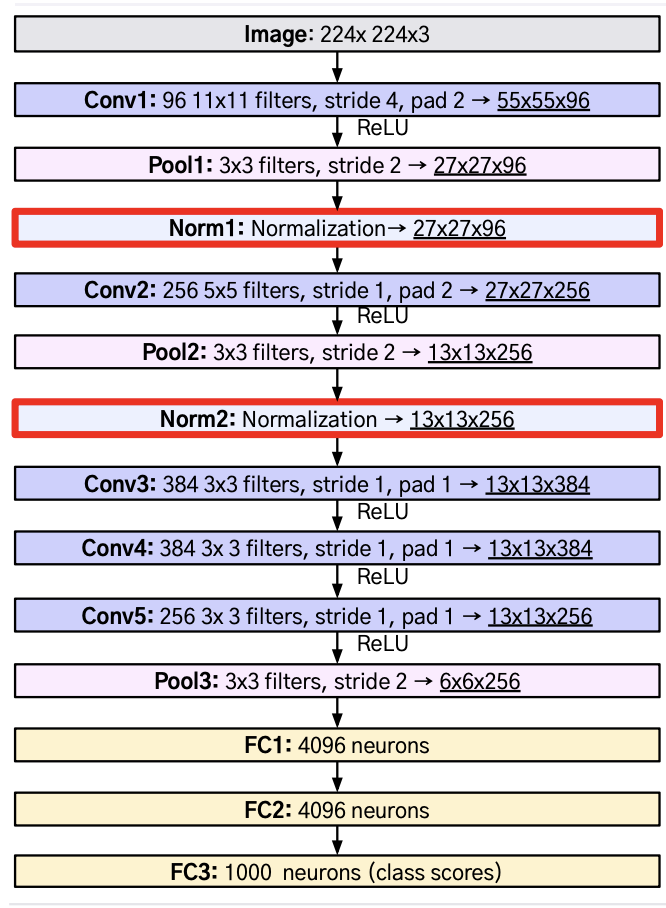

AlexNet 구조

Convolution - Pooling - Batch Normalization의 구조

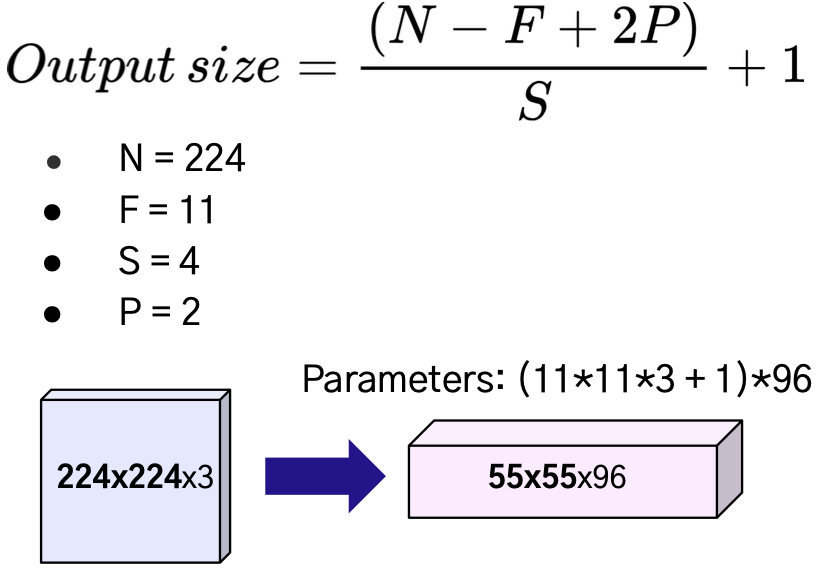

Convolution Layer

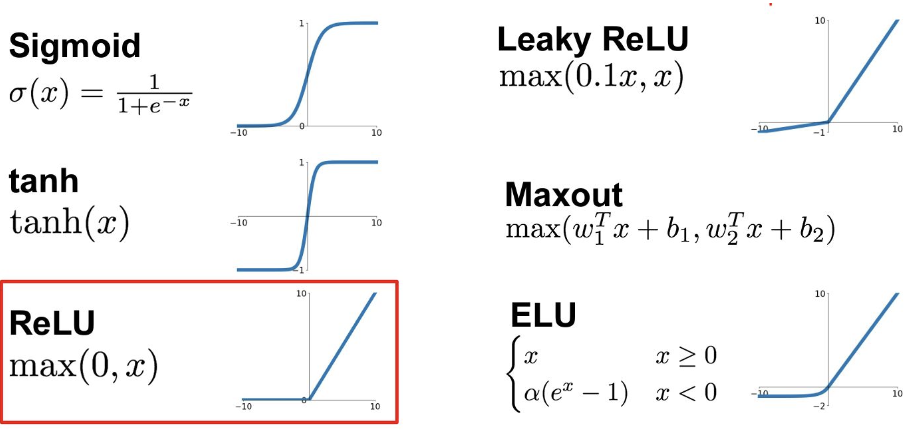

Active Function

ReLU가 가장 좋은 성능을 보여 도입 !

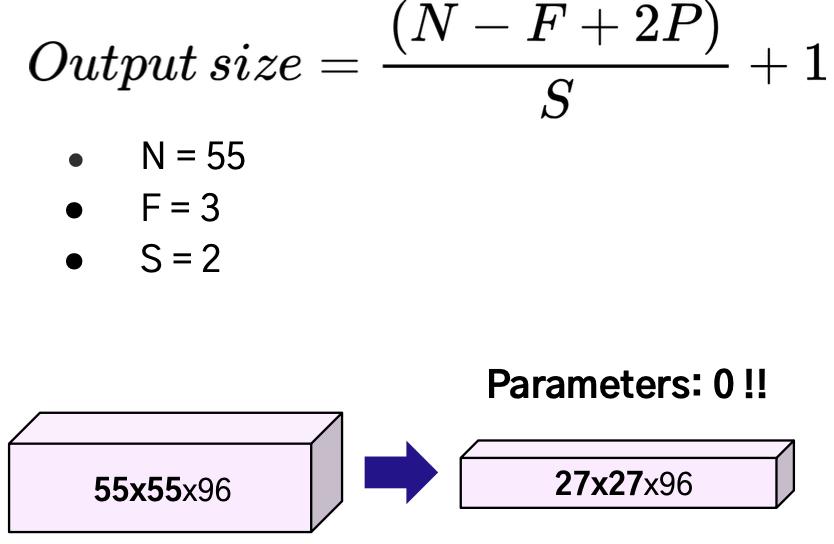

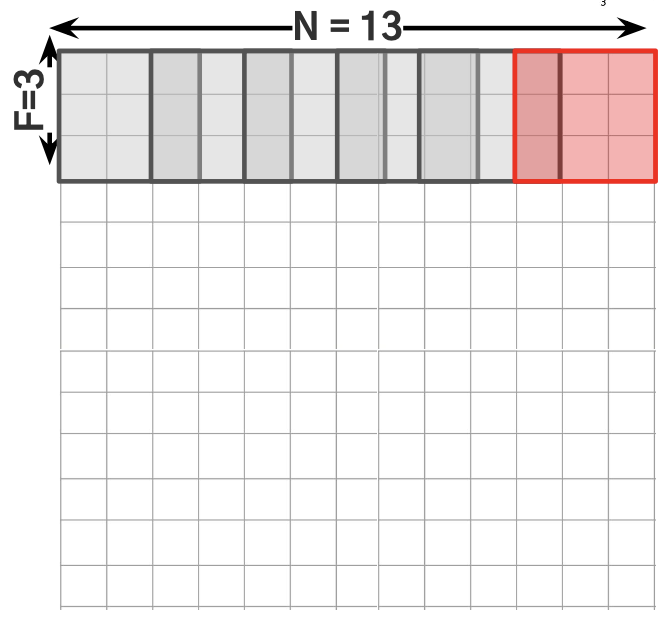

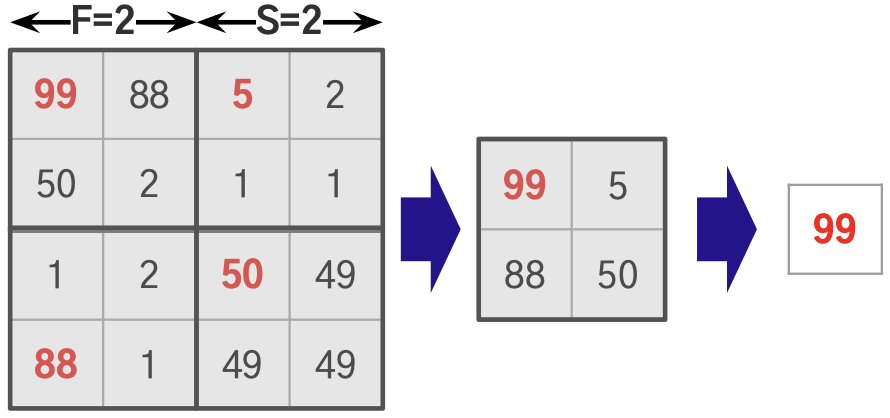

Pooling Layer

Overlapping Pooling을 했을 때 그렇지 않은 경우 (F=2, S=2)보다 좋은 성능을 보였다고 함

Local Response Normalization

Lateral Inhibition 현상: 강하게 활성화된 뉴런이 다른 뉴런의 값을 억제하는 현상

- 너무 강하게 활성화된 뉴런이 있을 경우 주변 뉴런들에 대해서 Normalization 진행

- Normalize를 통해 강하게 활성화된 뉴런의 값을 감소시켜, 특정 뉴런만 활성화되는 것을 막음

- 이후에는 Batch Normalization을 주로 사용

Overfitting 방지

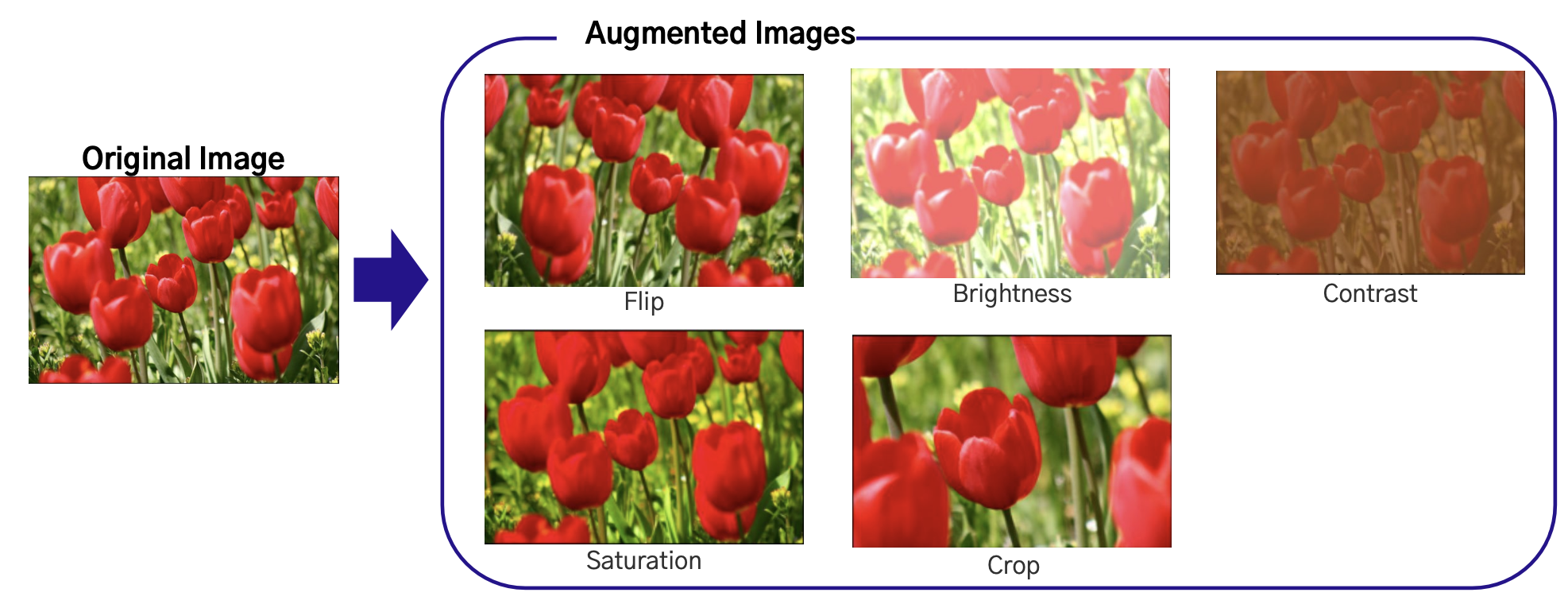

Data Augmentation

학습 데이터에 변형(Augmentation)을 가해서 좀 더 다양성을 지닌 데이터로 학습될 수 있도록 하는 방법

Drop Out

- 뉴런 중 일부를 일정 비율(p)로 생략하면서 학습을 진행하는 방법

- 몇몇 뉴런의 값을 0으로 바꾸어서 학습 시에 영향을 미치지 못하도록 만들어 일정 뉴런의 값에 치중해 학습되는 것을 방지함

- Dropout은 학습 시에만 행해지고, 테스트를 할 때는 모든 뉴런을 사용함