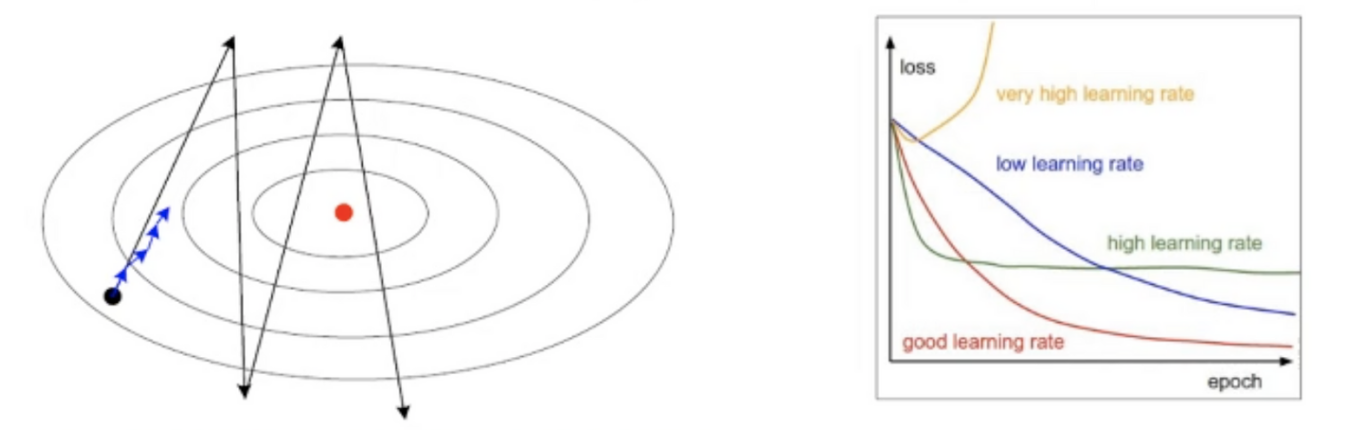

학습률 p의 중요성

- 너무 크면 최저점을 지나쳐가서 최저점 수렴속도가 느려지는 현상 발생

- 경사도에 학습률을 곱하면 최저점에 대한 방향성을 보존하며 수렴할 수 있음

- 일관된 경사도는 모든 매개변수에 같은 크기의 학습률을 사용하므로

- 적응적 학습률을 사용해 매개변수마다 자신의 상황에 다라 학습률을 조절해 사용할 수 있음(학습률 담금질 stimulated annealing)

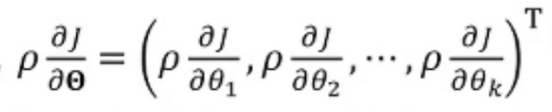

AdaGrad(adaptive gradient)

- 각 매개변수 위치에서의 그래디언트를 구하고

- 매개변수 경사도 정도에 따라 학습률을 나눈 값을 각 매개변수의 학습률로 사용

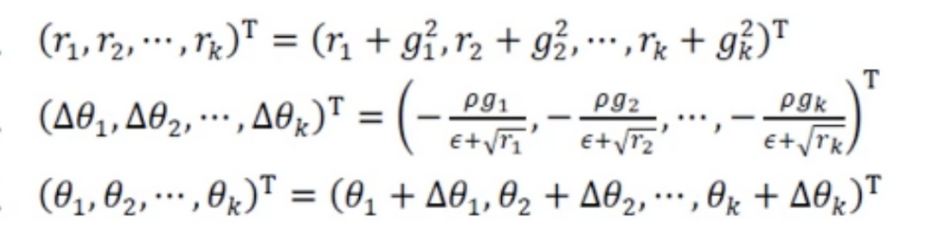

RMSProp

-

AdaGrad의 누적경사도가 점점 커셔 수렴을 방해할 가능성이 있음

-

RMSProp은

누적된 값과 새로운 그래디언트 양을 반비례로 구성해 최근 그래디언트로 더 나아갈지 기존 방향성을 가질지 결정할 수 잇음

누적된 값과 새로운 그래디언트 양을 반비례로 구성해 최근 그래디언트로 더 나아갈지 기존 방향성을 가질지 결정할 수 잇음 -

보통 a를 0.9, 0.99, 0.999로 사용

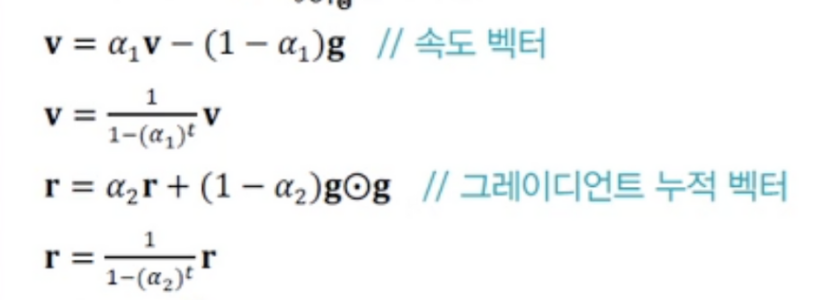

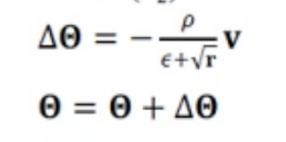

Adam(adaptive moment)

- RMSProp에 관성을 추가로 적용한 알고리즘

- 속도와 그래디언트 누적분을 모두 사용함

- 식 자체가 그래디언트 누적분이 많을수록 속도가 줄어드는 구조