Daniel W. Otter, Julian R. Medina, and Jugal K. Kalita

IEEE Transactions on Neural Networks and Learning Systems 2018Abstract

- 최근 딥러닝 모델의 등장으로 자연어 처리 분야가 크게 발전함

- 자연어 처리에 대한 소개와 딥러닝 구조에 대한 개요를 설명함

- 현재 기술 수준에 대한 논의와 향후 연구의 권장 사항을 제공함

Introduction

- NLP는 컴퓨터가 인간의 언어를 계산하고 처리하고 이해하도록 하는 것을 다루는 분야

- 1980년대 이후, 통계, 확률, 기계 학습 등의 데이터 기반 계산이 가능해지면서, 대용량 데이터 셋 및 GPU를 이용한 딥러닝이 가능해짐

- 자연어 처리와 딥 뉴럴 네트워크에 대한 간략한 소개를 제공하고, 딥러닝을 이용한 최신 자연어 처리 기술을 설명

- 자연어 모델링, 형태소 분석, 구문 분석, 의미론적 처리, 정보 검색, 정보 추출, 텍스트 분류, 텍스트 생성, 요약, 질의 응답, 기계 번역에 대한 전반적인 내용 설명

- 자연어 처리 분야의 최신 동향과 미래 전망 요약

Overview of NLP and Deep Learning

Natural Language Processing

- 인간의 언어를 이해하는 컴퓨터 모델과 프로세스를 설계하는 것

- 크게 핵심영역과 응용분야로 나뉨

- 핵심영역은 모델링, 형태소 처리, 구문 분석, 의미론적 처리

- 응용분야는 정보추출, 기계번역, 요약, 질의응답, 문서분류

- 과거에는 머신러닝을 사용 But... 이제는 신경망 모델을 사용함

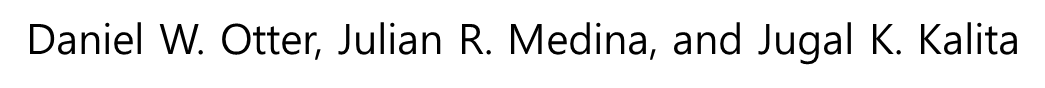

딥러닝을 활용한 NLP 역사

출처: https://medium.com/@antoine.louis/a-brief-history-of-natural-language-processing-part-2-f5e575e8e37

Neural Networks and Deep Learning

- CNN

- RNN

- LSTM

- GRU

- Attention

- Transformer

- Pre-trained model

모델의 역사

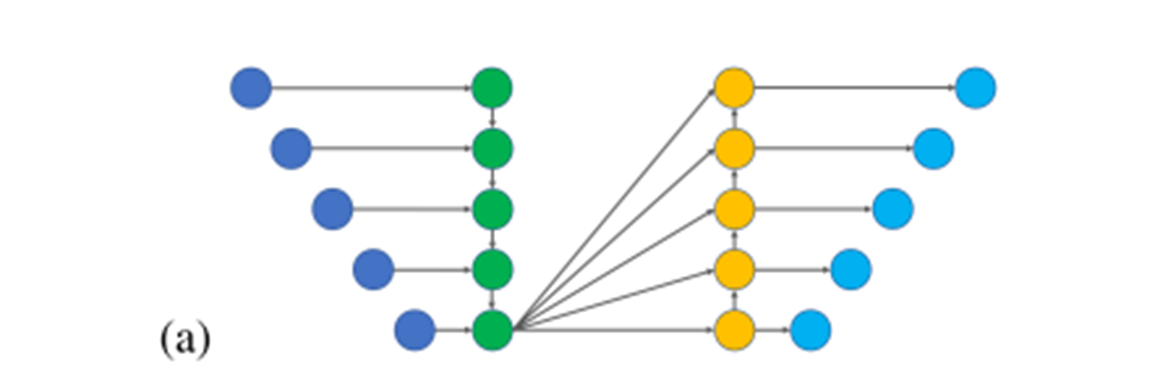

RNN Encoder-Decoer 구조

- 기계번역, 텍스트 요약, 자막을 만드는 작업에서 Encoder-Decoder 쌍을 사용하여 출력을 텍스트 형태로 반환

- Encoder는 일정한 길이의 벡터 생성

- Decoder는 위의 벡터를 기반으로 가변 길이 텍스트 생성

- RNN이 전체 시퀀스를 유한한 길이의 벡터로 인코딩하도록 강제하고 중요한 입력을 구분하지 못하는 한계가 있다.

Attention 구조

- RNN이 가진 문제점을 극복하기 위해서 Attention 메커니즘이 도입되었음.

- Pay attention to에서의 attention 즉, 무엇에 집중해야 하는지를 학습하는 것.(집중도?)

- Attention도 여러가지 종류가 있는데 self-attention은 한 문장에서 단어 간의 어텐션을 구함.

Deep Learning in Core Area of NLP

Core Area

언어 작업을 수행하려면 기본 언어의 이해가 필요함

1. 언어 모델링 : 단어 간 관계를 결정

2. 형태론 : 단어의 형태와 어근, 접두사, 접미사, 복합어

3. 구문 분석 : 단어간의 관계를 고려하여 문장 구조를 형성

4. 의미론 : 단어의 의미와 나타내는 문맥을 이해

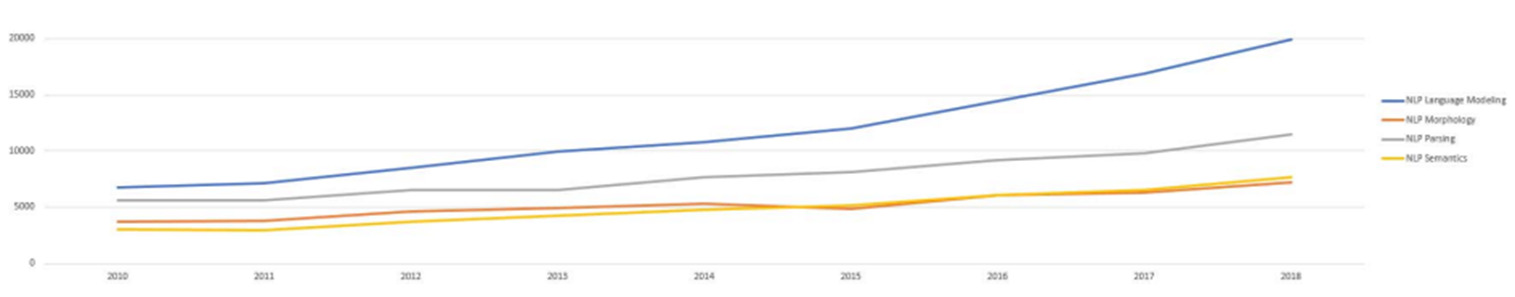

A) Languauge Modeling and Word Embedding

1.Language Modeling, 2.Morphology, 3.Parsing 4.Sementics

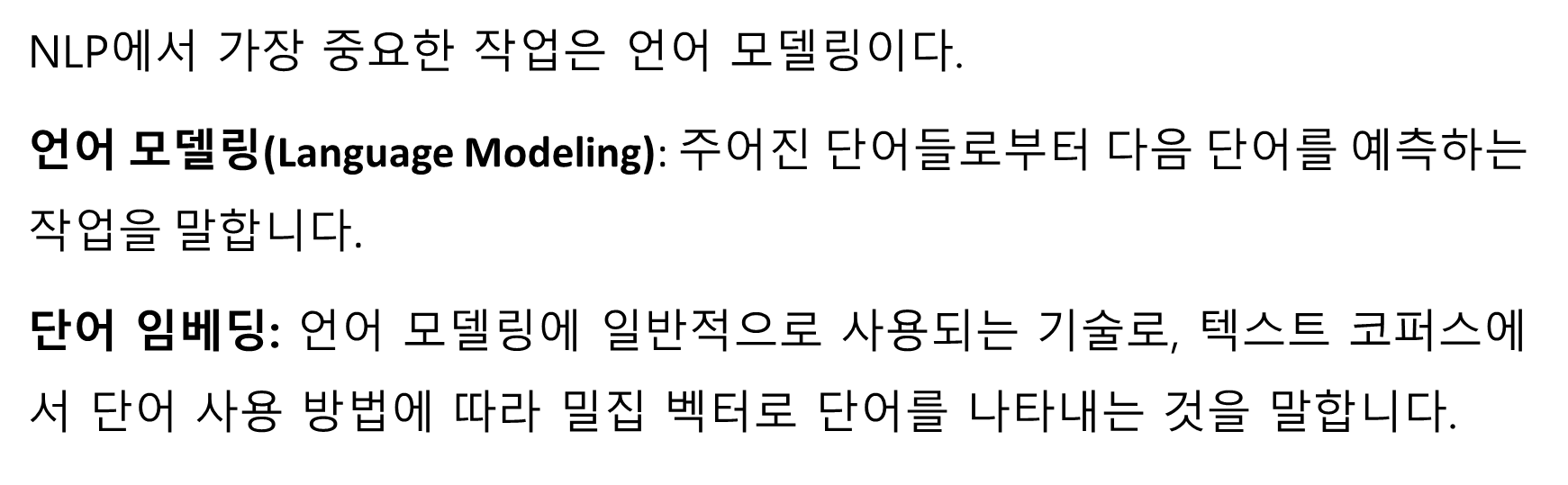

About Language Modeling

1. Neural Language Modeling

2. Evaluation of Language Models

3. Memory Networks and Attention Mechanisms LM

4. CNN Language Modeling

5. Character-Aware Neural Language Models

6. Development of Word Embedding

7. Recent Advances and Challenges

Recent Advances and Challenges

B. Morphology

C. Parsing

D. Semantics

위 세가지 코어 영역은 이런것이 있구나만 알고 패스

Summary of Core Issues

- 딥러닝은 기존은 작업 방식을 넘어서는 성능을 보여줌

- NLP는 복잡하다. 해결할 것이 많이 남아있다.

- It is unclear how to synthesize architectures for multiple core tasks into a single neural architecture to achieve competence in all tasks.

- 딥러닝 아키텍처들이 기본적인 기능을 명시적으로 수행하지 않고 암묵적으로 학습함.

- 이러한 이유로 몇몇 연구자들은 핵심 기능들에 대한 연구가 충분히 필요하지 않다고 주장하지만, 다른 연구자들은 기본적인 기능들을 명시적으로 또는 암묵적으로 수행하는 시스템을 더 잘 이해하고 개발하는 것이 더 나은 성능을 보이는 모델을 만들기 위해서 필수적이라고 주장함.

Applications of NLP Using Deep Learning

1. Information Retrieval

2. Information Extraction

3. Text Classification

4. Text Generation

5. Summarization

6. Question Answering

7. Machine Translation

Text Generation

인간과 비슷한 방식으로 문장이나 단락, 아이디어를 생성하는 기술

A. Poetry Generation

B. Joke and Pun Generation

C. Story Generation

D. Text Generation with GANs

E. Text Generation With VAEs

F. Summary of Text Generation

A. Poetry Generation

시를 생성하는 것은 창의적인 콘텐츠를 생산하는 것 + 일정한 구조를 따라서 텍스트를 생성해야함. -> 어려움

RNN을 썼는데 내부 언어 모델 학습은 괜찮음.

BUT, 구조화된 출력을 생성하거나 단일 스타일을 유지하는 것이 어렵다.

그래서 pre-trained 모델을 사용함. 성능 좋음

B. Joke and Pun Generation

LSTM으로 동음이의어 유머를 생성했는데 모호성을 도입하는 문장을 잘 생산했지만, 유머러스하진 않았다.

-> 인간이 평가를 해줌, 유머 데이터만을 가지고 훈련하는 것은 충분치 않았음. 뉴스기사, 명언, 유머, 트위터와 같은 추가 데이터를 사용해서 학습을 하니 유머글의 성능이 향상되었다.

C. Story Generation

- RNN과 Attention을 이용해서 짧은 이야기를 생성

- LSTM을 이용해서 행복, 슬픈 결말인지 지정해 줌

Summary of Text Generation

일관성 문제

핵심 샘플링을 제안

창의성을 평가하는 지표를 만드는 것이 어렵기 때문에 사람이 평가해야함 -> Mechanical Turk 활용

자동 평가하는 지표를 제안하는 연구들이 이뤄지고 있음

Conclusion