딥러닝에서 활성화 함수는 왜 필수적일까?

활성화 함수는 보통 비선형 함수를 사용하는데 MLP안에 포함시키면서 모델의 표현력이 좋아지기때문이다. 레이어 사이에 비선형 함수가 포함되지않은 MLP는 그저 한개의 레이어로 이루어진 모델과 다를게 없다.

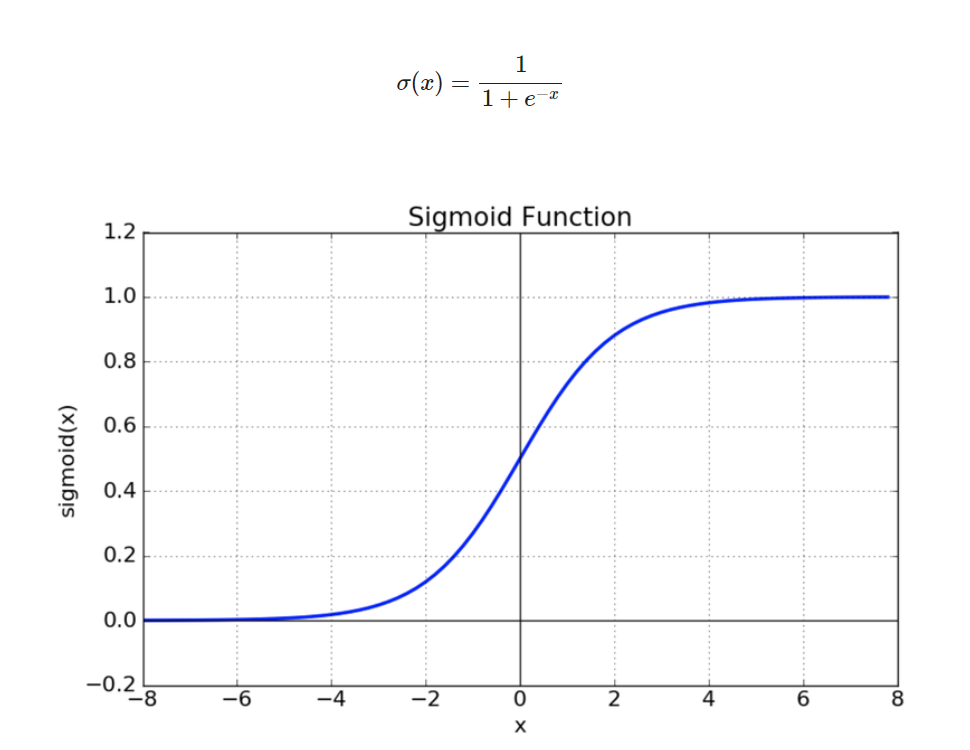

1. Sigmoid

그림에서도 볼 수 있듯이 시그모이드함수를 쓰면 어떤 출력값이든 0~1 사이로 맞출 수 있다.

하지만 활성화함수로 쓰기에는

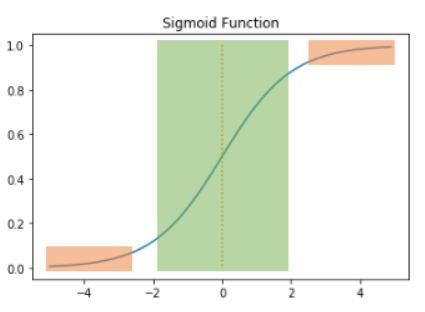

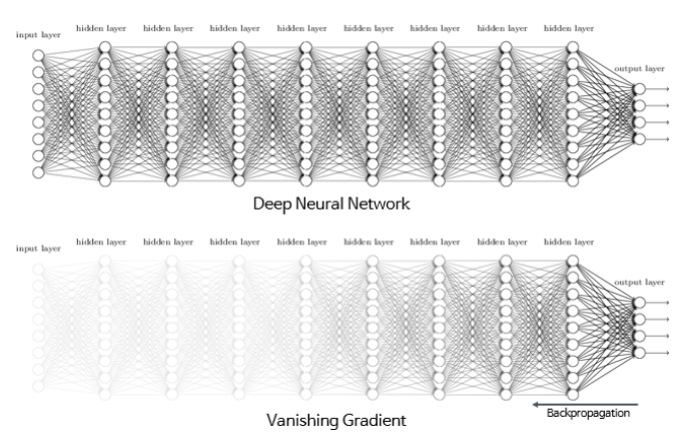

- vanishing gradient 현상이 발생한다.

함수의 출력값이 0과 1에 가까워지면(주황색부분) 기울기가 0에 가까운 작은 값이 나오게 되는데 역전파 과정에서 이 작은 기울기가 곱해지면 앞단에 기울기가 잘 전달되지않게 된다. 은닉층의 개수가 많을때 0에 가까운 기울기가 계속 곱해지면 학습이 되지 않는다.

- exp 함수 사용 시 비용이 크다.

이러한 단점들이 있어서 활성화 함수로 relu 함수를 더 많이 사용한다.

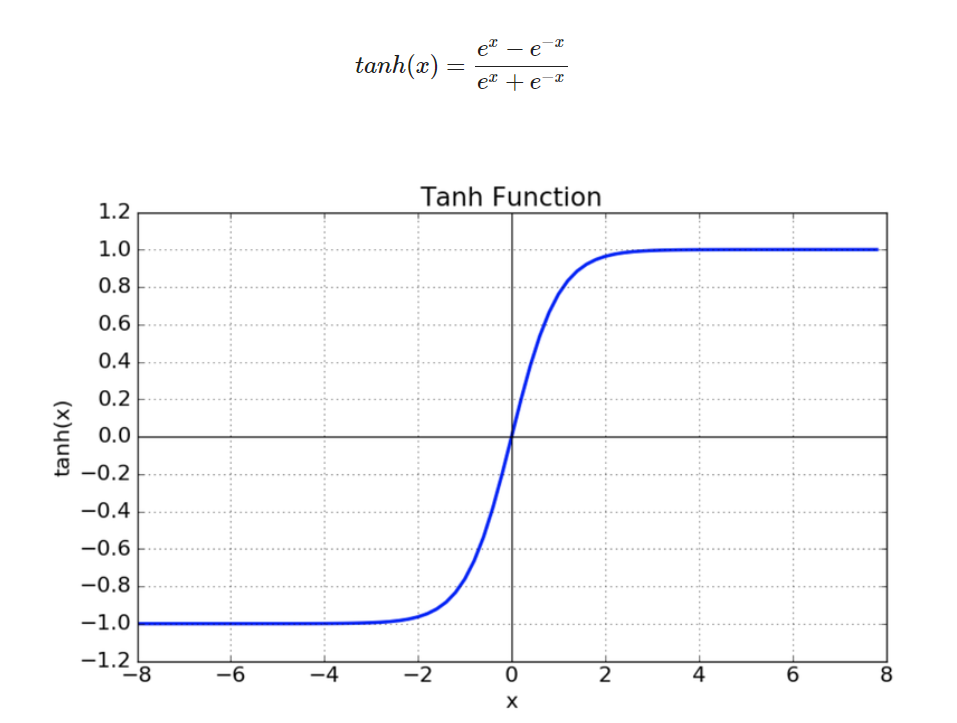

2. Tanh

tanh 함수의 중심값은 0으로 sigmoid 함수의 최적화 과정이 느려지는 문제를 해결하지만 여전히 vanishing gradient 현상이 존재한다.

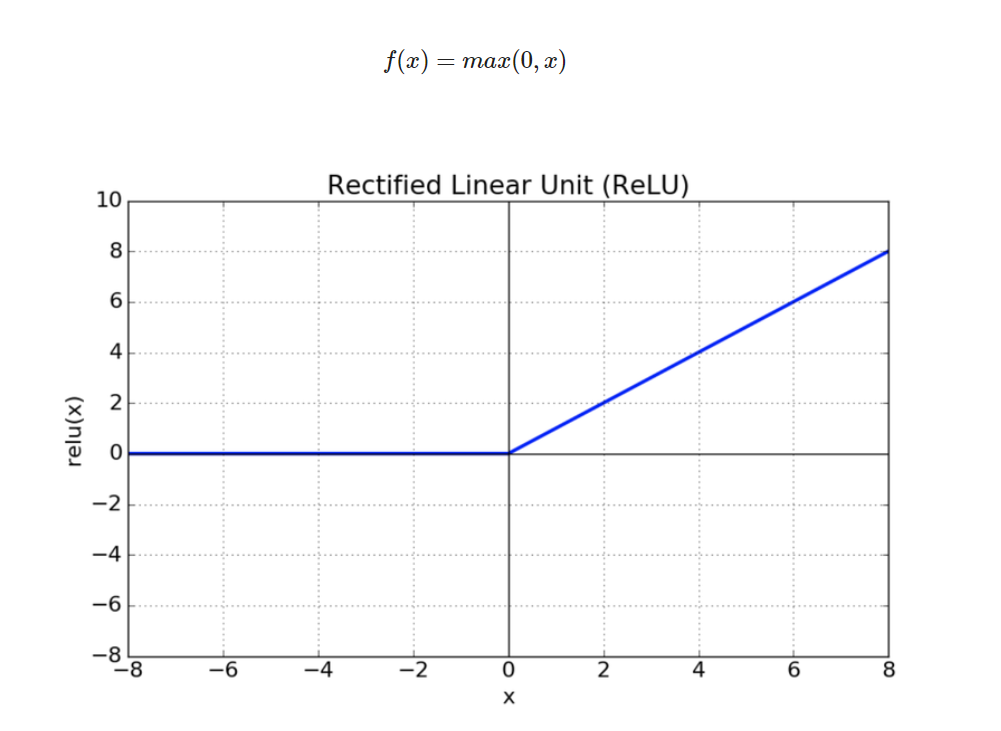

3. ReLU

relu 함수는 가장 많이 쓰이는 활성화함수이다.

음수를 입력하면 0을 출력하고, 양수를 입력하면 그 값을 그대로 반환한다. 단순 임계값으로 연산비용이 크지않고 구현도 간단하며 학습이 빠르다.