홈쿠 도전기

홈쿠 당췌 뭐냐구요? 집에서 직접 쿠버네티스 클러스터 구축 하는 걸 줄여서 부르는 말입니다. 못 들어 보셨다구요??? 제가 만들었으니 그렇죠-_-;;; 뭐든 줄여 부르는 요즘, '홈트' 처럼 제 맘대로 줄여서 적어봤습니다. 😁

오케이? 근데 왜 홈쿠?

작년에 도커와 쿠버네티스에 관심 좀 생겼던 때 열심히 삽질해서 너튭 에 영상을 만들어 올렸었죠. 나름 최대한 두뇌를 풀가동해서 만든 영상이었지만, 역시 튜토리얼 수준의 지식으로는 뭘 제대로 할 수가 없더군요. (그 당시에 다니던 회사의 주니어 꼬맹이 한테 보여줬더니 노잼이다 는 평가를 들었습니다. 하하하하.......🙅)

그러던 차에 최근에 시작하세요! 도커/쿠버네티스를 보고 불타오르는 학구열과 함께 테스트를 진행하고 있었죠!

그런데 역시 Docker Desktop에서 제공하는 쿠버네티스는 테스트 목적으로 사용하기는 편리하지만 단일 노드 클러스터라서 뭔가 아쉬움이 남더라구욥. 그래서 뭔가 서버를 사용해서 멀티 노드를 구성해볼까 하는 생각이 들어 이것저것 찾아봤습니다. 클라우드는 비싸서 겁나고, cafe24에서 제공하는 ssd 리눅스 가상서버 호스팅 이 제일 싸긴 하지만 이것도 테스트 때문에 이리저리 만져보기에는 좀 부담이 될 것 같았습니다.

그러던 차에! 옛날에 많이 하던 짓거리를 떠올렸습니다. Hyper-V로 VM을 이용해서 구성하는 거였죠! 제 컴터가 머리는 좀 안좋지만 메모리는 32gb라서 테스트하기에는 딱이었습니다.

Hyper-V는 윈도우 10 Home버전은 안되요! 그런데... 윈도우 10 Home에서도 Hyper-V 사용이 가능하다고 말하는 글도 있네요. 해보진 않았습니다만 진짜 되는건가...🤔

혓바닥이 길구나

넵넵..늬예늬예..... 😒 그러면 이제 제가 어떻게 구성했는지 함 풀어보까예?

참고자료

이 글은 김기혁님 께서 작성하신 Hyper-v 환경에서 쿠버네티스 master-worker 클러스터 구축하기를 아주 많이 참고했습니다! 김기혁님 최고오~!

시스템 구성

컴퓨터 사양 및 환경

- CPU : Ryzen 5 2600X (6Core 12Thread)

- Memory: 32gb

- SSD : 512gb

- OS : Windows 10 20H2

VM 구성

1마스터 - 2워커 노드 구성 이며, 각 VM은 다음과 같이 구성할 겁니다.

| 이름 | CPU | Memory | SSD |

|---|---|---|---|

| k8s-master | 2Core | 6gb | 40gb |

| k8s-node-1 | 2Core | 4gb | 40gb |

| k8s-node-2 | 2Core | 4gb | 40gb |

쿠버네티스를 실행하려면 최소 2Core 이상의 CPU와 2gb이상의 메모리가 필요합니다. 자세한 내용은 여기를 참조하세요.

Hyper-V 설정하기

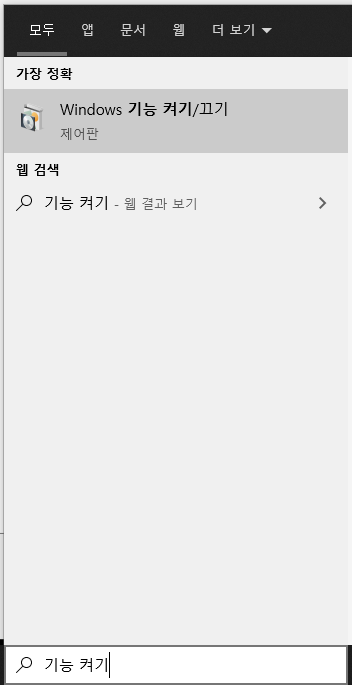

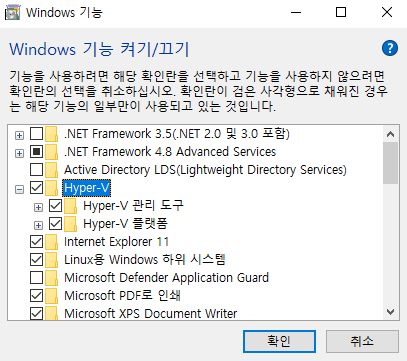

윈도우 키를 누르고 Windows 기능 켜기/끄기 로 들어갑니다!

Hyper-V 를 찾아서 확인 을 눌러줍시다.

그러면 지가 알아서 껐다 켰다하며 설치를 진행합니다. 참 똑똑하쥬? (그러네 나보다 똑똑...쓰읍🙊)

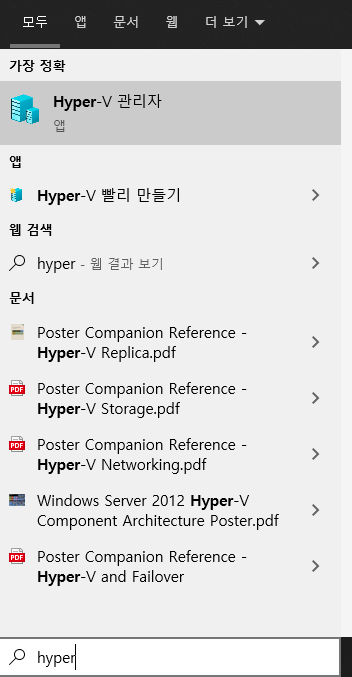

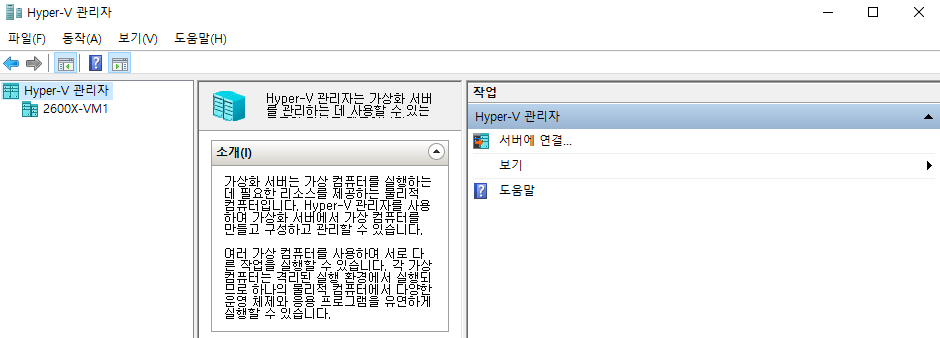

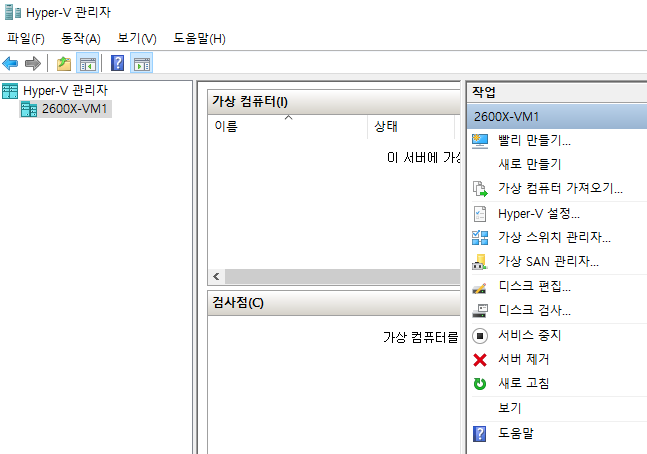

설치가 완료되면 Hyper-V 관리자 를 실행할 수 있습니다.

관리자 딱 불러서 앞에 세우고 나면! 뭔가 휑하죠???😲

당황하지 마시고 Hyper-V 관리자 밑에 보이는 컴퓨터를 클릭해주세요.

아... 이제 뭔가 편안하네요. 자 그럼 VM을 하나씩 만들어 볼 차례입니다.

준비물 xubuntu

각 vm에는 xubuntu를 설치해서 돌릴 겁니다. xubuntu가 뭐냐구요? 저도 이번에 첨봐서 잘은 모르지만 ubuntu에 XFCE라는 GUI 데크스탑을 올린 거라고 합니다. XFCE는 약간 생긴건 모자라지만 리소스를 적게 먹는다고 하는 군요! 생긴게 뭐 중요하나요.... 적게 먹는다는데! 그러고 보니 저도 생긴건 좀 모자라지만 적게 먹습니다. 꺄르륵...😏

자 그럼 위에 저 링크로 딱 가서! 맨 위에 보이는 64-bit systems 을 딱 누르지! 마시구요. 그 밑에 있는 Mirror downloads 에서 Japan 을 선택하셔서 다운로드 하세요. 저거 토렌트입니다. 에비.

xubuntu-20.04.2.0-desktop-amd64.iso 요거 클릭하셔서 다운로드 하세요.

이상한 거 받으신 분들 없죠? 그럼 오라이~

네트워크 생성

자 VM끼리 통신하고, VM과 호스트 컴퓨터가 통신하고! VM이 인터넷으로 자료 다운받고! 하려면 VM이 조인할 수 있는 네트워크를 만들어 줘야 겠죠.

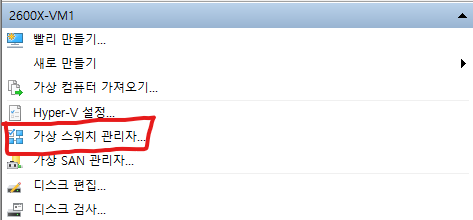

Hyper-V 관리자 우측 메뉴에서 가상 스위치 관리자 를 눌러줍시다.

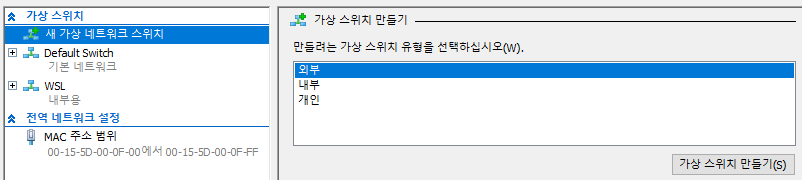

새 가상 네트워크 스위치 를 눌러 외부 를 선택하고 가상 스위치 만들기 를 눌러줍니다.

김기혁님의 포스트에서는 내부 스위치를 생성하고, 이더넷 스위치에서 내부 스위치에 인터넷 연결을 공유하는 방법을 사용했습니다. 그런데 제가 그렇게 해보니 제 컴퓨터의 문제인지 인터넷 연결이 대단히 불안정해서 그냥 외부 연결로 진행하였스빈다!

외부, 내부, 개인의 차이점에 대해서는 제가 오래전 고대의 언어로 작성한 문서를 참고해주세요. 아... 이게 벌써 10년전 글이라니... 근데 글을 다시 봐도 이해가 안되네요?

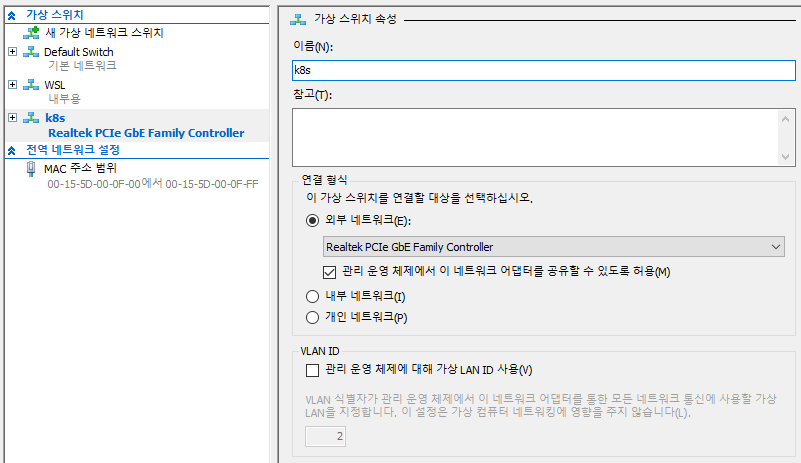

다음과 같이 이름을 입력하고 생성합니다.

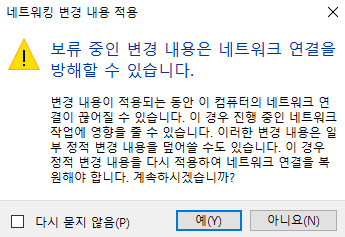

그러면 무씨무씨한 경고 메세지가 뜨는데요, 그냥 무시하고 진행합니다.

이제 VM끼리, 그리고 VM과 호스트 컴퓨터가, 그리고 VM이 인터넷에 접속할 수 있는 네트워크가 생성되었습니다. 와 🐶신난다~

마스터 VM 생성

자 마스터 VM 생성부터 가죠.

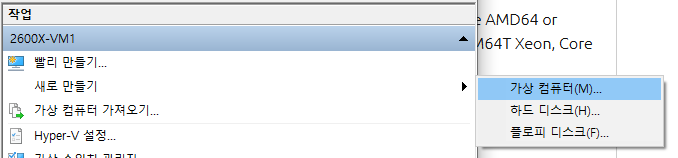

Hyper-V 관리자 에서 우측 메뉴의 새로 만들기 -> 가상 컴퓨터 로 갑시다.

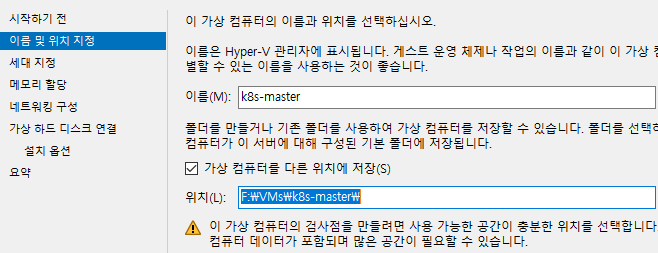

VM 이름을 적어주고, 가상 컴퓨터를 저장할 위치를 설정한 하고 다음!

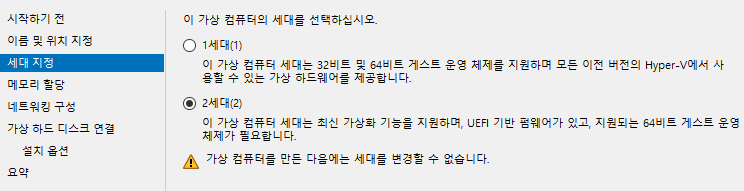

1세대는 구형 OS를 위해 존재하는 레거시 모드이구요, 우리는 2세대로 갑시다!

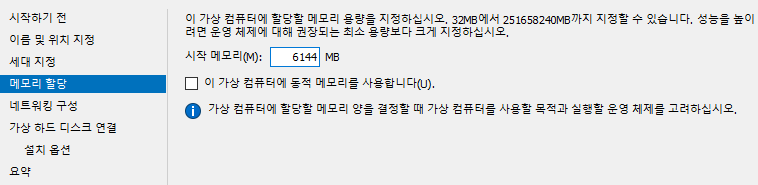

쿨하게 동적 메모리 필요 없이 메모리는 6gb 긁어주고!

네트워크는 아까 만든 네트워크로 연결해줍니다.

여기까지 하다가 네트워크 안 만든거 알아차리고 위로 올라가서 네트워크 생성 파트 작성하고 다시 온 건 안비밀.... 뭐 다들 그러잖아..

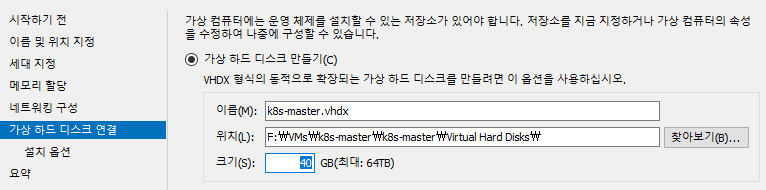

하드 디스크는 40GB 정도로 설정합니다. SSD 공간 넘치시는 분들은 맘대로 할당하세요~

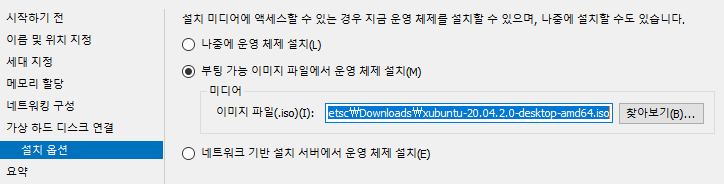

설치 옵션 은 아까 다운로드 한 이미지를 지정합니다.

그리고 마침 을 눌러 설정을 종료합시다. 나중에 워커 노드 VM 만들 때 여기 다시 오셔서 참조하심 됩니다. 또 쓰기 귀찮아서 그런건 절대 아닙니다. 그럴리가 없죠.

VM 시작 전에 할 일

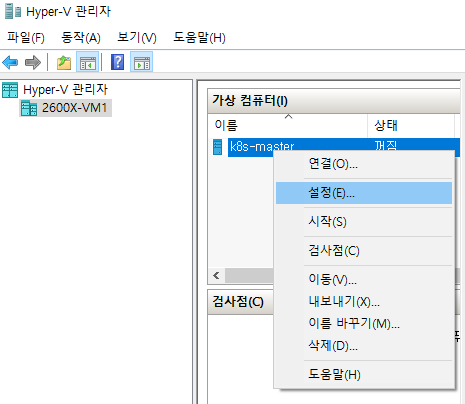

만들어진 VM에 우클릭하고 설정 으로 들어갑니다.

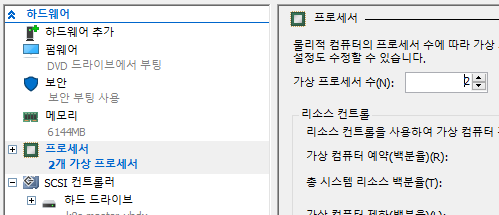

그리고 가상 프로세서를 2개로 설정합니다. 최소 요구 조건이죠.

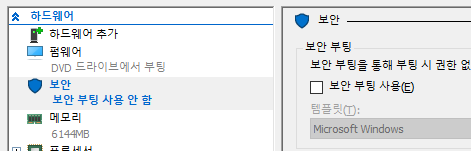

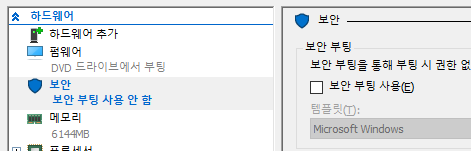

그리고 보안 부팅 사용 을 해제합니다.

이제 진짜 VM 시작

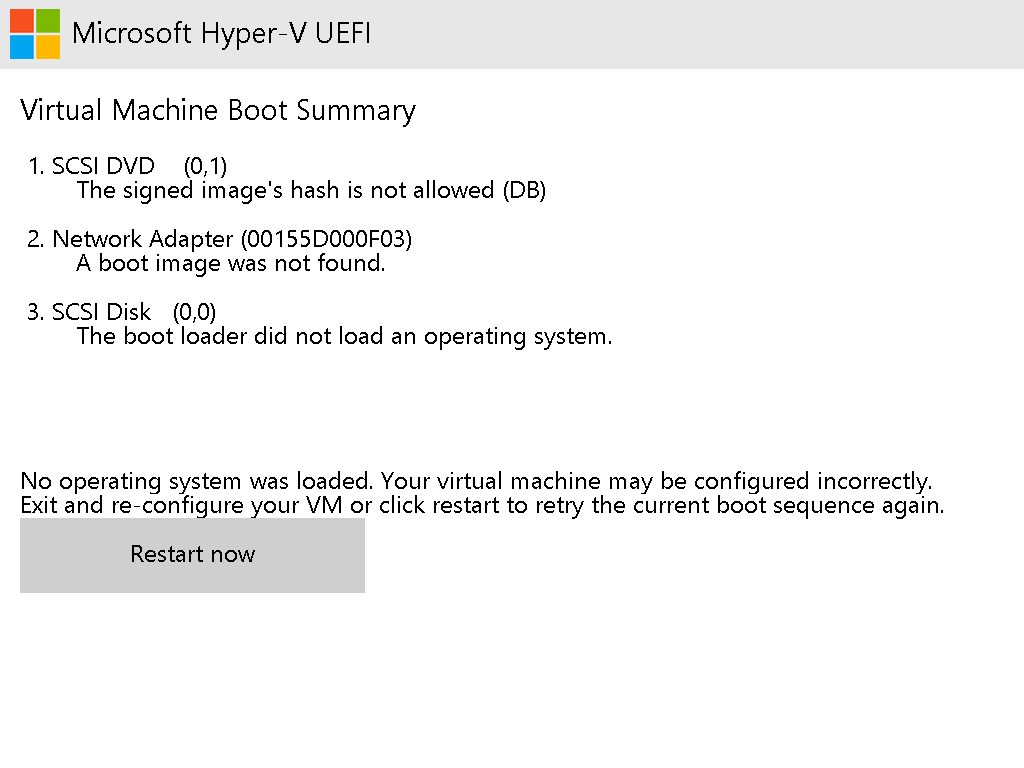

보안 부팅 사용 해제 설정을 안 하면 아래와 같은 에러가 납니다! 물론 제가 설정하는 걸 까먹어서 이런 에러가 난 건 아닙니다. 여러분 참고하시라고 일부러 에러를 낸거죠. 와... 이 친절함.

VM에 우클릭하고 연결 을 눌러주고, VM화면이 뜨면 시작 을 눌러봅시다. 그럼 VM이 숨을 쉬기 시작합니다. 후욱~ 후욱~

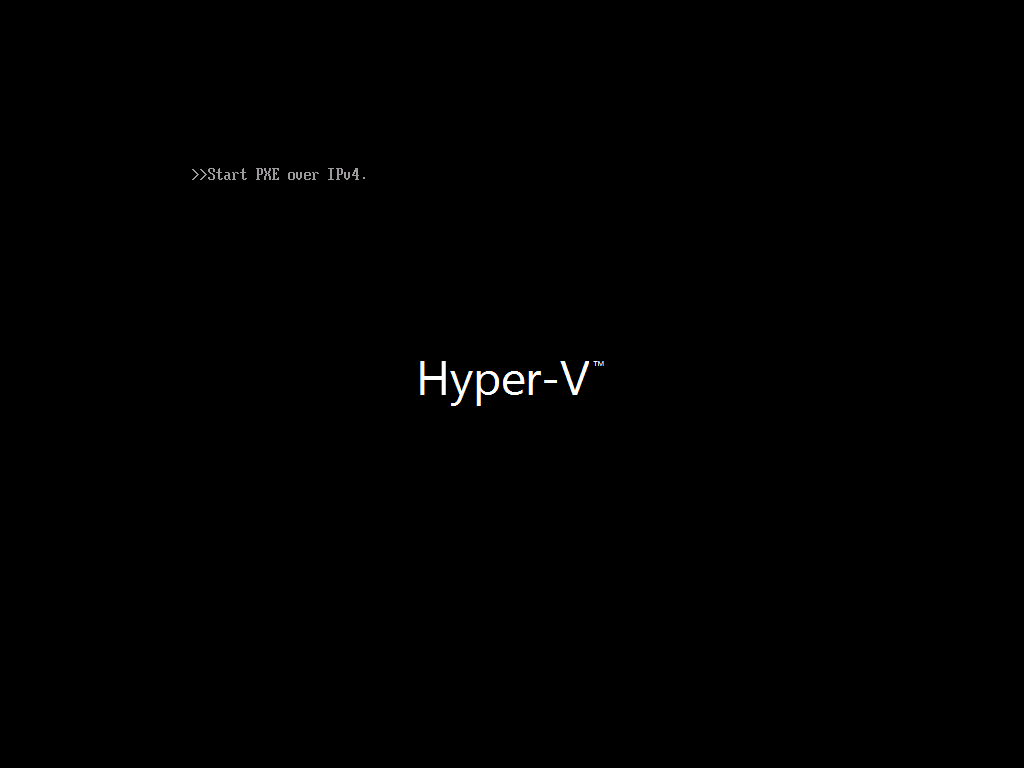

근데 저는 VM이 반응을 한동안 안하더라구요, 그래서 요 화면을 몇십초 동안 보면서 제가 뭘 잘못했는지 깨달을 찰나에..

요런 에러 메세지가 딱!

상단의 중지 버튼을 누르고 끄기 를 꾹 눌러줍니다.

보안 부팅 사용 을 해제하고 다시 시작합니다. 위에서 이미 설절을 해제하신 분들은 에러 안나니까 그냥 다음 파트로 넘어 가실게요~ 오라이~

다시다시 VM을 시작합니다.

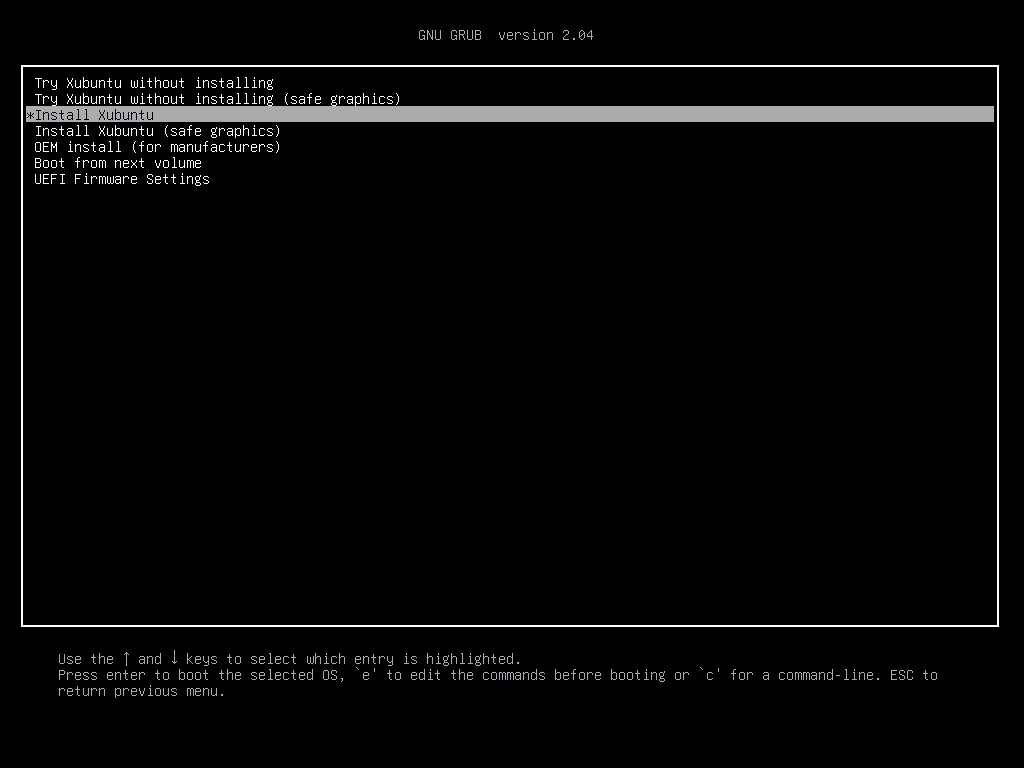

xubuntu 설치

Install Xubuntu 를 선택하고 설치를 진행합니다.

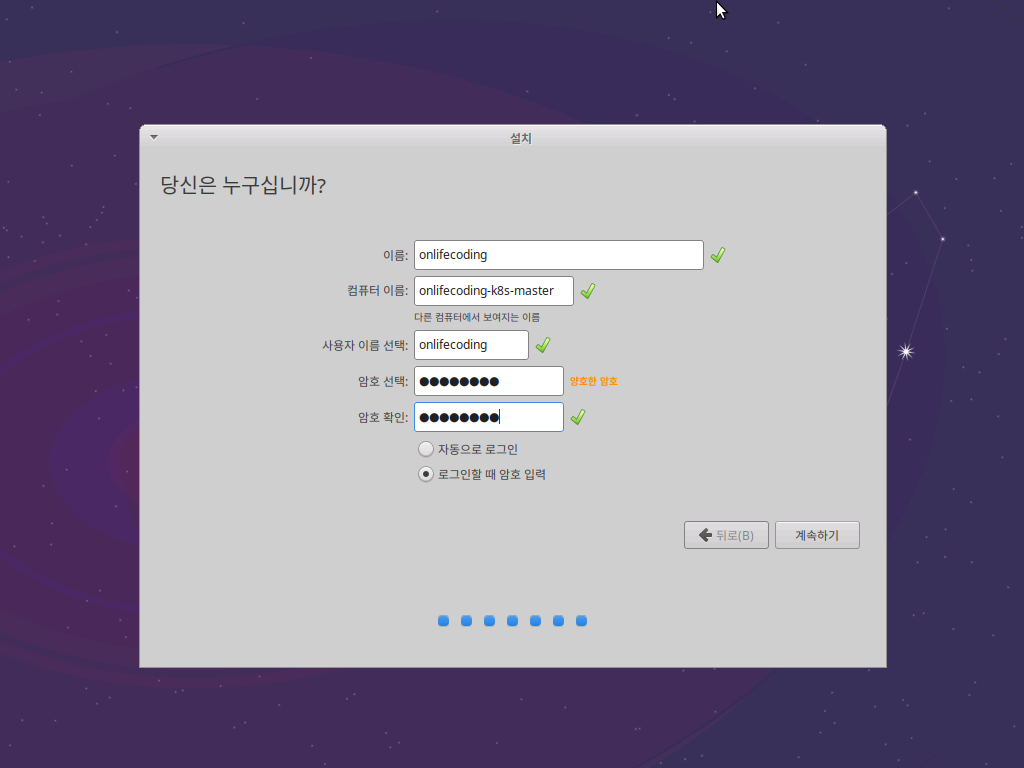

언어 설정과 키보드 설정 등등 기본값으로 전부 처리하고 갑시다. 그리고 당신은 누구십니까? 라고 정겹게 물어보는 질문에 답을 합니다.

한 번 재부팅을 마치면 설치가 완료된 xubuntu를 사용할 수 있습니다.

ssh 설정

아무리 GUI가 달려있다지만 VM에서 작업하는 건 그다지 유쾌한 일이 아닙니다! 로컬에서 아아주우 빤딱빤딱 빛나는 Windows Terminal을 이용해서 작업하면 아주 신나겠죠??? 그래서 ssh를 통해 VM에 접속할 수 있도록 ssh 설정을 할 겁니다.

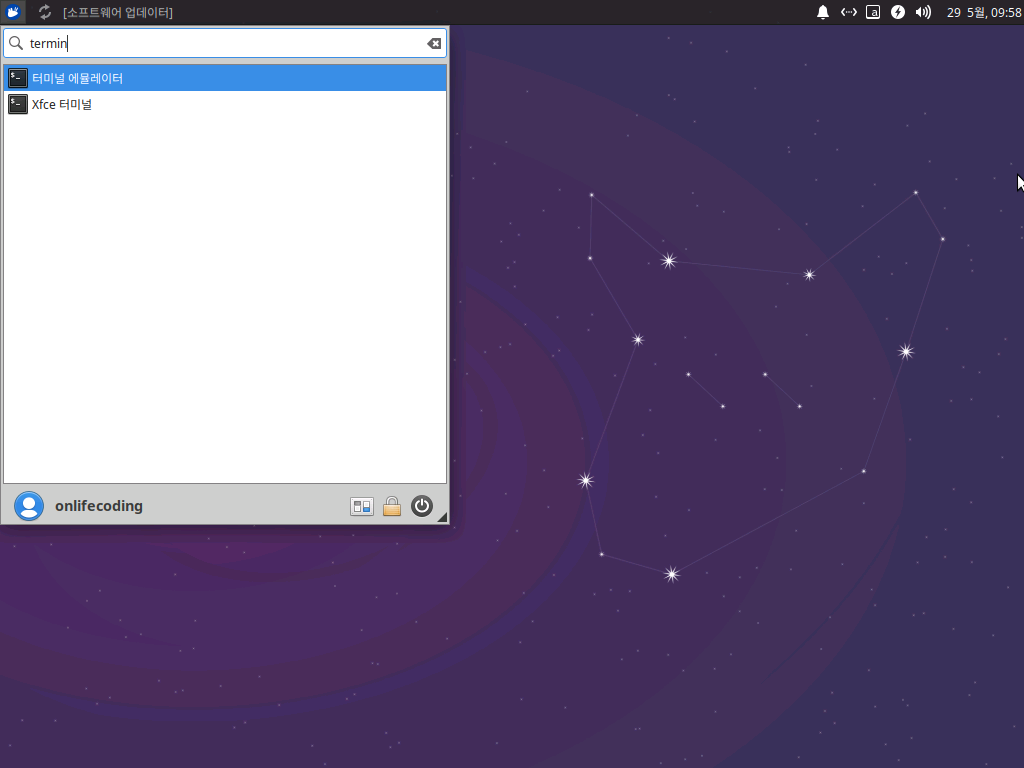

불완전한 언어 지원 경고를 그냥 무시하구요, 왼쪽 상단의 버튼을 눌러 터미널 에뮬레이터 를 선택합니다.

터미널에서 다음과 같이 ssh를 설치합니다.

$ sudo apt-get update

...

$ sudo apt-get install openssh-server이제 이 컴퓨터에 ssh를 통해 접속할 수 있도록 설정을 바꿔줘야 합니다. 그런데... vi 쓰긴 좀 그렇고... 기왕 GUI 달린 xubuntu 설치 했으니 gedit를 써봅시다!

$ sudo apt-get install gedit츠암 쉽죠오~? 그럼 ssh 설정 편집 갑시다!

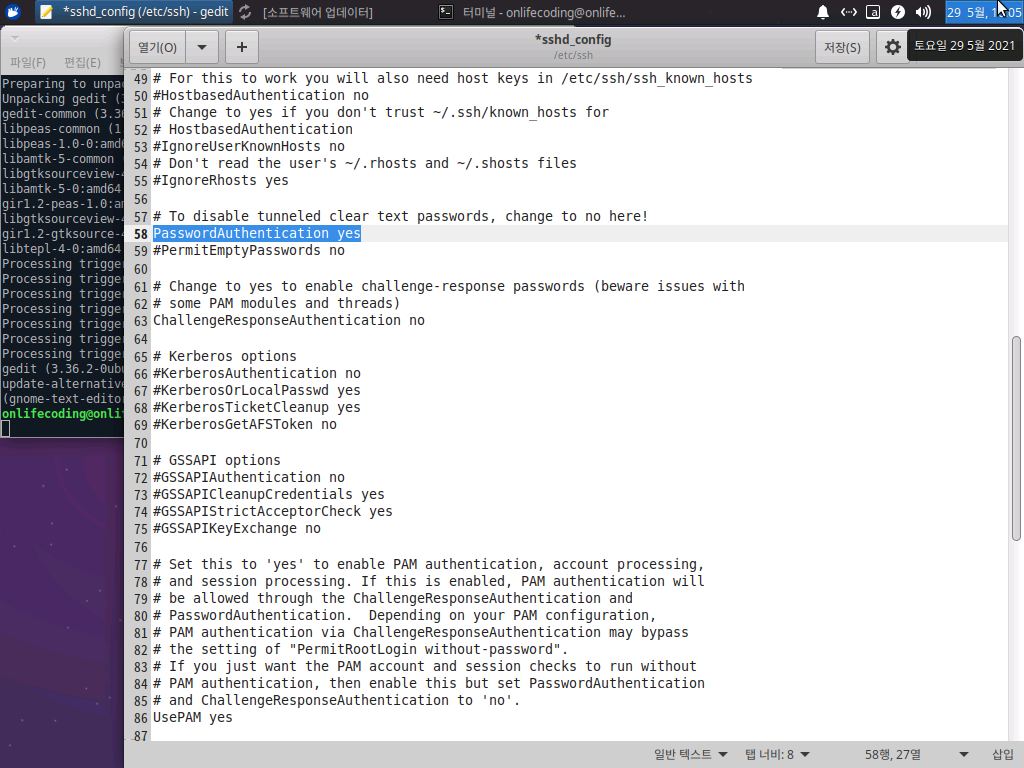

$ sudo gedit /etc/ssh/sshd_config우선 PasswordAuthentication yes 줄의 주석을 제거해줍니다. ssh를 패스워드로 로그인할 거거든요!

컨트롤 + S 를 눌러서 저장하고 gedit를 닫습니다. 마지막으로 이 VM의 ip주소를 확인하기 위해서 필요한 툴을 설치하겠습니다.

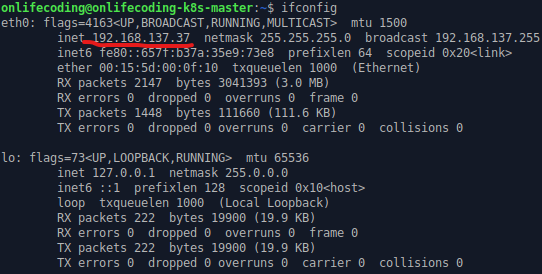

$ sudo apt install net-tools

...

$ ifconfigeth0 의 ip를 잘 기록해둡니다.

이제 로컬의 Windows Terminal 에서 Powershell 로 접속할 수 있습니다. 명령어는 다음과 같습니다.

ssh {계정명}@{vm의 ip}VM에 접속해볼까요?

PS C:\Sources> ssh onlifecoding@192.168.137.37

The authenticity of host '192.168.137.37 (192.168.137.37)' can't be established.

ECDSA key fingerprint is SHA256:qI16ydJqZO3vjAaaWvZ783xjX/NDhuy/yx6lDOq6BbI.

Are you sure you want to continue connecting (yes/no/[fingerprint])? yes

Warning: Permanently added '192.168.137.37' (ECDSA) to the list of known hosts.

onlifecoding@192.168.137.37's password:

Welcome to Ubuntu 20.04.2 LTS (GNU/Linux 5.8.0-53-generic x86_64)

* Documentation: https://help.ubuntu.com

* Management: https://landscape.canonical.com

* Support: https://ubuntu.com/advantage

169개의 업데이트가 바로 설치 가능합니다.

73개의 업데이트는 보안 업데이트입니다.

추가 업데이트를 확인하려면 apt list --upgradable 을 실행하세요.

Your Hardware Enablement Stack (HWE) is supported until April 2025.

The programs included with the Ubuntu system are free software;

the exact distribution terms for each program are described in the

individual files in /usr/share/doc/*/copyright.

Ubuntu comes with ABSOLUTELY NO WARRANTY, to the extent permitted by

applicable law.

onlifecoding@onlifecoding-k8s-master:~$딱! 접속이 됩니다. 아오 이제 로컬에서 편하게 작업할 수 있습니다. 휴우.... 힘들어따. 로컬에서는 vi로 작업하더라도 복사해서 붙여넣기가 가능하거든요 꺄르륵. 😝

이제 마스터 VM이 설정되었으니 워커 노드를 2개 만들어 볼 차례입니다.

자, VM 생성 계획을 다시 확인해볼까요?

| 이름 | CPU | Memory | SSD |

|---|---|---|---|

| k8s-master | 2Core | 6gb | 40gb |

| k8s-node-1 | 2Core | 4gb | 40gb |

| k8s-node-2 | 2Core | 4gb | 40gb |

위에 적은 거 또 적는 거는 좀 그러니까, 다들 실습으로 VM 2개 더 만들고 오실께요~! 유후~!

자습/실습 시간. 강사들이 제일 좋아하는 시간입니다. 시간 때워먹기 제일 좋거든요. 😝 개꾸르

VM 끼리 연결 테스트

자! 설정이 다 끝나신 분들 주목하실게요~ 저는 각 VM의 설정이 다음과 같습니다. 여러분은 뭐 ip가 좀 다르게 나오시겠죠?

| 이름 | ip |

|---|---|

| k8s-master | 192.168.137.37 |

| k8s-node-1 | 192.168.137.98 |

| k8s-node-2 | 192.168.137.169 |

각 연결된 터미널에서 다른 VM의 ip에 핑을 때려서 잘 연결되는지 확인합니다. 예를 들면 k8s-node-1 에서 k8s-node-2 로 핑을 때립니다.

onlifecoding@onlifecoding-k8s-node-1:~$ ping 192.168.137.169

PING 192.168.137.169 (192.168.137.169) 56(84) bytes of data.

64 bytes from 192.168.137.169: icmp_seq=1 ttl=64 time=0.372 ms

64 bytes from 192.168.137.169: icmp_seq=2 ttl=64 time=0.246 ms

64 bytes from 192.168.137.169: icmp_seq=3 ttl=64 time=0.243 ms

^C

--- 192.168.137.169 ping statistics ---

3 packets transmitted, 3 received, 0% packet loss, time 2029ms

rtt min/avg/max/mdev = 0.243/0.287/0.372/0.060 ms

onlifecoding@onlifecoding-k8s-node-1:~$오! 잘 되네요. 그러면 이제 각 VM에 kubeadm 을 설치할 차례입니다.

각 VM에 kubeadm 설치

각 VM의 /etc/hosts 에 VM끼리 ip가 아니라 도메인 네임으로 통신할 수 있도록 다음과 같이 설정합니다. 메모장에 작성하신 다음에 붙여넣기 하시면 되겠죠~? 당연히 ip는 여러분이 환경에 맞게 작성하셔야 합니다.

192.168.137.37 k8s-master-host

192.168.137.98 k8s-node-1-host

192.168.137.169 k8s-node-2-host이거를 다음과 같이 vi 를 통해서 붙여넣기 합니다.

$ sudo vi /etc/hosts참고로 vi사용법!

위 내용을 추가할 곳에 커서를 위치시키시고 i 키를 눌러 편집모드로 전환하고 붙여넣기, 그리고 esc 키를 눌러 편집모드에서 빠져나오고 :wq! 를 입력하여 변경사항을 저장합니다!

이렇게 알고 있었는데 그냥 바로 붙여넣기 하고 :wq!해도 되네요😒

각 3대의 VM에 설정을 완료했다면, ping {도메인 네임} 으로 핑을 때려볼 수 있습니다. 참고로, k8s-node-2 에서 k8s-master 로 핑을 때려볼까요?

onlifecoding@onlifecoding-k8s-node-2:~$ ping k8s-master-host

PING k8s-master-host (192.168.137.37) 56(84) bytes of data.

64 bytes from k8s-master-host (192.168.137.37): icmp_seq=1 ttl=64 time=0.407 ms

64 bytes from k8s-master-host (192.168.137.37): icmp_seq=2 ttl=64 time=0.259 ms

64 bytes from k8s-master-host (192.168.137.37): icmp_seq=3 ttl=64 time=0.358 ms

64 bytes from k8s-master-host (192.168.137.37): icmp_seq=4 ttl=64 time=0.281 ms

^C

--- k8s-master-host ping statistics ---

4 packets transmitted, 4 received, 0% packet loss, time 3051ms

rtt min/avg/max/mdev = 0.259/0.326/0.407/0.059 ms와우! 잘됩니다! 꺄르륵😚

그럼 도커 설치 갑시다!

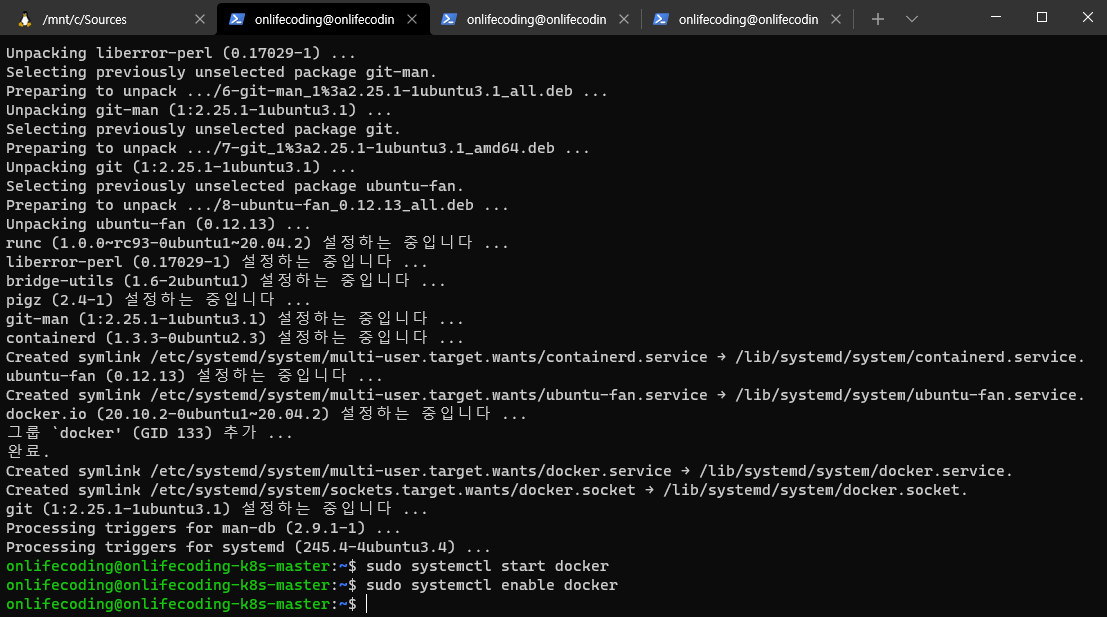

$ sudo apt-get install docker.io -y

...

$ sudo systemctl start docker

$ sudo systemctl enable docker참고로 Windows Terminal 을 이용하시면 저엉말 편합니다~ 요렇게 3개 연달아 띄워놓고, 붙여넣기-엔터-컨트롤+탭 하시면 쉽게 쉽게 진행하실 수 있죠~

다음으로 쿠버네티스 리포지토리를 등록합니다.

$ sudo apt-get install apt-transport-https curl -y

...

$ curl -s https://packages.cloud.google.com/apt/doc/apt-key.gpg | sudo apt-key add

...

$ sudo apt-add-repository "deb http://apt.kubernetes.io/ kubernetes-xenial main"다음으로는 가상메모리를 비활성화하는 게 좋다고 하네요. 쿠버네티스에서 노드의 상태를 예측하려면 가상메모리가 없어야 한다고 합니다.

$ sudo swapoff -a

$ sudo sed -i '/ swap / s/^\(.*\)$/#\1/g' /etc/fstab이제 쿠버네티스를 설치할 수 있습니다아~!

$ sudo apt-get install kubeadm -y

...

$ kubeadm version

kubeadm version: &version.Info{Major:"1", Minor:"21", GitVersion:"v1.21.1", GitCommit:"5e58841cce77d4bc13713ad2b91fa0d961e69192", GitTreeState:"clean", BuildDate:"2021-05-12T14:17:27Z", GoVersion:"go1.16.4", Compiler:"gc", Platform:"linux/amd64"}버전명이 잘 나오면 설치 성공입니다. 쿠버네티스에서 컨테이너를 도커로 사용하도록 설정을 추가해줍니다.

$ sudo vi /etc/docker/daemon.json아래 내용을 잘 복사해서 붙여넣습니다.

//https://gist.github.com/KimKiHyuk/692803efd97da482cd9c4b0bbe96a18d

{

"exec-opts": ["native.cgroupdriver=systemd"],

"log-driver": "json-file",

"log-opts": {

"max-size": "100m"

},

"storage-driver": "overlay2"

}자 이제는 마스터와 워커 노드의 작업이 분리됩니다. 마스터 부터 가볼까요?

쿠버네티스 마스터 설정

마스터 VM에서 하셔야 되오~!!! 꼭이오!!

쿠버네티스 클러스터를 생성합니다.

$ sudo kubeadm init --pod-network-cidr=10.244.0.0/16

...

Your Kubernetes control-plane has initialized successfully!

To start using your cluster, you need to run the following as a regular user:

mkdir -p $HOME/.kube

sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

sudo chown $(id -u):$(id -g) $HOME/.kube/config

Alternatively, if you are the root user, you can run:

export KUBECONFIG=/etc/kubernetes/admin.conf

You should now deploy a pod network to the cluster.

Run "kubectl apply -f [podnetwork].yaml" with one of the options listed at:

https://kubernetes.io/docs/concepts/cluster-administration/addons/

Then you can join any number of worker nodes by running the following on each as root:

kubeadm join 192.168.137.37:6443 --token nqwc1w.yg2y2fmksn91v2fh \

--discovery-token-ca-cert-hash sha256:3698d99704836baf053093daa7fafa4431d489280e9fd6ff11a1eacec29a177a자 여기서 중요한 거! 위 내용을 잘 읽어보시면 2종류의 커맨드가 나열되어 있습니다. 위에꺼!

$ mkdir -p $HOME/.kube

$ sudo cp -i /etc/kubernetes/admin.conf $HOME/.kube/config

$ sudo chown $(id -u):$(id -g) $HOME/.kube/config요거 3개는 마스터 에서 실행합니다. 그리고 나머지 1개

$ kubeadm join 192.168.137.37:6443 --token nqwc1w.yg2y2fmksn91v2fh \

--discovery-token-ca-cert-hash sha256:3698d99704836baf053093daa7fafa4431d489280e9fd6ff11a1eacec29a177a요거는 워커 노드에서 실행해야 하는 겁니다. 이 명령을 실행하면 워커노드가 클러스터에 붙을 수 있게 됩니다. 만약에 토큰 값을 다시 얻고 싶으면 요렇게 하면 된다고 합니다.(김기혁님 최고!)

$ kubeadm token list

$ openssl x509 -pubkey -in /etc/kubernetes/pki/ca.crt | openssl rsa -pubin -outform der 2>/dev/null | openssl dgst -sha256 -hex | sed ‘s/^.* //’자 그럼 마스터 부터 실행하죠. 명령을 모두 실행한 뒤에 flannel CNI를 설치 합니다. 플라넬 은 클러스터의 네트워크를 동작시키는 오버레이 네트워크라고 합니다.

$ kubectl apply -f https://raw.githubusercontent.com/coreos/flannel/master/Documentation/kube-flannel.yml

Warning: policy/v1beta1 PodSecurityPolicy is deprecated in v1.21+, unavailable in v1.25+

podsecuritypolicy.policy/psp.flannel.unprivileged created

clusterrole.rbac.authorization.k8s.io/flannel created

clusterrolebinding.rbac.authorization.k8s.io/flannel created

serviceaccount/flannel created

configmap/kube-flannel-cfg created

daemonset.apps/kube-flannel-ds created위 명령을 실행했는데, The connection to the server localhost:8080 was refused - did you specify the right host or port? 요런 에러가 나온다면 명령 앞에 sudo 를 붙였는지 확인해보세요. sudo 붙이면 에러납니다. 왜인지는 아직.. 저도.. 잘..😒

이제 워커 노드에서 클러스터에 참여 할 차례입니다.

워커 노드를 클러스터에 참여시키기

앞서 언급해드렸던 명령어를 실행합시다! 명령 앞에 sudo 를 꼭 붙여주세요!

$ sudo kubeadm join 192.168.137.37:6443 --token nqwc1w.yg2y2fmksn91v2fh \

--discovery-token-ca-cert-hash sha256:3698d99704836baf053093daa7fafa4431d489280e9fd6ff11a1eacec29a177a

[sudo] onlifecoding의 암호:

[preflight] Running pre-flight checks

[WARNING IsDockerSystemdCheck]: detected "cgroupfs" as the Docker cgroup driver. The recommended driver is "systemd". Please follow the guide at https://kubernetes.io/docs/setup/cri/

[preflight] Reading configuration from the cluster...

[preflight] FYI: You can look at this config file with 'kubectl -n kube-system get cm kubeadm-config -o yaml'

[kubelet-start] Writing kubelet configuration to file "/var/lib/kubelet/config.yaml"

[kubelet-start] Writing kubelet environment file with flags to file "/var/lib/kubelet/kubeadm-flags.env"

[kubelet-start] Starting the kubelet

[kubelet-start] Waiting for the kubelet to perform the TLS Bootstrap...

This node has joined the cluster:

* Certificate signing request was sent to apiserver and a response was received.

* The Kubelet was informed of the new secure connection details.

Run 'kubectl get nodes' on the control-plane to see this node join the cluster. 명령앞에 sudo를 붙여야 합니다. 안 그러면 이런 에러가!

[preflight] Running pre-flight checks error execution phase preflight: [preflight] Some fatal errors occurred: [ERROR IsPrivilegedUser]: user is not running as root [preflight] If you know what you are doing, you can make a check non-fatal with `--ignore-preflight-errors=...` To see the stack trace of this error execute with --v=5 or higher

마스터 VM으로 돌아와서 노드가 제대로 참여했는지 확인합니다.

onlifecoding@onlifecoding-k8s-master:~$ kubectl get nodes

NAME STATUS ROLES AGE VERSION

onlifecoding-k8s-master Ready control-plane,master 14m v1.21.1

onlifecoding-k8s-node-1 Ready <none> 2m12s v1.21.1

onlifecoding-k8s-node-2 Ready <none> 118s v1.21.1오우예~! 전부 Ready 상태로 잘 참여했군요. 그리고 혹시 모르니 쿠버네티스 Pod가 잘 돌아가는지 확인할까요?

onlifecoding@onlifecoding-k8s-master:~$ kubectl get pods --all-namespaces

NAMESPACE NAME READY STATUS RESTARTS AGE

kube-system coredns-558bd4d5db-65qps 1/1 Running 0 16m

kube-system coredns-558bd4d5db-8qm6f 1/1 Running 0 16m

kube-system etcd-onlifecoding-k8s-master 1/1 Running 0 16m

kube-system kube-apiserver-onlifecoding-k8s-master 1/1 Running 0 16m

kube-system kube-controller-manager-onlifecoding-k8s-master 1/1 Running 0 16m

kube-system kube-flannel-ds-k9hd6 1/1 Running 0 3m46s

kube-system kube-flannel-ds-lshqc 1/1 Running 0 4m

kube-system kube-flannel-ds-v8fx5 1/1 Running 0 7m18s

kube-system kube-proxy-djljf 1/1 Running 0 4m

kube-system kube-proxy-fj6mr 1/1 Running 0 3m46s

kube-system kube-proxy-nv8l6 1/1 Running 0 16m

kube-system kube-scheduler-onlifecoding-k8s-master 1/1 Running 0 16m얍! 아무 문제 없군요. 이렇게 일단 1master - 2node 세팅은 된 겁니다.😤

근데 이거 가지고 뭐 할거냐구요? 그건 천천히... 생각해봅시다! 다음에 또 뭔가 가지고 돌아오겠습니다. 천천히😘 전 게으른 사람이니까.