" Forward Propagation -> Backward Propagation -> gradient descent " 과정의 반복

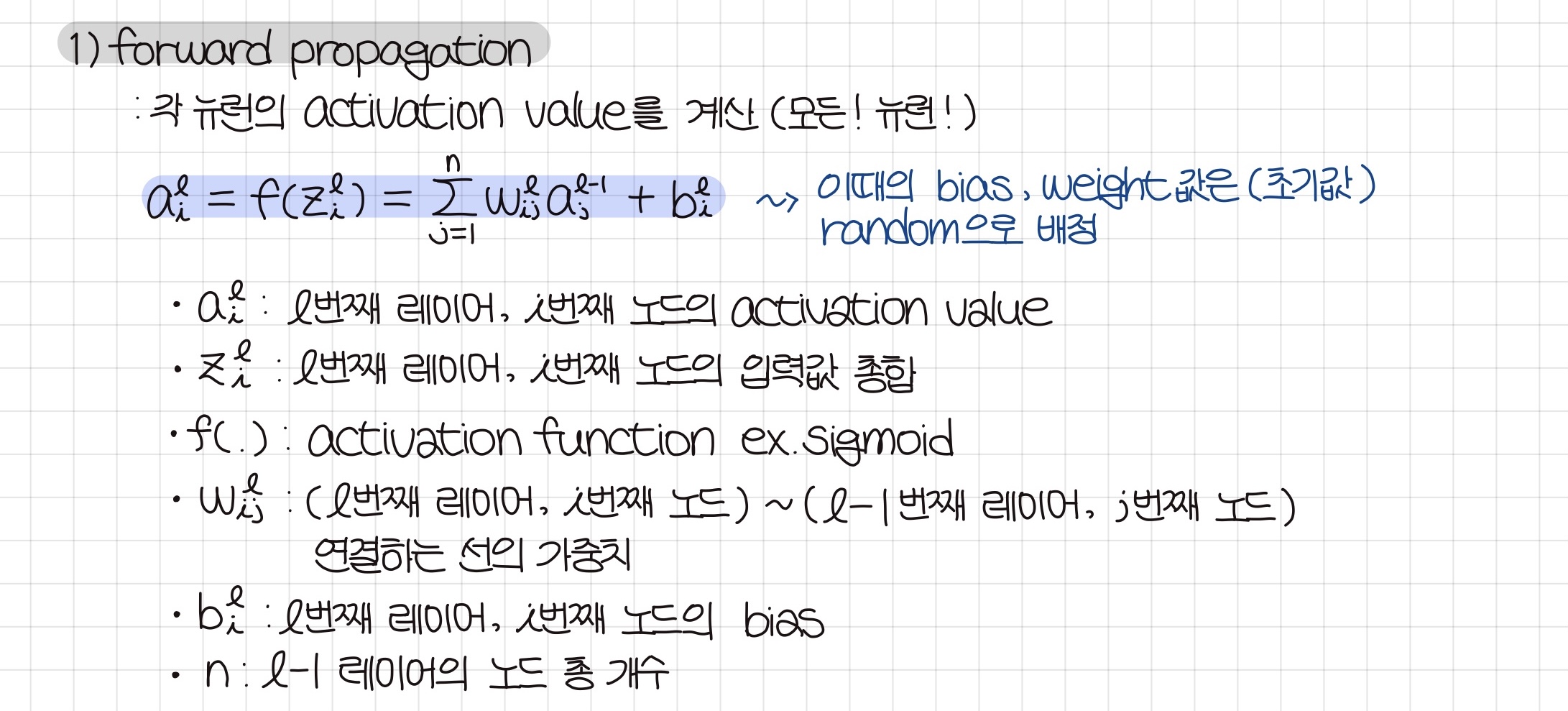

1. Forward Propagation

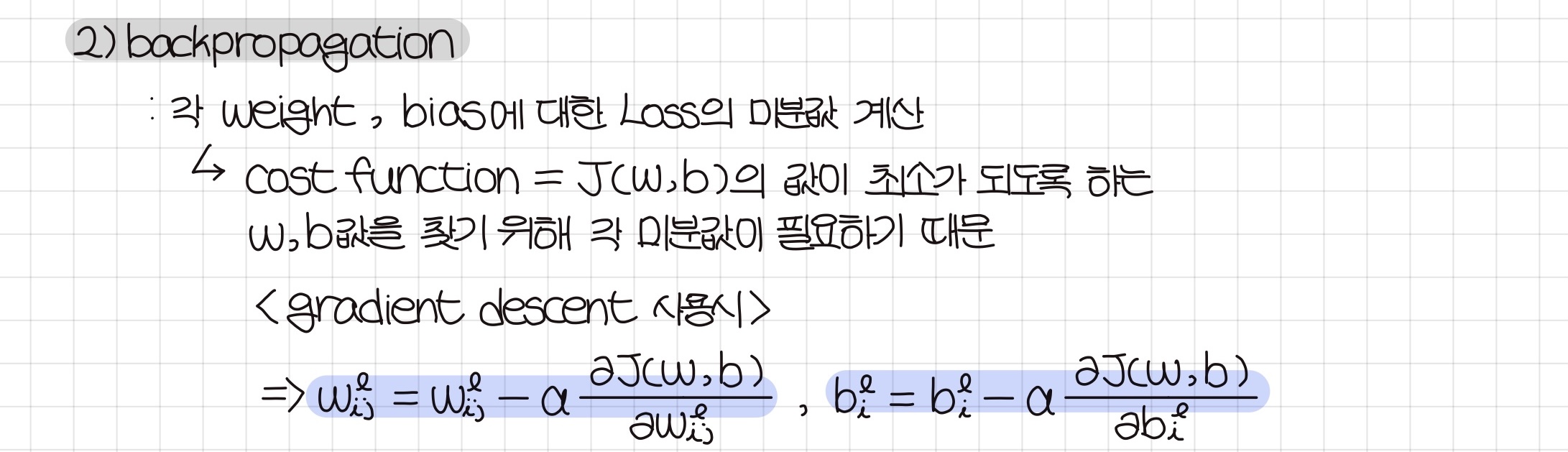

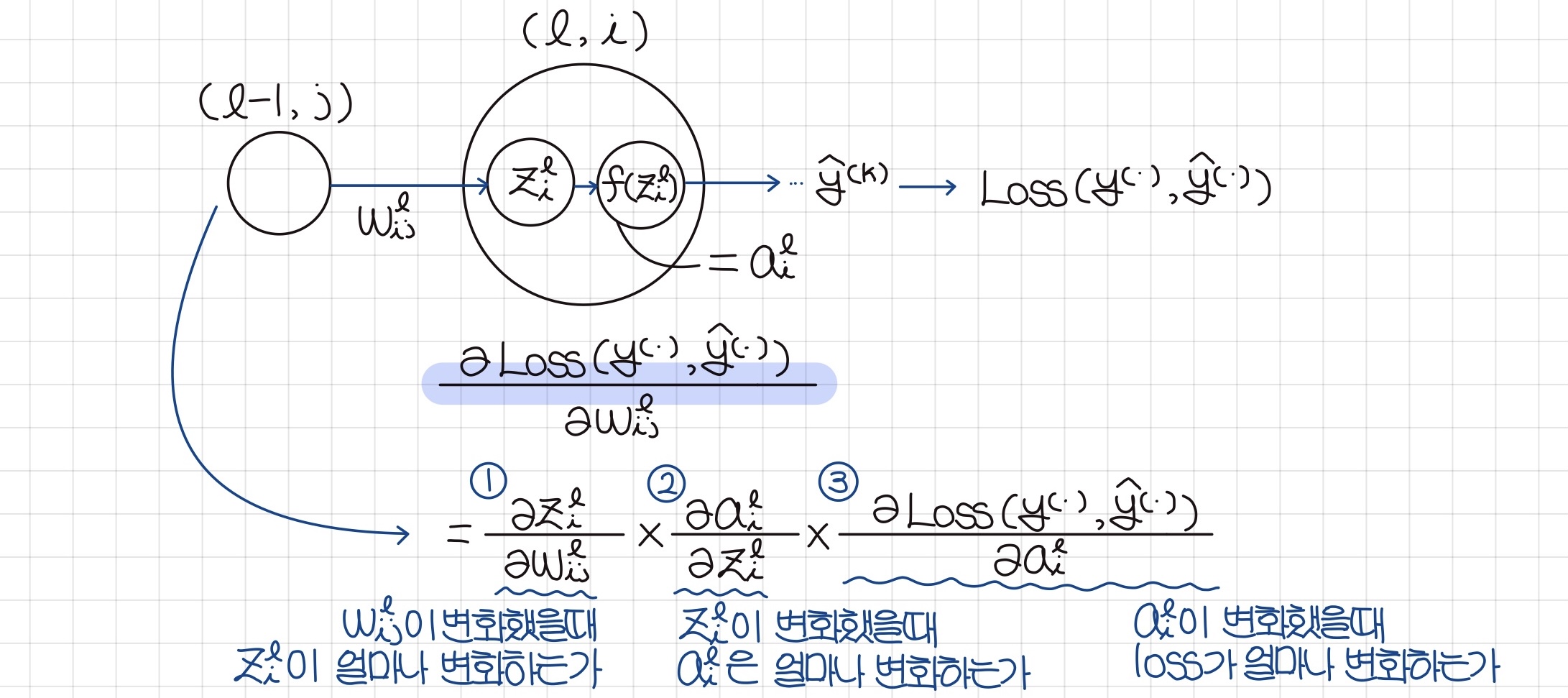

2. Backward Propagation

기본 Concept

Weight에 대해 J(w,b) 미분

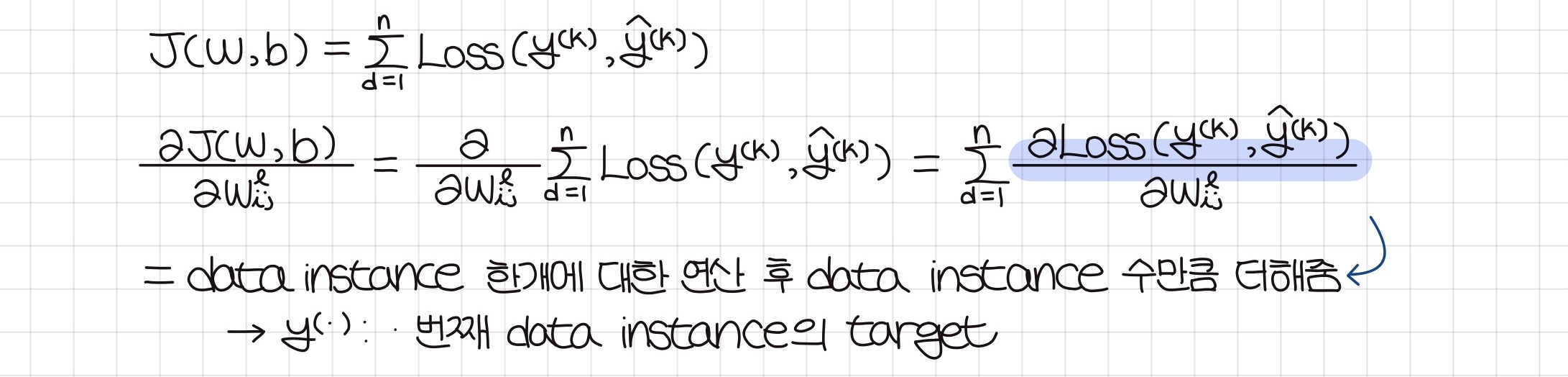

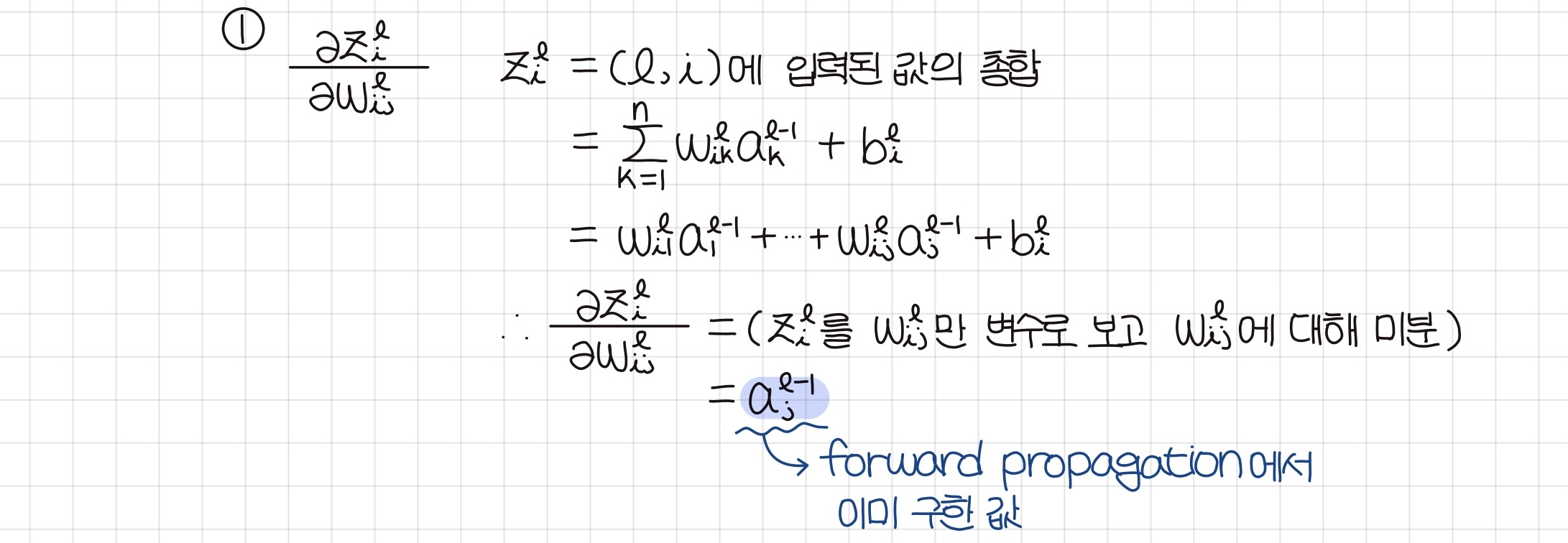

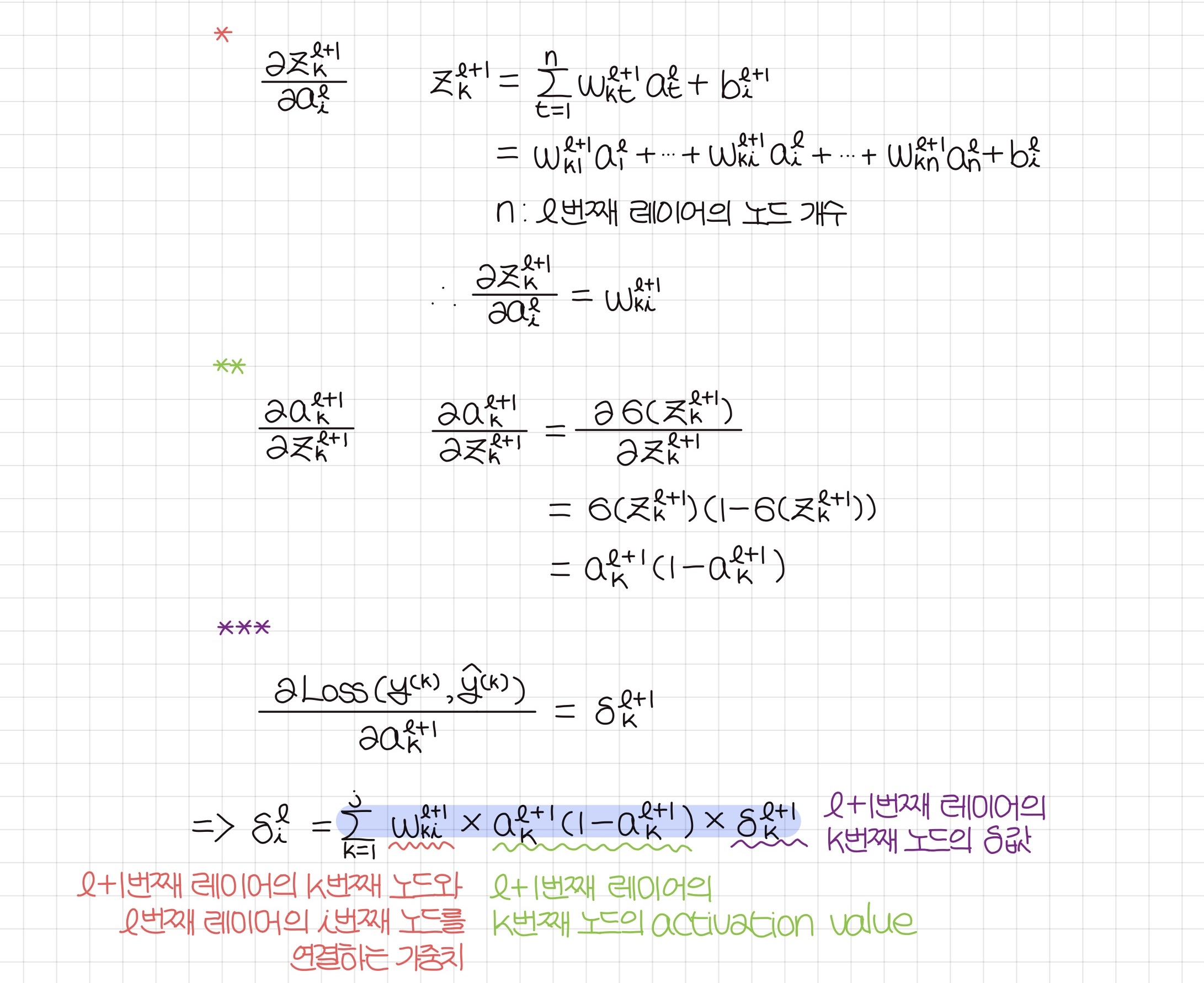

(1) 쪼갠식 - 1

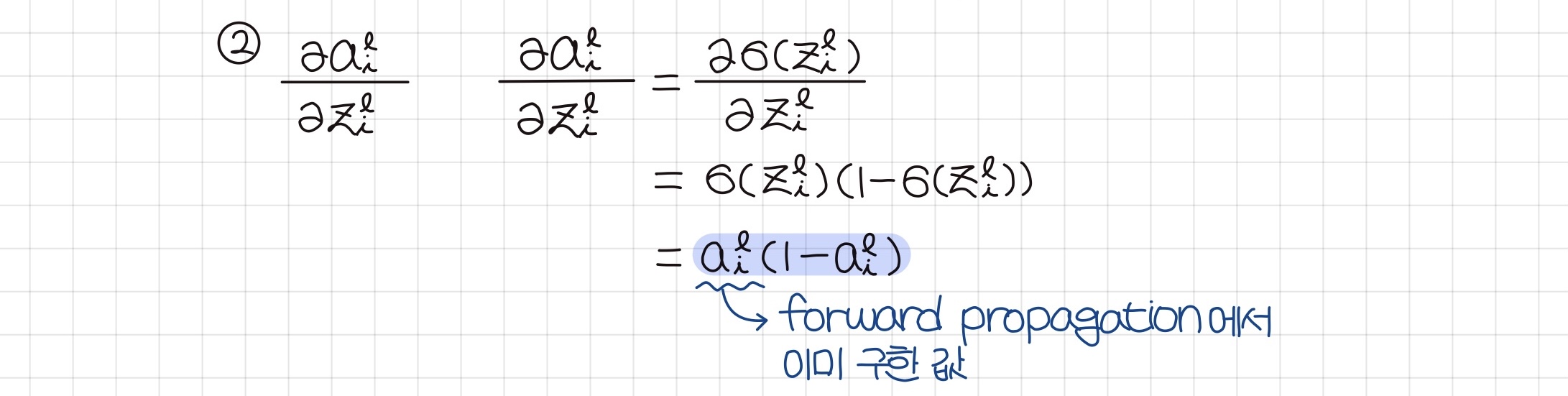

(2) 쪼갠식 - 2

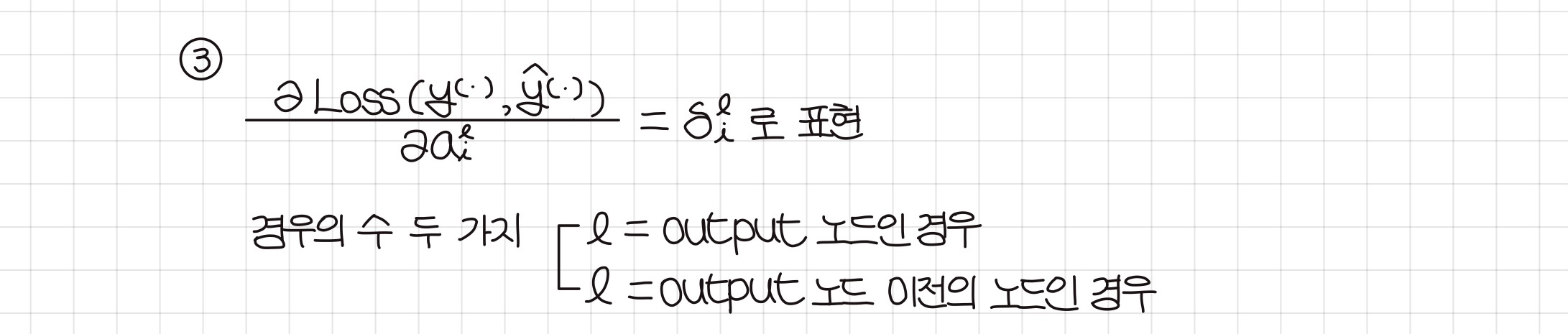

(3) 쪼갠식 - 3

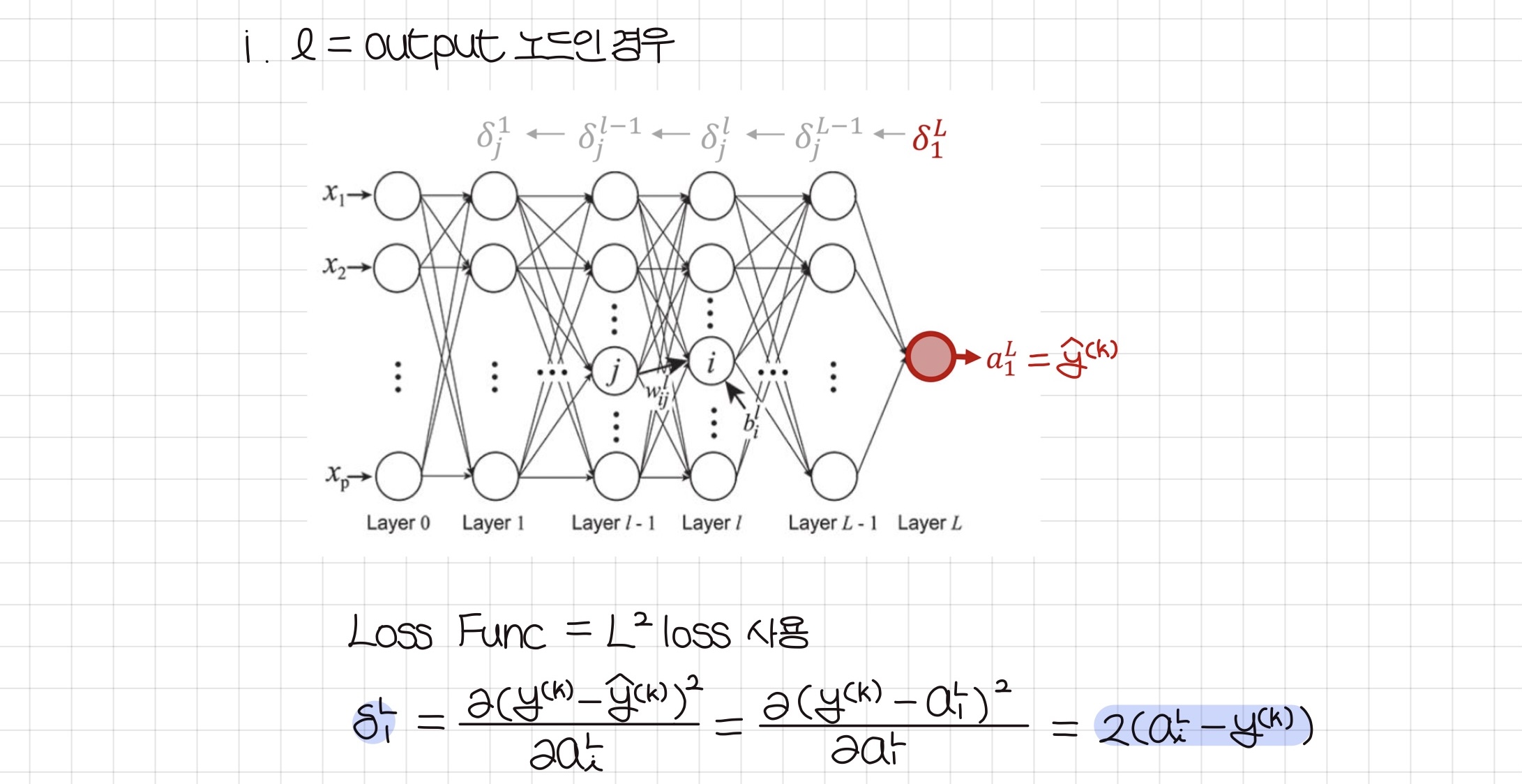

- 구하려는 델타값의 레이어가 output 레이어인 경우

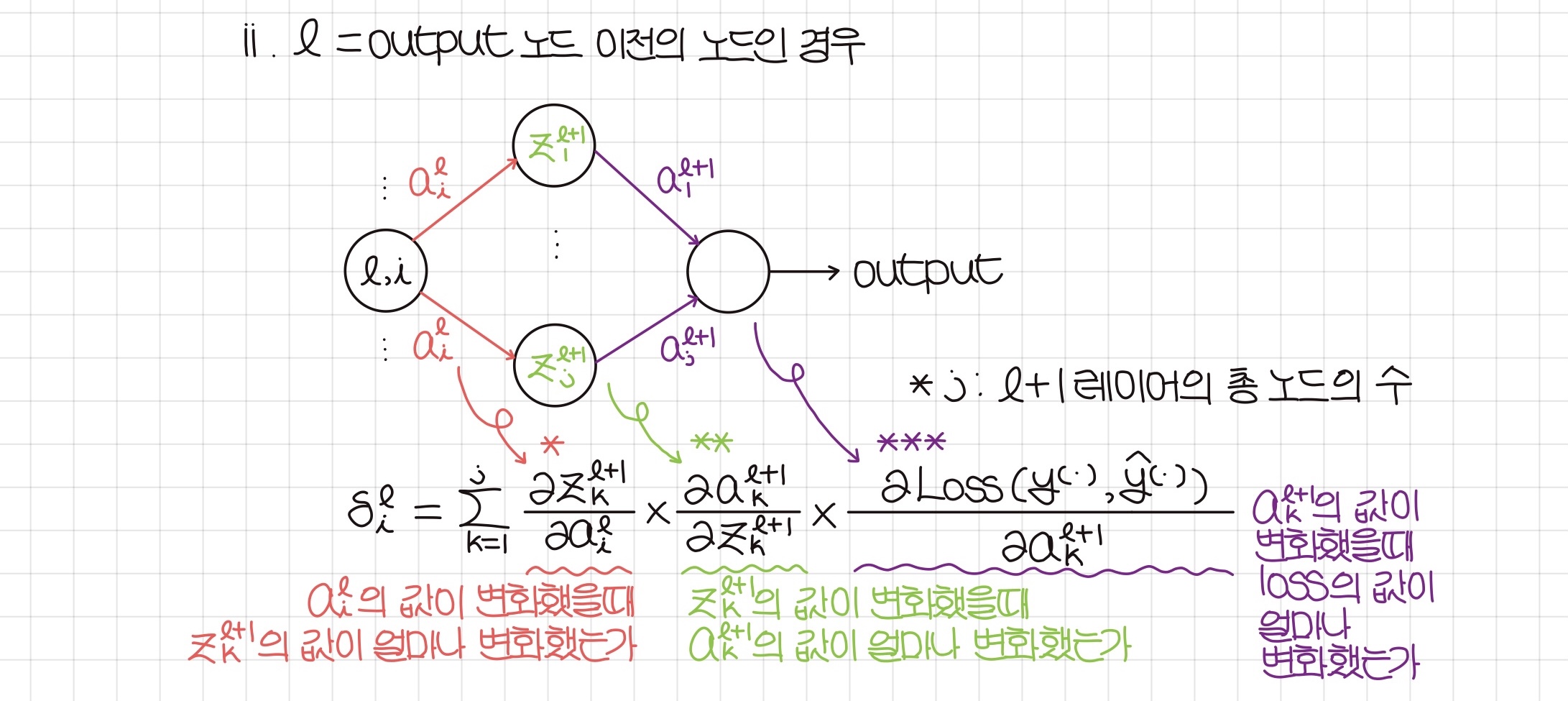

- 구하려는 델타값의 레이어가 output 레이어가 아닌 경우

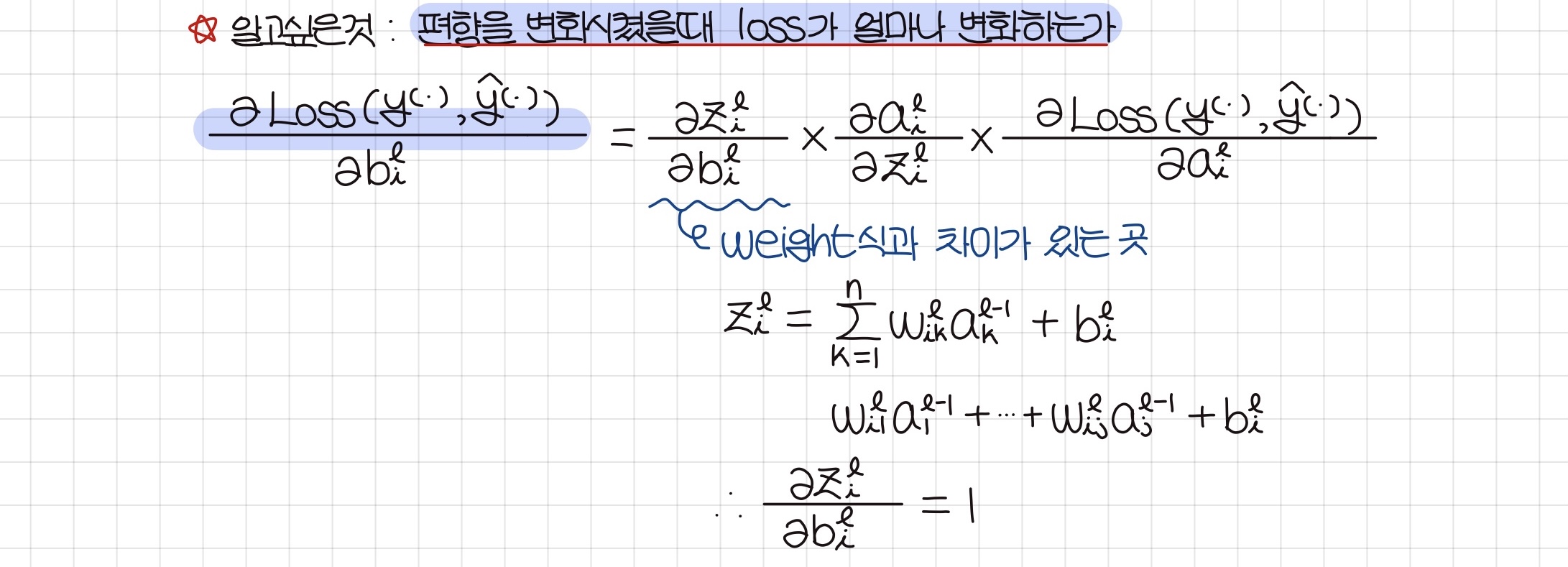

bias에 대해 J(w,b) 미분

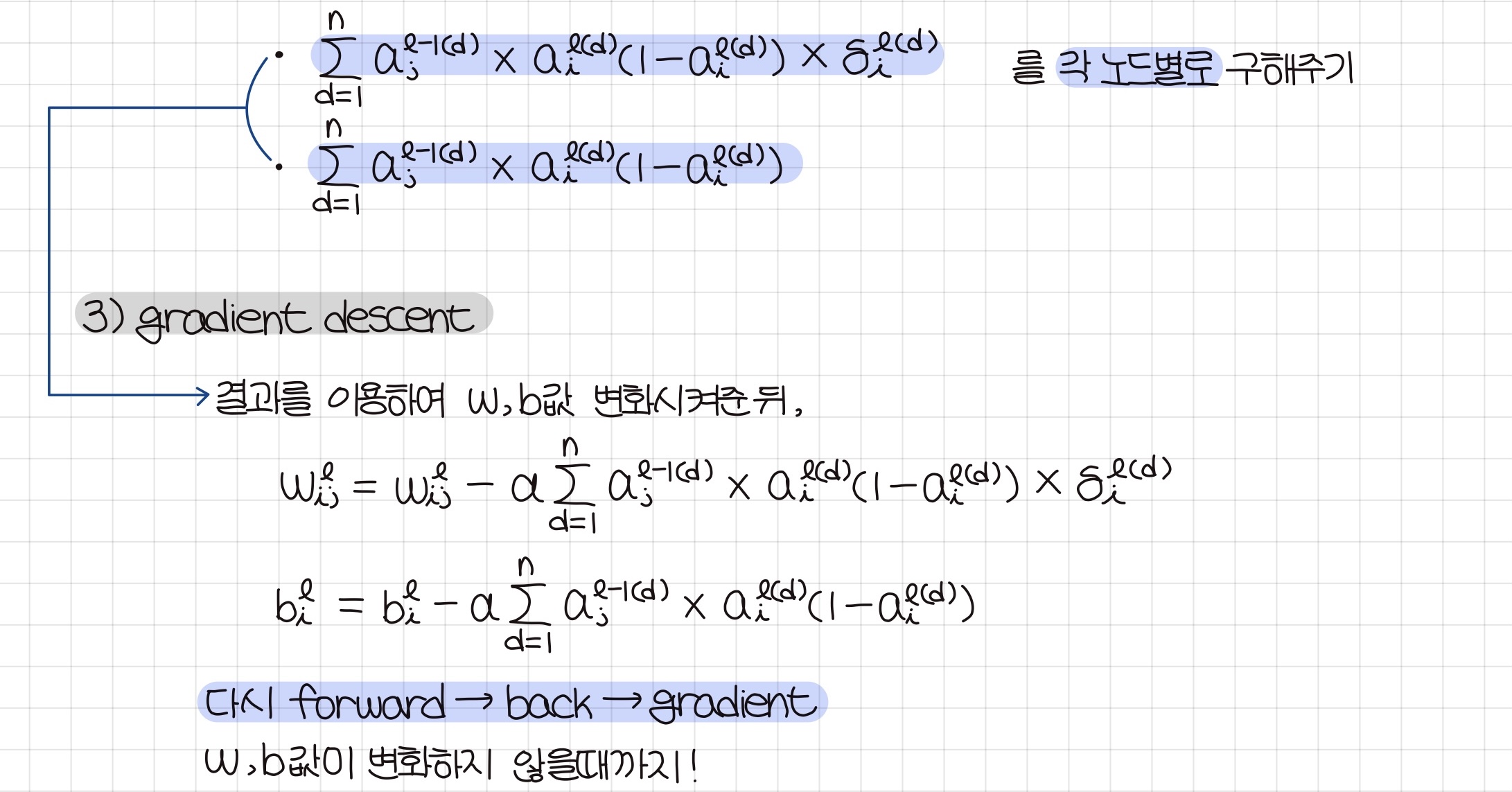

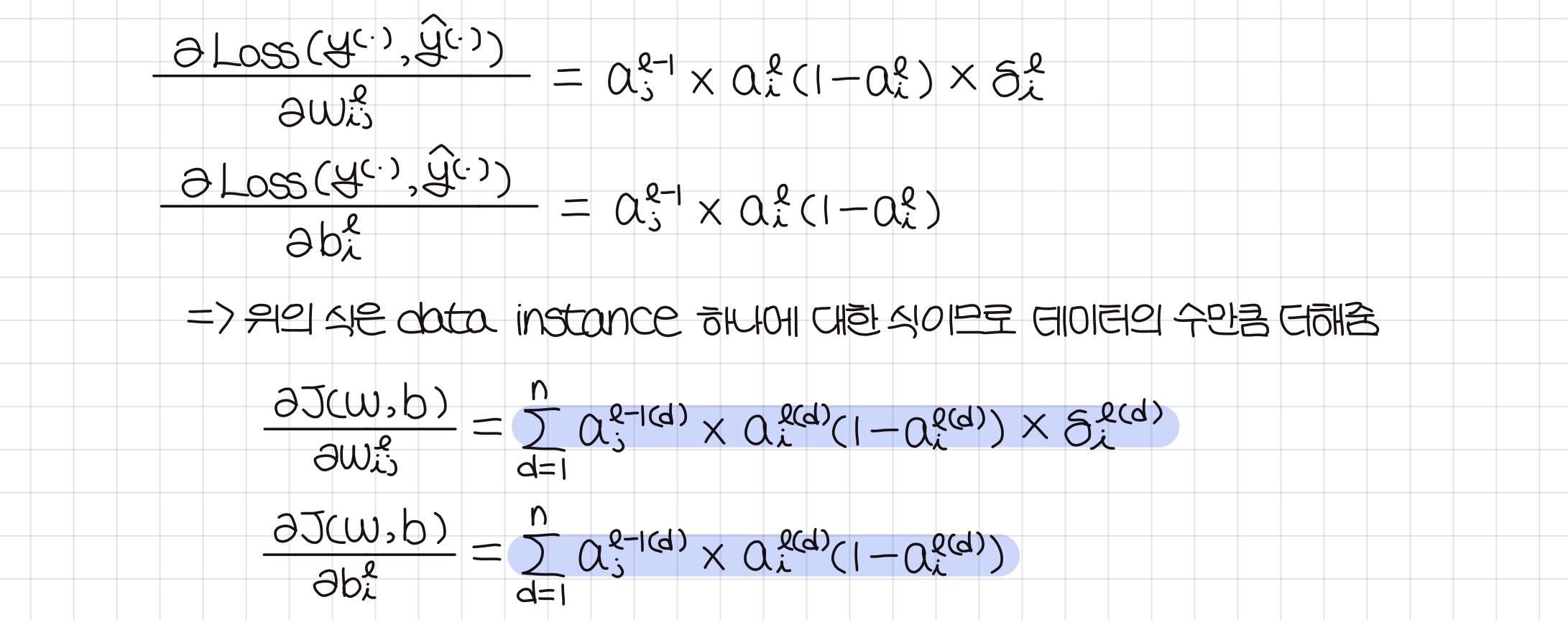

결과

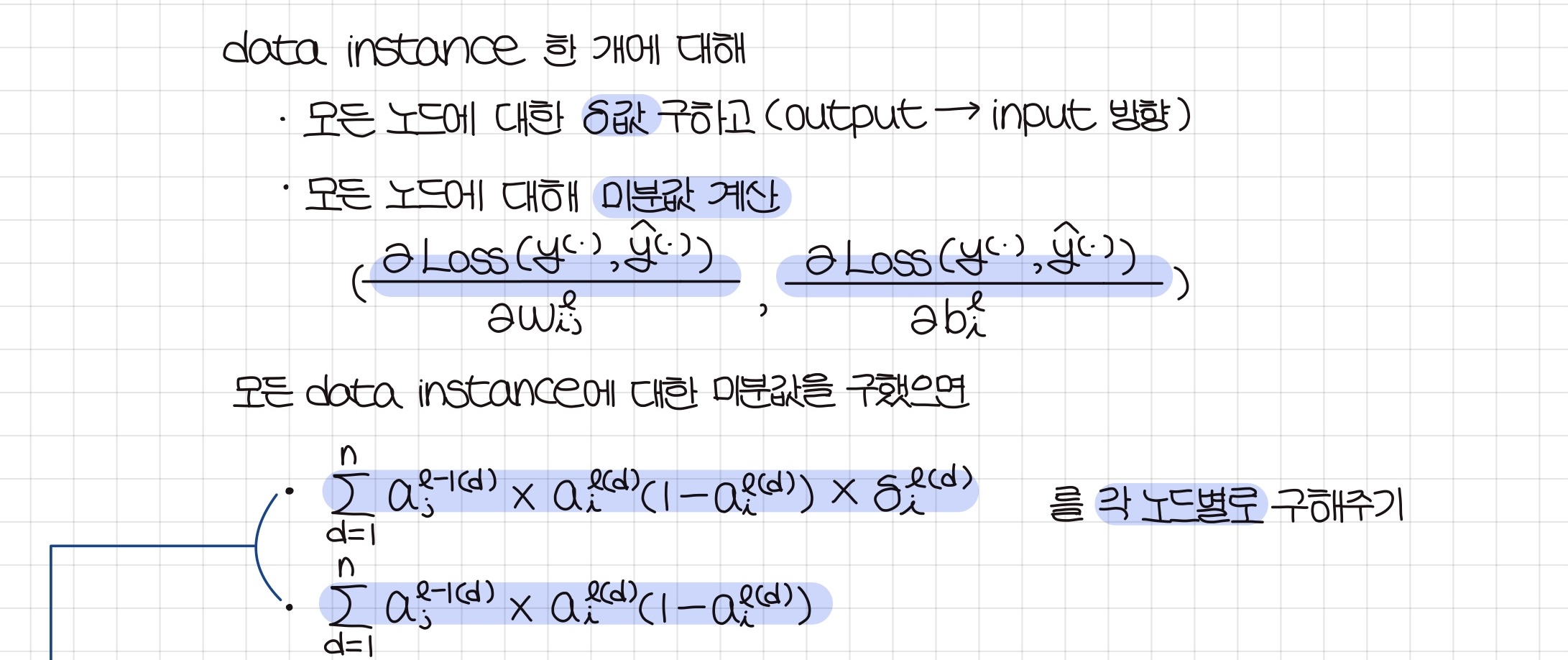

과정

3. Gradient descent