crontab??

특정 시간에 작업을 예약하는것, 즉 Linux 및 Unix 시스템에서 작업을 자동화하는데 사용되는 유틸리티입니다. crontab은 cron 데몬에 의해 로드되고 작업을 실행합니다.

💡 필드의 형식

- 분

- 시간

- 날짜

- 월

- 요일

각 필드는 0에서 59사이의 숫자 또는 를 사용할 수 있습니다. 는 모든 값을 의미합니다.

예를 들어 * * * * *는 매분마다 작업을 실행합니다.

예를 들어 매일 오전 10시마다 ls 작업을 수행하고 싶다면

crontab -e 를 통해 들어간뒤

0 10 * * * ls

를 작성한뒤 :wq를 하면 완성입니다

crontab으로 매일 16시40분의 주식 10개를 알아보기

그렇다면 먼저 일정시간에 실행하기위한 크롤링 파이썬코드를 완성하겠습니다.

파이썬 코드는 krx에서 종목의 코드를 가져온뒤

네이버 증권 api를 통해서 값을 가져오는 방식을 하였습니다.

- stock.py

from datetime import date, datetime

import requests

import pandas as pd

krx_url = "http://data.krx.co.kr/comm/bldAttendant/getJsonData.cmd"

krx_payload = {"bld": "dbms/MDC/STAT/standard/MDCSTAT01901",

"locale": "ko_KR",

"mktId": "ALL",

"share": "1",

"csvxls_isNo": "false",}

today = str(date.today()).replace("-","")

r= requests.post(krx_url, data=krx_payload)

total = []

for x in r.json()['OutBlock_1'][:10]:

symbol = x['ISU_SRT_CD']

url = f"https://api.finance.naver.com/siseJson.naver?symbol={symbol}&requestType=1&startTime={today}&endTime={today}&timeframe=day"

df =pd.DataFrame(data=eval(requests.post(url).text.strip())[1:], columns=eval(requests.post(url).text.strip())[0])

df['symbol'] = symbol

total.append(df)

pd.concat(total, ignore_index=True).to_csv(f"./{today}.csv", index=False)batch.sh 파일 작성하기

💡batch.sh파일의 형식

{python3의 경로} {stock.py의 경로}

💡python3의 경로

which python3를 통해서 나온 경로를 복사해 둡니다.

이제 crontab -e 를 통해서 실행시킬 batch.sh가 필요합니다.

vim batch.sh 를 통해서 위의 형식처럼 파일을 작성합니다.

그리고 나서는 batch.sh의 권한을 주어야 합니다.

💡batch.sh 권한 주기

chmod 777 batch.sh

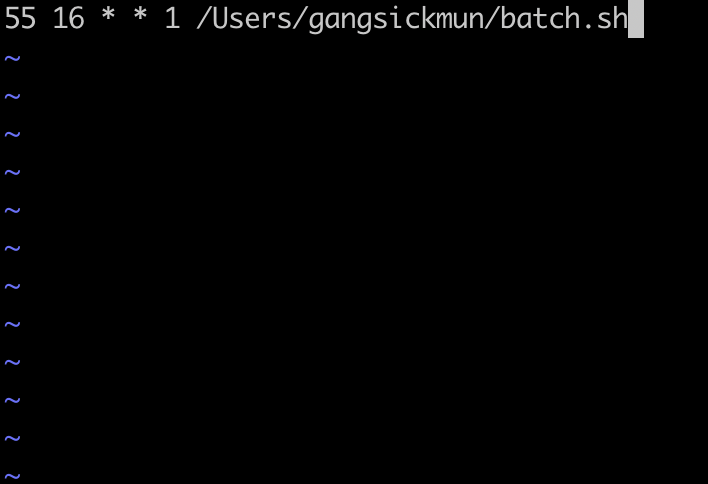

crontab 작성하기

crontab -e 를 통해서 들어가 줍니다.

그리고 이제 월요일마다 16시 55분의 주식을 csv파일로 저장할것이기 때문에 조건에 맞춰서 작성해줍니다.

이렇게 까지하면 끝입니다.

💡crontab 리스트 확인하기

crontab -l