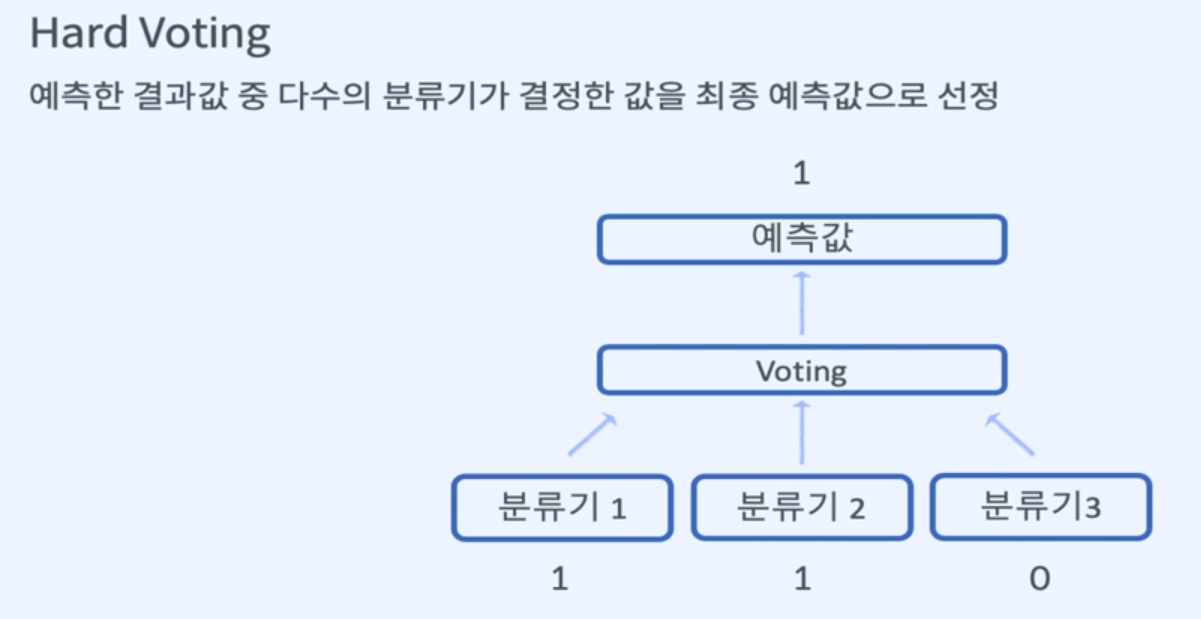

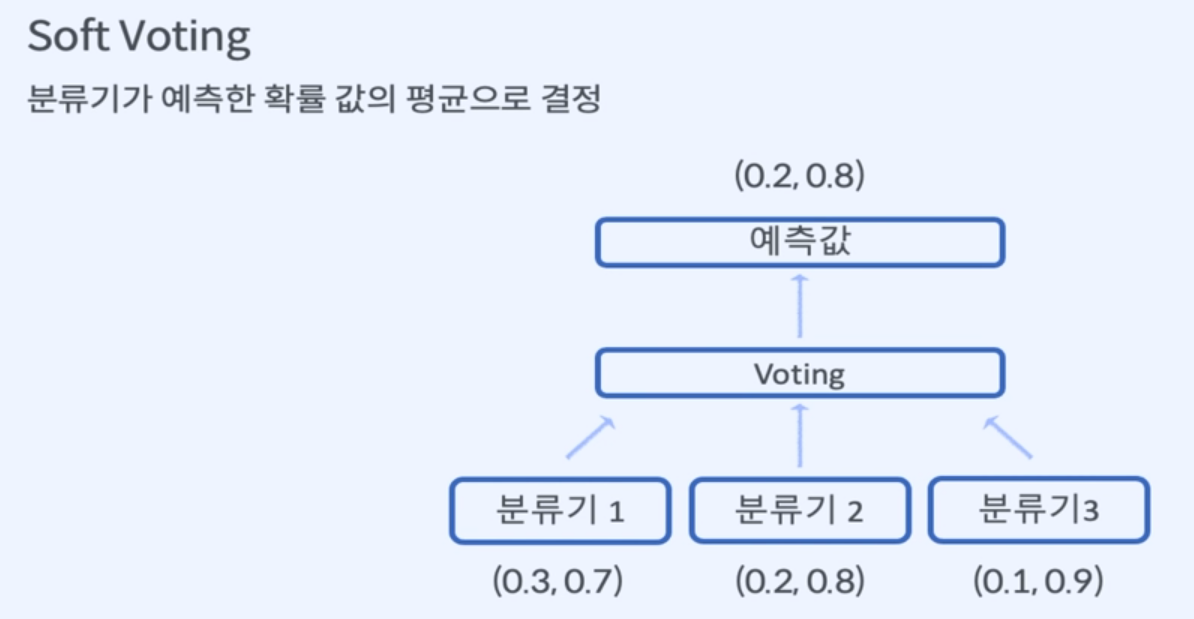

1. Bagging

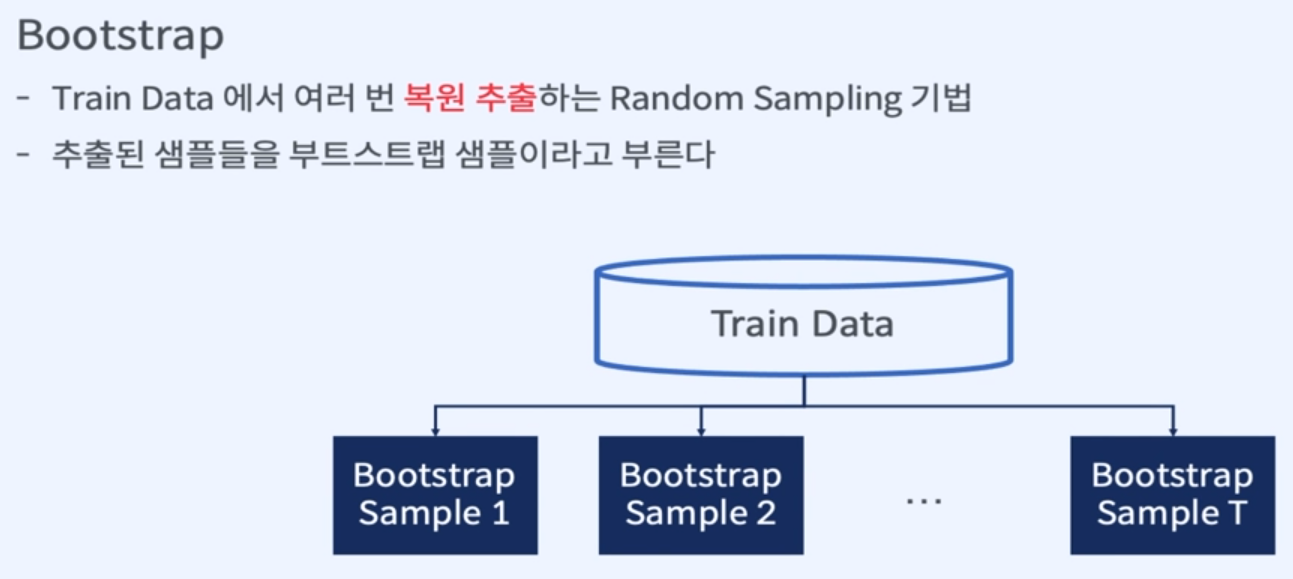

Bootstrap

Aggregation

장점

- 분산을 줄이는 효과

- 원래 추정 모델이 불안정하면 분산 감소 효과를 얻을 수 있다.

- overfitting이 심한 모델에 적합

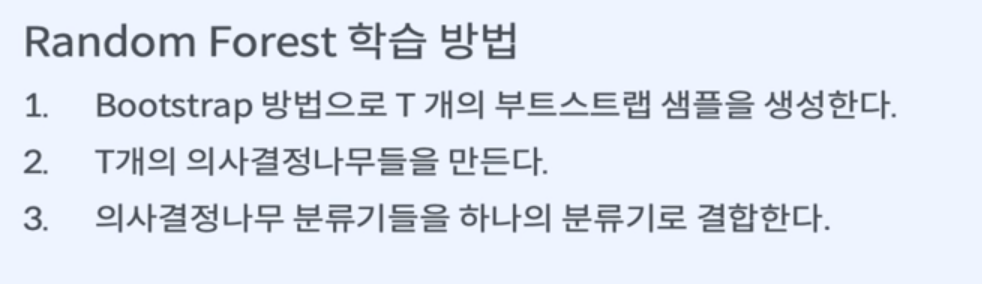

2. RandomForest

Decision Tree + Bagging

- 분산이 큰 DecisionTree + 분산을 줄일 수 있는 Baggin

장점

- Decision Tree의 overfitting을 해결

- noise 데이터에 영향을 크게 받지 않는다.

- Decision Tree 모델 복잡도가 적다.

단점

- 모델 예측 결과를 해석하고 이해하기 어렵다.