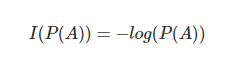

1. Shannon Information

- 사건이 일어났을 때를 가정한다.

-

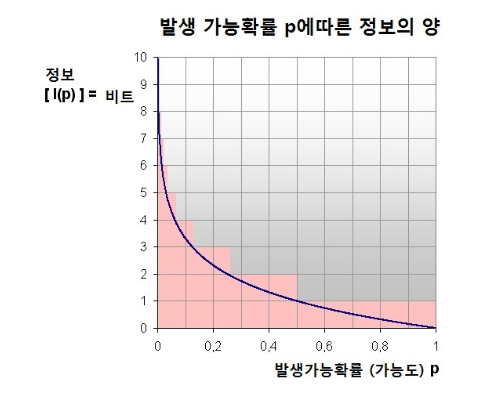

일어나는 사건의 확률이 낮을 수록 정보의 양이 많고

확률이 높을 수록 정보의 양의 적다. -

ex) 아침에 해가 뜰 확률은 1에 가깝다. 즉, 정보 양이 없다.

-

ex) 내가 유명 여배우랑 연애할 확률은 0에 가깝다.

즉, 연애를 한다면 정보 양이 많아진다. 뉴스 기사가 뜨거나

유튜브에 실린다거나 인터뷰를 받는다거나 등

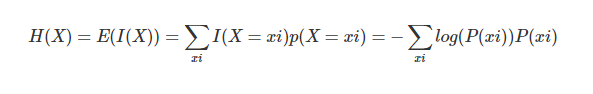

2. Shannon Entropy

-

정보량의 기댓값

-

예측하기 어려울 수록 불확실성은 높아지고

예측하기 쉬울 수록 불확실성은 낮아진다.

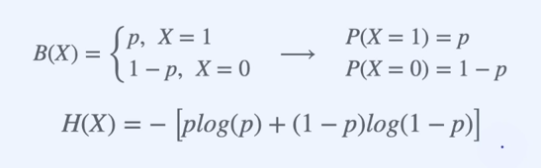

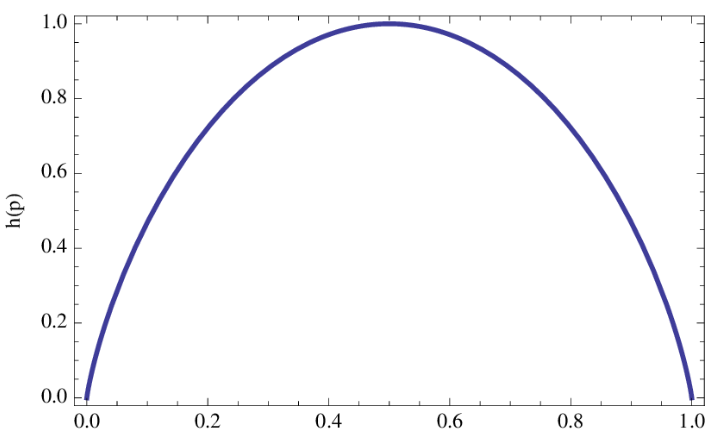

3. Binary Entropy

- 이항분포에 대한 Entropy

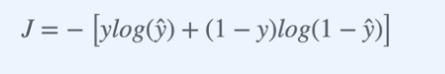

4. Binary Cross Entropy

- 서로 다른 확률분포 사이의 유사성 ( 서로 얼마나 닮아있는지 )을 수치화 한 것.

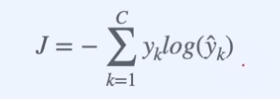

5. Cross Entropy

- Binary Cross Entropy를 general하게 만든 것