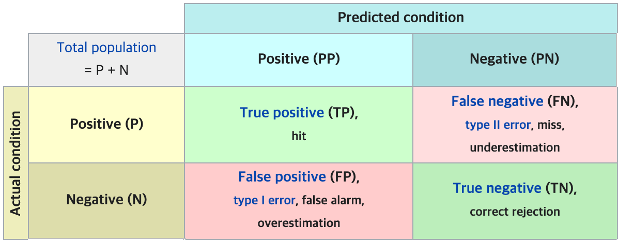

<TP / TN / FP / FN>

•True Positive(TP) : 실제 Positive 인 정답을 Positive 라고 예측 (정답) (올바르게 잘 예측한 것)

•True Negative(TN) : 실제 Negative 인 정답을 Negative 라고 예측 (정답) (거절해야할것을 잘 거절한것 (아닌걸 아닌거라고 한 것))

•False Positive(FP) : 실제 Negative 인 정답을 Positive 라고 예측 (오답) (예측한것 중에 잘못 예측한 값)

•False Negative(FN) : 실제 Positive 인 정답을 Negative 라고 예측 (오답) (잘못 예측한 값)

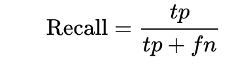

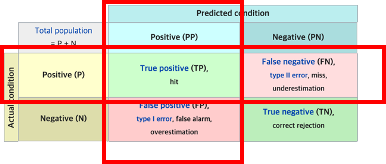

<Precision & Recall>

Precision : 예측한 값들 중 얼마나 정확한지

Recall : 실제 True 중에 얼마나 잘 예측했는지

< F1 Score>

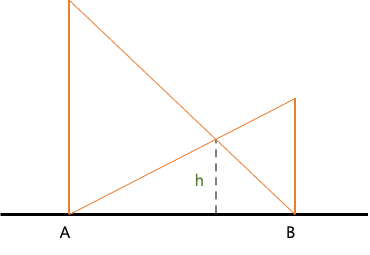

- 조화평균은 A 높이에서 B까지 선을 내리고, B에서 A로 선을 내리면 h라는 높이가 나오게 되는데, 여기서 h는 조화평균의 절반값입니다.

만약 다음과 같이 Precision 값이 recall 값에 비해 훨씬 큰 경우 작은 값인 recall 값 근처에 조화 평균 값이 계산되고, 마찬가지로 Recall 값이 precision 값에 비해 훨씬 클경우 조화평균은 precision 값 근처로 계산 결과가 나오게 됩니다.

이 처럼 조화 평균을 사용했을 때, 작은 값위주로 평균을 내기 때문에 f1 score는 inbalance 한 데이터에서 사용하기 적합니다.

(큰 값에 패널티 주는 개념으로 이해)

F1 score는 Precision과 recall 값을 이용해 다음과 같이 계산됩니다.

출처 : https://eunsukimme.github.io/ml/2019/10/21/Accuracy-Recall-Precision-F1-score/