신경망이란 무엇인가? | 1장 딥러닝에 대하여 영상을 보고 셀프 기록

딥러닝과 머신러닝의 차이를 구글링하는 도중에 신경망이란 무엇인가라는 유튜브 영상에까지 이르렀다.

처음 보았던 영상은 Backpropagation(역전파)에 대한 내용이였는데, 예전 선형대수 시간에 배웠던 것을 훨씬 더 쉽고 이해하기 쉽게끔 그래픽과 함께 가르쳐 주는 영상이였다. 하지만... 경사하강법이 나오고 뭐.. 나오고 예전에 까먹었었던 선형대수 개념이 나오길래 이 재생목록의 첫 번째 영상부터 차근히 보고자 결심했다.

신경망은 우리 인간의 뇌를 기반으로 만들어진 것이다. 뉴런에 0~1까지의 데이터가 담긴다고 가정한다.

뭐 상세한 내용은 나중에 정리할거고 일단 지금 기록하고 싶은것은

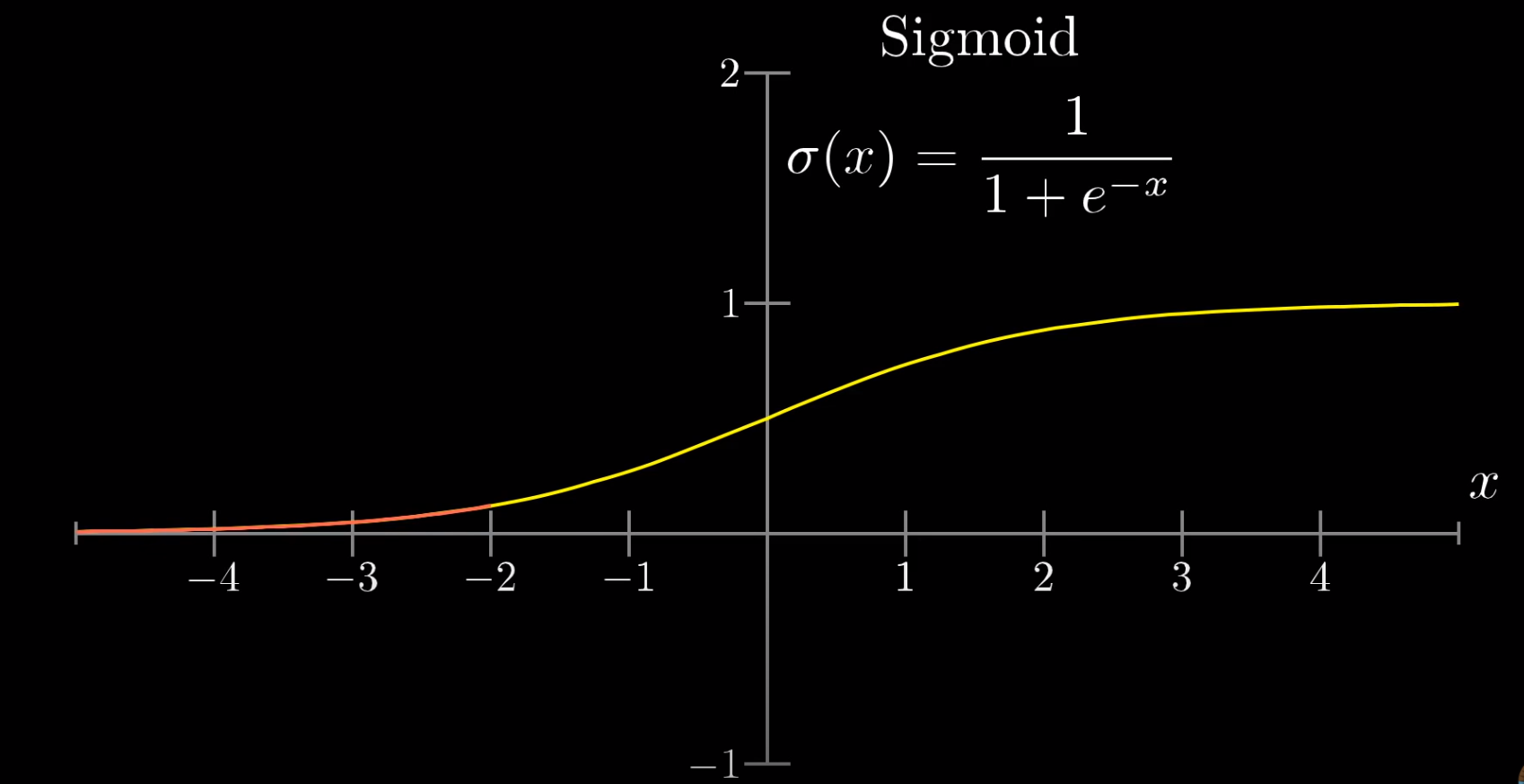

시그모이드 함수 이거다

시그모이드 함수란 로지스틱 방정식의 한 종류로 숫자를 주어주면 0과 1사이의 값으로 만들어준다. 매우 작은 음수는 최대한 0에 가깝고, 0 주변의 값은 증가하며, 매우 큰 양수는 최대한 1에 가깝게 표현되는 함수이다.

일단 이것만 기록해두고 다시 영상보러가야징

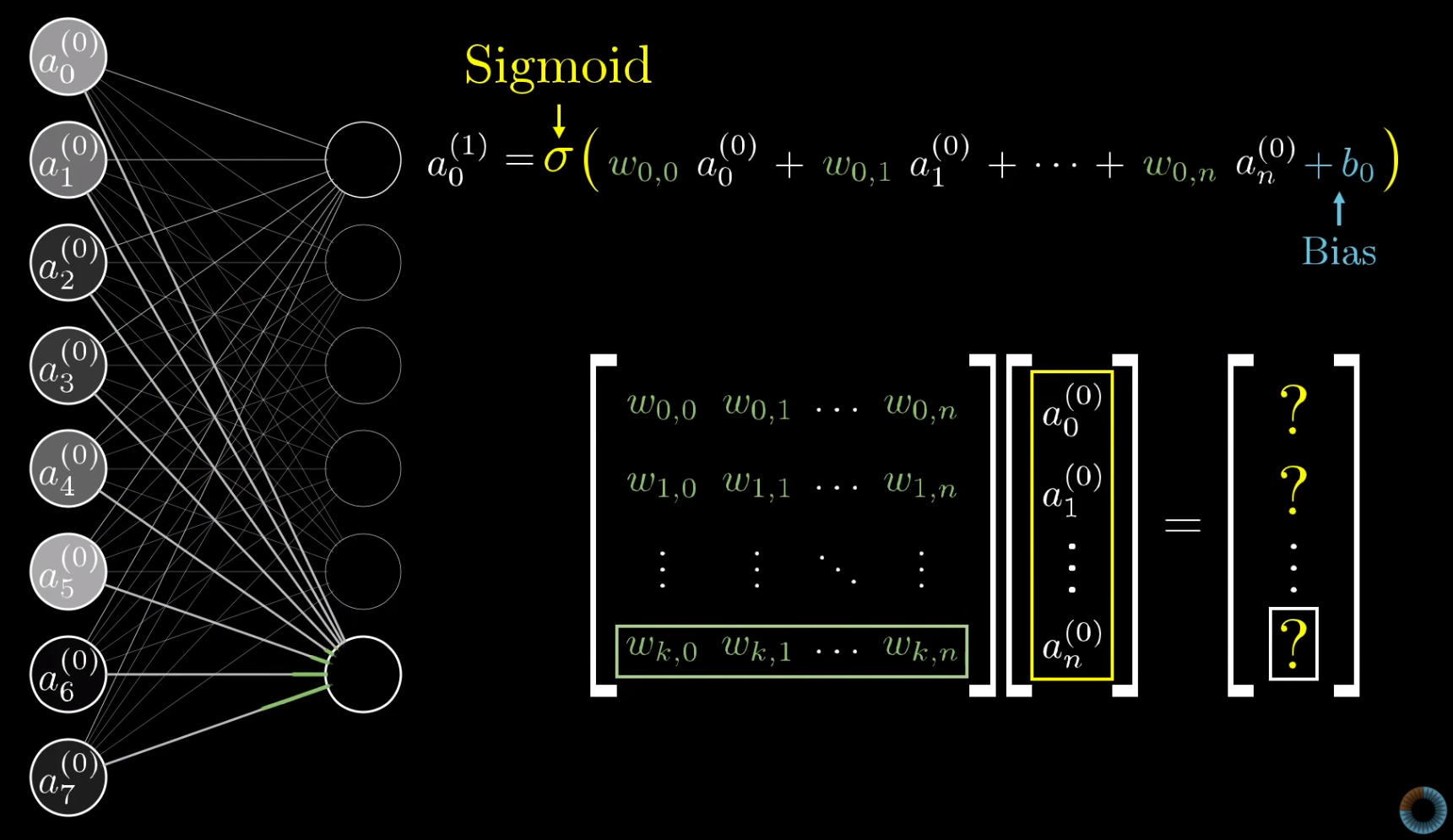

bias에 대한 개념

영상을 조금 더 보고 왔다.

bias는 성향으로 이해하면 될 것 같다.

bias의 값에 따라 뉴런 x 가중치가 내가 원하는 패턴에 근접하더라도

최종적으로 시그모이드로 덮었을 때 값이 달라질 수 있다.

즉 bias는 뉴런이 활성화 되려면 가중치의 합이 얼마나 더 높아야 하는지 일종의 허들?의 역할을 한다고 (내가 그렇게 이해했음...)

bias는 시그모이드로 감싸기 전에 계산해준다!

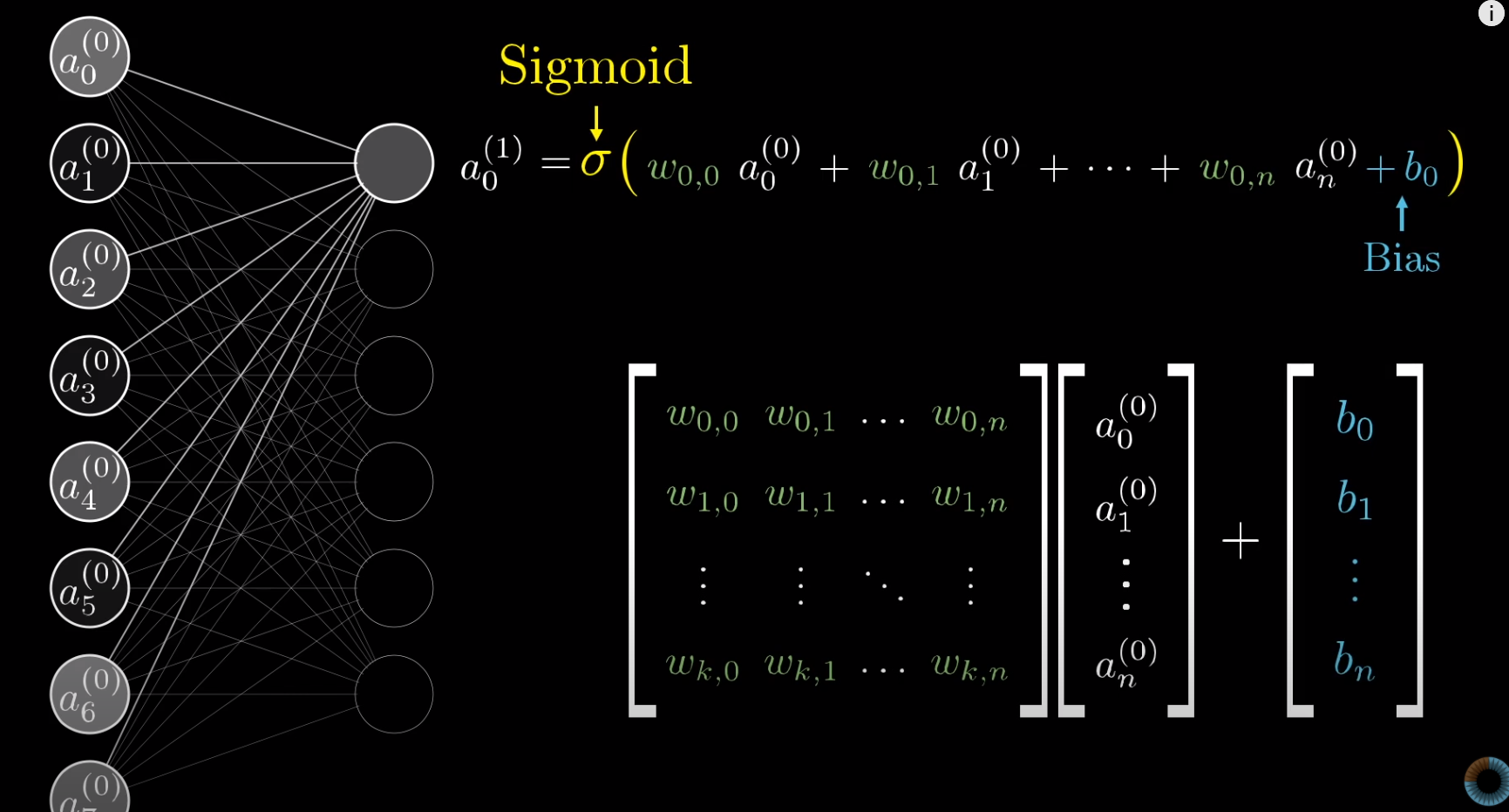

이제 하나의 뉴런에 대해서 얘기했다.

이를 수식으로 간단히 표기해보자. 저기 보이는 무수히 많은 선들이 가중치 값이다.

저기 보이는 무수히 많은 선들이 가중치 값이다. 첫번째 레이어의 784개의 뉴런들에 가중치를 곱에다가 마지막으로 bias값들을 더한다.

첫번째 레이어의 784개의 뉴런들에 가중치를 곱에다가 마지막으로 bias값들을 더한다.

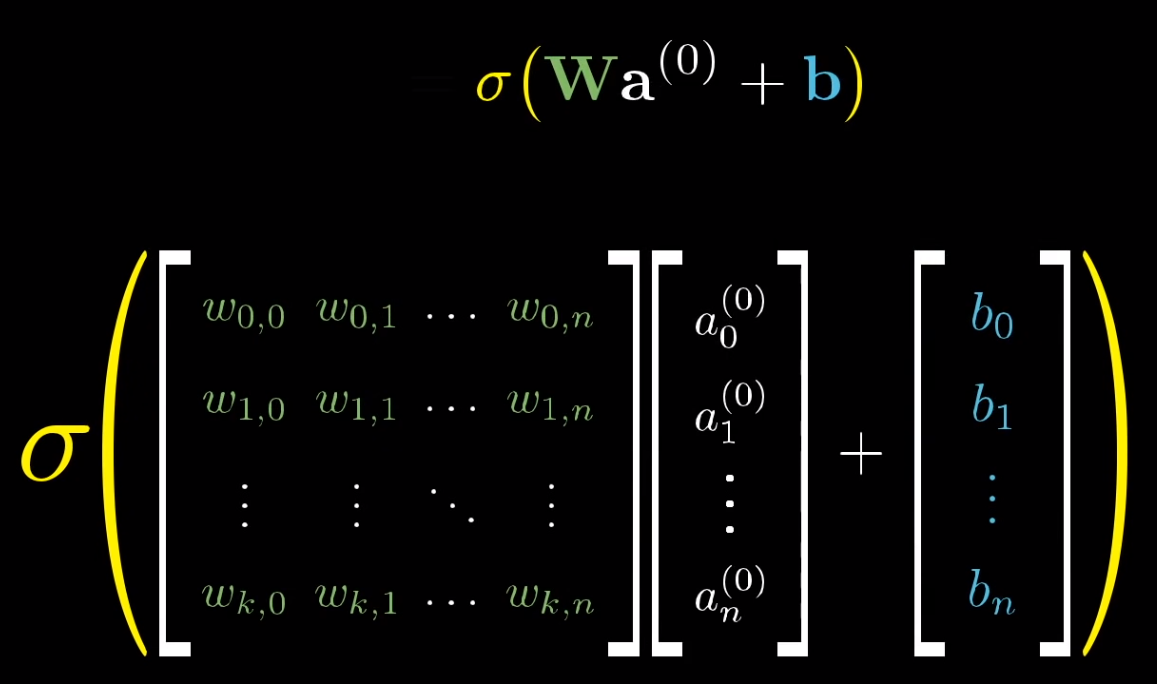

이제 마지막으로 시그모이드 함수로 감싸준다.

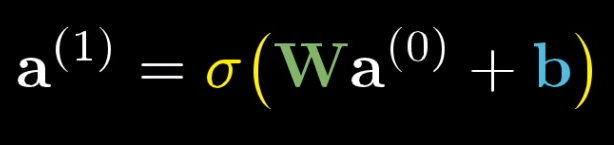

그러면 수식은 다음과 같이 정리된다.

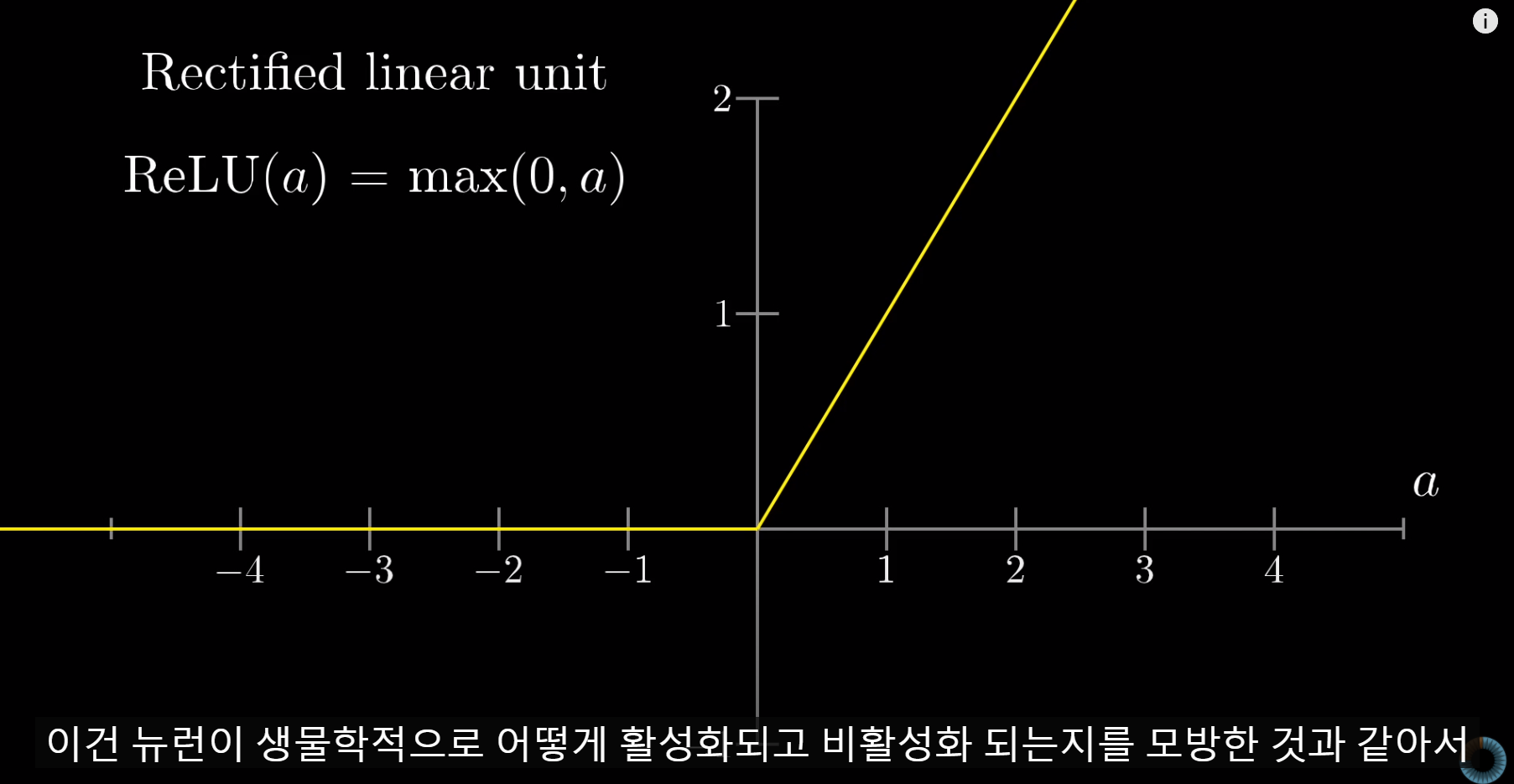

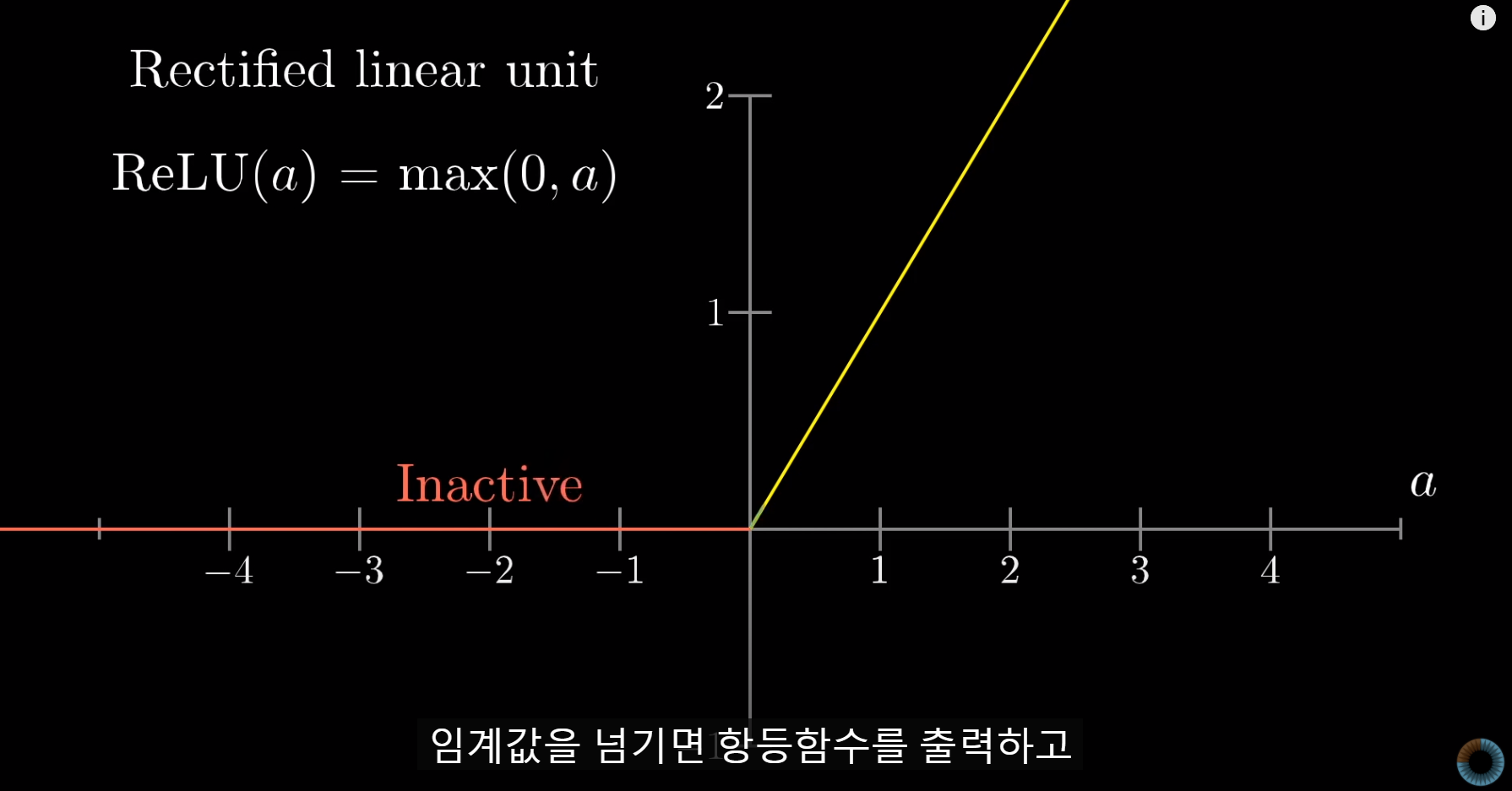

초기 Network는 시그모이드 함수를 가중치가 적용된 합들을 0과 1사이의 값으로 압축하기 위해 이용했다. 이는 생물학적으로 뉴런이 활성화되는지 비활성화 되는 생물학적인 현상을 모방한 것이라고 한다.

현재는 이것이 old school(옛날 방식)이라고 한다.

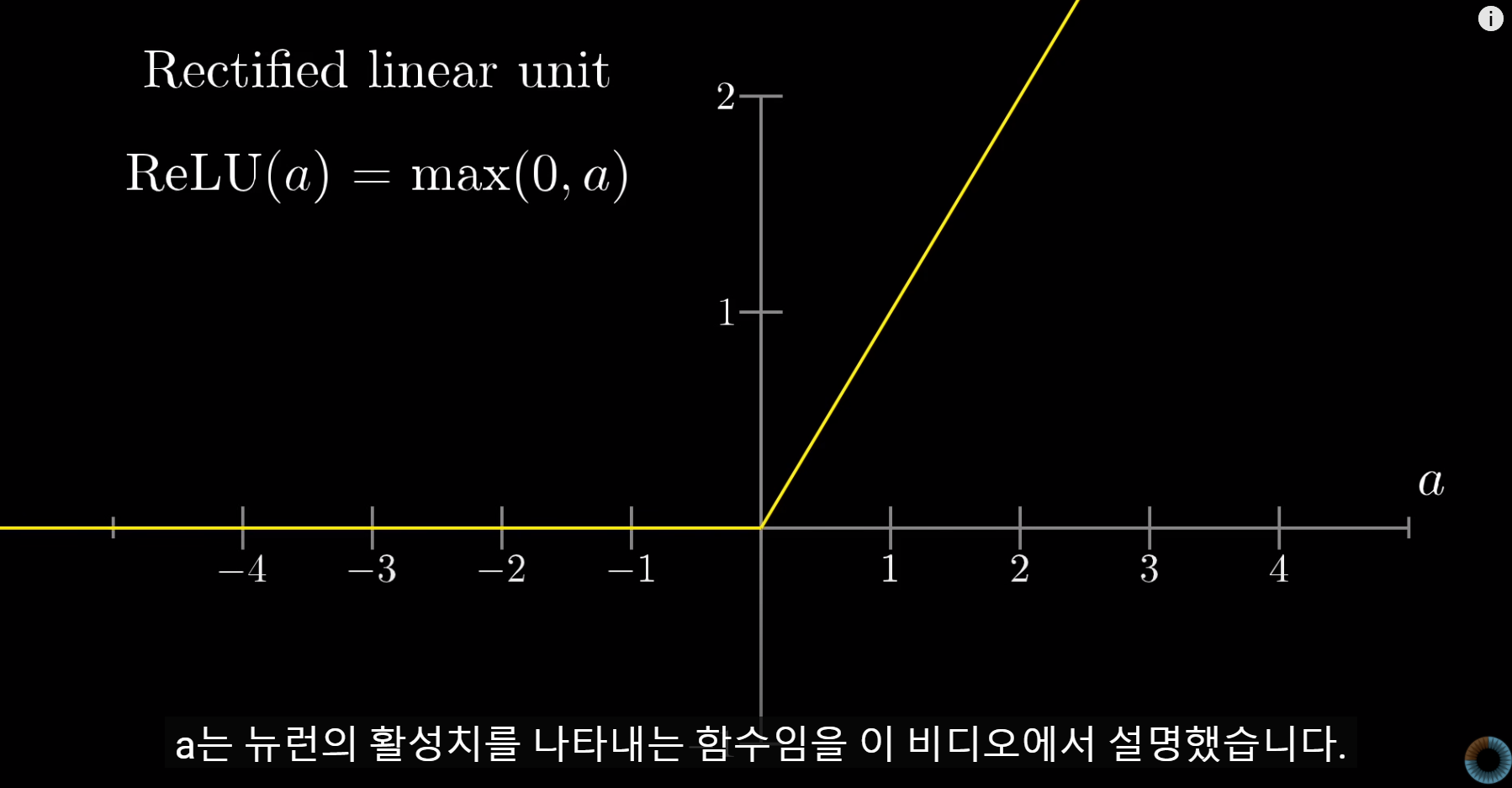

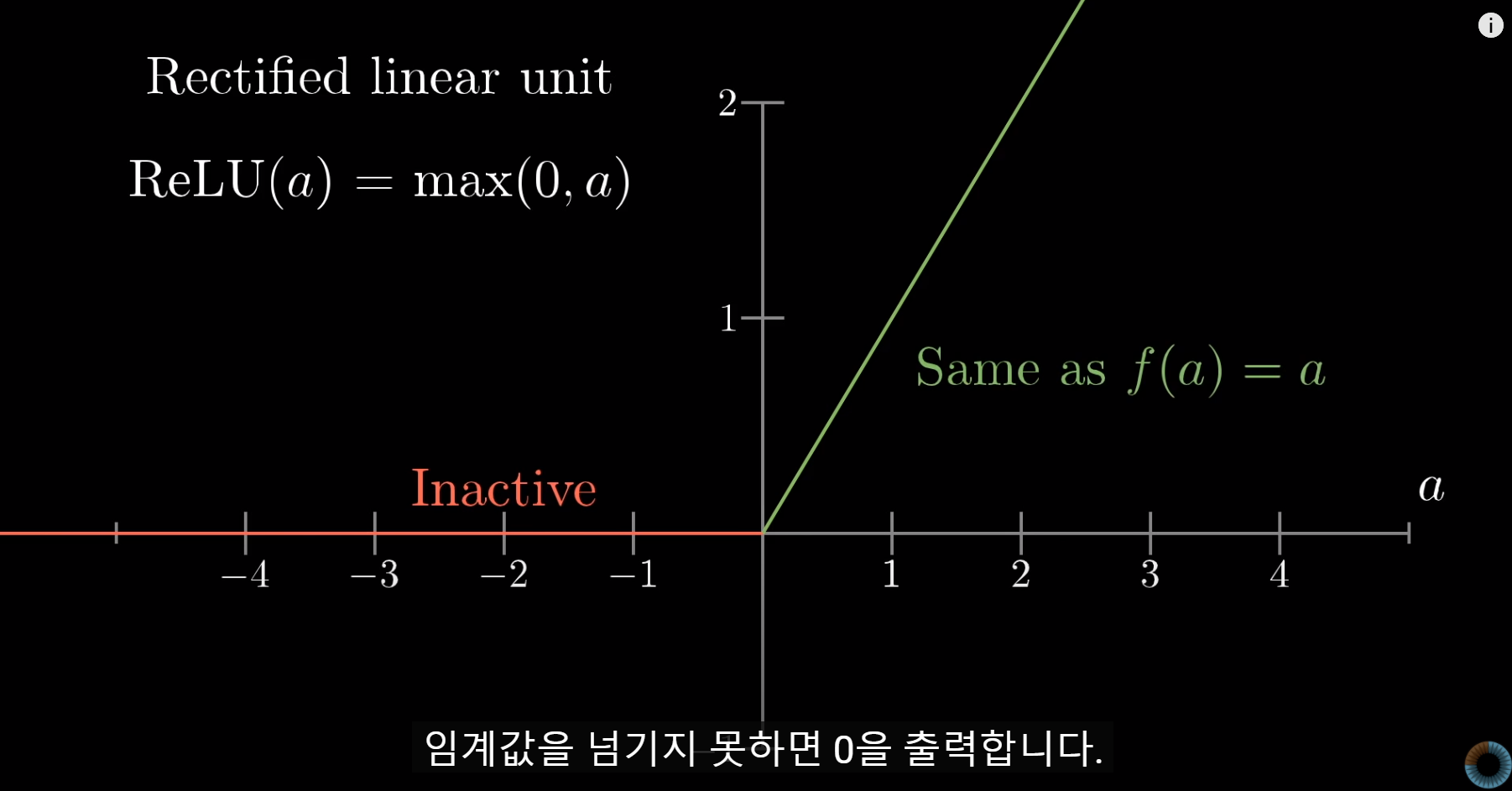

요즘은 ReLU(a) 함수(Rectified Linear Unit 선형 정류 유닛)를 사용한다고 한다.

ReLU(a) = max(0,a)

ReLU 함수를 사용하는 이유는 시그모이드 함수로는 신경망 훈련이 잘 되지 않는다고 한다. 근데 누군가가 ReLU 함수를 사용해보았더니 아주 깊은 신경망에서도 훈련이 잘 되었다고 한다.