[논문리뷰] DKT: Diverse Knowledge Transfer Transformer for Class Incremental Learning

1

논문정리

- 학회: CVPR'23

- 저자: Xinyuan Gao et al.,

- 링크: https://openaccess.thecvf.com/content/CVPR2023/papers/Gao_DKT_Diverse_Knowledge_Transfer_Transformer_for_Class_Incremental_Learning_CVPR_2023_paper.pdf

Task

Class Incremental Learning (CIL)

Motivation

1) Feature Degradation

2) Stability-Plasticity Dilemma

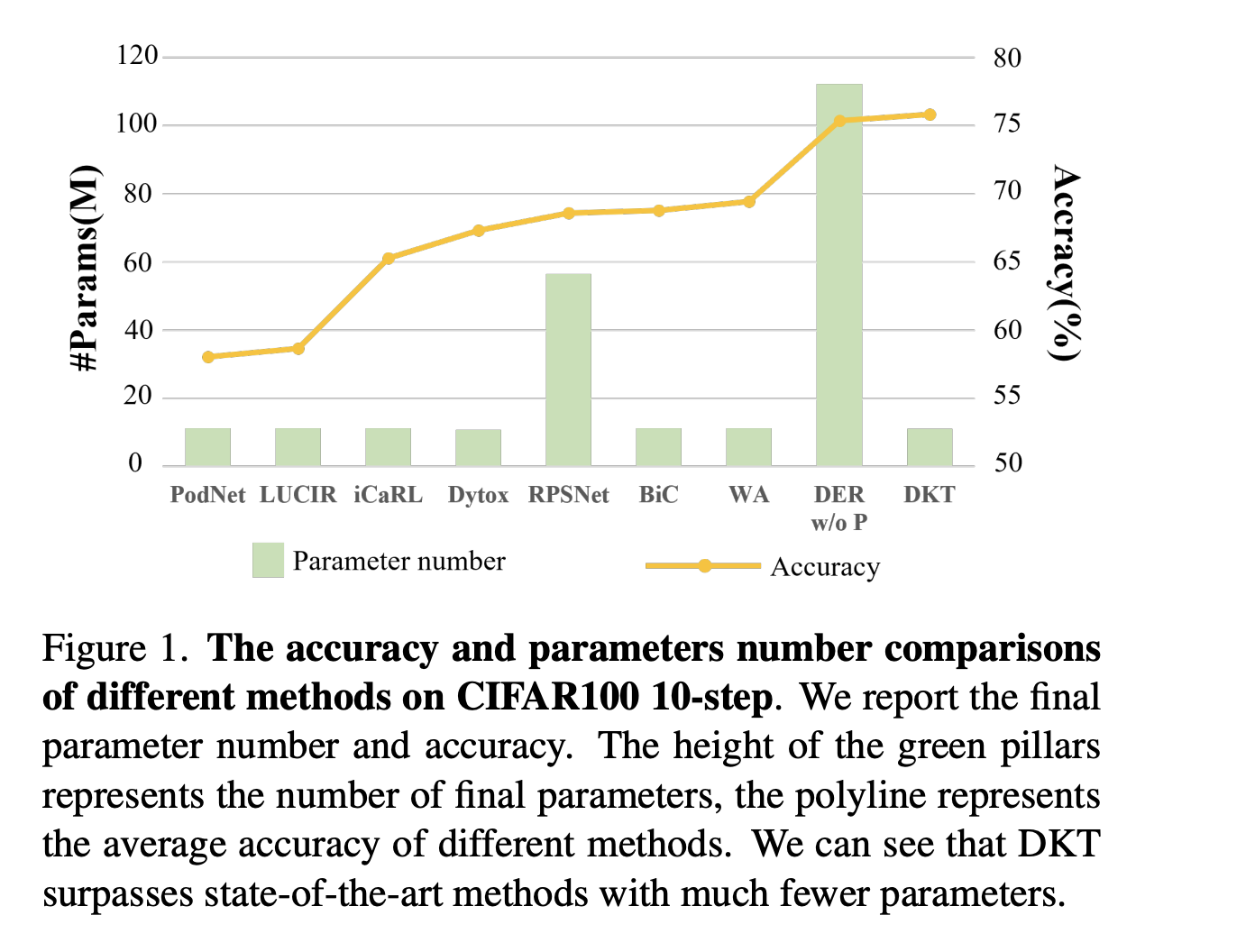

3) Significant additional parameters (i.e., DER)

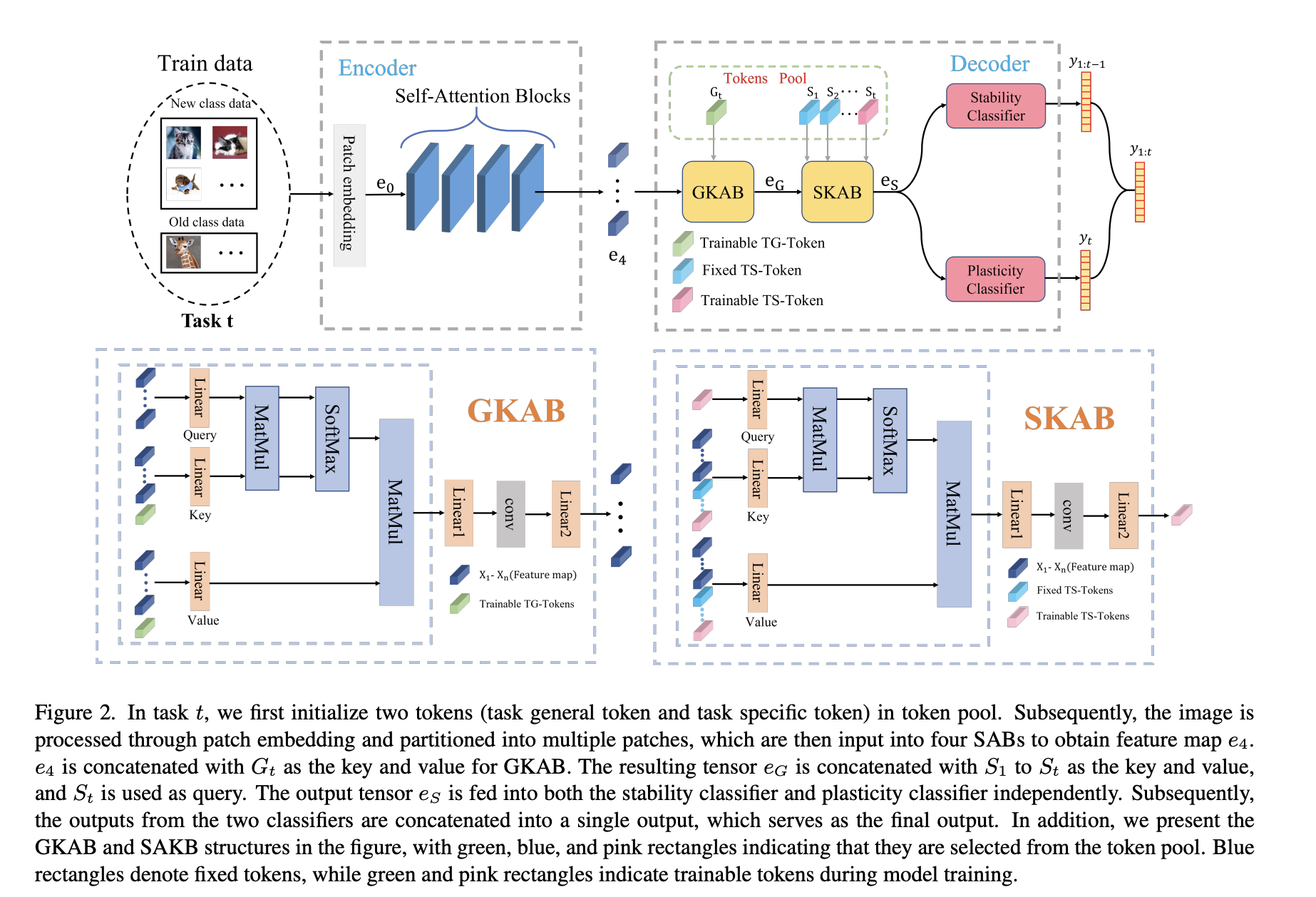

Method

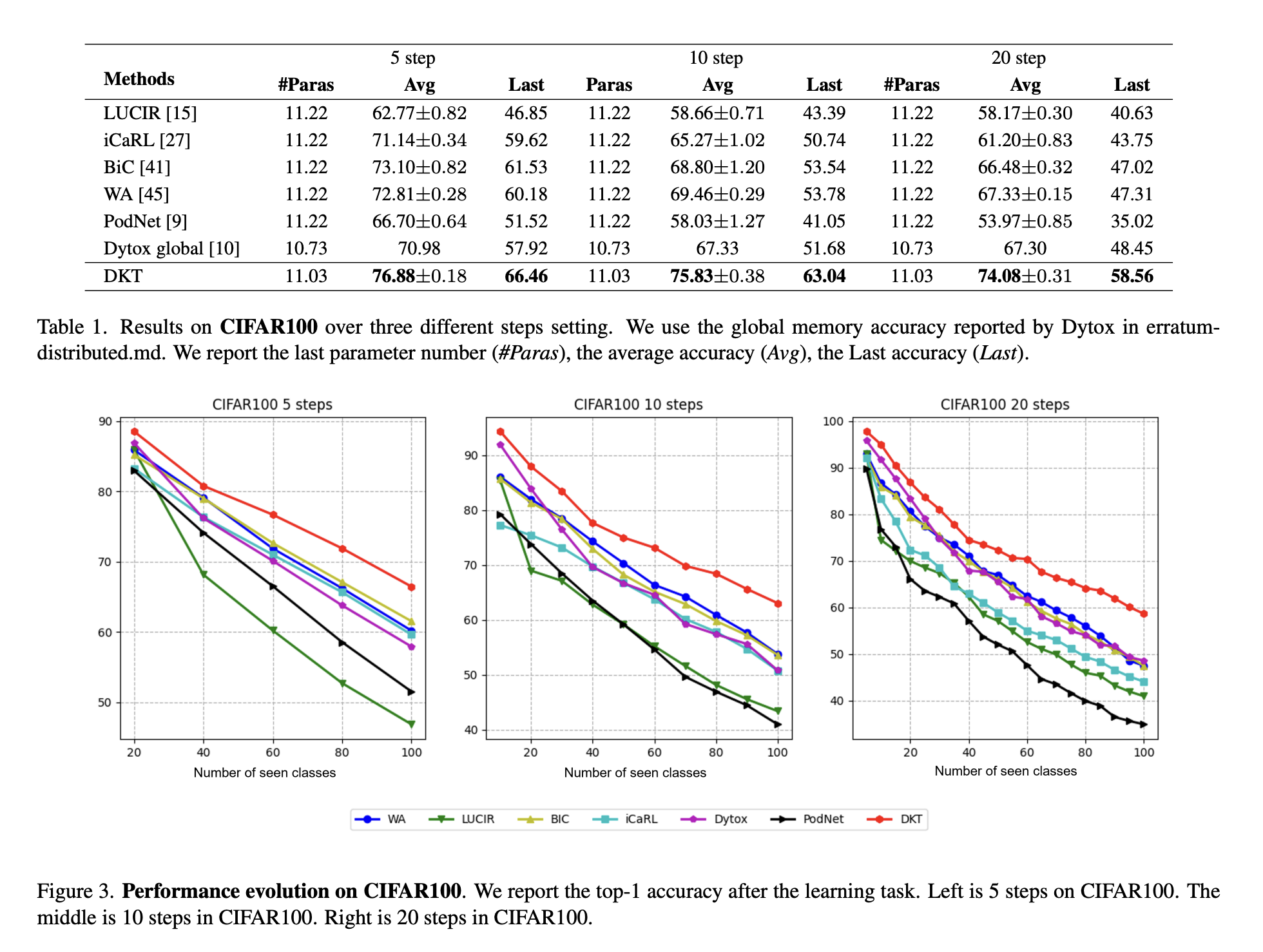

Result

Pros and Cons

-

Pros

1) 적은양의 파라미터만으로도 충분히 성능을 뽑아냄

2) 모델링한게 사실상 Attention Module이랑 Classifier를 Task가 끝나면 합쳐주는거랑 Task-specific(general) token 밖에 없음 -> 간단한 아이디어로 효과적인 결과! -

Cons

1) Motivation Align

Stability-Plasticity가 실제로 어떻게 극복되었는지 모르겠음

Token의 기능을 모르겠음

* Cluster Loss를 만든 이유를 솔직히 잘 모르겠음2) Evaluation

* Evaluation을 그냥 매 step마다 찍은 것 같은데, 모든 Task가 다 끝나고 각 Task별로 성능을 뽑아내서 BWT나 FWT 값을 뽑아내는게 낫지 않았을까 싶음 -> Stability-Plasticity에 관한 언급을 위해서