본 게시글은 패스트캠퍼스 [혁펜하임의 AI DEEP DIVE] 체험단 활동을 위해 작성되었습니다.

AI DEEP DIVE Chapter 6 "인공신경망, 그 한계는 어디까지인가 ?"를 보고 정리한 글이다.

Universal Approximation Theorem

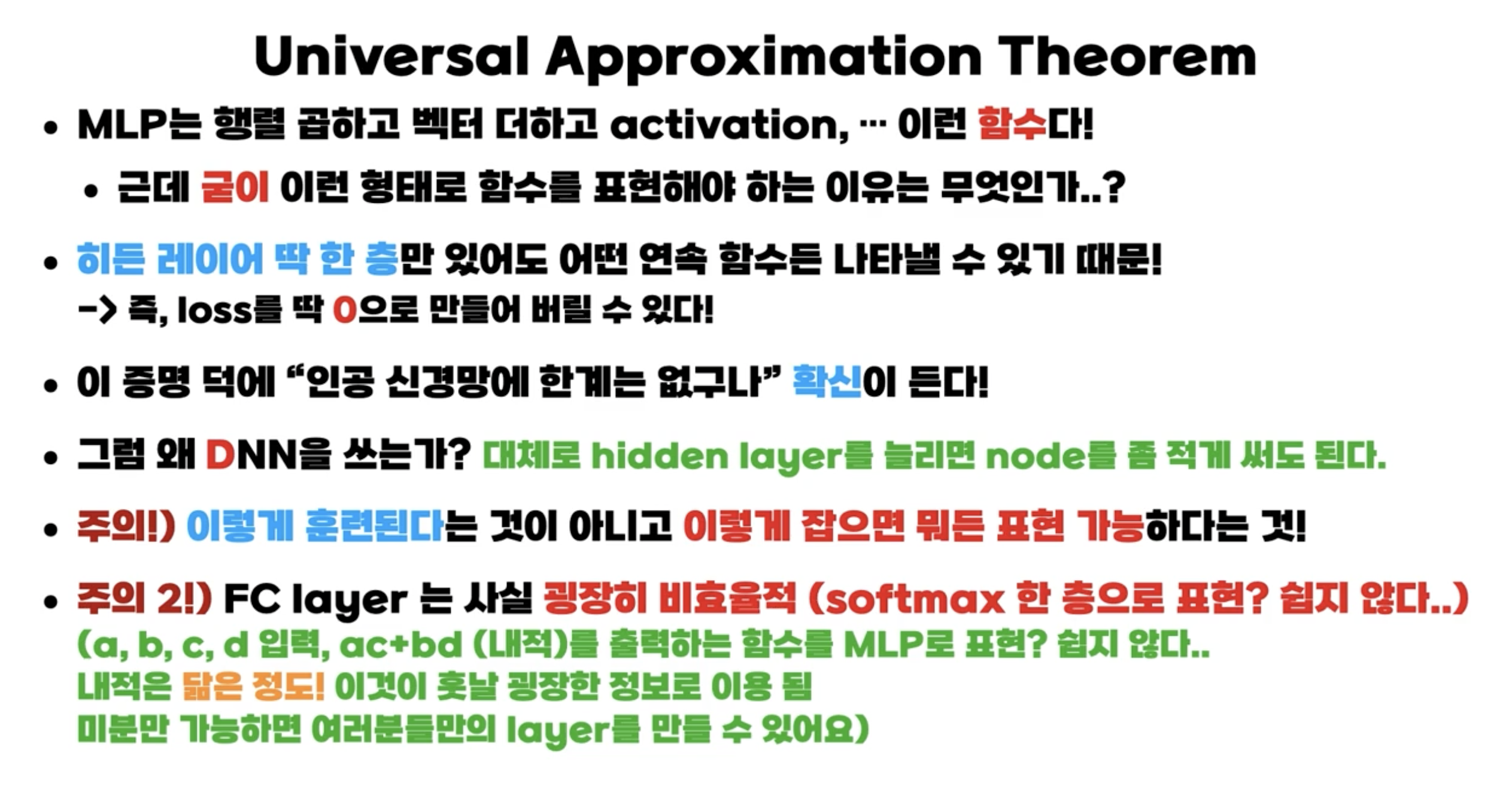

인공신경망의 한계는 없다라는 것을 보여주는 이론이다.

입력과 출력의 관계를 담당하는 '함수의 형태'를 만드는 것이 곧 '학습한다'라는 것이며, 인공신경망의 한계가 없다라는 것은, 이 입력과 출력이 어떤 관계일지라도 그것을 나타내는 함수를 만들 수 있다는 것을 의미한다.

입력과 출력은 숫자이기 때문에 어떤 패턴이라도 대응 가능하다

MLP는 ... 의 반복이라고 배웠는데, 의 제곱 등을 사용하지 않고 위와 같은 형태로 함수를 표현하는 이유는 무엇일까 ? 바로 아래에 이유가 적혀있다.

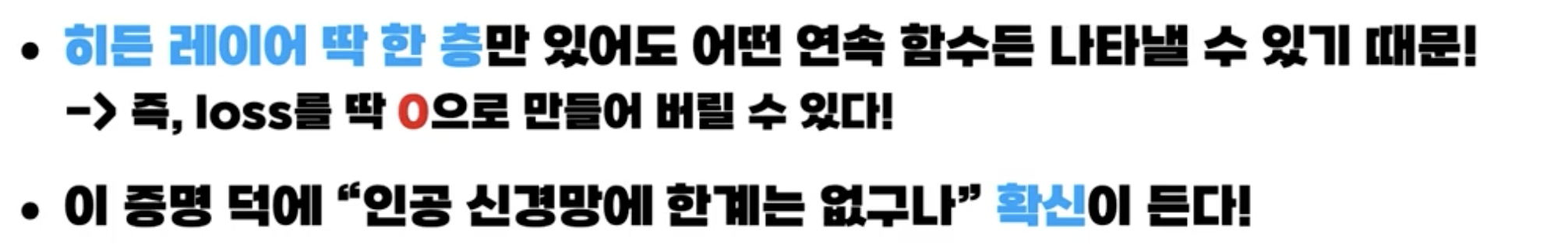

입력 숫자에 가중치 를 곱하고 바이어스 를 더하고, 활성화 함수(시그모이드 등)를 통과시키는 신경망의 계산 절차를 따라보면, 가중치와 바이어스의 값을 바꾸는 것으로 그래프의 모양을 변화시킬 수 있다. 이를 통해 아래 문장을 이해할 수 있을 것이다.

유한 개의 유닛을 가지고 1개의 은닉층으로 구성되는 신경망은 특정 조건 하에서 임의의 연속함수를 근사할 수 있다.

이러한 Universal Approximation Theorem를 통해 AI가 왜 범용성이 높은 방법이 되었는지 알 수 있다.

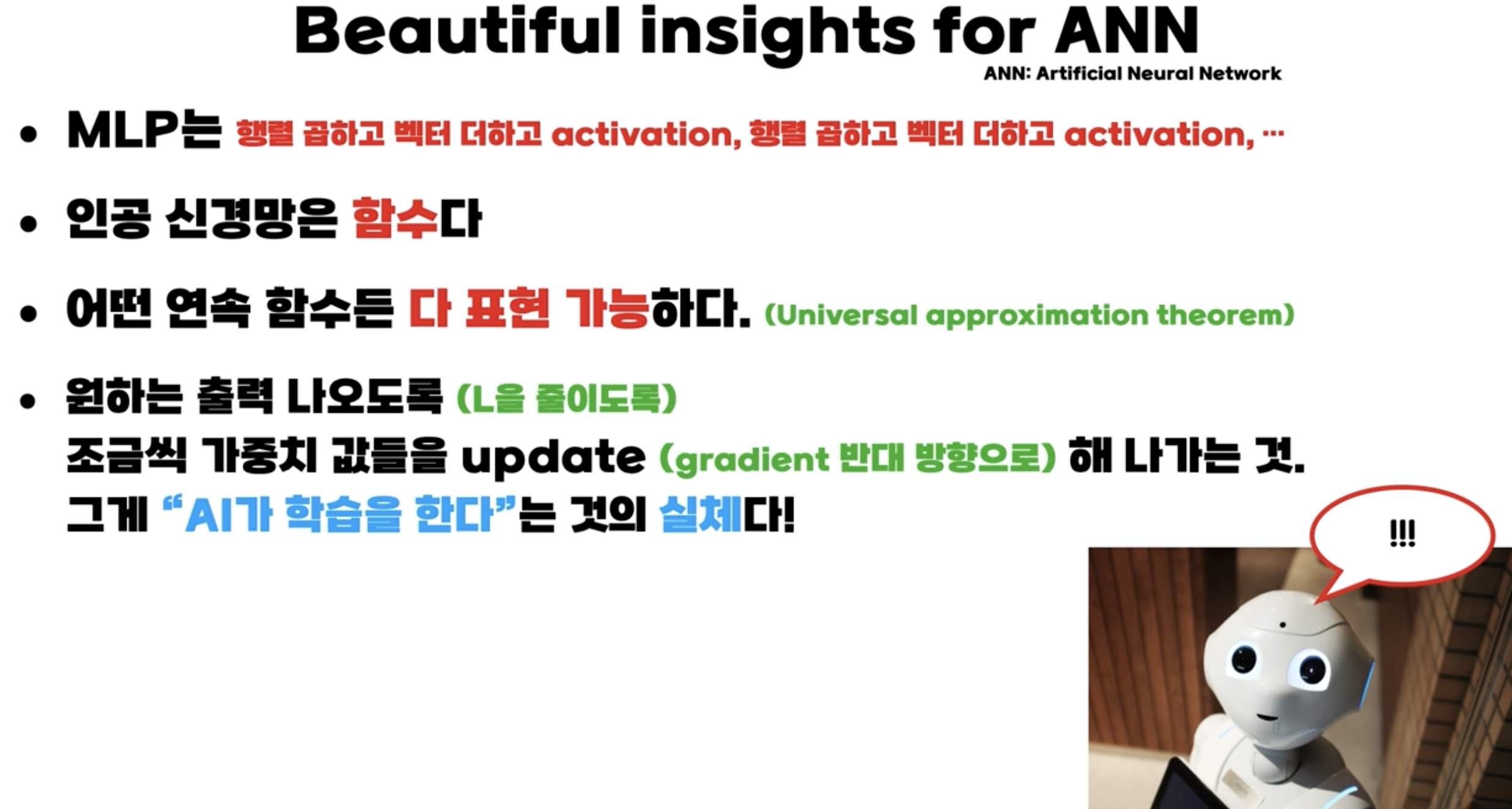

요약

내적은 닮은 정도를 나타내기때문에 유용한 정보로 이용될 수 있는데, 트랜스포머의 기본 컨셉인 어텐션에서 내적이 이용되었다.

AI가 스스로 학습 한다는 것의 실체는 ?

어떠한 연속 함수든 다 표현가능한 인공신경망을 이용해 내가 원하는 data의 입출력의 상관관계를 근사시키는 것이 바로 "학습"의 실체이다. 최대한 가깝게 근사하기 위해 가중치 값을 gradient 반대방향으로 업데이트해나가는 것이다.

이제 막 인공지능에 대해서 공부중이라 어떤 강의를 들어야 할지 고민이었는데 많은 참고가 되었습니다!! 감사합니다 !