Spark 설치 및 실행

아래 포스팅을 참조해 Spark를 설치한다.

Spark 설치 및 실행하기 - Local Mode

https://velog.io/@jskim/Spark-%EC%84%A4%EC%B9%98-%EB%B0%8F-%EC%8B%A4%ED%96%89%ED%95%98%EA%B8%B0-Local-Mode

Spark Standalone Cluster Manager로 실행시키기 위한 설정

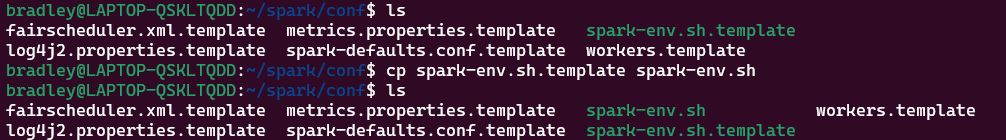

$SPARK_HOME/conf로 이동하여 spark-env.sh.template를 복사하여 spark-env.sh 파일을 만든다.

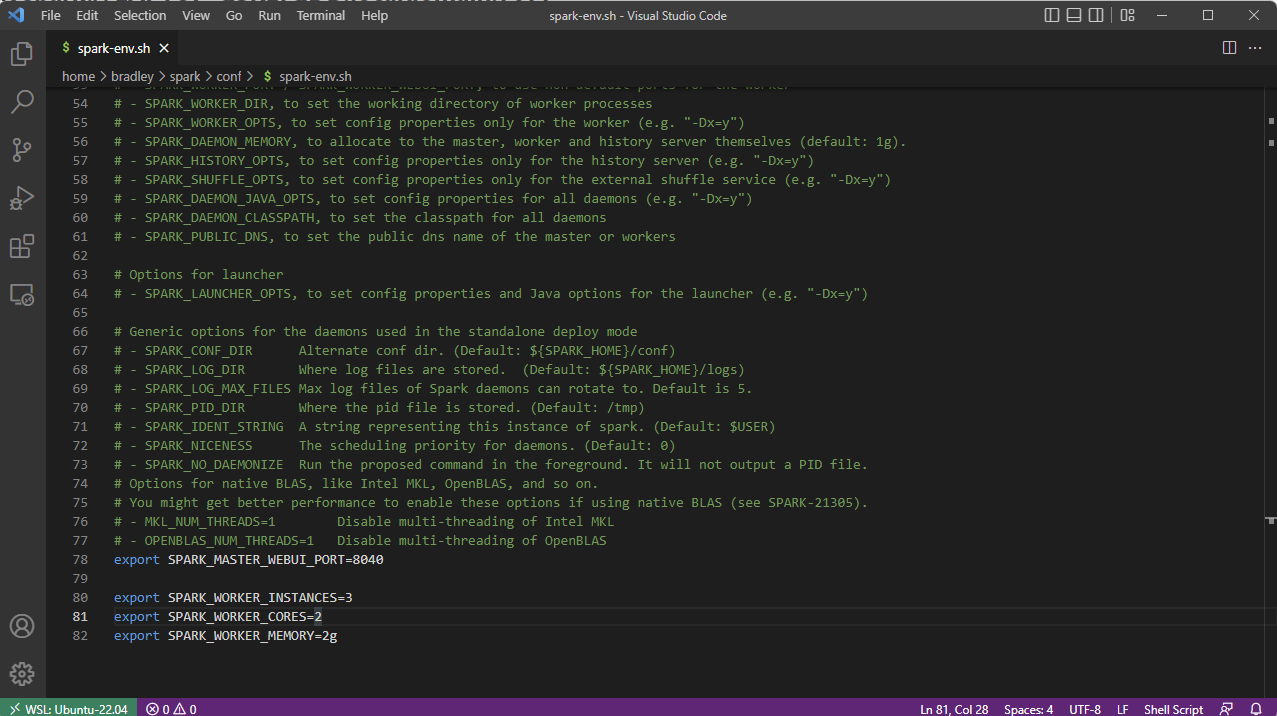

spark-env.sh를 통해 다음과 같은 설정을 할 수 있다.

필자는 다음과 같이 설정하였다.

- Master Port는

8040할당 - Worker 3개 할당

- Worker의 Core는 각 2 Core

- Worker의 Memory는 각 2GB

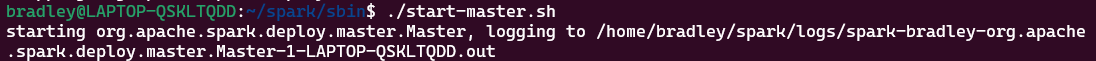

Master 실행

$SPARK_HOME/sbin의 start-master.sh를 실행한다.

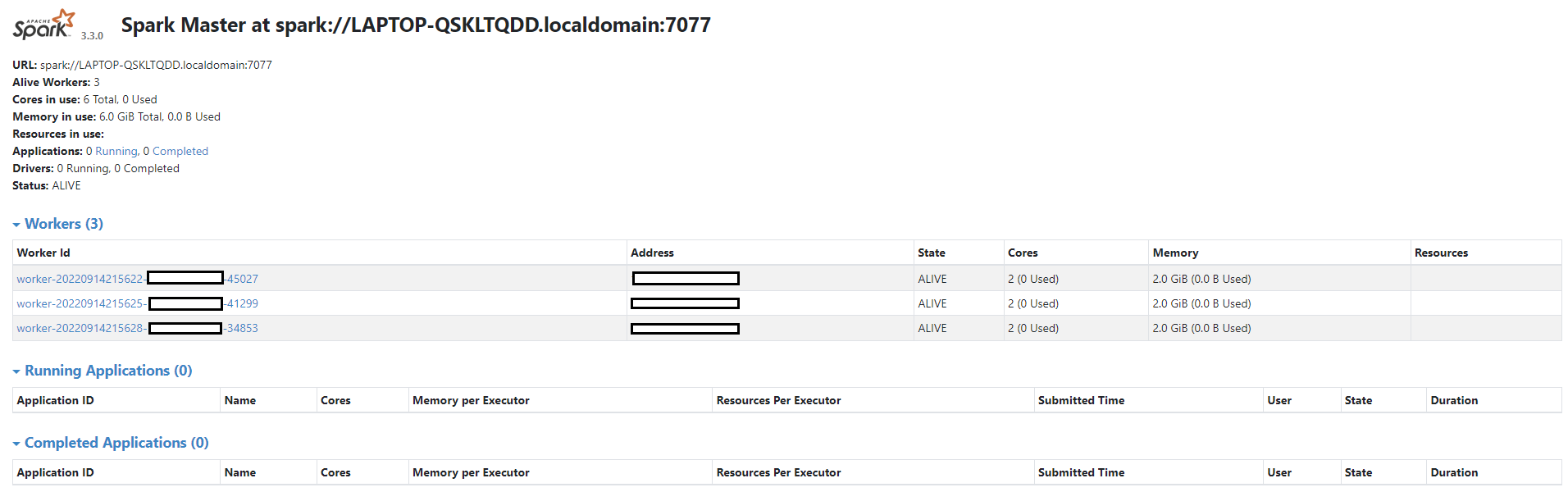

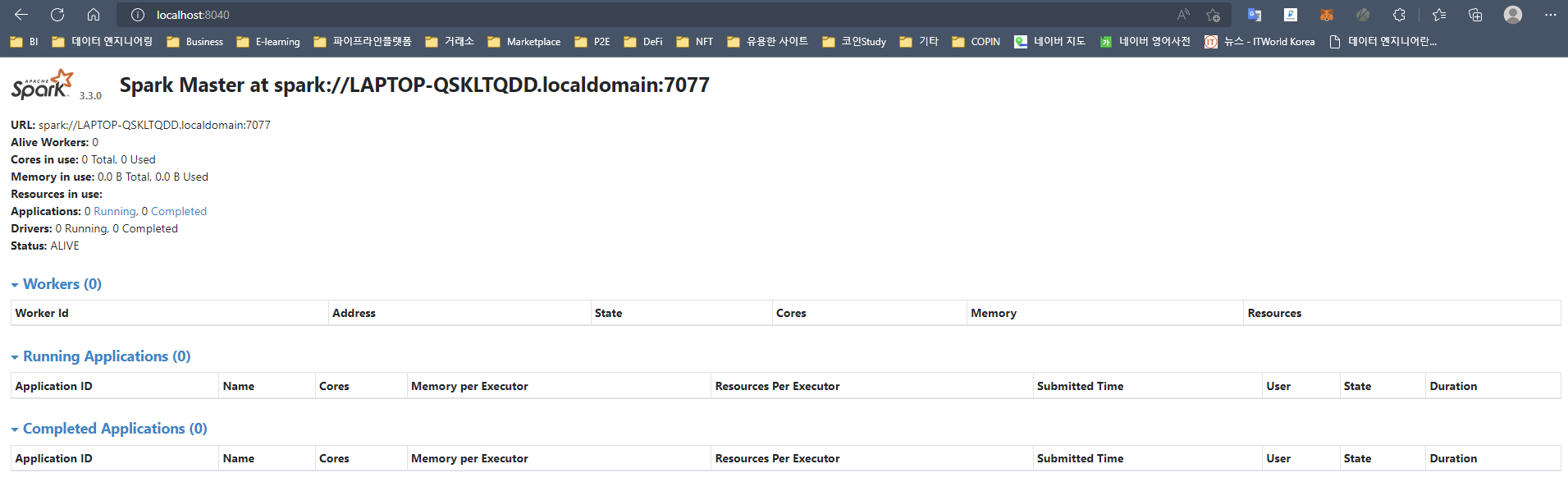

localhost:[PORT]에 접속하면 Spark Master가 실행된 것을 확인할 수 있다.

다시 말해 이 화면이 Spark Standalone Cluster Manager 화면이다.

이 곳에서는 Cluster Machine에 대한 관리 현황을 알 수 있다.

Spark Job에 대한 모니터링은

localhost:4040에서 확인할 수 있다.

맞다. Spark Local Mode에서 접근했던 Spark Web이다.

Cluster Manager 화면에서 실행 중인 Application 관련 정보를 따라가다보면 자동으로 Spark Web(localhost:4040)으로 이동된다.

Worker 실행

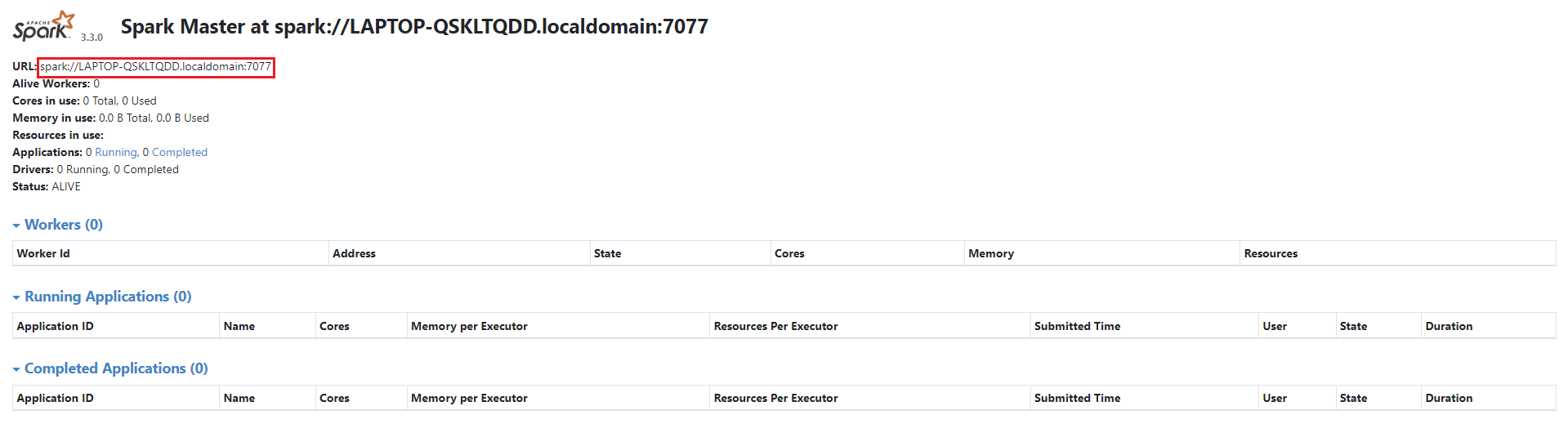

우선 Master URL을 복사한다.

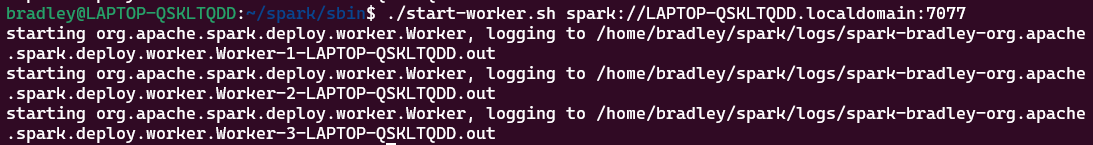

이제 Worker를 실행한다

./start-worker.sh [Master URL]

Spark Web을 Refresh하면 spark-env.sh에 설정한 것처럼 3개의 Worker가 실행되고, 각 2 Cores와 2GB Memory가 할당된 것을 확인할 수 있다.