1. 개념 정리

1) 언어 모델

- 단어의 시퀀스를 기반으로 다음 단어에 확률을 할당하는 모델

- 주변 단어를 기반으로 중심 단어를 예측하는 언어 모델

- 종류

-

딥러닝 등장 이전: 통계적 언어 모델

-

NNLM (Neural Network Language Model): 신경망 언어 모델, Embedding 레이어의 아이디어

워드 임베딩

밀집 벡터의 형태로 단어를 표현하는 방법

- 임베딩 벡터: 워드 임베딩 과정을 통해 나온 밀집 벡터

2) Sequence to Sequence

RNN

1. 등장: 고정된 크기가 아닌 단어의 개수와 무관한 처리를 가능케 하는 네트워크가 필요했음.

2. 보완: 입력을 순차적으로 적립 (+고정된 크기의 Weight 선언)

3. 한계

- 기울기 소실 ⇒ LSTM

- 번역에서 활용하기 힘듦 ⇒ Sequence to Sequence

- 등장: 구글의 발명, 번역을 위해 사용

- 구조: 인코더 - 디코더

3) Attention

-

Bahdanau Attention

NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE

Attention mechanism in NLP. From seq2seq + attention to BERT -

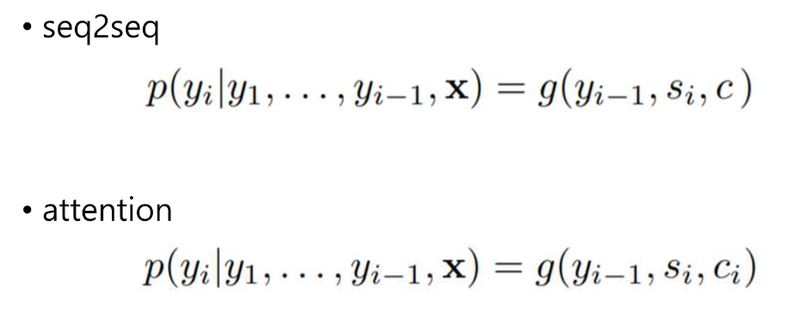

seq2seq vs attn-seq2seq

- 차이: context vector c

- context 는 디코더의 포지션 i에 다라 다르게 표현 되어야 한다는 것을 의미

- Luong Attention

Luong Attention 개념 정리

4) Google's Neural Machine Translation System

- end-to-end 구조

- 구조: 8개의 LSTM encoder, 8개의 LSTM decoder

2. 회고

Sequence to Sequence 와 Attention에 대해 배웠다. 이전 노드에서 나온 내용이었는데 새로워서 밑바닥부터 시작하는 딥러닝을 보고 복습해야겠다고 생각했다. 이전보다 더 깊게 들어그런지 이해가 잘 안되는 부분이 있어서 더 복습이 필요할 거 같다. 워드 임베딩부터 시작해서 GNMT까지 흐름을 다시 정리하는 것이 좋을 거 같다.