DLmath

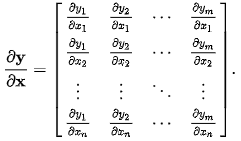

1.Backpropagation, 벡터로 미분하기

Gradient Descent 방법에서 backpropagation이나 가중치 업데이트 등의 토픽을 다루다보면 Loss function을 가중치로 미분하는 연산이 등장합니다. 이때, 가중치는 행렬이므로 스칼라 함수를 행렬로 미분하는 연산을 정의해야 합니다.

2021년 8월 30일

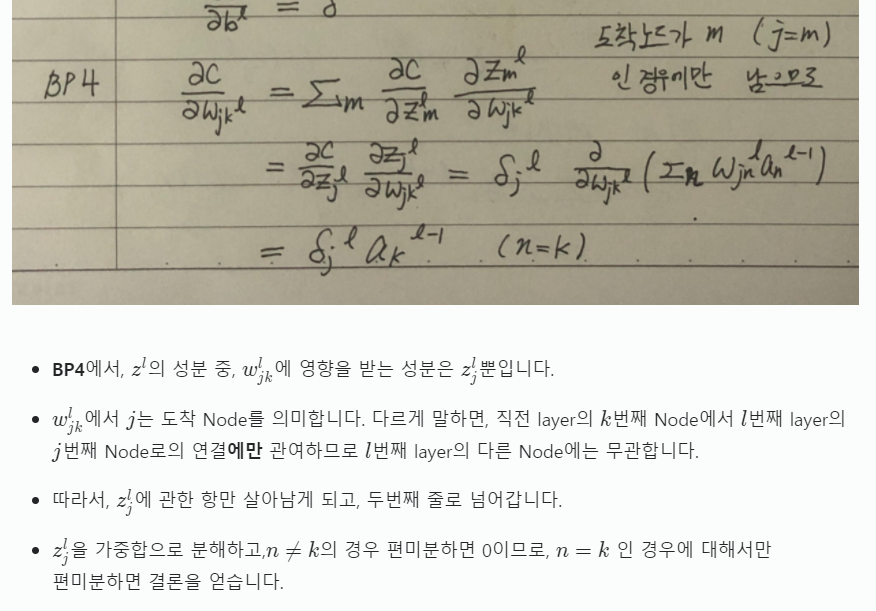

2.Backpropagation 유도 - 함께 편미분하기

Gradient Descent 방법을 사용할 때 필수적인 알고리즘, Backpropagation을 살펴봅니다. 딥러닝은 어떻게 학습하는 걸까요?...

2021년 9월 4일

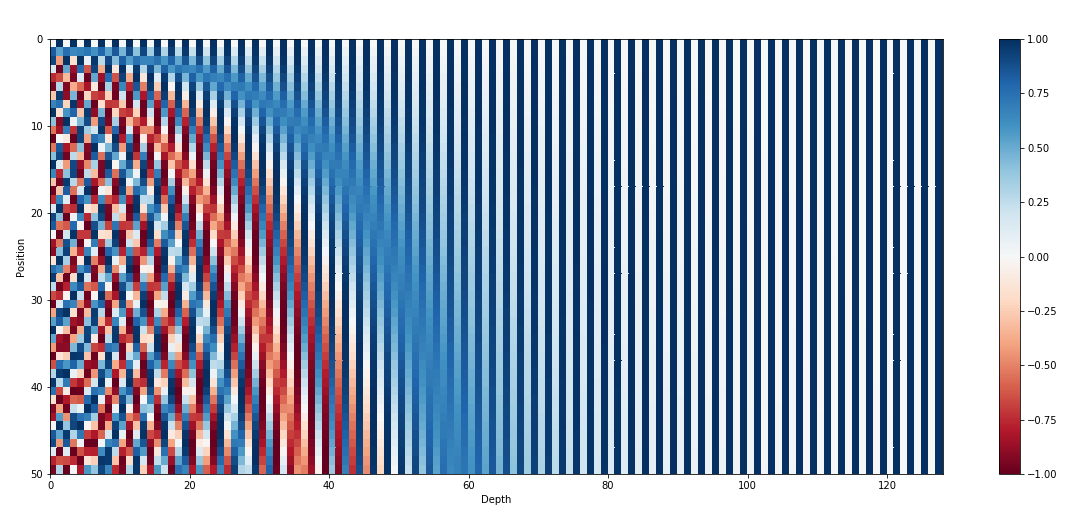

3.[Transformer]-1 Positional Encoding은 왜 그렇게 생겼을까? 이유

트랜스포머의 입력은 RNN과 달리 한꺼번에 모든 요소가 들어가기 때문에, 위치관계의 패턴을 Encode해주는데요. 주로 사용되는 Sinusoidal Positional Encoding의 장점에 대해 알아보겠습니다.

2021년 9월 10일

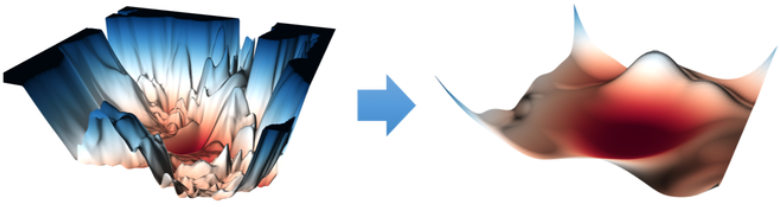

4.Batch Normalization - backpropagation 유도하기

Batch Normalization은 2015년에 제안된 이래로 꾸준히 쓰이고 있는 정규화 기법입니다. Backpropagation은 어떨지 살펴봅시다

2021년 9월 19일

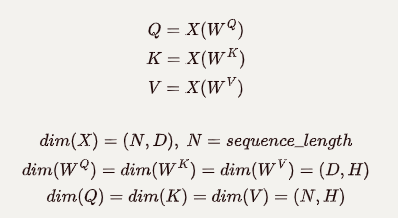

5.[Transformer]-2 Self Attention 어떻게 계산할까? 차원은?

Transformer의 Self Attention은 무엇일까요?

2021년 10월 20일