1) NLP

word embedding

ELMo (https://arxiv.org/abs/1802.05365)

ELMo: Embeddings from Language Models

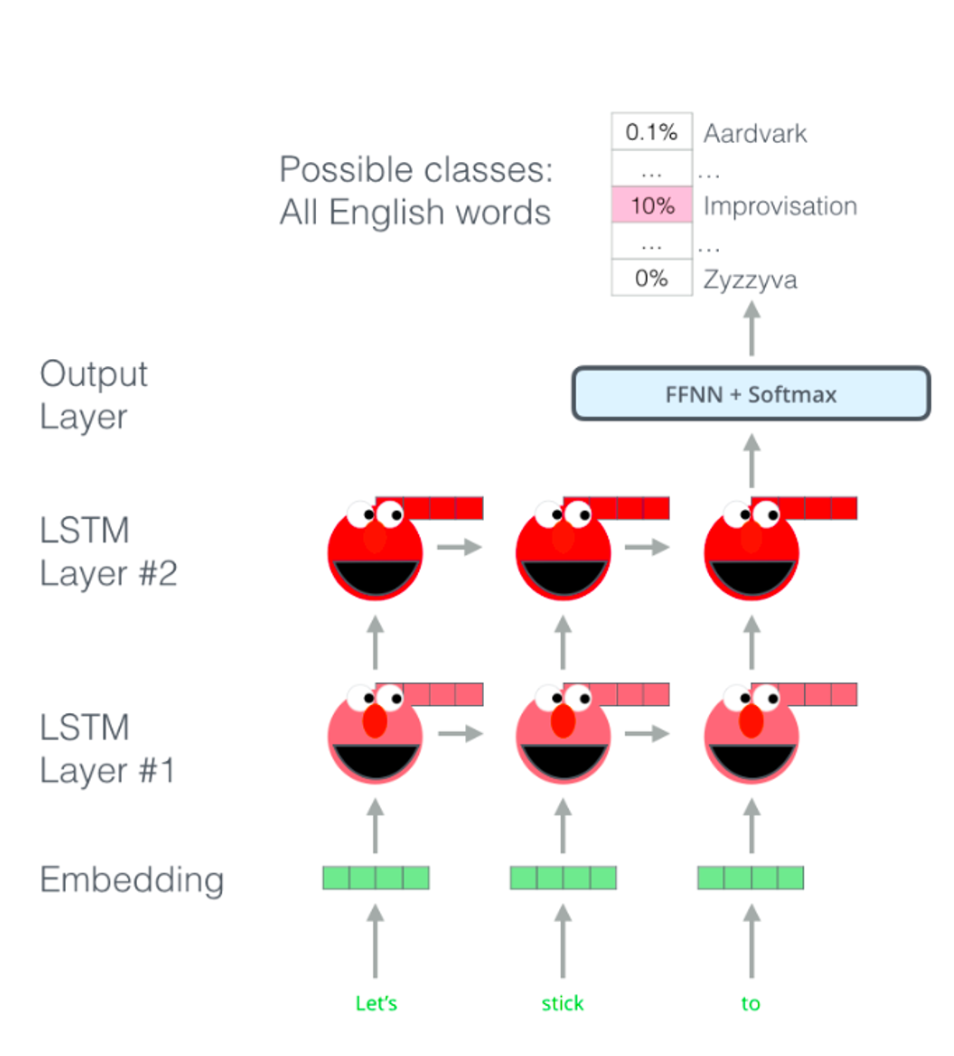

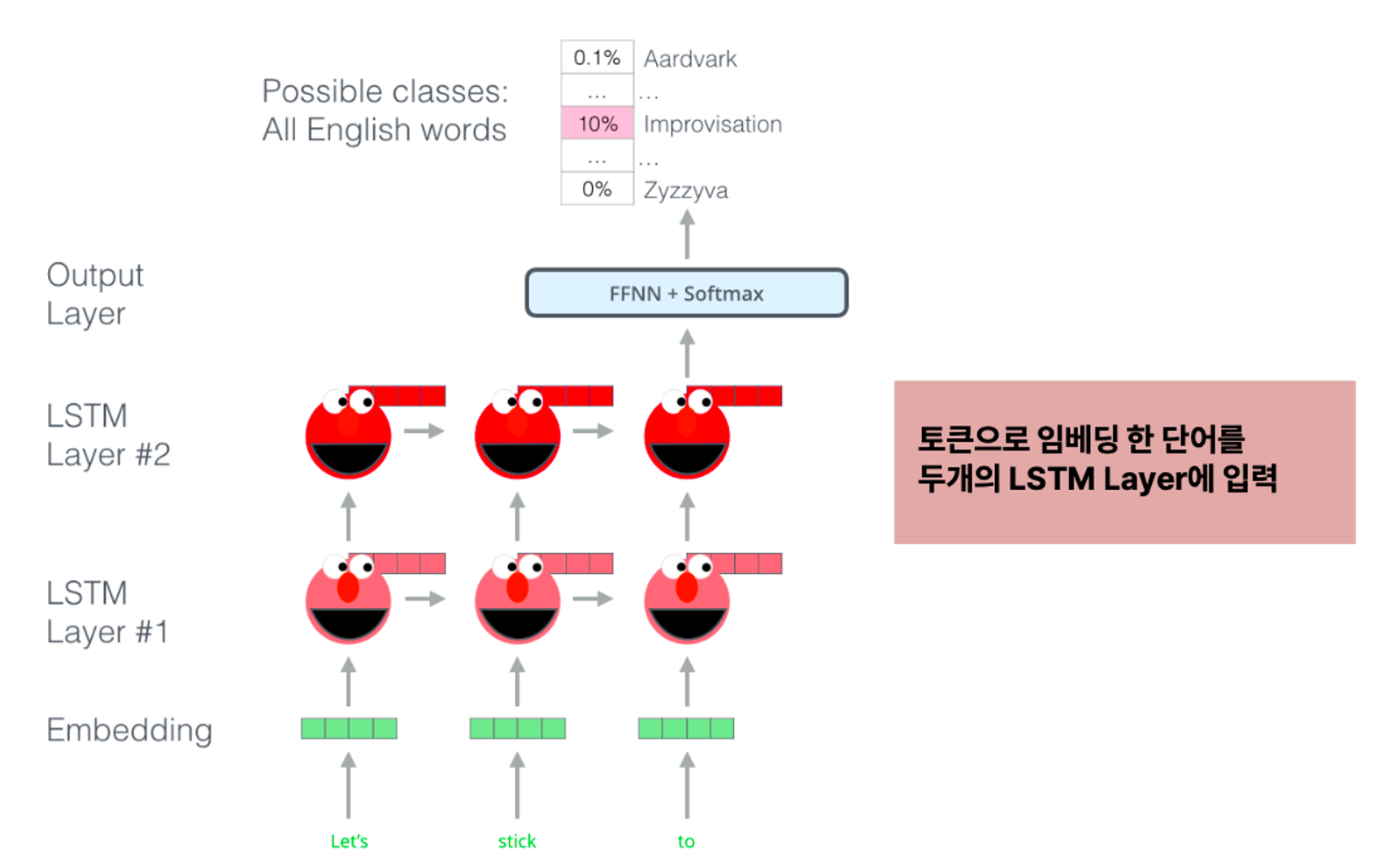

- 토큰으로 임베딩한 단어를 두개의 LSTM에 입력하는 형태

- Embeddings from Language Models. 임베딩 방법 중 일종인데, 사전 훈련된 언어모델이라는 것이 가장 큰 특징

Method

- biLM

- 기존의 LM과 달리, 양방향을 모두 활용해 임베딩을 얻는다.

- 순방향 언어모델 +역방향 언어모델

- 문맥을 온전히 고려해서 임베딩을 얻을 수 있다.

- 장점

- 쉽게 다른 모델에 붙여쓸 수 잇다

- semi-supervised learning 가능

Result

- 단순히 ELMo를 붙이는 것 만으로도 SQuAD, SNLI 등의 태스크에서 1~4%p가량의 성능향상을 보임

- ELMo는 biLM을 통해 워드 임베딩을 얻으며, 그 덕분에 문맥을 온전히 고려할 수 있다.

Conclusion

- biLM을 사용해 높은 수준의 context를 학습하는 ELMO model을 제안

- ELMo model을 사용하면, 대부분의 NLP task에서 성능향상

- layer에서 층이 올라갈수록, syntax보다 의미가 담긴 semantic한 정보를 담아낸다.

- 어느 한 layer를 사용하는 것보다는 모든 layer의 representation을 결합해 사용하는 것이 전반적인 성능 향상에 도움이된다.