Techniques for Maximizing LLM Performance

유튜브 링크

이 영상에서는 OpenAI의 개발자 컨퍼런스에서 "A Survey of Techniques for Maximizing LLM Performance"라는 주제로 진행된 세션의 내용을 더 자세히 다룹니다. 발표자들은 언어 모델(Large Language Models, LLMs)의 성능을 극대화하기 위한 다양한 기술과 접근 방법에 대해 설명합니다.

발표자 소개

- John Allard: OpenAI의 Fine-tuning Product Team의 엔지니어링 리더.

- Colin Jarvis: OpenAI의 EMEA 솔루션 책임자.

주요 내용

-

LLM 성능 최적화의 중요성

- LLM을 신뢰성 있게 생산 환경에 통합하기 위한 최적화의 중요성 강조.

- 최적화는 어렵지만, 다양한 프레임워크와 도구들을 통해 접근 가능.

-

LLM 성능 최적화의 어려움

- 신호와 잡음을 구분하는 것이 어렵다는 점.

- LLM의 성능을 측정하는 것이 추상적이고 어려울 수 있다는 점.

- 문제를 식별하고 해결 방법을 선택하는 것이 복잡하다는 점.

-

LLM 성능 최적화 방법

-

최적화는 선형적인 과정이 아니라는 점.

-

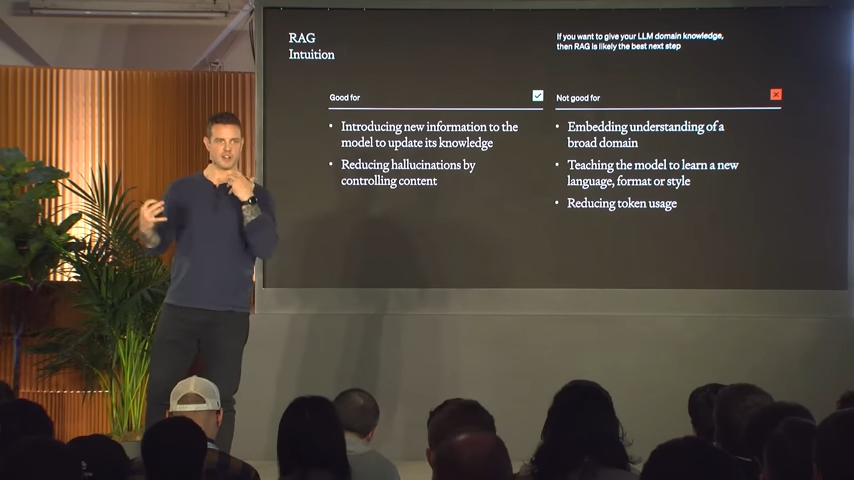

프롬프트 엔지니어링(Prompt Engineering), 검색 증강 생성(Retrieval-Augmented Generation, RAG), 파인튜닝(Fine-tuning) 등 다양한 접근 방법.

-

이들은 상호 보완적이며, 때로는 복합적으로 사용될 필요가 있다는 점.

-

세부 내용:

-

최적화의 두 축: 문맥 최적화(Context Optimization)와 모델 최적화(LM Optimization).

-

프롬프트 엔지니어링: 시작점으로서의 중요성, 빠른 테스트 및 학습 가능.

-

평가 및 결정: 문제가 문맥 문제인지, 모델 행동 문제인지 결정.

-

검색 증강 생성(RAG): 문맥이 더 필요할 때 사용.

-

파인튜닝: 일관된 지시 사항 따르기가 필요할 때 사용.

-

최적화 여정: 프롬프트 생성 → 평가 → 기준선 설정 → 몇 가지 예시 추가 → 검색 증강 생성 → 파인튜닝 → 검색 최적화 → 파인튜닝 반복.

-

시스템적 테스트: 변화를 체계적으로 테스트하는 것의 중요성.

-

-

-

Fine-tuning의 발전

- 3.5 터보 파인튜닝의 출시와 그에 따른 개발자 커뮤니티의 반응.

- 연속적인 파인튜닝, 함수 호출 데이터에 대한 F 튜닝, 파인튜닝을 위한 전체 UI 출시 등의 기능 개선.

-

LLM 성능 최적화를 위한 프레임워크

- 문제를 식별하고 접근하는 방법에 대한 프레임워크 제공.

- 다양한 최적화 도구와 기술의 사용을 권장.

결론

이 세션은 LLM의 성능을 극대화하기 위한 다양한 기술과 접근 방법을 제공하며, 개발자들이 이러한 도구를 활용하여 더 효율적이고 강력한 애플리케이션을 구축할 수 있도록 지원합니다.