[Object Detection] YOLOv13: Real-Time Object Detection with Hypergraph-Enhanced Adaptive Visual Perception 리뷰

Object Detection

논문 제목

YOLOv13: Real-Time Object Detection with Hypergraph-Enhanced Adaptive Visual Perception

URL: https://arxiv.org/abs/2506.17733

Github: https://github.com/iMoonLab/yolov13

인용수 : 0회 (25.7.1기준)

YOLOv12가 나온지 얼마 안된 것 같은데 다시 YOLO시리즈에서 SOTA가 등장했습니다.

ultralytics 기반의 YOLOv13이 릴리즈 되었습니다.

해당 모델은 ultralytics사의 공식 버전은 아니며, ultralytics 라이브러리 기반 개인의 버전업 모델입니다.

GNN이 처음으로 도입되었기에 해당 부분의 이해도 필요하고,, 수식이 꽤많아서 찬찬히 공부하며 글을 추가해볼 예정입니다. 러프하게 v13은 이런걸 적용했구나 정도로 봐주시면 감사하겠습니다.

Abstract

- YOLO 시리즈 모델은 뛰어난 정확성과 계산 효율성 덕분에 실시간 객체 탐지 분야에서 우수한 성능을 보임.

- 하지만 YOLO11 이전 버전의 컨볼루션 아키텍처와 YOLOv12에 도입된 area-based self-attention mechanism은 local information aggregation 및 pairwise correlation modeling으로 제한되어 전역 다대다 고차 상관관계를 캡처하는 기능이 부족하여 복잡한 시나리오에서 탐지 성능을 제한함.

- 위 문제를 해결하기 위해 Hypergraph-based Adaptive Correlation Enhancement (HyperACE) 및 HyperACE 기반의 Full-Pipeline Aggregation-and-Distribution (FullPAD) 패러다임을 제안함.

- 또한 모델 내 vanilla large-kernel convolutions을 depthwise separable convolutions로 대체하여, 성능 저하 없이 파라미터와 계산 복잡도를 크게 줄이는 블록 설계.

Related Work

Evolution of YOLO Detectors

컨볼루션 신경망의 등장 이후 실시간 객체 탐지는 R-CNN 시리즈같은 멀티스테이지 파이프라인에서 YOLO 모델과 같은 최적화된 싱글스테이지 프레임워크로 발전했음.

YOLO : 탐지를 single-shot regression problem으로 재구성하여 속도와 정확도 trade-off를 달성.

YOLOv2 : 앵커기반 예측 + DarkNet-19 백본 도입

YOLOv3 : DarkNet-53 백본과 three-scale predictions 도입으로 작은 객체 탐지 강화

YOLOv4 ~ YOLOv8 : CSP, SPP, PANet, multi-mode support과 anchor-free heads 모듈들을 점진적으로 통합하여 처리량과 정확도 균형을 개선

YOLOv9 ~ YOLOv10 : 경량 백본과 간소화된 엔드 투 엔드 배포에 중점

YOLO11 : 기존 C2f 블록을 C3k2 유닛으로 대체하고 Convolutional Block with

Partial Spatial Attention (C2PSA) 추가

YOLOv12 : Residual Efficient Layer Aggregation Network (R-ELAN) + lightweight Area Attention (A2) and Flash Attention 도입

High-Order Correlation Modeling

복잡한 multi-to-multi high-order correlations은 신경연결 및 단백질 상호작용과 정보과학 분야(소셜네트워크 등)에 널리 퍼져있음. 시각 데이터에서는 다양한 객체가 공간적, 시간적, 의미론적 상호 작용에 참여하여 복잡한 상관관계를 형성함. 이러한 상관관계는 pairwise (low-order)이거나 더 복잡한 group-based correlations (high-order)일 수 있습니다. 일반 그래프의 확장인 하이퍼그래프는 pairwise 상관관계뿐만 아니라 multi-to-multi high-order 상관관계도 표현할 수 있다고함.

여러 연구에서 hypergraph neural networks(HGNNs)을 연구하였고, 비전 태스크에서 이점을 입증했다고함. 그러나 이 방법은 수작업으로 정해진 고정된 매개변수를 임계값으로 사용하며, feature distance가 해당 임계값보다 작은 픽셀들이 상관관계가 있는 것으로 판단되어 상관관계 모델링의 정확성과 견고성이 부족하게 됨.

위에서 언급한 문제들을 해결하기 위해 해당 논문에서는 hypergraph-based adaptive correlation enhancement mechanism을 제안했음.

이는 잠재적인 상관관계를 adaptive하게 활용하여 cross-location과 cross-scale semantic interactions을 효율적으로 모델링함. 해당 메커니즘은 수작업 하이퍼파라미터로 인해 발생하는 기존 하이퍼그래프 컴퓨팅 패러다임의 견고성 부족과 기존 YOLO 시리즈 모델의 global high-order correlation 모델링 부재를 극복한다고 함.

Method

Overall Architecture

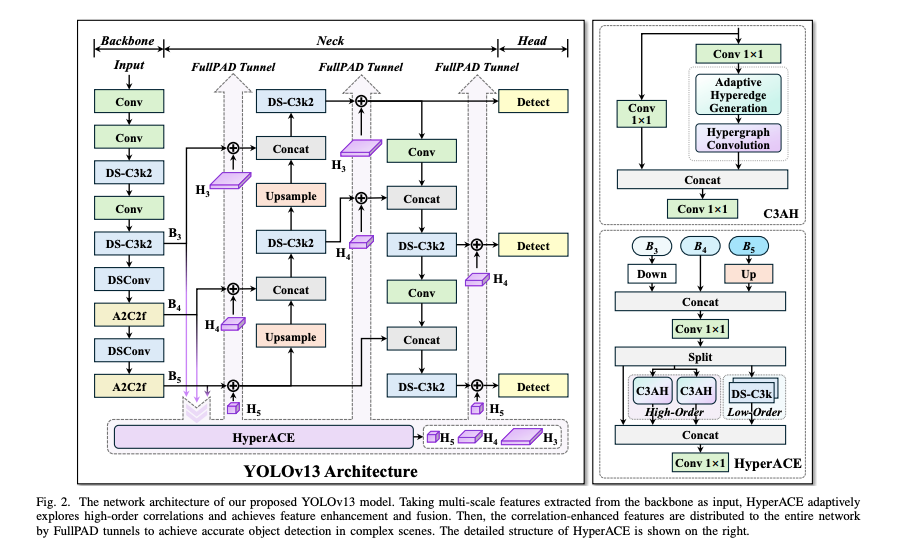

이전 YOLO 시리즈들은 "Backbone → Neck → Head" 계산 패러다임을 따르는데, 이는 정보 흐름의 적절한 전달을 본질적으로 제약한다고함. 이와 대조적으로, 본 논문의 모델은 Hypergraph-based Adaptive Correlation Enhancement(HyperACE) 메커니즘을 통해 Full-Pipeline feature Aggregationand-Distribution(FullPAD)를 달성함으로써 전통적인 YOLO 아키텍처를 향상시킨다함.

따라서 본 논문에서 제안하는 방법은 네트워크 전체에 걸쳐 세밀한 정보 흐름과 표현 시너지를 달성하여 기울기 전파를 개선하고 탐지 성능을 크게 향상시킬 수 있다고한다.

위 그림을 보면 YOLOv13 모델은 먼저 이전 연구들과 유사한 백본 네트워크를 사용하여 다중 스케일 특징 맵 를 추출하지만 해당 백본에서는 경량 DS-C3k2블록으로 대체했음. (논문의 편집하다 삭제 누락된 것으로 보임.)

그리고 를 넥 네트워크에 직접 입력하는 전통적인 YOLO 방법과 달리, 제안 방법은 이러한 특징들을 수집하여 제안된 HyperACE 모듈로 전달하고, 이를 통해 cross-scale cross-position 특징의 high-order correlation adaptive modeling 및 특징 강화를 달성함.

더하여 FullPAD 패러다임은 세 개의 독립적인 터널을 활용하여 상관 강화 특징을 백본과 넥 사이의 연결, 넥의 내부 계층, 그리고 넥과 헤드 사이의 연결로 각각 분배하여 더 나은 정보 흐름을 제공함.

Hypergraph-Based Adaptive Correlation Enhancement

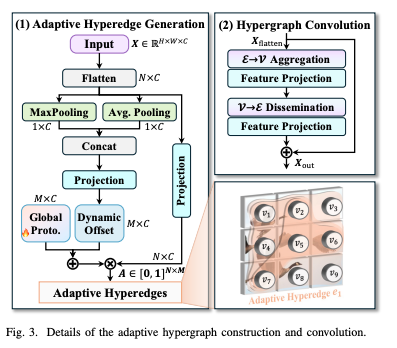

Efficient하고 robust한 cross-scale cross-position correlation modeling과 feature enhancement를 달성하기 위해 hypergraph-based adaptive correlation enhancement mechanism를 제안. HyperACE는 두 가지 핵심 구성 요소를 포함.

1) Adaptive Hypergraph Computation

visual features에서 high-order correlation를 효과적이고 효율적으로 모델링하고, correlation-guided feature aggregation 및 enhancement를 달성하기 위해 새로운 패러다임을 제안함.

위 그림을 보면 특징 유사성을 기반으로 하이퍼엣지를 구성하기 위해 수동으로 미리 정의된 매개변수를 사용하는 전통적인 하이퍼그래프 모델링 방법과 달리 본 논문에서 제안하는 방법은 각 하이퍼엣지에 대한 각 정점의 참여 정도를 적응적으로 학습하여 이 계산 패러다임을 더욱 견고하고 효율적으로 만듦. 전통적인 하이퍼그래프 계산 패러다임은 소셜 네트워크와 같이 명시적인 연결 관계를 포함하는 비유클리드 데이터에 더 적합한 반면, 해당 방법은 적응형 하이퍼그래프 계산 패러다임은 컴퓨터 비전 작업에 더 유리함.

2) C3AH for Adaptive High-Order Correlation Modeling

본 논문에서 제안하는 adaptive hypergraph computation paradigm을 기반으로 C3AH 블록을 추가로 제안함. C3AH 블록은 CSP bottleneck branch-split mechanigm을 유지하면서 적응형 하이퍼그래프 계산 모듈을 통합하여 공간 위치를 가로지르는 전역 고차 의미론적 집계를 가능하게한다고함.

Full-Pipeline Aggregation-and-Distribution Paradigm

HyperACE에서 얻은 correlation-enhanced features를 완전히 활용하기 위해 FullPAD 패러다임을 추가로 도입함. FullPAD는 백본에서 다중 스케일 특징 맵을 수집하고 이를 HyperACE로 전달한 다음 아키텍쳐 그림에 나타난 바와 같이 다양한 FullPAD 터널을 통해 강화된 특징을 파이프라인 전체의 다양한 위치로 재분배함. 이러한 설계는 세밀한 정보 흐름과 표현 시너지를 가능하게 하여 기울기 전파를 크게 개선하고 탐지 성능을 향상시킨다고함.

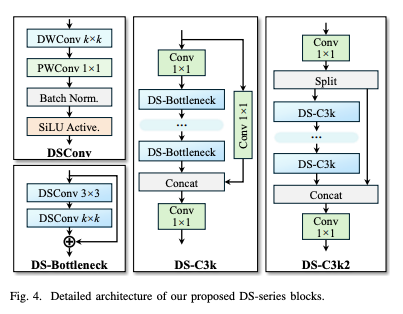

Model Lightweighting with Depth-Separable Convolution

YOLOv13에서는 large-kernel depthwise-separable convolution(DSConv)을 basic unit으로 활용하여 위 그림에 나타난 바와 같이 일련의 경량 특징 추출 블록을 설계했음.

총 네 종류의 DS 시리즈가 있음. (DSConv, DS-Bottleneck, DS-C3k, DS-C3k2)

Experiments

훈련 검증 데이터셋은 Microsoft COCO (MS COCO) 사용.

MS COCO 데이터셋 훈련 세트(Train2017)는 약 118,000장의 이미지를 포함하고, 검증 세트(Val2017)는 약 5,000장의 이미지를 포함.

서브 벤치마크는 Pascal VOC 2007 데이터셋 사용.

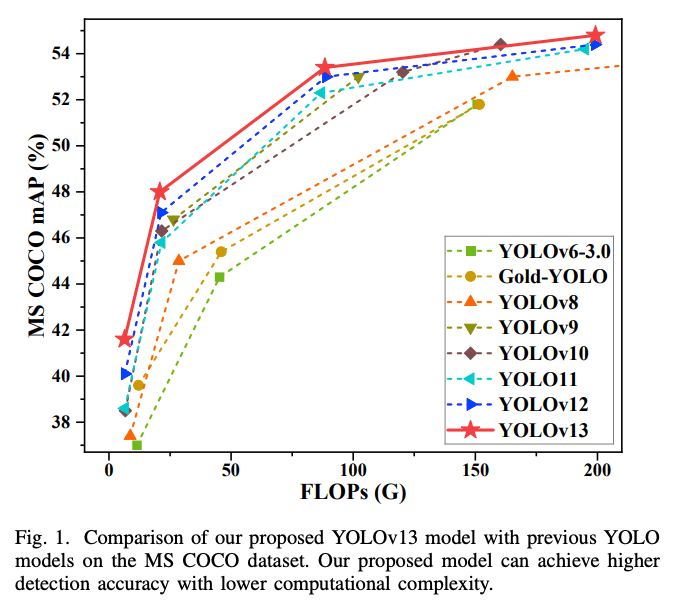

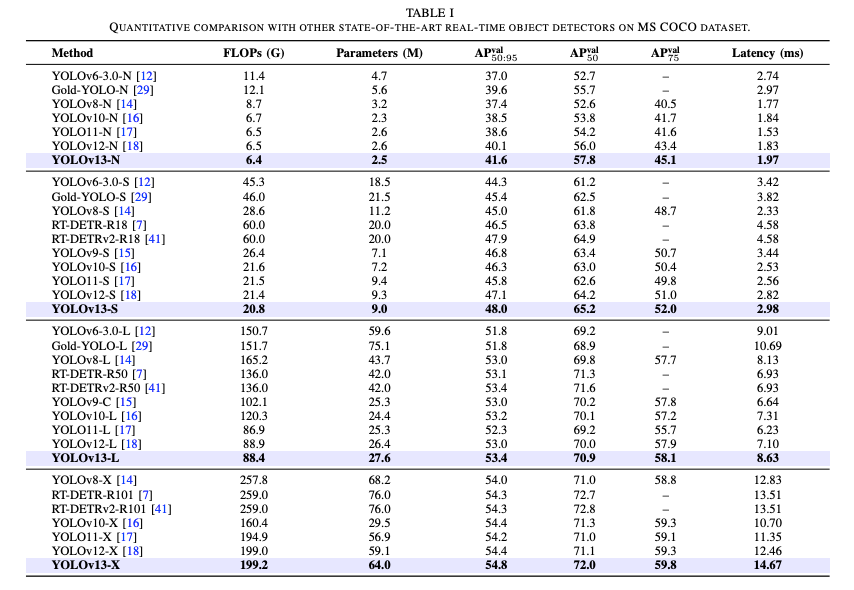

위 표는 MS COCO 데이터셋 에 대한 정량적 비교 결과를 보여줌. 제안하는 방법은 이전 YOLO 시리즈 모델들과 비교되었음. YOLOv13 모델과 최신 YOLO11 및 YOLOv12 모델은 동일한 GPU에서 훈련되었으며, 기존 방법들은 공식 코드와 훈련 매개변수를 사용하여 훈련되었음. YOLOv13 모델의 모든 모델 크기에서 경량을 유지하면서도 최첨단 성능을 달성함을 확인할 수 있음.

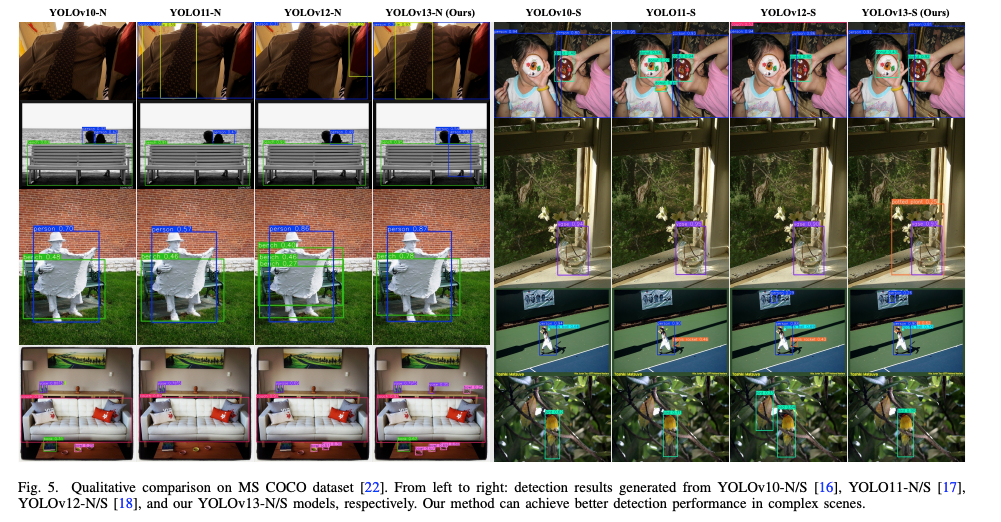

위 그림은 MS COCO 데이터셋에 대한 정성적 비교 결과를 보여줌. YOLOv13 모델은 기존 YOLOv10, YOLO11, YOLOv12 모델들과 비교하였음. YOLOv13 모델이 복잡한 장면에서 더 정확한 탐지 성능을 달성할 수 있음을 확인할 수 있다.

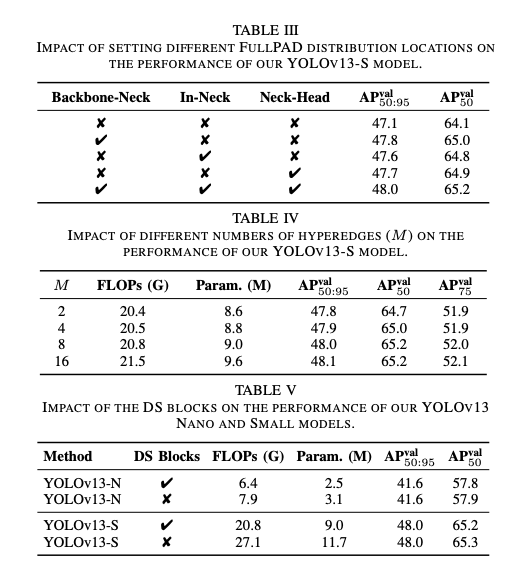

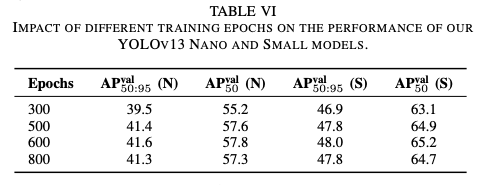

Ablation Study

제안하는 각 모듈을 제거했을 경우 성능이 떨어지는 것을 확인할 수 있다.

Conclusion

- 본 논문에서는 SOTA end-to-end 실시간 객체 탐지기인 YOLOv13을 제안함.

- HyeperACE와 FullPAD, DSConv 기반의 모델 아키텍쳐는정확도를 유지하면서 파라미터 수와 FLOPs를 크게 줄일 수 있었음.

v13은 GNN 매커니즘을 YOLO에 적용하여 v11과 v12에 비해 FLOPs는 줄었지만 Latency가 비약적으로 늘어나긴 했습니다. 그래도 늘어난 시간 대비 성능 향상이 더 크기에 더 세밀한 탐지가 필요한 태스크에서 사용해보면 좋을 것 같습니다.

깃허브에 코드를 올려주셔서 간편하게 학습 및 평가가 가능하여 쉽게 사용하실 수 있을 것 같습니다.