nn.BatchNorm2d

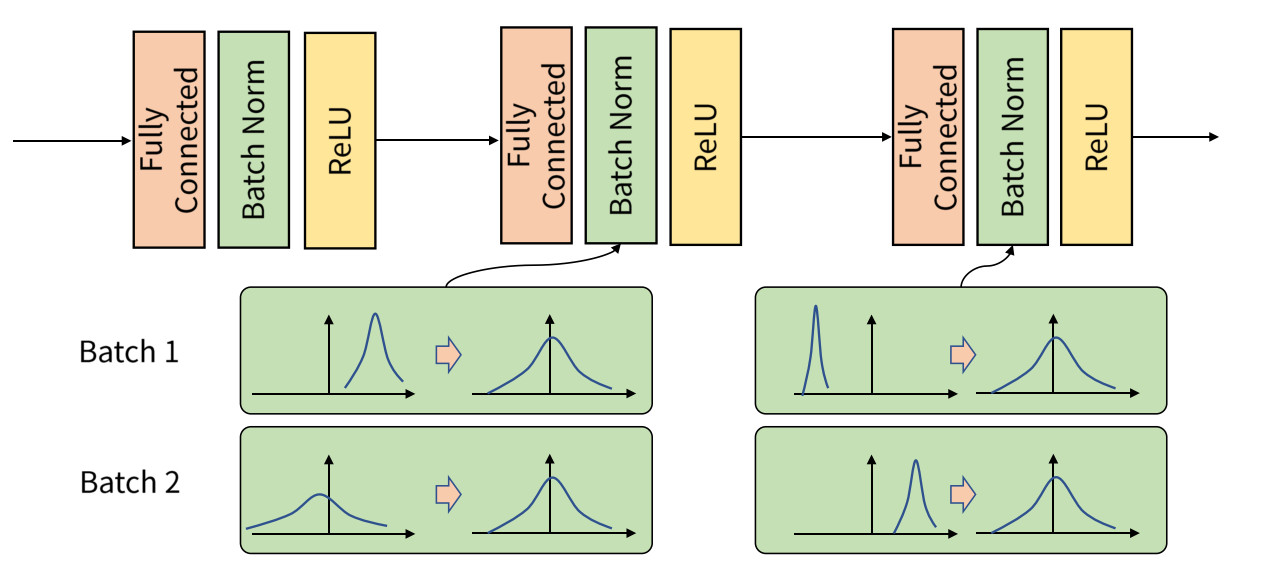

Mini-Batch 학습 진행시, Internal Covariant Shift 현상이 나타날 수 있다. 따라서 학습 과정에서 각 배치 단위 별로 평균과 분산을 이용해 정규화해주는데, 이것이 바로 배치 정규화(Batch Normalization)이다! 정규화를 해주면 gradient descent에 따른 weight의 반응이 같아지기 때문에 학습에 유리하다!

Internal Covariant Shift: 학습 과정에서 계층 별로 입력 데이터 분포가 달라지는 현상

사용법

torch.nn.BatchNorm2d(num_features, eps=1e-05, momentum=0.1,

affine=True, track_running_stats=True,

device=None, dtype=None)