[Research] 코드 스위칭 코퍼스 기반 다국어 LLM의 지식 전이 연구 정리

English LLMs -> Korean LLMs 의 가능성 확인

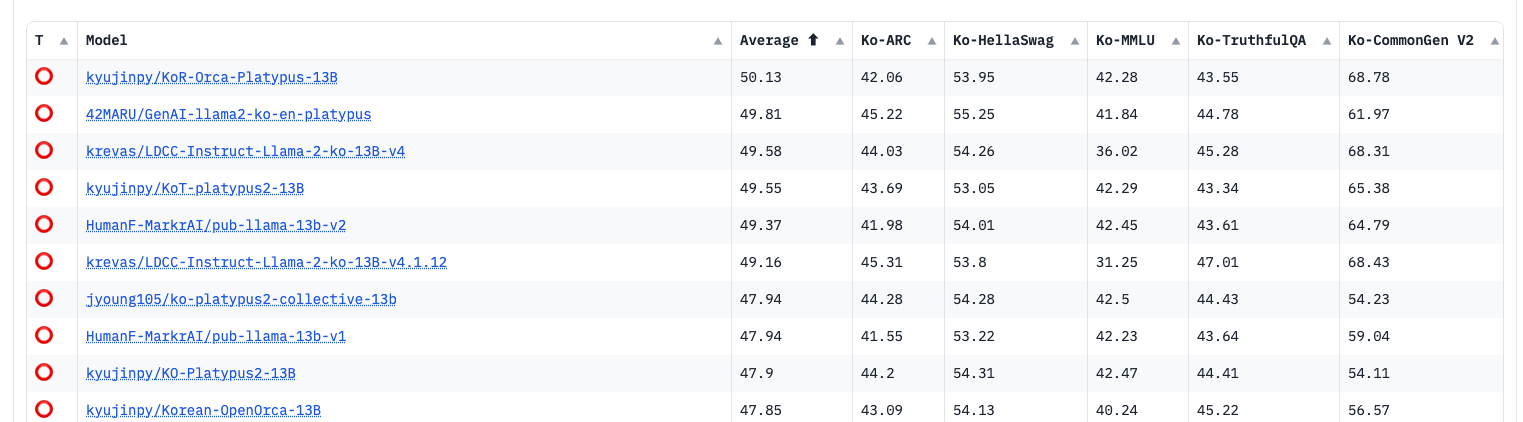

필자의 짧은 생각으로는 LLaMA와 같은 영어 기반의 모델들은 아무리 한국어를 투입해도, 한국어 특화모델보다 한국어를 잘할 수 없다고 생각하였다. 그러나 최근 한국어 LLM의 성능을 평가하는 리더보드인 Ko-LLM Leaderboard (https://huggingface.co/spaces/upstage/open-ko-llm-leaderboard) 에서의 사례를 보면 상위권에 있는 대부분의 모델들이 LLaMA-2를 베이스모델로 하고 있다는 것을 확인할 수 있다.

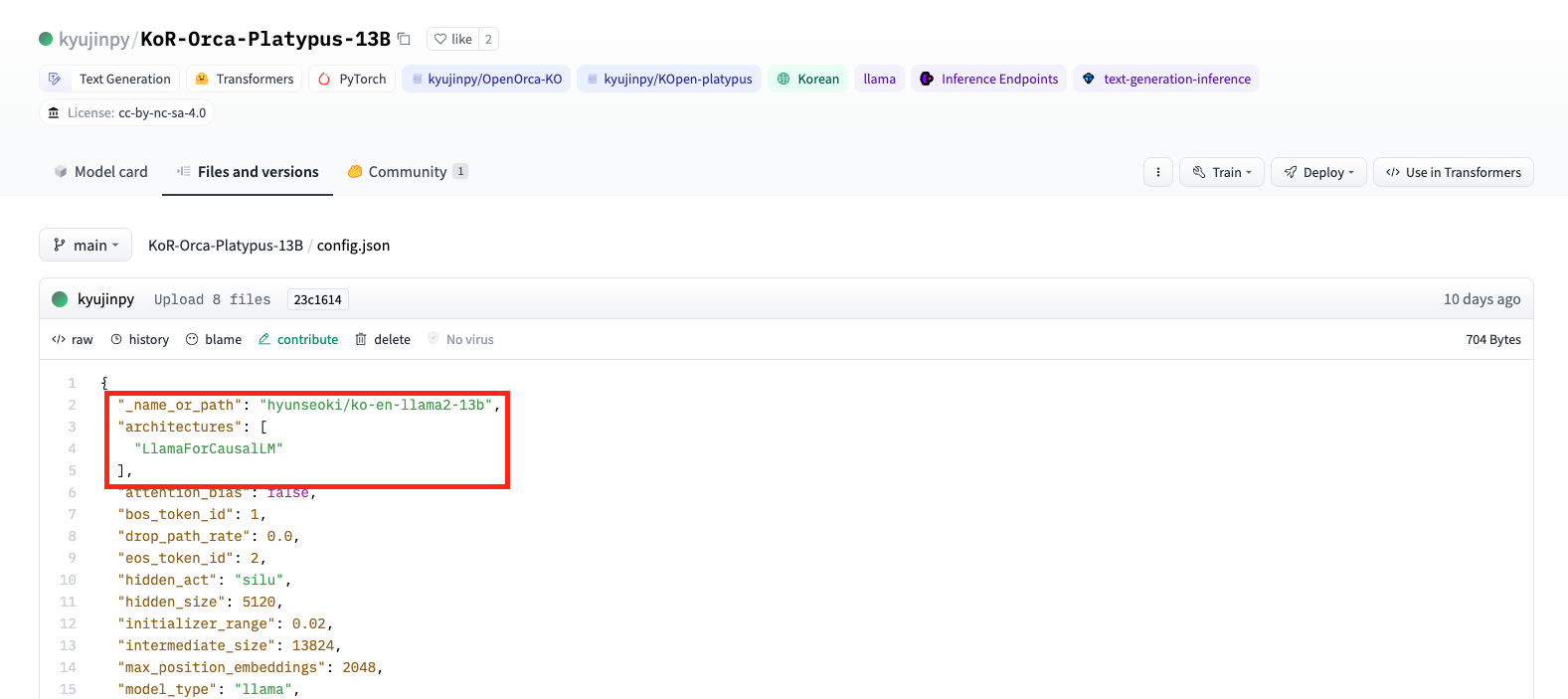

특히 가장 상단에 있는 kyujinpy/KoR-Orca-Platypus-13B의 config 파일을 열어보면, LLaMA-2 기반의 모델을 Instruction tuning 했다는 것을 확인할 수 있다.

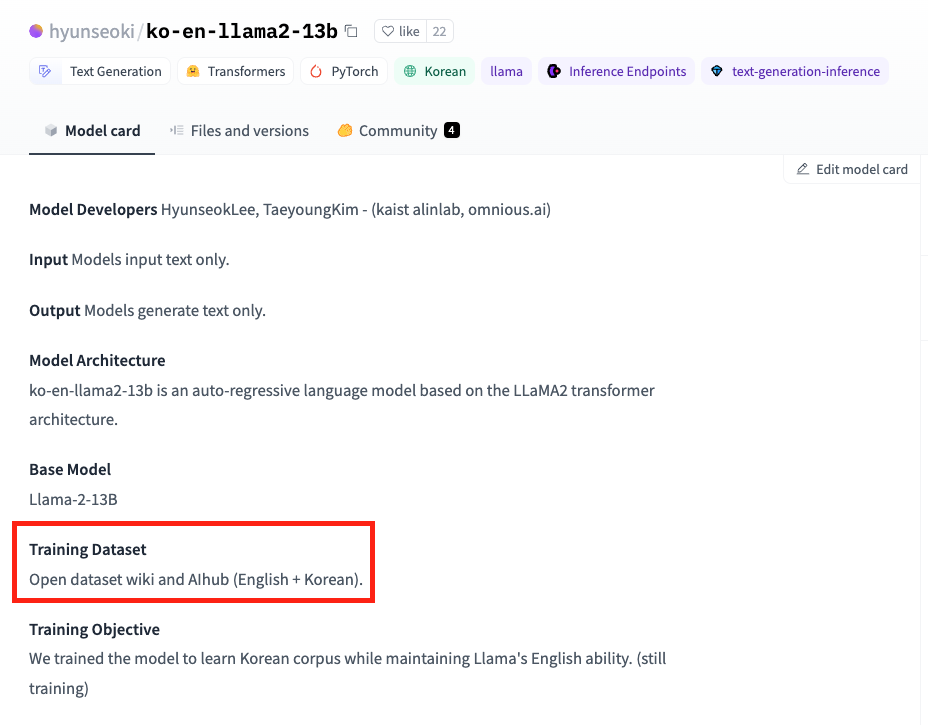

특히, 이 모델의 백본 모델은 hyunseoki/ko-en-llama2-13b 인데, 모델 개발자에 계신 분들의 소속이 카이스트인듯하다. 무엇보다 Training Dataset 부분을 살펴보면 wiki와 Aihub에서 가져온 영어와 한국어 데이터를 사용했다고 하는데 어떤 비율로 훈련시켰는지까지는 공개되어있지 않은 것 같다.

그러나 해당 데이터를 모두 모아서 훈련하는 것은 생각보다 많은 자원이 필요하다. 따라서 이보다 효율적인 방법을 탐색하던 중에 알게 된 것이 '코드 스위칭 코퍼스 기반 다국어 LLM의 지식 전이 연구'이다. 페이스북에서 김성현님이 올려두신 포스트를 보긴했으나 당시에는 바로 살펴보진 않았었다. 그러나 얼마전에 지인이 해당 논문에 대해 언급해주어서 해당 연구에 관심이 생겼고 논문을 살펴보게 되었다.

Background

현재 많은 LLM은 영어를 중심으로 개발되고 있다. 다국어 모델들은 주로 영어 기반의 LLM을 기반으로 한 재학습 과정을 거치게 되는데, 대부분 전이학습(Transfer Learning) 방법론을 사용한다.

언어 변환에 관한 최근 연구는 크게 두 가지 주요 방법론을 사용하고 있다.

1) 사전 학습된 모델의 구조적 특징을 변화시키지 않으며, 특정 언어의 데이터를 재학습하는 방법

2) 사전 학습 모델의 임베딩 층을 재 정의하거나 모델의 구조를 수정하는 방법

그러나 이런 방법들은 모델의 기존 지식이 손실된다는 문제, LLM과 같은 대형 모델에서는 대체로 실험이 성공적이지 않았다는 문제, 그리고 대량의 언어 코퍼스 요구(기존 소스언어의 20~50%)라는 문제가 있었다.

이에 따라 본 연구에서는 소량의 코드 스위칭(Code-Switching) 코퍼스로 모델을 재학습 하는 방법을 선택하였다.

Code-Switching 이란?

코드 스위칭(Code-Switching)은 두 가지 이상의 언어나 방언을 사용하는 사람들이 대화 중에 한 언어에서 다른 언어로 전환하는 현상을 의미한다고 한다.

[코드 스위칭에 대한 나무위키 글 / 재미로만 참고하면 좋을 것 같다.]

https://namu.wiki/w/%EC%BD%94%EB%93%9C%20%EC%8A%A4%EC%9C%84%EC%B9%AD

예를들어, "코드 스위칭에 대한 treewiki text 는 너무 funny한데" 처럼 이야기하는 것을 의미한다고 생각하면 된다.

데이터셋

본 연구에서는 코드 스위칭 코퍼스 구축을 위해 GPT-4 API와 한국어 위키피디아 문서를 활용했다고 한다. 한국어 위키피디아는 당연하게도 대부분 한국어로 작성되어있는데, 이를 GPT-4를 활용해서 Code-Switching 데이터 형태로 변환하는 것이다.

본 연구에서는 약 8000건의 데이터셋(LLaMA-2 tokenizer 기준으로 3M 토큰)을 제작하였는데, 데이터셋은 저자의 깃허브에 공개되어있다 (다운받기전에는 스타를 꼭 눌러주도록 하자).

실험 세팅

처음에는 실험 세팅을 꼼꼼하게 보지 않고 연구를 재현해봤는데, 생각보다 성능이 잘 나오지 않았다. 논문에 공개된 세팅을 그대로 사용하면 비슷한 결과를 얻을 수 있다.

- 시퀀스 길이: 2048

- 배치 크기: 32,

- 에폭 수: 5,

- 학습률: 4e-5

- 원본모델: LLaMA-2-7B

연구결과

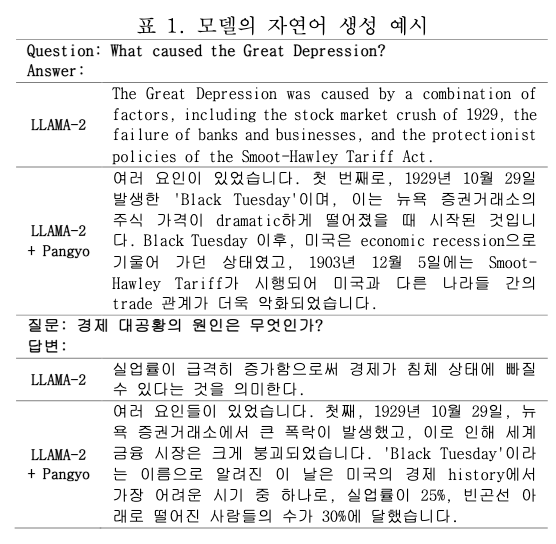

논문에서 공개된대로, 한국어로 질문해도 기존 LLaMA-2보다 훨씬 자세하게 답변할 수 있다는 사실을 확인할 수 있다.

실제로 동일한 세팅으로 모델을 학습시켰을때, 논문과 유사한 품질의 출력 결과를 확인할 수 있었다.

질문: 경제 대공황의 원인은 무엇인가?

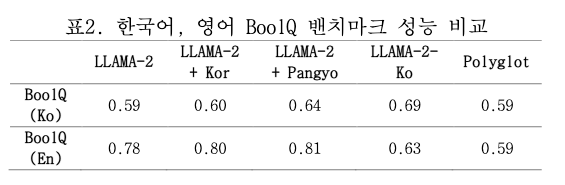

답변: 축적된 채무를 반환하는 것이 힘들어진 때문입니다. 이는 폭발적인 발전을 겪었던 미국의 경제 불규칙성이 발생한 것이 반영됩니다. 이는 불규칙성이 축적되었을 때 발생합니다. 불규칙성이 반영되는 것은 미국 경제의 축적된 채무 반환 문제가 발생한 것을 보여줍니다. 이 문제 는 1930년대의 경제 대공황 발생에 있었습니다. 이 채무 반환 문제는 미국 경제의 불규칙성에 대한 축적된 채무 반환 문제를 반영하고..벤치마크 성능도 기존 모델이나 대량의 한국어 코퍼스를 입력한 모델들과 비교할때, 상당히 좋은 성능을 보인다는 사실을 확인할 수 있다. 특히, 영어의 지식을 유지하는 상태에서 한국어 성능도 증가되었다는 점이 고무적이다.

총평

모델 구조의 변화없이, 적은 양의 데이터만으로 이렇게 좋은 품질의 한국어 성능을 보일 수 있다는 것은 매우 고무적인 일이다.

본 논문의 결과를 보면서 든 생각은 기존 영어교육에서 사용하던 학습방법론들을 가져와서 사용해보면 어떨까라고 생각해보았다.

그리고 Curriculum learning 으로 점점 입력되는 영어의 비중을 줄이거나 한국어의 복잡도를 올리는 방향으로 학습시키면 어떨까라고도 생각해봤다.

Reference

김성현, 이강희, 정민수, 이정우 (2023). 코드 스위칭 코퍼스 기반 다국어 LLM의 지식 전이 연구. 제35회 한글 및 한국어 정보처리 학술대회 논문집.

김성현 님의 깃허브 레포: https://github.com/MrBananaHuman/PangyoCorpora