Paper : Zip-NeRF: Anti-Aliased Grid-Based Neural Radiance Fields

Abstract

문제

- 공간 좌표에서 color 및 volumetric density에 대한 NeRF의 trained 매핑에서 grid-based representation을 사용하여 Neural Radiance Field training 가속화

- 그러나, grid 기반 접근 방식은 규모에 대한 명확한 이해가 부족하므로, jaggies 또는 누락된 scene content의 형태로 aliasing이 발생

- Anti-aliasing은 이전 mip-NeRF 360에 의해 해결

- Anti-aliasing : 높은 해상도의 신호를 낮은 해상도에서 나타낼 때 생기는 계단 현상(깨진 패턴)을 최소화하는 방법

- mip-NeRF 360 : ray 위의 점이 아니라 원뿔에 따른 하위 볼륨을 설명

→ 이 접근 방식은 grid 기반 기술과 호환되지 않음

제안

- mipNeRF 360과 Instant NGP을 결합

결과

- 이전 기술보다 8%~77% 낮은 오류율을 산출하고 mip-NeRF 360보다 24배 더 빠르게 training하는 기술을 구성

Background

- NeRF(Neural Radiance Fields)의 신경망은 3D 장면의 볼륨 표현을 모델링하도록 훈련되어 해당 장면의 새로운 뷰가 ray-tracing을 통해 렌더링될 수 있다.

- NeRF는 뷰 합성, 생성 미디어, 로봇 공학 및 컴퓨터 사진과 같은 작업에 효과적인 도구임이 입증되었다.

- 원래 NeRF 모델은 다층 퍼셉트론(MLP)을 사용하여 공간 좌표에서 색상 및 밀도로의 매핑을 매개 변수화했다.

- 소형이고 표현적이지만 MLP는 훈련 속도가 느리다.

- 최근 연구에서는 MLP를 복셀 그리드와 유사한 데이터 구조로 대체하거나 보강하여 훈련 속도를 높였다.

- Instant NGP(iNGP)는 coarse and fine 피라미드를 사용하여 작은 MLP에 의해 처리되는 학습된 feature를 통해 training 속도를 크게 높였다.

- 기존 NeRF 모델은 느린 것 외에도 앨리어싱된다.

- NeRF는 ray를 따른 개별 포인트의 렌더링된 이미지에서 "jaggies"가 발생하고 크기에 대해 추론하는 NeRF의 기능을 제한한다.

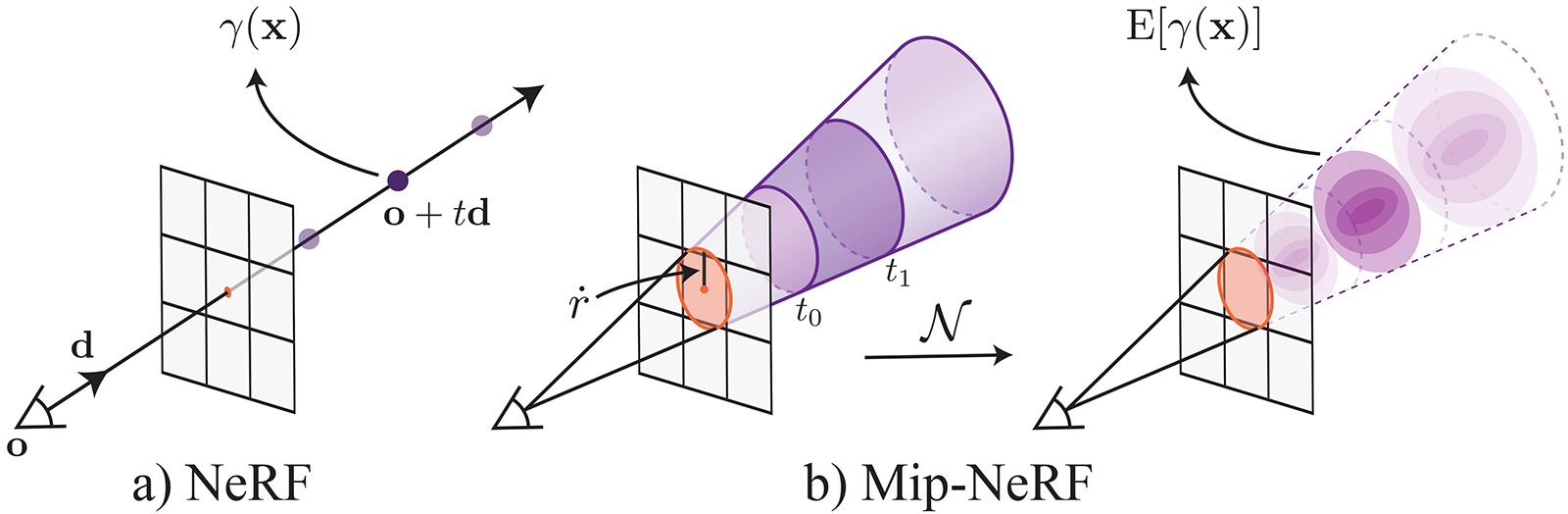

- Mip-NeRF는 ray 대신 cone을 캐스팅하고 MLP의 입력으로 사용하기 위해 원뿔형 frustum내에서 전체 볼륨을 특징으로 하여 이 문제를 해결했다.

- Mip-NeRF와 그 후속 mipNeRF 360은 이 접근 방식이 까다로운 실제 장면에서 매우 정확한 렌더링을 가능하게 한다는 것을 보여주었다.

- 빠른 훈련과 안티앨리어싱이라는 이 두 가지 문제에 대한 진전은 언뜻 보기에 서로 양립할 수 없다.

- 이는 mip-NeRF의 앤티앨리어싱 전략이 원뿔형 플라텀을 별개의 특징 벡터로 특징짓기 위한 위치 인코딩의 사용에 결정적으로 의존하지만, 현재의 그리드 기반 접근 방식은 위치 인코딩을 사용하지 않기 때문이다,

- 대신 단일 3D 좌표에서 그리드 계층으로 보간하여 얻은 학습된 기능을 사용한다.

- 안티 앨리어싱은 렌더링에서 잘 연구된 문제이지만, 대부분의 접근 방식은 iNGP와 같은 그리드 기반 NeRF 모델에서 역 렌더링으로 자연스럽게 일반화되지 않는다.

- 본 연구에서는 멀티 샘플링, 통계 및 신호 처리의 아이디어를 활용하여 iNGP의 피라미드 그리드를 mip-NeRF 360의 프레임워크에 통합한다.

- 속도, mipNeRF와의 유사성 및 zipper와 같은 앨리어싱 아티팩트를 수정하는 기능으로 인해 본 연구의 모델을 "Zip-NeRF"라고 명명한다.

- mip-NeRF 360 벤치마크에서 Zip-NeRF는 오류율을 최대 19%까지 줄이고 이전 최신 기술보다 24배 빠르게 훈련한다.

- 앨리어싱과 확장성을 보다 철저히 측정하는 벤치마크의 멀티스케일 변형에서 Zip-NeRF는 오류율을 77%까지 낮춥니다.

1. Preliminaries

- Mip-NeRF 360 및 Instant NGP(iNGP)는 모두 NeRF와 유사

- 픽셀은 캐스팅된 3D ray를 따라 거리 의 위치를 특징으로 하여 렌더링되며, 이러한 특징은 색상을 렌더링하기 위해 알파 합성된 출력의 신경망에 공급

- training은 training 이미지의 픽셀에 해당하는 ray를 반복적으로 캐스팅하고, 각 픽셀의 렌더링된 색상과 실제 색상 간의 차이를 최소화하는 것으로 구성

- Mip-NeRF 360과 iNGP는 ray를 따라 좌표를 매개변수화하는 방식이 다름

- mip-NeRF 360에서 ray는 일련의 간격 으로 세분화되며, 각 간격은 원뿔형 절두체로 모양이 multivariate Gaussian과 근사하고, 해당 Gaussian에 대한 예상 positional encoding은 큰 MLP에 대한 입력으로 사용

- iNGP는 작은 MLP에 대한 특징 벡터를 생성하기 위해 크기가 다른 3D 그리드의 계층 구조로 거의 보간

- 본 논문의 모델은 ‘mip-NeRF 360의 전체 프레임워크’와 ‘iNGP의 featurization 접근 방식’을 결합하지만, 이 두 가지 접근 방식을 단순하게 결합하면 두 가지 형태의 aliasing 발생

-

Instant NGP의 ‘feature grid 접근 방식’은 mip-NeRF 360의 ‘scale-aware integrated positional encoding 기술’과 호환되지 않으므로 iNGP에서 생성된 feature는 공간 좌표에 대해 앨리어싱된 렌더링 생성

→ 섹션 2에서 사전 필터링된 iNGP feature를 계산하기 위한 멀티샘플링 유사 솔루션을 도입하여 이 문제를 해결

-

iNGP를 사용하면 훈련 속도가 크게 향상되지만, 이는 카메라가 이동함에 따라 장면 콘텐츠가 불규칙하게 사라지는 매우 가시적인 “z-aliasing"(ray를 따라 aliasing)을 유발하는 mip-NeRF 360의 online distillation 접근 방식의 문제 발생

→ 섹션 3에서 online distillation를 감독하는 데 사용되는 loss function을 계산할 때 각 ray를 따라 미리 필터링하는 새로운 loss function으로 이 문제를 해결

-

2. Spatial Anti-Aliasing

-

Mip-NeRF는 원뿔형 frustum인 하위 볼륨 내 좌표의 positional encoding에 대한 적분을 근사화하는 feature 사용

- 따라서 feature sinusoid’s 곡선의 주기가 Gaussian 표준 편차보다 클 때 진폭이 작은 Fourier feature가 생성

- feature는 하위 볼륨의 크기보다 큰 파장에서만 하위 볼륨의 공간 위치를 표현

- 이 feature는 위치와 스케일을 모두 인코딩하기 때문에 이를 소비하는 MLP는 Anti-Aliasing 이미지를 렌더링하는 3D 장면의 다중 스케일 표현을 학습할 수 있음

-

iNGP와 같은 Grid-based representation은 기본적으로 하위 볼륨의 쿼리를 허용하지 않음

- 대신 단일 지점에서 3선 보간을 사용하여 MLP에서 사용할 기능을 구성하므로 스케일 또는 앨리어싱에 대해 추론할 수 없는 학습된 모델이 생성

-

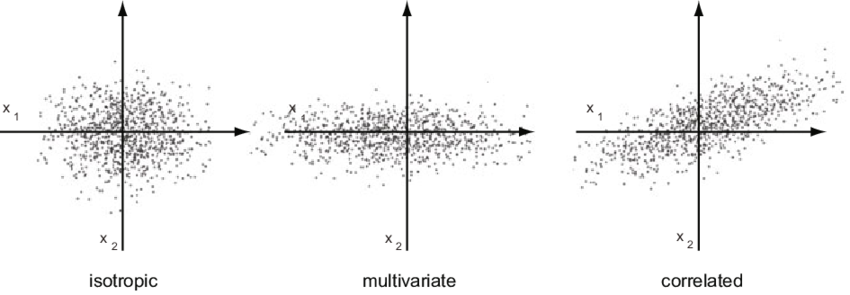

본 연구는 multisampling과 feature-downweighting의 조합을 사용하여 각 원뿔 frustum을 isotropic(등방성) Gaussians 세트로 전환하여 이를 해결

Gaussian mutation

- 비등방성 하위 볼륨은 먼저 모양에 가까운 점 세트로 변환된 다음 → 각 점이 일정한 척도를 가진 등방성 가우시안으로 가정

- 이 등방성 가정을 통해 grid의 값이 zero-mean 이라는 사실을 활용하여 하위 볼륨에 대한 형상 grid의 실제 적분을 근사화

- 이런 가중치가 낮은 feature를 평균화하여 iNGP grid에서 scale-aware prefiltered feature를 얻음

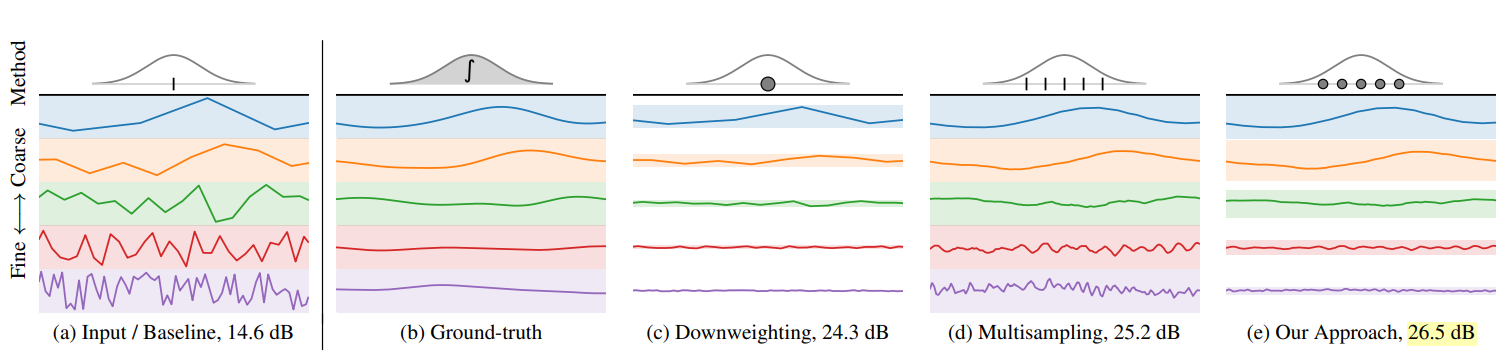

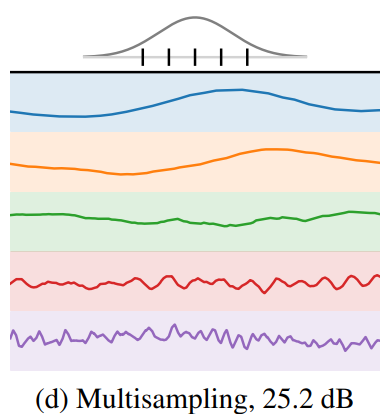

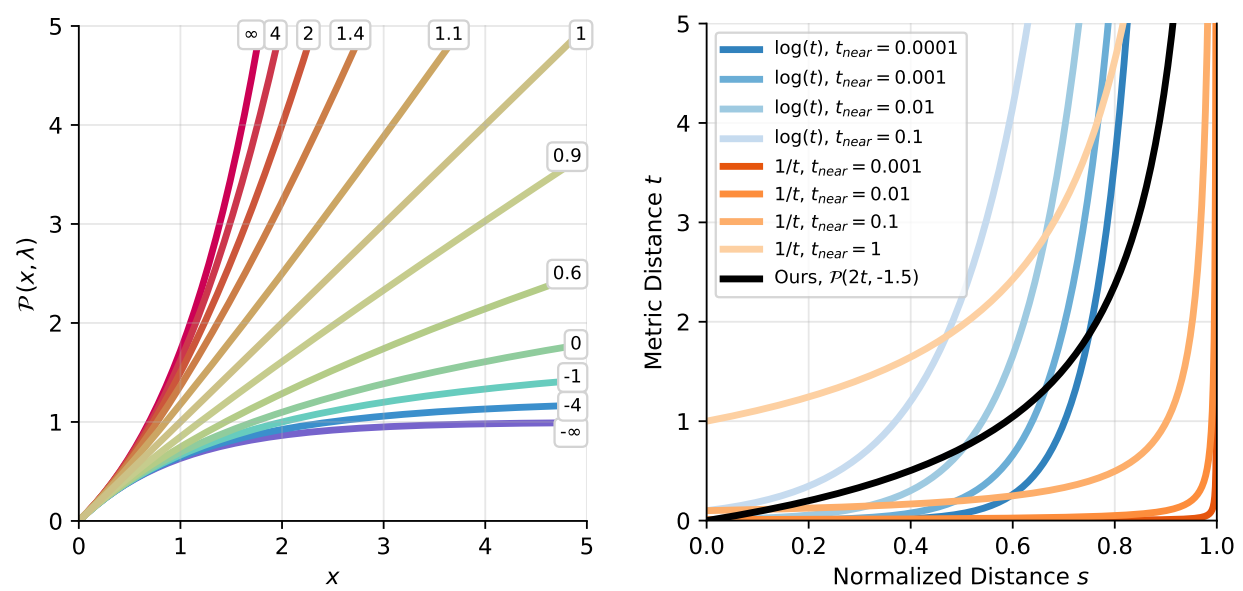

Figure 2: scale 당 1개의 faeture가 있는 toy 1차원 iNGP. 각 하위 플롯은 축을 따라 모든 좌표에서 iNGP를 쿼리하기 위한 다른 전략을 나타냄. 각 선은 각 좌표에 대한 iNGP feature이며, 각 색상은 iNGP에서 서로 다른 scale.

(a) Gaussian의 평균을 쿼리하는 naive 해결법은 Gaussian의 대역폭을 지나는 고주파가 크고 부정확한 부분 선형 꼬임을 가진 특징을 초래

(b) 진정한 솔루션은, iNGP 기능을 가우스(실제로는 다루기 어려운 솔루션)로 변환하여 얻은 결과, 부드러우면서도 정보를 제공하는 거친 기능과 0에 가까운 미세한 기능이 생성

(c) 우리는 가우스 척도를 기반으로 주파수를 낮게 가중치를 부여하여 신뢰할 수 없는 고주파를 억제할 수 있지만(각 특징 뒤의 색상 밴드는 가중치를 낮춤), 이는 거친 특징에서 부자연스럽게 날카로운 불연속성을 초래

(d) 또는 슈퍼샘플링은 합리적이고 거친 스케일 특징이지만 불규칙한 미세 스케일 특징을 생성

(e) 따라서 우리는 등방성 하위 가우스인(여기에 표시된 5)을 다중 샘플링하고 각 하위 가우스의 척도를 사용하여 주파수의 가중치를 낮춤

- Mip mapping (mip-NeRF)는 빠른 anti-aliasing을 가능하게 하는 데이터 구조를 사전 계산하지만, 이 접근 방식을 iNGP의 해시 기반 데이터 구조에 어떻게 적용할 수 있는지는 불분명

- Supersampling은 anti-aliasing에 대해 무차별적인 접근 방식을 채택하고 많은 샘플을 사용 → 비쌈

- Multisampling은 작은 샘플 세트를 구성한 다음, multisample의 정보를 값비싼 렌더링 프로세스에 제공되는 집합 표현으로 pooling→ 본 연구의 접근 방식

Multisampling

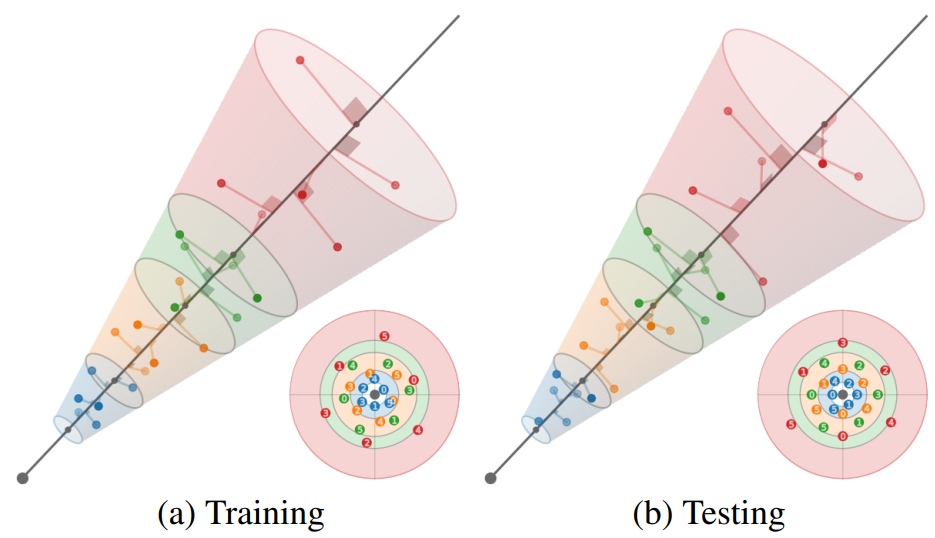

- mip-NeRF에 따라, 각 픽셀이 반경 을 가진 원뿔에 해당한다고 가정

- : ray를 따르는 거리

- ray 의 간격으로 원뿔형 frustum의 모양의 다중 샘플 세트를 구성

- 아래 각도 를 가진 6-point 육각형 패턴

-

이는 원의 한 회전을 중심으로 선형으로 회전하는 각도로, 60도씩 이동하는 한 쌍의 삼각형을 주기 위해 순열화

-

- ray 를 따르는 거리

-

이 값은 에서 선형으로 측정된 값이며, 이동하고 크기를 조정하여 frustum의 far base 근처에 질량을 집중시킴

-

- 본 연구의 multisample 좌표는 ray에 상대적

- 이러한 3D 좌표는 세 번째 벡터를 ray 방향인 orthonormal basis에 곱하여 세계 좌표로 회전 → 광선 원점으로 이동

- 처음 두 벡터가 ray에 수직인 임의 프레임

- 구성에 따라, 이러한 multisample의 샘플 평균과 분산(ray에 따라 수직)은 mip-NeRF Gaussians와 유사하게 원뿔 frustum의 것과 정확하게 일치

- training 중에는 각 패턴을 무작위로 회전 및 플립하고, rendering 중에는 결정적으로 다른 모든 패턴을 30도씩 플립 및 회전

- 이러한 3D 좌표는 세 번째 벡터를 ray 방향인 orthonormal basis에 곱하여 세계 좌표로 회전 → 광선 원점으로 이동

Figure 3 : 4개의 색상으로 표시된 frustum으로 분할된 과장된 픽셀 폭(ray를 따라 inset으로 표시)을 가진 toy 3D ray. 각 frustum의 첫 번째 및 두 번째 모멘트와 일치하는 육각형 패턴으로 각 frustum을 다중 샘플링. 각 패턴은 ray를 중심으로 회전하고 (a) Training 시 무작위로 ray를 따라 뒤집히고 (b) Rendering 시 결정적으로 뒤집힘

- 이 6개의 multisample 을 각각 표준 편차가 인 등방성 가우스의 평균으로 사용

- 모든 실험에서 0.5인 hyperparameter에 의해 축적된 를 로 설정

- iNGP grid는 경계 영역에 놓이기 위해 입력 좌표가 필요하기 때문에, mip-NeRF 360의 contraction function을 적용

- 이러한 가우스파는 등방성이기 때문에, mip-NeRF 360에서 사용되는 칼만 필터 접근법의 효율적인 대안을 사용하여 이 수축에 의해 유도된 스케일 팩터를 계산할 수 있음

Downweighting

- multisampling은 aliasing을 줄이기 위한 효과적인 도구 → 그러나 위 그림처럼 각 multisample에 대해 단순한 3선 보간법을 사용하면 여전히 고주파에서 aliasing이 발생

- 각 개별 multisample에 대한 anti-alias 보간을 위해 각 multisample의 등방성 가우스가 각 grid 셀 내에 얼마나 적합한지에 반비례하는 방식으로 각 스케일에서 feature의 가중치를 다시 부여

- Gaussian이 보간되는 셀보다 훨씬 클 경우, 보간된 형상은 신뢰할 수 없으므로 가중치를 낮춰야 함

- Mip-NeRF의 IPE feature도 유사한 해석

- iNGP는 좌표 에서 각 에 대한 보간은 를 grid의 선형 크기 으로 스케일링하고 길이 벡터를 얻기 위해 로 3선 보간을 수행

- 본 연구에서는 대신 평균이 이고 표준 편차가 인 다중 샘플링된 등방성 가우스 세트를 보간

- Gaussian CDF에 대한 추론을 통해 의 큐브 안에 있는 각 Gaussian PDF의 부분을 계산할 수 있음

- 여기서 , 여기서 ∈j, ω[0, 1]로 보간

- 에 가중치 감쇠를 적용하여 의 값이 정규 분포를 따르고 zero-mean이 되도록 권장

- zero-mean 가정을 통해 각 multisample의 Gaussian에 대한 예상 grid feature을 로 근사 가능

- 이를 통해 각 multisample의 보간된 feature의 가중 평균을 취함으로써 특징화되는 원뿔 frustum에 해당하는 예상 feature 근사화 가능 :

- 이 feature 집합 은 연결되어 iNGP에서와 같이 MLP에 대한 입력으로 제공

- 또한 featurized 버전의 를 연결

3. Z-Aliasing and Proposal Supervision

-

multisampling 및 downweighting 방식은 spatial aliasing을 줄이는 효과적인 방법이지만, ray를 따라 고려해야 하는 추가 aliasing 소스가 있으며, 이를 ‘-aliasing’이라고 함

- z-aliasing은 장면 지오메트리에 대한 상한을 생성하는 방법을 학습하는 제안 MLP를 mip-NeRF 360이 사용

- 훈련 및 렌더링 중에 이 제안 MLP에 의해 광선을 따른 간격이 반복적으로 평가되어 다음 샘플링에 의해 재샘플링되는 히스토그램을 생성하며, 최종 샘플 세트만 NeRF MLP에 의해 렌더링

- Mip-NeRF 360은 이 접근 방식이 이미지 재구성을 사용하여 감독되는 하나 또는 여러 개의 NeRF를 학습하는 이전 전략에 비해 속도와 렌더링 품질을 크게 향상

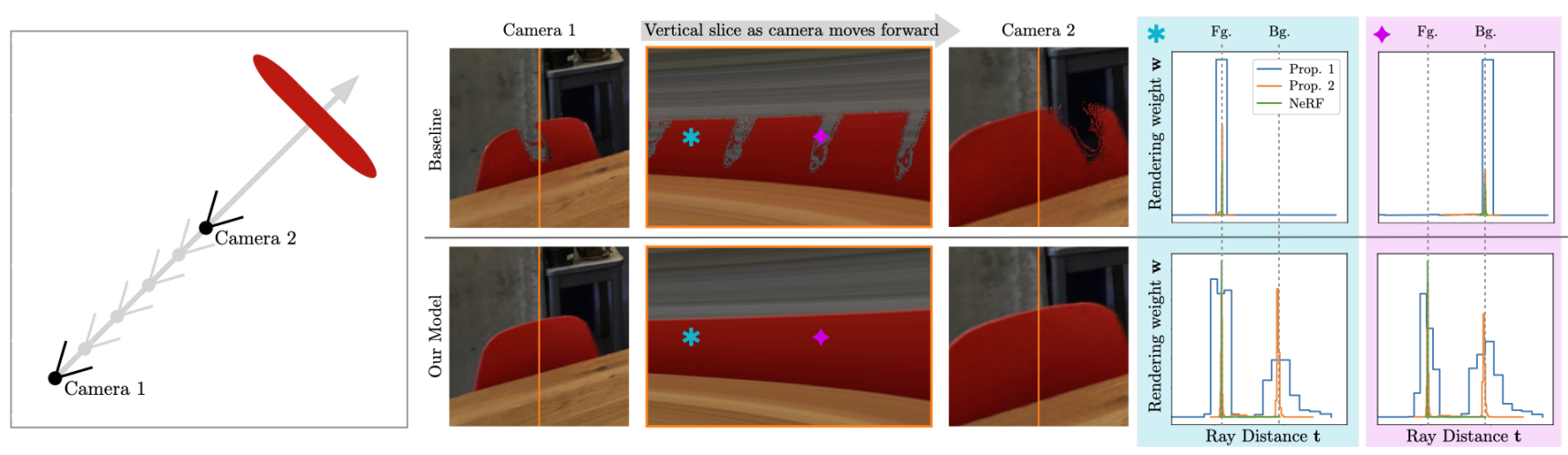

- 본 연구에서는 mip-NeRF 360의 제안 MLP가 입력 좌표에서 출력 체적 밀도로 매끄럽지 않은 매핑을 학습하는 경향을 관찰 → ray가 장면 내용을 "skips"하는 아티팩트 발생

- 이 아티팩트는 mip-NeRF 360에서 미묘하지만 MLP 대신 제안 네트워크에 iNGP 백엔드를 사용하면(따라서 모델의 신속한 최적화 능력을 향상시킬 수 있음) 특히 카메라가 z축을 따라 변환할 때 일반적이고 시각적으로 두드러짐

-

mip-NeRF 360에서 -aliasing의 근본 원인은 proposal 네트워크를 감독하는 데 사용되는 "interlevel loss"

-

proposal 히스토그램 bin은 중복이 부분적이든 완전하든 상관없이 NeRF 및 제안 히스토그램 bin에 동등한 loss 할당

-

proposal 히스토그램 bin은 중복이 완전히 실패할 때만 불이익을 받음

→ 이 문제를 해결하기 위해 mip-NeRF 360의 level 간 loss와 달리 ray를 따라 거리와 관련하여 연속적이고 매끄러운 대체 loss을 제시

Figure 6: 좁은 NeRF 히스토그램(파란색)이 coarse proposal 히스토그램(주황색)에 상대적으로 ray를 따라 변환되는 toy setting에 대한 proposal 감독 시각화. (a) mip-NeRF 360에서 사용되는 loss는 조각별로 일정하지만 (b) NeRF 히스토그램을 조각별 선형 스플라인(녹색)으로 흐리기 때문에 loss가 원활하다. 사전 필터링된 loss를 통해 anti-aliasing proposal 분포를 학습할 수 있다.

-

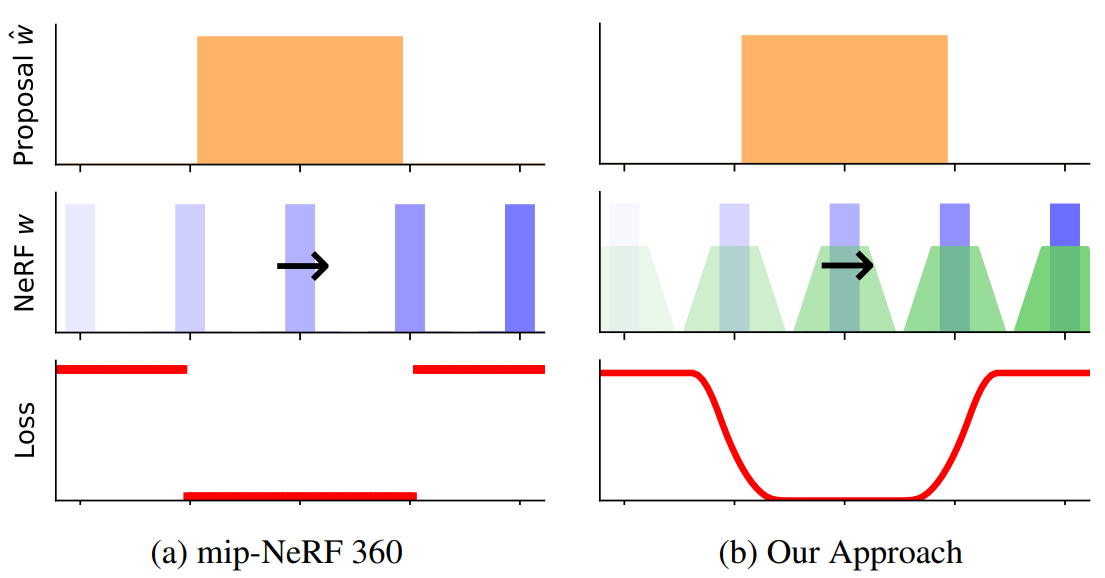

Blurring a Step Function

- ray를 따라 거리에 대해 매끄러운 loss function 설계 : ‘piecewise constant step function’ → ‘continuous piecewise-linear function’로 변환하는 기술을 구성해야 함

- discrete 1D 신호를 매끄럽게 하는 것은 사소한 일이며 box filter(혹은 Gaussian filter)를 사용하여 discrete convolution만 필요로 함

- 그러나 step function의 각 구간의 끝점이 임의의 위치에 있을 수 있기 때문에 끝점이 연속적인 piecewise constant function를 처리할 때 어려워짐

- step function을 래스터화하고 컨볼루션을 수행하는 것은 매우 좁은 히스토그램 bin의 일반적인 경우에 실패하기 때문에 실행 가능한 솔루션이 아님 → 따라서 새로운 알고리즘이 필요

- step function 를 예로

- : 구간 의 끝점이고

- : 구간 내부의 step function 값

- 이 step function을 에 통합되는 반지름 r을 가진 직사각형 펄스로 컨볼루션하려고 함

- : Iverson brackets

- 이 직사각형 펄스를 갖는 스텝 함수의 단일 간격 의 컨볼루션은 에서 매듭을 갖는 piecewise linear trapezoid

- piecewise linear spline은 각 spline 매듭에 위치한 스케일 델타 함수의 이중 적분

- 직사각형 펄스로 step function을 효율적으로 컨벌루션할 수 있음

-

step function의 각 끝점 를 인접 값 사이의 변화에 비례하는 값으로 및 에 위치한 두 개의 서명된 델타 함수로 변환

-

이러한 델타 함수를 정렬을 통해 interleave(정렬)한 다음 정렬된 델타 함수를 두 번 통합

→ 이를 통해 anti-aliased loss function를 구성할 수 있음

-

Anti-Aliased Interlevel Loss

- mip-NeRF 360의 proposal supervision 접근법은 NeRF 에 의해 생성된 step function과 proposal 모델에 의해 생성된 유사한 step function 을 입력으로 취하는 loss function 필요

-

이러한 두 단계 함수는 히스토그램이며 각 히스토그램의 끝점은 다름

-

와 : 끝점 위치의 벡터(둘은 동일하지 않음)

-

와 : 가중치 벡터로 합계가

-

: 보이는 장면 내용이 단계 함수의 간격 i인 방식

-

: 일부 정규화 함수 에 따라 실제 메트릭 거리 의 일부 정규화 함수

Figure 5. anti-aliased loss를 계산하기 위해서는 NeRF 히스토그램 을 평활화하고 proposal 히스토그램 과 동일한 끝점 세트로 다시 샘플링해야 한다. (1) 를 의 각 구간의 크기로 나누어 1 이하로 통합하는 piecewise constant PDF를 생성한다. (2) 이 PDF를 직사각형 펄스와 결합하여 piecewise linear PDF를 얻는다. (3) 이 PDF는 통합되어 의 각 위치에서 piecewise quadratic interpolation을 통해 쿼리되는 piecewise-quadratic CDF를 생성한다. (4) 인접한 보간 값 사이의 차이를 취함으로써 proposal 히스토그램 의 끝점으로 다시 샘플링된 NeRF 히스토그램 가중치 인 를 얻는다. (5) 리샘플링 후, 공통 좌표 공간을 공유하므로 loss 을 와 의 element-wise function으로 평가한다.

-

- aliasing을 도입하지 않고 NeRF에 의해 예측된 scene geometry을 결합하도록 proposal 네트워크를 훈련 : ray를 따른 변환에 대한 부드러운 와 사이의 거리를 측정할 수 있는 loss function 필요

- NeRF 히스토그램 을 블러링하고 블러링된 분포를 proposal 히스토그램 의 간격 집합으로 리샘플링하여 새로운 히스토그램 가중치 를 생성

- blurred NeRF 가중치를 proposal 히스토그램의 공간에 리샘플링한 후 loss function는 와 의 element-wise function :

- 이 loss는 mip-NeRF 360(a halfquadratic chi-squared loss with a stop-gradient)과 유사하지만, 를 생성하는 데 사용되는 블러링 및 리샘플링은 앨리어싱을 방지

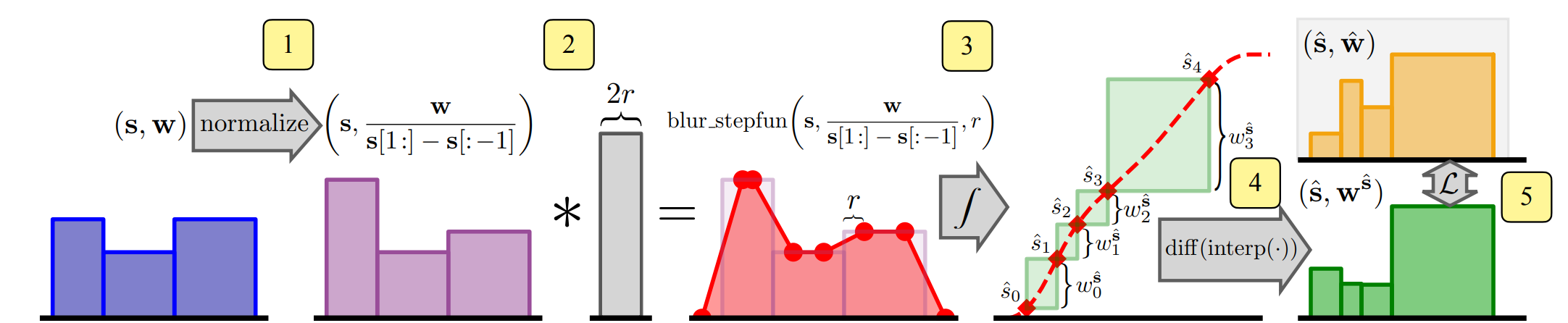

Normalizing Metric Distance

- mip-NeRF 360과 마찬가지로, ray (수동 정의)를 따르는 metric distance를 정규화된 거리 의 관점에서 매개 변수화

- 렌더링은 metric distance 를 사용하지만, 리샘플링 및 proposal supervision은 normalized distance 를 사용하며, 는 둘 사이의 편향을 정의

- mip-NeRF 360에서 사용되는 interlevel loss는 거리의 단조로운 변환에 불변하므로 의 선택에 영향을 받지 않음

- 그러나 anti-aliased loss의 prefiltering은 이러한 불변성을 제거하며, 모델에서 mip-NeRF 360의 를 사용하면 부적합하므로 새로운 정규화 구성 :

- 원점에서 이 함수의 기울기는 1이므로, ray 원점 근처의 정규화된 거리는 메트릭 거리에 비례

(0이 아닌 near plane 를 조정할 필요성 제거)

- 원점에서 멀리 떨어진 메트릭 거리는 log-distance 또는 inverse-distance 와 유사하게 곡선이 됨 → 이를 통해 서로 다른 개별 함수로 교환하는 대신 서로 다른 정규화 사이를 원활하게 보간 가능

-

- 일 때 대략 선형이지만 일 때 역제곱과 역제곱 사이에 있는 곡선

Figure 7. 많은 NeRF 접근법에는 metric distance 를 normalized distance ∈ [0, 1]로 변환하기 위한 함수가 필요하다. Left : 전력 변환 를 사용하면 원점 근처에서 선형과 같은 모양을 유지하면서 을 수정하여 선형, 로그, 역곡선과 같은 공통 곡선 사이를 보간할 수 있다. Right: 이를 통해 선형에서 역/역 사각형으로 전환되는 곡선을 구성할 수 있으며 카메라에 가까운 장면 콘텐츠를 지원하다.

4. Results

- 본 연구는 JAX로 구현되고 mip-NeRF 360 코드베이스에 기초하여 mip-NeRF 360에서 사용되는 큰 MLP를 대신하여 iNGP의 복셀 격자 및 해시 피라미드를 재구현

- 전체 모델 아키텍처는 안티에이징 조정과 몇 가지 추가 수정 사항을 제외하고는 mip-NeRF 360과 동일

- mip-NeRF 360과 마찬가지로 각각 64개의 샘플로 두 라운드의 proposal 샘플링을 사용하고 마지막 NeRF 샘플링 라운드에서 32개의 샘플을 사용

- anti-aliased interlevel loss는 두 라운드의 proposal 샘플링에 부과되며 첫 번째 라운드에서는 r = 0.03, 두 번째 라운드에서는 r = 0.003의 직사각형 펄스 폭을 가지며 loss multiplier 0.01

- 각 라운드의 proposal 샘플링에 별도의 proposal iNGP와 MLP를 사용하고, NeRF MLP는 iNGP에서 사용되는 것보다 훨씬 큰 view-dependent branch 사용

- iNGP에 대한 작지만 중요한 수정 사항 중 하나는 그리드 및 해시 피라미드에 저장된 기능 코드에 정규화된 가중치 감쇠를 부과하는 것 :

- 각 피라미드 레벨 에서 grid/hash 값 제곱의 평균의 합을 penalizing함으로써, coarse scales은 fine scales보다 큰 크기의 차수로 penalizing을 받기 때문에 모든 값의 합을 벌칙으로 하는 순진한 해결책과는 다른 행동을 유도

- 가중치 감쇠가 없는 것에 비해 성능을 크게 향상시키고 naive 가중치 감쇠를 크게 능가

- 모든 실험에서 이 정규화된 가중치 감쇠에 대해 0.1의 loss multiplier를 사용

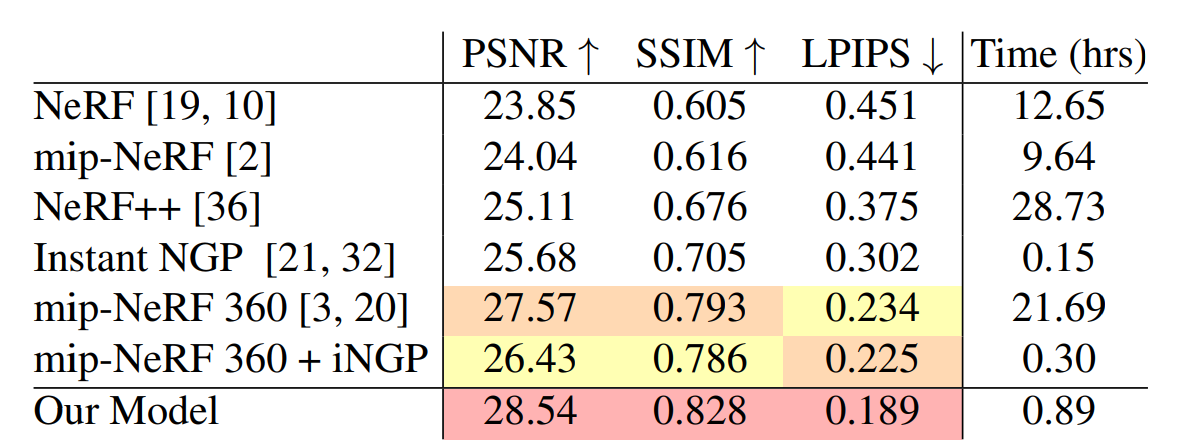

360 Dataset

- 모델은 mipNeRF 360의 확장 모델이므로 동일한 평가 절차를 사용하여 본 논문에 제시된 "360" 벤치마크에서 평가

- NeRF, mip-NeRF, NeRF++, mipNeRF 360, iNGP (tuned hyperparameter), 그리고 본 논문의 기여 없이 mip-NeRF 360과 iNGP를 단순하게 결합하는 baseline 평가

- our model, mip-NeRF 360 및 "mip-NeRF 360 + iNGP" baseline은 모두 8개의 NVIDIA Tesla V100-SXM2-16GB GPU에서 훈련

- 다른 baseline NeRF, mip-NeRF 및 NeRF+은 TPU를, iNGP은 단일 NVIDIA 3090를 사용하였고 하드웨어에서 대략적인 성능을 비교하기 위해 실행 시간 재조정

- our 모델의 렌더링 시간은 0.9s, mip-NeRF 360은 7.4s, mip-NeRF 360 + iNGP baseline은 0.2s

- our 모델은 이 벤치마크에서 mip-NeRF 360 (이전 SOTA)을 크게 능가

Table 2. Performance on the 360 dataset. Runtimes shown in gray are approximate, see text for details.

Table 2. Performance on the 360 dataset. Runtimes shown in gray are approximate, see text for details.-

RMSE, DSSIM 및 LPIPS가 각각 11%, 17%, 19% 감소함을 관찰

-

our 모델은 mip-NeRF 360보다 24배 더 빨리 학습

-

our 모델은 iNGP보다 훈련 속도가 ~6배 느리지만, RMSE, DSSIM 및 LPIPS가 28%, 42%, 37% 감소 iNGP와 비교하면 오류가 훨씬 더 크게 감소

-

결합된 "mipNeRF 360 + iNGP" baseline 훈련은 mip-NeRF 360보다 훨씬 빠르고, mip-NeRF 360과 동등하고 iNGP보다 더 나은 오류율을 생성

-

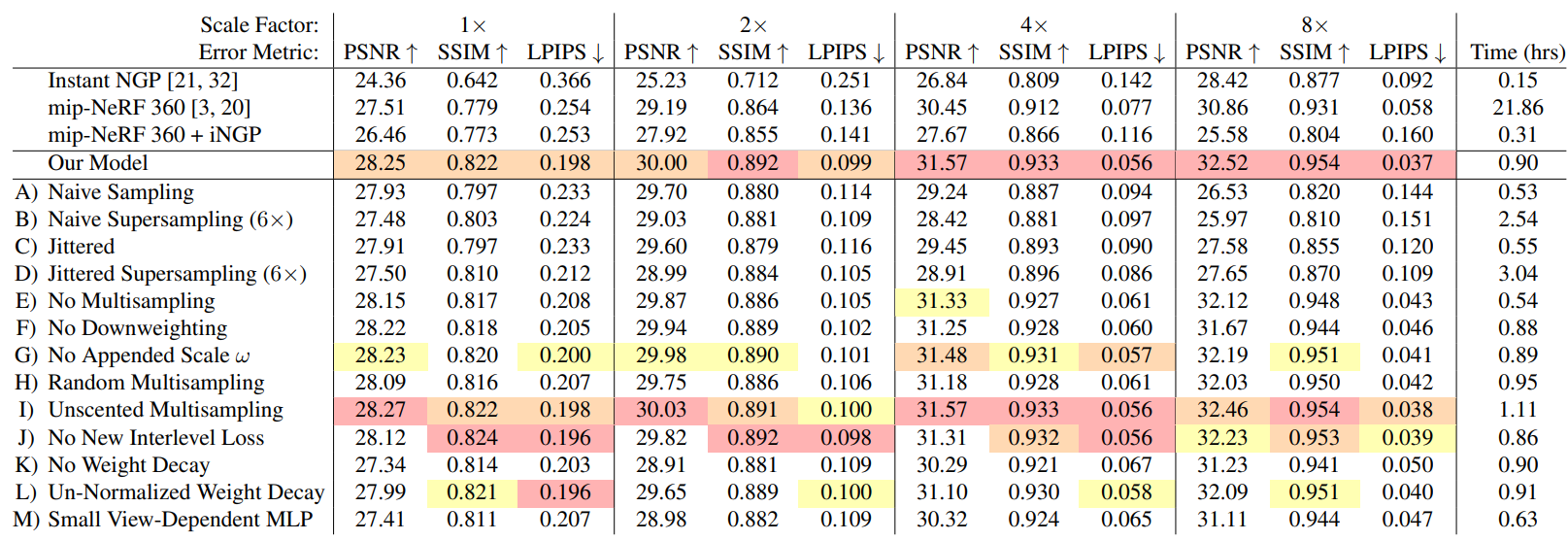

Multiscale 360 Dataset

- 360 데이터 세트에는 도전적인 장면 콘텐츠가 포함되어 있지만 렌더링 품질을 스케일의 함수로 측정하지는 않음

- 이 데이터 세트는 중심 객체 주위의 카메라를 거의 일정한 거리로 선회하여 캡처되었기 때문에 학습된 모델은 서로 다른 이미지 해상도 또는 중심 객체와의 서로 다른 거리에서 잘 일반화할 필요가 없음

- 따라서 mip-NeRF에서 사용되는 멀티스케일 블렌더 데이터 세트와 유사한 보다 도전적인 평가 절차를 사용

- 다운샘플링된 이미지를 스케일 팩터에 의해 바이큐빅 다운샘플링된 4개의 이미지 세트로 변환합

- 훈련 중에는 데이터 항에 각 광선의 스케일 팩터를 곱하고, 테스트 시에는 각 스케일을 별도로 평가

- 이는 학습된 모델이 스케일에 걸쳐 일반화하도록 요구함으로써 재구성의 난이도를 크게 높이며, 앨리어싱 아티팩트가 특히 거친 스케일에서 매우 두드러지도록 함

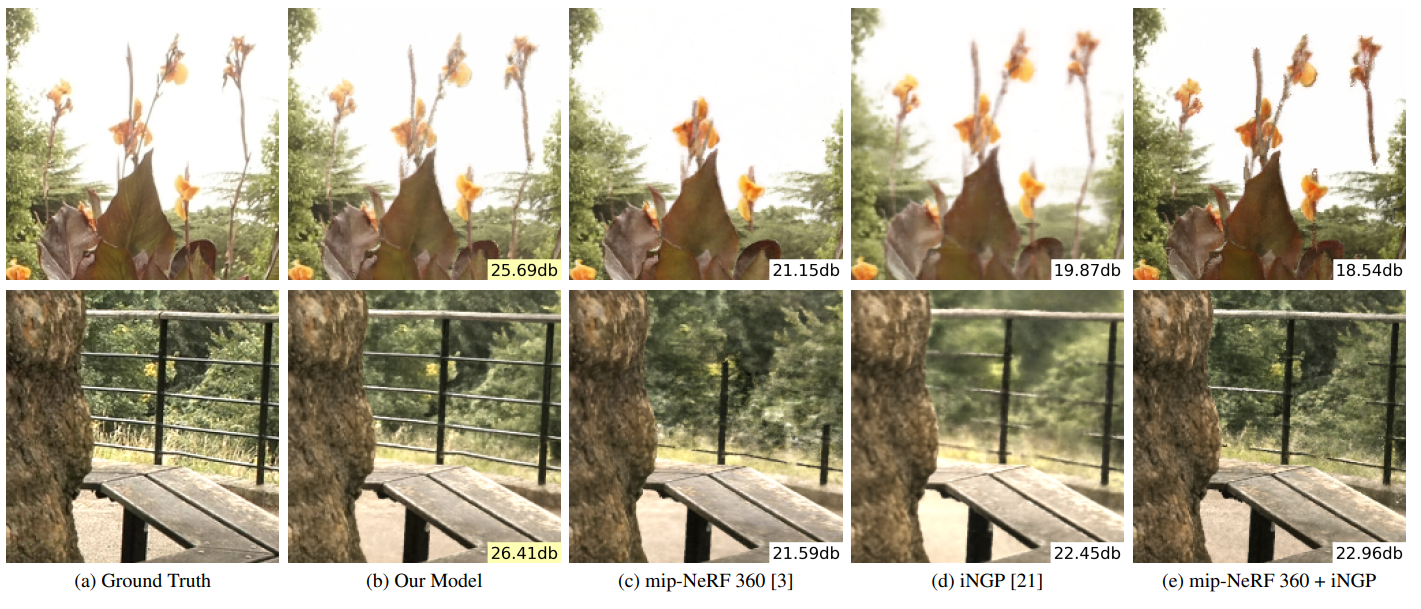

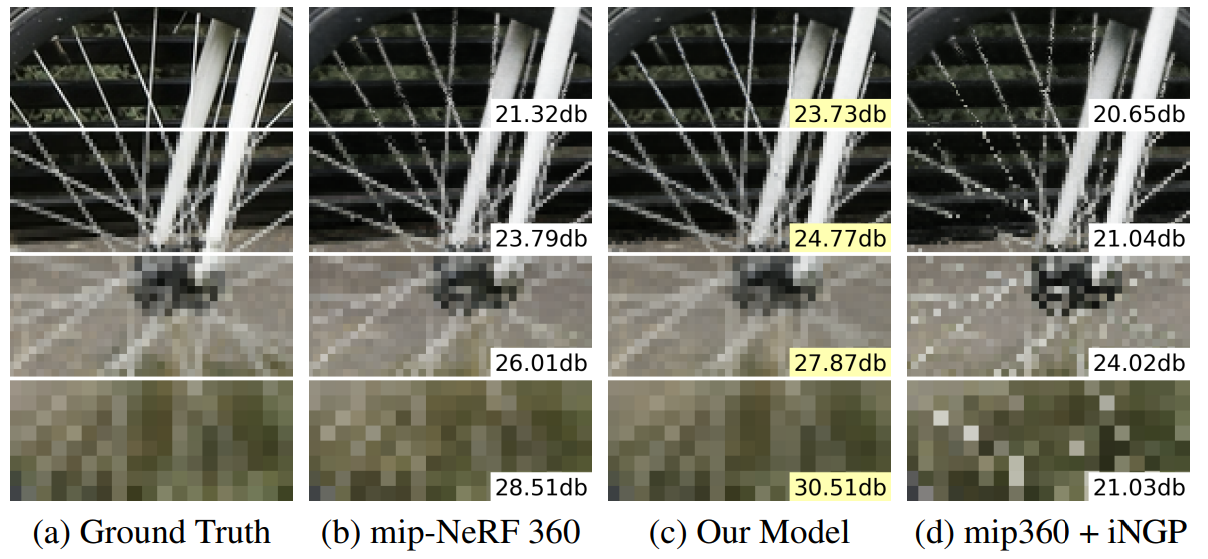

Table 1. 360 데이터 세트의 멀티스케일 버전에서 성능은 멀티스케일 이미지를 훈련하고 평가한다. 빨간색, 주황색 및 노란색 강조 표시는 각 메트릭에 대해 1위, 2위 및 3위의 성능 기술을 나타낸다. 우리 모델은 특히 iNGP 기반의 두 기준선을 크게 능가하며, 특히 오류가 55%~77% 감소하는 거친 스케일에서 더욱 우수합니다.

-

iNGP, mipNeRF 360, mip-NeRF 360 + iNGP 기준선 및 많은 완화에 대해 모델을 평가

-

mip-NeRF 360은 (규모에 대해 추론할 수 있기 때문에) 합리적으로 성능을 발휘하지만, 우리의 모델은 최상의 스케일에서 8%, 가장 거친 스케일에서 17% RMSE를 감소시키는 동시에 24배 더 빠릅니다.

-

규모에 대한 안티 앨리어싱 또는 추론 메커니즘이 없는 mip-NeRF 360 + iNGP 기준선은 성능이 좋지 않음

-

우리의 RMSE는 최상의 스케일에서 19%, 가장 거친 스케일에서 55% 더 낮으며, 가장 거친 스케일에서 DSSIM과 LPIPS 모두 77% 더 낮음

Figure 8. (a) 훈련하고 테스트하는 4가지 스케일에서 멀티스케일 벤치마크의 테스트 세트 뷰. (b) Mip-NeRF 360은 스케일에서 합리적으로 동작하지만 (c) 모델, 특히 얇은 구조에서 성능이 우수합니다. (d) 특히 거친 스케일에서 iNGP 기반 기준선은 극도로 앨리어싱된 렌더링을 생성합니다. PSNR은 삽입되어 있습니다.

-

우리의 mip-NeRF 360 + iNGP 기준선은 표 2에서 예상할 수 있듯이 (가장 거친 스케일을 제외하고) 일반적으로 iNGP를 능가합니다.

-

-

ablation study

- (A) multisampling과 downweighting(NeRF 및 iNGP에 사용되는 접근법)이 비활성화된 상태에서 "naive" 샘플링 사용은 큰 품질 저하

- (B) multisample 예산과 일치하도록 6배 비율로 supersampling링하는 것은 정확도를 향상시키지 않음

- (C, D) 캐스팅되는 원뿔 내에서 naive 샘플을 무작위 jittering 하는 것은 coarse scale에서 약간 성능 개선

- (E) multisampling 및 (F) downweighting를 개별적으로 비활성화하면 각 구성 요소의 영향을 측정

- (G) 를 feature로 사용하지 않으면 약간 성능 저하

- (H) 각 mip-NeRF 가우시안에서 6개의 임의 포인트를 샘플링하거나 (I) 각 가우스에서 7개의 unscented transform control point를 사용하는 것과 같은 대체 multisampling 접근 방식은 multisample이 육각형 패턴에 대한 경쟁력 있는 대안이지만 속도/정확도가 약간 더 낮음

- (J) anti-aliased interlevel loss을 비활성화하면 단일 이미지 메트릭에 거의 영향을 미치지 않지만 비디오 결과에서 z 앨리어싱 아티팩트가 발생

- (K) normalized weight decay를 비활성화하면 정확도 크게 감소

- (L) non-normalized weight decay를 사용하면 정확도 감소

- (M) iNGP의 작은 view-dependent MLP를 사용하면 정확도 감소

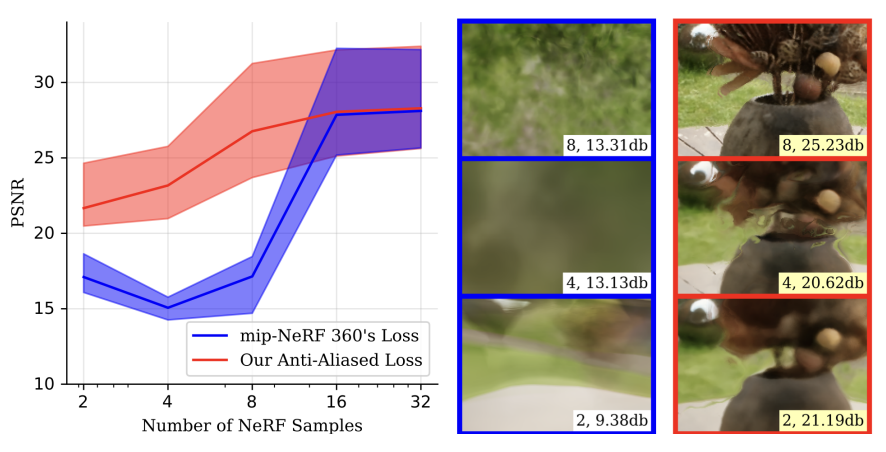

Sample Efficiency

- 다중 스케일 벤치마크에서 anti-aliased interlevel loss을 완화해도 mip-NeRF 360은 각 ray를 따라 많은 샘플을 사용하므로 -aliasing을 줄일 수 있으므로 품질이 크게 저하되지 않음

-

-aliasing에 대한 mip-NeRF 360의 취약성을 드러내기 위해 그림 9에서 다중 스케일 벤치마크에 대한 테스트 세트 PSNR을 구성하고, 광선을 따라 샘플 수(NeRF와 제안 네트워크 모두)를 2배로 줄이는 동시에 r과 훈련 반복 횟수를 두 배로 늘린다.

Figure 9. anti-aliased interlevel loss function(빨간색)는 NeRF 샘플 수가 32개에서 2개로 감소함에 따라 성능이 적절히 저하될 수 있습니다. Mip-NeRF 360의 손실(파란색)은 16개 미만의 샘플이 사용되면 치명적인 실패를 초래합니다. 여기서 우리는 테스트 세트 PSNR의 평균과 IQR을 플롯합니다. NeRF 샘플 수와 PSNR이 삽입됩니다.

-

우리의 안티 앨리어싱된 손실은 샘플 수가 많을 때 밉-NeRF 360의 손실을 약간 능가하지만, 샘플 수가 감소하면 기준선 손실은 치명적으로 실패하는 반면 손실은 심각하게 저하

-

- 즉, 누락된 장면 콘텐츠의 가장 끔찍한 z-앨리어싱 아티팩트(그림 4)는 장면 콘텐츠가 테스트 세트가 탐색하지 못할 수 있는 특정 거리에서만 사라지기 때문에 정지 영상의 작은 벤치마크에서 측정하기가 어려움

5. Conclusion

- 이전 ‘scale-aware anti-aliased NeRF’와 ‘빠른 grid-based NeRF’를 통합한 모델 Zip-NeRF 제시

- multisampling 및 prefiltering를 활용하여 이전 기술보다 8%~77% 낮은 오류율을 달성하는 동시에 mip-NeRF 360보다 24배 더 빠르게 훈련 가능