(1)-1 로지스틱 회귀 분석

- 회귀분석을 분류에 이용한 방법

- 독립 변수의 선형결합을 사용해 사건의 발생 가능성을 예측하는 분석방법

- 종속 변수(y)가 범주형 변수일 때 사용 가능

- 바로 범주형 변수를 반환 x, 각 범주(집단)에 포함될 확률 값을 반환하여 분류

- 어떤 사건이 발생할 확률과 발생하지 않을 확률로 나누어서 예측

- 이진 분류가 기본

- 다중 로지스틱 회귀분석 - 세 개 이상의 집단을 분류

- 독립변수 - 연속형, 종속변수 - 범주형일때 가능

- 독립 변수가 범주형일 경우 -> 범주형 독립변수를 더미변수로 변환하면 가능

- 독립 변수가 어떤 값을 가지든 종속변수는 확률값을 가짐

- 종속변수는 항상 0과 1사이 값 가짐 <- 오즈(Odds), 로짓(Logit)변환, 시그모이드 함수로

(1)-2 로지스틱 회귀 분석 알고리즘

- 오즈 (Odds)

- 성공할 확률이 실패할 확률의 몇 배인지를 나타내는 값

- 로지스틱 회귀분석에서 오즈를 사용하여 각 범주에 분류될 값을 추정

- 성공 / 실패

- 독립변수(x)가 주어졌을 때 성공확률 P, 실패확률 1-P -> 오즈값 : P / 1-P

- P는 확률 값이라 항상 0과 1사이의 값을 가져야 함 -> 오즈에 로그를 취해 항상 0과 1사이의 값을 가질 수 있음.

- 음수를 가질 수 없음.

- 확률값과 오즈의 그래프는 비대칭성을 띔.

- 로짓변환

- 로짓 (logit) ->오즈에 로그값을 취한 것

- log(Odds)

- 범위가 무한대에서 확장, 성공확률 0.5 기준으로 대칭 형태

- 시그모이드 함수

- 로지스틱 회귀 분석과 인공신경망 분석에서 활성화 함수로 활용되는 대표적인 함수 중 하나

- 로짓 함수와 역관계 -> 로짓함수를 통해 시그모이드 함수가 도출

(2)-1 의사결정 나무

- 자료를 학습하여 특정 분리 규칙을 찾아내고, 그에 따라 몇 개의 소집단으로 분류하는 분석 방법

- 의사결정이 진행되는 방식을 한 눈에 볼 수 있다.

- 올바른 분류를 위해서는 상위노드에서 하위노드로 갈수록 집단내 - 동질성, 집단간 - 이질성이 커져야 함.

- 회귀트리 -> 종속변수가 연속형, 분류트리 -> 종속변수가 이산형

- 활용 : 세분화, 분류, 예측, 차원 축소 및 변수 선택, 교효작용

- 장점 : 모델이 직관적 해석 용이, 정규화 및 단위 변환 필요 x, 전처리 작업 어렵지 않음, 이산형 . 연속형 변수에 모두 적용 가능, 데이터 선형성, 정규성 등의 가정이 불필요, 이상값에 민감 x

- 단점 : 독립변수들 사이의 중요도 판단하기 쉽지 않음, 분류 경계선 근처 자료에 대해 오차 큼, 과적합 발생 가능성 큼

(2)-2 의사결정 나무 분석 과정

-

성장 단계 : 분석 목적과 자료 구조에 따라 적절한 분리 기준과 정지 규칙을 설정해 의사결정나무를 성장시키는 단계

- 각 마디에서 최적의 분리 규칙을 찾아 의사결정나무 형성

- 적절한 정지 규칙 만족 -> 나무의 성장 중단

- 최적의 분할은 불순도 감소량을 가장 크게 하는 분할

-

분리기준 : 데이터를 분류하는 방법으로 불순도를 사용

-

불순도 : 자료들의 범주가 한 그룹 안에 얼마나 섞여 있는지 나타내는 측도

-

하나의 범주로만 구성 -> 불순도 작음, 다양한 범주의 데이터로 구성 -> 불순도 값 큼.

-

종속변수가 범주형

- 분류 트리 사용

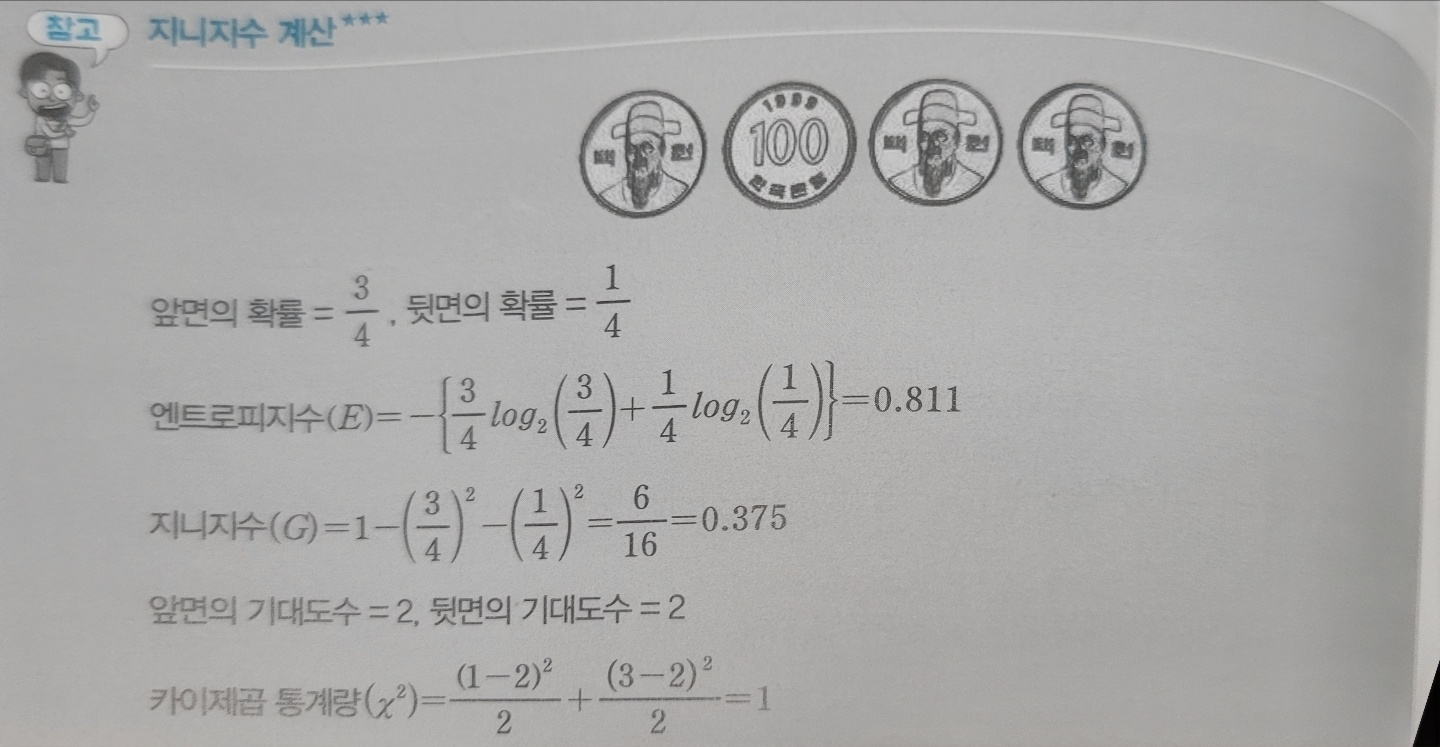

- 분리 기준 : 카이제곱검정, 지니지수, 엔트로피 지수 등 활용

-

종속변수가 연속형

- 회귀 트리 사용

- 분리 기준 : 분산분석에서의 F통계량, 분산의 감소량 등을 사용

-

의사결정나무는 주로 분류트리를 많이 사용. 조속변수가 연속형일 경우 예측 목적으로 회귀트리가 사용

-

지니니수 - 불순도를 나타내는 값, 낮을수록 좋음

-

엔트로피 지수 - 순수도를 나타내는 값, 높을수록 좋음

-

-

정지규칙 : 분석자가 설정한 특정한 조건하에 현재의 마디에서 더 이상 분리가 일어나지 않고 현재의 마디가 끝마디가 되도록 정지시킨다.

- 뿌리마디로부터 일정 깊이에 도달하였을 경우, 불순도의 감소량이 아주 작아 분리에 의미가 없는 경우, 마디에 속하는 자료가 일정 수 이하인 경우, 모든 자료들이 하나의 그룹에 속하는 경우

-

분리 기준

- 이산형

- 분류기준 - 알고리즘

* 카이제곱 통계량 - CHAID- 지니지수 - CART

- 엔트로피지수 - C4.5

- 분류기준 - 알고리즘

- 연속형

- 분류기준 - 알고리즘

- ANOVA F-통계량- CHAID

- 분산감소량 - CART

- 분류기준 - 알고리즘

- 이산형

(3)-1 앙상블 분석

- 여러 개의 모형을 생성 및 조합하여 예측력이 높은 모형을 만드는 것

- 모형의 예측력을 높이고자 여러 번의 데이이터 분할을 통하여 구축된 다수의 모형을 결합하여 새로운 모형을 만드는 방법

- 각각 예측 모형에서 독립적으로 산출된 결과를 종합하여 예측 정확도 향상 가능

- 종속변수 형태에 따라 회귀분석, 분류분석 모두 적용가능

- 결과가 수치형 데이터 - 값들의 평균 통해 최종 결과 예측, 범주형 데이터 - 다수결 방식

- 각각의 모델을 분류기라고 부름, 흔히 의사결정 나무를 사용

- 보팅(voting) 여러 개의 분류기에 의한 결과 중 다수결에 의하여 최종 결괏값을 선정하는 작업

(3)-2 앙상블 분석의 종류

- 배깅 (bagging)

- 여러 개의 붓스트랩(Bootstrap)을 집계하는 알고리즘

- 모딥단의 특성이 잘 반영되는 분산이 작고 좋은 예측력을 보여줌

- 각 분류기(모델)이 독립적

- 각 붓스트랩을 활용하여 트리를 구성할 때 트리 모든 마디가 불순도가 제일 작아지는 최적 분할 실시

- 붓스트랩 -> 원본 데이터와 같은 크기의 표본을 랜덤복원추출한 샘플 데이터

- 모델 구축을 위한 훈련용(train) 데이터를 가리킴

- 복원추출이기 때문에 하나의 붓스트랩에는 같은 데이터가 여러 번 추출될 수도 있지만, 그렇지 않을 수도 있음.

- 원본 데이터로부터 복원추출을 진행하기 때문에 알 수 없던 모집단의 특성을 더 잘 반영

- 부스팅 (boosting)

- 여러 개의 모형을 구축함

- 각 분류기(모델)이 독립적 x

- 이전 모델을 구축한 뒤 다음 모델을 구축할 때 이전 분류기에 의해 잘못 분류된 데이터에 더 큰 가중치를 주어 붓스트랩을 구성

- 약한 모델들을 결합하여 점차적으로 강한 분류기를 만듦

- 에이다부스팅, Gradien Boost, XGBoost, Light CBM 등이 있음.

- 훈련 오차를 빠르개 줄일 수 있음

- 배깅보다 예측 성능 뛰어남.

- 랜덤포레스트(random forest)

- 서로 상관성이 없는 나무들로 이루어진 숲 뜻함.

- 방법은 배깅과 유사 But, 더 많은 무작위성 줌.

- 최적의 분할이 아닌 표본 추출 과정이 한 번 더 반복되어 추출된 표본을 대상으로 최적의 분할 실시

- 최종결과: 분류 - 다수결, 회귀 - 평균 또는 중앙값

- 큰 분산 갖고 있는 의사결정나무 단점 보완 -> 분산 감소

- 일반화 성능 향상

- 이상값에 민감 x

- 독립 변수의 차원을 랜덤하게 감소시킨 다음 그중에서 독립 변수를 선택하는 방법

(4)-1 인공신경망

- 인간의 뇌를 모방하여 만들어진 학습 및 추론 모형

- 뇌의 구조를 수학적으로 단순화해 모델링한 것

- 값이 입력되면 개별 신호의 정도에 따라 값이 가중

- 가중된 값에 편향(bias)이라는 상수를 더한 후 활성함수를 거치면 출력값 생성

- 장점 : 잡음에 민감하게 반응 x, 비선형적 문제 분석 유용, 패턴인식.분류.예측에 효과적, 스스로 가중치를 학습 -> 다양하고 많은 데이터에 효과적

- 단점 : 모형이 복잡할 경우 학습에 오랜 시간 소요, 초기 가중치에 따라 지역해로 수렴가능, 추정 가중치 신뢰도 낮음, 결과 해석 어려움, 은닉층의 수와 은닉 노드 수 결정 어려움.

(4)-2 인공신경망 알고리즘

- 활성함수

- 인공신경망은 노드에 입력되는 값을 바로 다음 노드로 전달하지 않고 비선형 함수 (활성함수)에 통과시킨 후 전달

- 어떤 함수를 사용하느냐에 따라 출력값이 달라짐

- Step 함수 -> 기본적인 활성함수, 0또는 1 반환

- Sigmoid 함수 -> 로지스틱 회귀분석 확률값을 구하기 위한 계산 식과 유사

- 0과 1 사이 값 반환, 많이 사용되는 활성 함수 중 하나

- Sign 함수 -> 기본적인 활성함수, -1또는 1 반환하는 이진형 함수

- tanh 함수 -> 확장된 형태의 시그모이드 함수

- 중심값 0, -1과 1사이의 값 출력

- ReLU 함수 -> 최근 딥러닝에서 가장 많이 사용되는 함수

- 입력값과 0중에서 큰 값을 반환, 기울기 소실 문제 해결

- Softmax 함수 -> 표준화 지수 함수, 출력값이 다 범주인 경우 사용, 다중 클래스 분류를 목적으로 사용

- 로지스틱 회귀분석과 마찬가지로 각 범주에 속할 확률값 반환

(4)-3 인공신경망 종류

- 단층 퍼셉트론 (단층 신경망)

- 입력층의 은닉층을 거치지 않고 바로 출력층과 연결

- 다수의 입력값을 받아 하나의 출력값 출력 -> 정해진 임계값을 넘었을 경우 1을 출력, 넘지 못했을 경우 0을 출력

- 다층 퍼셉트론 (다층 신경망)

- 입력층과 출력층 사이에 보이지 않는 다수의 은닉층을 가지고 있을 수 있는 것

- 일반적으로 인공신경망을 부를 때 다층 퍼셉트론 의미

- 학습하기가 단층 퍼셉트론보다 어려움

- 은닉층의 수가 너무 적으면-> 복잡한 의사결정 경계 구축 불가, 은닉층 수 너무 많으면 -> 일반화 어려움

(5) 나이브베이즈 분류

- 베이즈 이론 (베이지안 확률) -> 확률을 해석하는 이론

- 빈도확률 - 사건이 발생한 횟수의 장기적 비율, 객관적으로 확률 해석

- 베이지안 확률 - 사전확률과 우도확률을 통해 사후확률을 추정하는 정리, 주관적으로 확률 해석

- 현재 관측된 데이터 빈도와 분석자의 사전지식까지 포함해 분석하는 방법

- 확률 : 주장 혹은 믿음의 신뢰도

- 두 확률변수의 사전확률과 사후확률 사이의 관계를 나타내는 정리

- 나이브 베이즈 -> 베이즈 정리를 기반으로 한 지도학습 모델

- 스팸 메일 필터링, 텍스트 분류 등에 사용

- 데이터 모든 특징 변수가 서로 동등.독립적이라는 가정하에 분류실행

(6) K-NN 알고리즘

- 지도학습인 분류 분석에 속하지만 군집의 특정도 갖고 있어 Semi(준)-지도학습으로 분류하기도 함.

- 정답 라벨이 있는 데이터 속에서 정답 라벨이 없는 데이터들을 어떻게 분류할 것인지에 대한 해결방법으로 사용

- 정답 라벨이 없는 자신의 데이터를 분류하기 위해 정답 라벨이 있는 주변의 데이터들을 분석해서 가장 가까이에 있는 데이터의 라벨을 확인하는 것.

- k 값을 어떻게 정하는 지가 관건

- 최적 k 값을 찾기 위해 총 데이터들의 제곱근 값을 사용

- 게으른 학습, 가장 간단한 기계학습 알고리즘

(7) 서포트벡터머신 (SVM)

- 지도학습에 주로 이용, 분류 성능이 뛰어나 분류분석에 자주 사용

- 같은 마진을 가져가는 방향으로 분류

- 마진이 크면 학습에 사용하지 않는 새로운 데이터가 들어오더라도 분류를 잘 할 가능성이 높기 때문 -> 분류분석에서 예측력이 높음

- 회귀 분석에 사용되는 지도학습 알고리즘

- 주어진 데이터를 학습해 새로운 데이터가 어떤 범주에 속할지 결정하는 알고리즘

- 분류분석, 머신러닝에 많이 활용

(8) 분류 모형 성과 평과

- 오분류표 & 성과지표

- 정분류율 (정확도) : 전체 관측치 중 올바르게 예측한 비율

- 오분류율 : 전체 관측치 중 잘못 예측한 비율

- 민감도 (재현율) : 실제 T 중 올바르게 T를 찾아낸 비율, 모형의 완전성 평가 지표

- 특이도 : 실제 F 중 올바르게 F를 찾아낸 비율

- 정밀도 (Precision) : 예측 T중 올바르게 T를 찾아낸 비율

- F1 Score : 정밀도와 재현율의 조화평균 값

- 정밀도의 재현율은 높은 음의 상관관계를 가질 수 있는 효과를 보정하기 위한 지표

- 값이 높을 수록 좋음

- 2정밀도재현율 / 정밀도+재현율

- 거짓 긍정률 : 실제 N값 중 P로 잘못 분류한 비율

- ROC 커브

- 분류 분석 모형의 평가를 쉽게 비교할 수 있도록 시각화한 그래프

- 이진분류 성능 평가 위해 사용

- AUROC (그래프 아래) 값이 1에 가까울 수록 모형의 성능이 우수

- 0.5에 가까울 수록 랜덤 모델에 가까운 좋지 못한 모형

- x축 : 1-특이도, y축 : 민감도

- 각 분류 기준값에 따라 민감도 특이도 변화 나타냄.

- 이익도표

- 랜덤모델 예측력 = 목표그룹 1에 속한 데이터 개수 / 전체 데이터 개수

- 향상도 = 반응률 / 랜덤모델 예측력

- 향상도 곡선 -> 좋은 모델일수록 큰 값에서 시작하여 급격히 감소